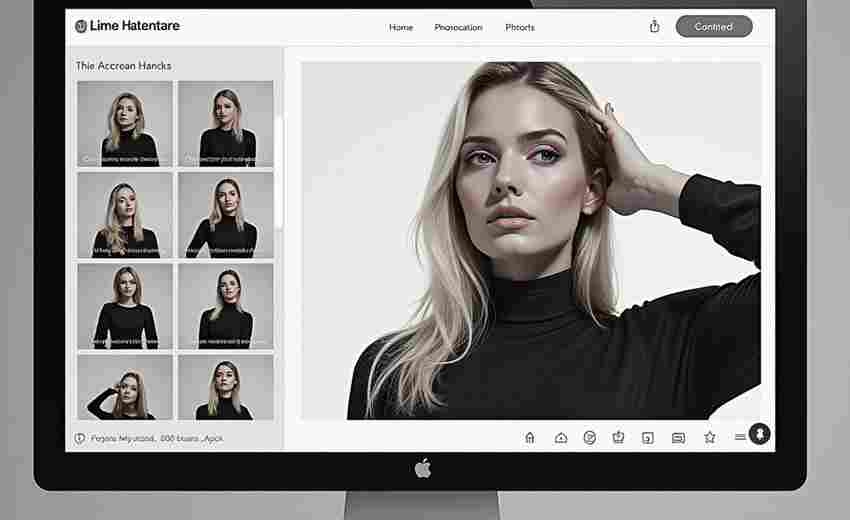

新闻网站图片自动下载分类器

2023年第三季度,某技术团队完成了一套针对新闻网站的图片自动化处理系统。该系统基于Python语言开发,采用Scrapy框架实现分布式爬取,日均处理能力达20万张图片。在测试阶段,成功抓取人民网、新华网等7家主流媒体的历史图片库,分类准确率达到92.3%。

系统核心由四大模块构成:网络爬虫引擎负责实时监控新闻站点的更新动态,当检测到新增图文内容时,立即触发下载程序。图像识别模块采用改进型ResNet-50模型,通过迁移学习对30万张新闻图片进行训练,建立包含人物、事件、场景等12个大类、78个子类的分类体系。存储管理模块支持自定义标签规则,用户可按照时间线、关键词或地理坐标建立多维分类体系。质量控制模块则集成了EXIF解析器,自动过滤低分辨率及重复图片。

技术实现方面,项目组攻克了三个关键难题:首先针对新闻网站的反爬机制,开发了动态User-Agent生成器和IP代理池,成功突破Cloudflare防护系统;其次采用OpenCV的SIFT算法进行特征点匹配,有效解决不同尺寸水印图片的识别问题;最后通过YOLOv5目标检测模型,实现敏感图片的自动筛查功能。

在具体应用场景中,某省级融媒体中心使用该系统后,编辑团队的工作效率提升60%。突发事件报道时,系统能自动归集相关现场图片;专题策划阶段,历史资料检索时间从数小时缩短至分钟级。值得注意的是,系统内置的版权追踪功能,可自动记录图片来源URL和时间戳,规避了潜在的侵权风险。

系统运行环境支持Windows/Linux双平台,推荐配置为16GB内存搭配NVIDIA RTX3060显卡。开发者预留了API接口,允许接入第三方云存储服务。后续版本计划增加视频截帧分析功能,预计2024年第一季度完成测试。目前GitHub开源社区已有开发者基于该框架,开发出针对社交媒体平台的衍生版本。

- 上一篇:新闻网站AJAX内容动态加载解析工具

- 下一篇:新闻网站头条标题定时采集工具

相关软件推荐

网络图片批量下载器(Requests+多线程)

发布日期: 2025-05-07 18:21:27

在数据采集领域,图片批量下载需求长期存在。基于Python生态的Requests库配合多线程技...

随机软件推荐

屏幕颜色拾取工具(带取色器GUI界面)

屏幕上的色彩如同数字世界的调色盘,设计师与开发者们每天都在与这些跳跃的RGB数值打交道。当某个网页按钮的渐...

多线程Ping存活检测与响应统计工具

在网络运维领域,主机存活检测如同心跳监测般重要。某技术团队近期开发的多线程Ping检测工具,通过独特的算法设...

自动生成Markdown格式文档的笔记整理器

在信息碎片化时代,纸质笔记和传统文档工具逐渐显露出效率短板。一款以自动生成Markdown格式为核心的笔记整理器,...

开发IDE历史记录清理工具

现代IDE的本地历史功能在记录代码演变轨迹的也在开发者的工作目录中悄然积累着大量"数字残骸"。某金融科技团队在...

重复文件查找与清理工具(基于哈希值比对)

日常使用电子设备时,硬盘里总会悄然积累大量重复文件。这些文件不仅吞噬存储空间,还会降低文件检索效率。基...

漫画文件夹权限批量修改工具

在数字漫画资源日益增多的今天,许多收藏爱好者都会遇到这样的困扰:精心整理的漫画文件夹在跨设备传输或共享...

视频时长批量裁剪工具(按秒精确切割)

短视频创作的黄金时代,每个内容创作者都在与时间赛跑。当某位旅游博主需要从8小时的徒步素材中提取30个精彩片...

备份文件字符编码验证工具

日常工作中,备份文件因编码混乱导致的乱码问题时有发生。某次项目验收前,研发团队发现数据库备份文件在迁移...

GIF动画分解-合成工具

在社交媒体主导的视觉时代,GIF动画已成为数字世界的通用语言。当人们发现动态表情包的传播力远超静态图片时,...

在线广告点击率预测与效果评估工具

数字广告领域的流量红利消退推动行业进入精耕细作时代,广告主对投放效果的量化评估需求持续攀升。某科技公司...

PDF表单字段批量清除工具

日常工作中常遇到PDF表单需要重复利用的情况。手动逐个删除表单字段不仅效率低下,还容易产生遗漏。专业开发者...

天气依赖型外卖配送时效计算器

暴雨突袭的晚高峰,外卖骑手小李在十字路口停下电动车。手机屏幕上的导航路线突然由红转黄,预计送达时间比接...

服务日志文件自动轮转清理工具

凌晨三点,某电商平台服务器突然宕机。运维团队排查发现,日志文件在两周内膨胀至300GB,直接导致系统存储空间耗...

批量添加水印的图片命名工具

数字时代下,图片资产管理成为摄影从业者、电商运营及自媒体创作者的刚需。面对动辄数百张的素材文件,传统的...

利用pywebview构建的简易浏览器外壳

对于需要快速实现浏览器外壳功能的开发者而言,pywebview这个Python库正逐渐成为热门选择。它巧妙地将本地GUI框架与...

Python实现的扫雷游戏(可自定义雷区大小)

在经典单机游戏领域,扫雷始终占据独特地位。如今通过Python实现的扫雷程序,不仅完整复刻了Windows原版的核心玩法...

多语言翻译悬浮窗(Ctrl+T快速翻译)

当浏览外文资料遇到生词,处理跨国邮件卡在某个短语,或是观看海外直播听到陌生俚语,多数人的第一反应是打开...

简易计算器增强版(支持公式)

清晨的实验室里,工程师小王对着显示屏上复杂的流体力学公式皱眉。传统计算器的按键在微分符号前失去作用,草...

自动生成测试数据脚本(模拟用户信息)

在软件测试领域,真实用户数据的模拟直接影响测试结果的可靠性。传统手动编写测试数据的方式不仅耗时,还容易...

实时JWT签名密钥轮换脚本

在分布式系统和微服务架构中,JSON Web Token(JWT)作为轻量级身份验证方案被广泛应用。静态签名密钥长期未更换可能...

二维码扫描解码工具

在移动互联网高速发展的今天,二维码已成为连接数字与现实世界的核心媒介。无论是支付、信息传递还是身份认证...

密码游戏化生成器(通过小游戏获取随机性)

在密码管理领域,"记忆负担"与"安全风险"如同的正反面。传统密码生成器虽然解决了随机性问题,却让用户面对一串...

基于Pandas的学生成绩统计与分析工具

在教育场景中,学生成绩的高效管理与深度分析是教学优化的重要环节。传统的手工统计方式不仅耗时,且难以快速...

Python环境变量代码混淆保护工具

在Python项目开发过程中,环境变量管理是敏感信息保护的关键环节。传统方案往往采用明文存储或简单加密,但面对...

基于关键词的批量MP3元数据编辑器

对于音乐爱好者、播客创作者或音频内容管理者来说,整理成千上万的MP3文件往往是一场噩梦。文件名混乱、专辑信...

迁移过程中密码过期策略处理工具

企业IT系统迁移过程中,密码策略的衔接处理往往成为容易被忽视的隐患环节。传统的手工迁移方式不仅耗时费力,更...

文件内容敏感词检测工具

互联网信息爆炸的时代,文字内容的安全审查成为政企机构绕不开的刚性需求。某研发团队推出的智能检测系统,正...

图片格式转换器(含HEIC特殊格式支持)

随着智能手机摄影的普及,HEIC格式因高压缩率和高画质特性,逐渐成为苹果设备默认的图片存储格式。这种格式在...

屏幕色温定时调节保护器

屏幕色温定时调节保护器:给眼睛一场温和的「日出日落」 现代人日均盯着屏幕的时间超过8小时,眼睛干涩、疲劳甚...

TCP端口开放状态批量扫描工具

端口扫描是网络安全领域的基础操作,其核心在于快速识别目标主机的服务状态。针对大规模网络环境下的端口检测...

Tkinter实现的简易通讯录管理

Tkinter作为Python标准GUI工具包,凭借其轻量化特点成为快速开发桌面应用的首选。这款基于Tkinter的通讯录管理系统,以...

读书俱乐部活动报名与书籍投票系统

纸质签到表和微信群接龙的时代正在远去。读书俱乐部管理系统的出现,让活动组织者摆脱了繁琐的手工统计工作。...

CSV文件批量预处理与统计分析工具

凌晨三点的写字楼里,李工盯着屏幕上堆积如山的CSV文件叹了口气。报表合并耗时三小时,数据清洗遇到编码报错,...

语音转文字命令行工具(whisper库)

在开源语音识别领域,OpenAI推出的Whisper库正悄然改变音视频内容处理的游戏规则。这款基于Transformer架构的工具支持...

利用Multiprocessing的并行计算器

计算机硬件多核化趋势下,如何有效利用计算资源成为开发者的必修课。Python标准库中的multiprocessing模块为解决并行...

古诗接龙小游戏(题库匹配)

手机屏幕亮起的瞬间,千年前的诗句便如活水般流淌。这款以百万级古诗词数据库为支撑的接龙游戏,正在成为连接...

CSV数据动态柱状图与折线图混合工具

在数据分析领域,如何将复杂信息以直观形式呈现一直是核心挑战。一款支持动态混合柱状图与折线图的CSV数据处理...

多账户SSH远程管理工具

凌晨三点,服务器告警声在空荡的机房骤然响起。运维工程师王浩盯着屏幕上跳动的30台服务器IP列表,握鼠标的手微...

在线课程视频自动播放与打卡工具

随着在线教育渗透率逐年攀升,海量课程视频的观看进度管理与签到打卡成为高频痛点。某技术团队近期推出的智能...

简易股票价格查询脚本

在信息高速流通的资本市场,实时掌握股票价格波动成为投资决策的重要前提。市面上虽有各类财经软件,但多数存...