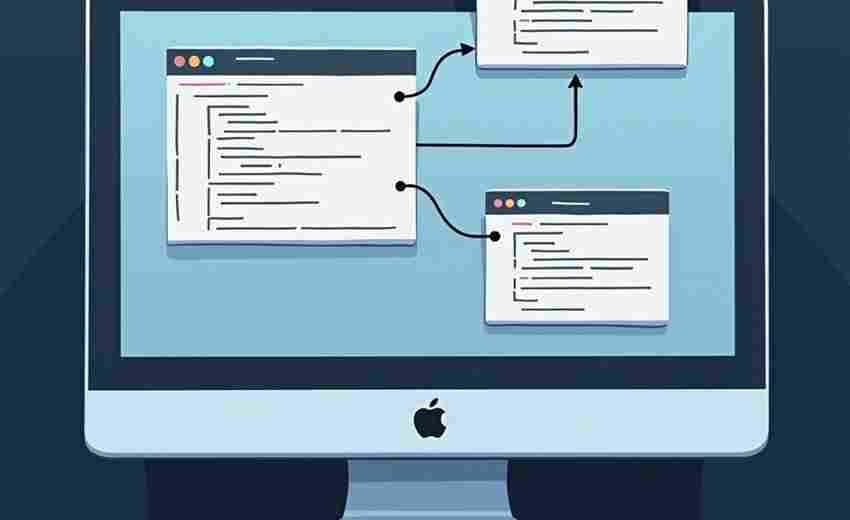

网络爬虫入门工具(静态页面数据抓取)

清晨八点的阳光斜照进书房,桌面上摊着三台不同操作系统的笔记本电脑。程序员阿杰正在为毕业论文收集数据,浏览器收藏夹里堆满待整理的网页链接。他需要的不是手工复制粘贴,而是一套能自动收割网页信息的工具。

Requests库在Python开发者的工具箱里躺了七年,至今仍是处理HTTP请求的首选。它像把精准的手术刀,二十行代码就能完成身份认证、参数传递、文件下载等操作。配合标准库中的urllib.parse,可以优雅地拼接复杂URL参数。但处理动态加载内容时,这把手术刀就变成了钝器。

当网页结构像迷宫般复杂时,BeautifulSoup便显露出它的价值。这个HTML解析库支持多种解析器,就像给近视者配了度数合适的眼镜。用find_all方法遍历DOM树时,CSS选择器与正则表达式混合使用的技巧,往往能精准捕获藏在多层嵌套标签里的数据。

实验数据采集到第三周,阿杰在Github发现了Scrapy框架。这个异步处理框架自带中间件和管道系统,如同给爬虫装上了涡轮增压器。ItemLoader模块能统一数据清洗流程,LinkExtractor自动追踪分页链接的特性,让持续抓取十万级页面成为可能。但框架的学习曲线,让习惯写脚本的新手需要适应三天。

抓取公开数据时遇到的GBK编码问题,促使阿杰研究起Lxml库。这个用C语言编写的解析器速度是BeautifulSoup的八倍,XPath表达式比CSS选择器更适应多层表格结构。不过它严格的XML解析规则,经常把格式松散的网页变成解析错误提示。

某天深夜抓取学术期刊网站时,403禁止访问的提示频繁出现。加上随机User-Agent和访问延迟,用requests.Session维持的会话终于突破反爬机制。这时候才理解到,即使面对静态页面,也需要像Selenium这类工具模拟人类操作行为,虽然这已超出纯粹静态抓取的范畴。

工具选择永远与目标场景紧密相连。小型项目用Requests+BeautifulSoup组合足够轻快,需要数据清洗时Pandas的read_html函数常有惊喜,面对JavaScript渲染的伪静态页面,Pyppeteer的无头浏览器方案逐渐成为新选项。当你在Stack Overflow看到某个五年前的问题还在持续更新解法,就会明白网络爬虫既是技术战场,也是攻防艺术。

相关软件推荐

随机软件推荐

基于Socket的多客户端聊天室

网络通信技术不断迭代的今天,即时通讯依然是各领域刚需。基于Socket协议搭建的多客户端聊天室,凭借其底层传输...

图书馆能耗数据可视化仪表盘

随着"双碳"目标持续推进,全国超过80%的公共建筑开始关注能耗管理问题。图书馆作为典型的大型公共空间,其能源消...

自定义提醒规则配置工具

闹钟总在错误时间响起?待办事项堆积如山却总被遗忘?传统提醒工具依赖标准化模板,难以满足千变万化的需求。...

简易虚拟机内存监视器

运行在云端的虚拟机如同高速运转的数字心脏,内存状态则是评估其健康程度的核心指标。某次线上服务突发的性能...

简易Markdown编辑器软件

在信息碎片化的时代,文字工作者对效率工具的追求从未停止。一款名为 SimpleMark 的Markdown编辑器近期在技术圈引发关...

莫兰迪色系会议日程提醒小部件

办公场景中,日程管理工具常因视觉干扰与功能臃肿令用户疲惫。近期市场出现一款以莫兰迪色系为设计核心的会议...

课堂签到与考勤统计系统

高校教室后门时常出现这样的场景:教师走下讲台查看纸质签到表时,台下半数学生已收起书本准备离开。传统考勤...

实时日志流关键词监控仪表盘

数据中心机房的警报声骤然响起,某电商平台的交易成功率曲线突然下跌两个百分点。运维团队打开监控仪表盘,红...

PySimpleGUI开发的自动化报表生成工具

【场景一:凌晨三点的办公室】 王磊盯着屏幕上密密麻麻的Excel公式,疲惫地揉了揉太阳穴。市场部要求每周提交的...

桌面便签贴纸工具(支持多窗口与颜色标记)

办公桌上散落的黄色便利贴,是无数职场人熟悉的场景。当纸质便签逐渐被数字化工具取代,某款支持多窗口与颜色...

音乐播放器(pygame基础版本)

在Python生态中,Pygame作为多媒体开发的重要工具包,其音频模块常被用于构建基础音乐播放器。本文将具体剖析一个...

自动化截图工具(定时或按快捷键触发)

办公桌上堆满未整理的截图文件,手动保存时误触快捷键打断工作节奏——这类场景早已成为数字办公时代的常态。...

批量电子书格式转换

电子书爱好者常面临一个难题:不同设备支持的格式差异导致阅读体验割裂。一台Kindle只能兼容MOBI或AZW3格式,手机阅...

屏幕取色器(pyautogui+tkinter)

当设计师在调整UI配色方案时,常会遇到需要精准捕捉屏幕特定位置颜色的场景。基于Python开发的屏幕取色工具,通过...

视频帧提取分析工具(OpenCV)

在计算机视觉应用领域,视频帧处理技术正成为内容分析的基础支撑。基于OpenCV的开源工具包,开发者能够快速构建...

地图瓦片存储目录结构优化工具

随着地理信息系统的广泛应用,地图瓦片技术逐渐成为在线地图服务的核心支撑。海量瓦片数据的高效存储和管理一...

会议室使用满意度简易调查问卷生成器

现代企业会议室内耗问题日益突出。资源分配不均导致部门间争执频发,设备故障影响会议进程,预约流程繁琐降低...

简易聊天室程序(Flask WebSocket)

(空一行) 实时通信功能已成为现代Web应用的标配需求。Flask作为轻量级Python框架,配合WebSocket协议能快速搭建具备...

CSV文件头缺失编码元数据自动补充工具

许多数据分析师都遇到过这样的困扰:打开CSV文件时,中文字符变成乱码,日期格式显示异常,数字字段被错误识别...

办公会议倒计时屏保程序

现代办公场景中,会议室预约冲突、会议超时占用等问题频发。某科技团队针对这一痛点,推出创新型智能屏保系统...

网站Cookie分析查看器

在互联网技术快速迭代的今天,Cookie作为网站与用户交互的核心媒介,直接影响用户体验、数据安全以及合规性管理...

文件签名批量添加工具(自定义尾注)

在数字化办公场景中,文件签名管理一直是困扰用户的痛点。手动逐一添加尾注不仅耗时,还容易因格式混乱导致文...

桌面便签贴纸工具(透明窗体)

启动软件后桌面会浮现半透明色块,如同在显示器表面覆盖了真实的便利贴。这款仅12MB的桌面便签工具支持Windows全系...

文本文件关键词快速统计与词频分析工具

在信息爆炸的数字时代,海量文本数据的高效处理成为刚需。针对文档关键词的快速提取与词频统计需求,市场上涌...

多线程社交媒体动态抓取与备份工具

数字时代的信息洪流中,社交平台动态的保存与管理成为棘手问题。某技术团队近期推出的多线程动态抓取工具,在...

自动化Excel表格数据合并与格式转换工具

在数字化办公场景中,Excel数据处理的效率痛点长期存在。某科技团队近期推出的智能数据处理工具,针对性地解决了...

热门话题数据抓取与可视化工具

数字时代的信息海洋中,掌握热点动态如同握住航海罗盘。三款核心工具构筑的"监测-分析-呈现"体系,正在重塑舆情...

基于命令行的科学计算器(支持基础运算)

在终端窗口敲击键盘的工程师群体中,高效与精准是永恒的追求。当复杂的数学问题遇上代码调试或数据分析需求时...

待办事项自动拆分子任务工具(WBS分解逻辑)

面对庞杂的待办事项时,多数人常陷入无从下手的困境。一款基于WBS(工作分解结构)原理设计的智能任务分解工具...

多线程文件内容加密-解密工具

现代办公环境中,机密合同、医疗档案这类敏感文件的流转频率日益增长。某互联网公司的开发团队近期发现,使用...

网页源码快速保存工具(带完整资源下载)

点击鼠标右键保存网页时,你是否经历过排版错乱、图片丢失的尴尬?当某个重要页面突然消失,精心收集的资料瞬...

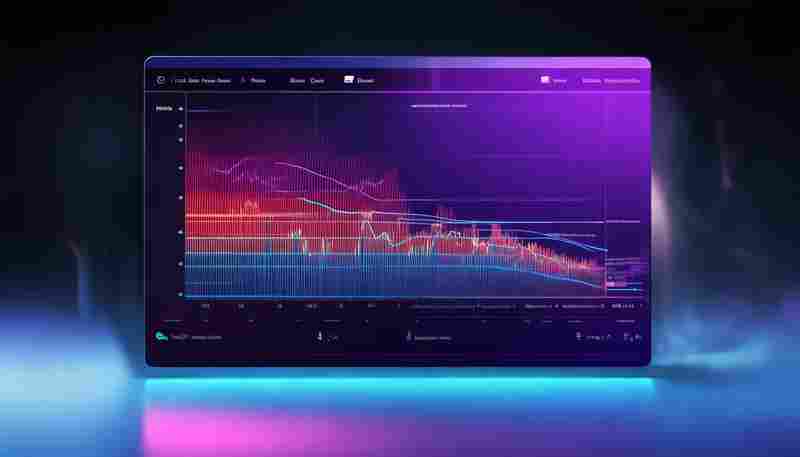

股票价格走势可视化工具(API)

金融市场瞬息万变,专业投资者往往需要借助可视化工具捕捉稍纵即逝的交易机会。某科技公司推出的股票行情可视...

文档内容自动生成思维导图工具

信息爆炸时代,整理文档内容常让人头疼。纸质笔记、电子文档、会议纪要层层堆叠,如何快速提炼核心逻辑?近两...

wxPython跨平台GUI工具包

在桌面应用开发领域,GUI工具包的选择往往决定开发效率和用户体验。当Python开发者面对跨平台需求时,wxPython凭借其...

文本文件批量编码转换与合并工具

在跨平台协作或处理历史数据时,不同编码格式的文本文件常引发乱码问题。某款针对此痛点的桌面工具近期在开发...

电子邮件附件智能归档工具

在商务往来频繁的数字化时代,普通职场人每年平均接收超过1200封工作邮件,其中包含的各类附件占据企业云端存储...

通过摄像头实现运动检测报警程序

近年来,随着智能安防需求激增,运动检测报警程序逐渐成为家庭及商用场景的热门选择。这类工具利用摄像头捕捉...

微博热搜榜爬取与存档工具

热搜榜单每分钟都在刷新,明星绯闻、社会热点、突发事件交替占据公众视野。面对这个实时滚动的信息池,某技术...

浏览器网站数据选择性清除工具

在互联网深度融入日常生活的当下,浏览器存储的网站数据逐渐成为隐私泄露的高危区。传统清理工具常采用「一刀...

下载进度可视化工具(实时显示速度与剩余时间)

下载文件时盯着进度条干等,是许多人熟悉的场景。尤其当网络波动、文件体积庞大时,用户常陷入「卡在99%」的困...