网页关键词实时监控爬虫程序

在信息爆炸的互联网时代,快速页关键词的变动成为企业、研究机构甚至个人用户的刚需。无论是追踪竞品动态、监测舆情风向,还是获取行业最新情报,一款高效的实时监控爬虫工具往往能成为破局关键。这类工具通过自动化抓取、解析及分析网页内容,帮助用户在海量数据中锁定目标信息,减少人工成本的同时提升决策效率。

核心功能:精准与速度的平衡

优秀的实时监控工具需要兼顾数据抓取的准确性和响应速度。通过预设关键词,系统可对目标网页或特定数据源进行周期性扫描,一旦发现内容更新或关键词匹配,立即触发通知机制。例如,某电商平台的价格波动监控工具,能在竞品调价后5分钟内推送提醒,为促销策略调整争取时间窗口。

技术层面,这类工具通常采用分布式架构应对反爬策略,结合动态IP池和请求频率控制,确保抓取行为的隐蔽性。智能解析引擎能自动适配不同网页结构,减少因页面改版导致的数据断层问题。

场景适配:从舆情到商机

实际应用中,关键词监控的边界正在不断拓展。在舆情监测领域,工具可抓取社交媒体、新闻网站及论坛内容,通过情感分析模块判断舆论倾向;在学术研究场景,学者可通过监控特定论文关键词,实时追踪最新研究成果。更前沿的应用甚至延伸至暗网数据监控,协助安全团队识别潜在风险。

技术挑战与应对策略

尽管功能强大,这类工具的开发仍面临多重挑战。例如,动态渲染页面(如JavaScript加载内容)需要借助无头浏览器技术,但会显著增加资源消耗。部分团队采用混合解析方案——对静态页面使用轻量级爬虫,复杂页面调用浏览器内核,以此平衡效率与覆盖率。

数据存储环节,流式处理框架(如Apache Kafka)的引入,能实现抓取数据的实时清洗与分类。结合Elasticsearch等搜索引擎,用户可对历史数据进行多维度检索,进一步挖掘信息关联性。

与合规的边界

使用爬虫工具需严格遵守《数据安全法》《个人信息保护法》等法规。过度抓取可能导致服务器负载激增,甚至引发法律纠纷。2021年某知名企业因爬取用户公开简历数据被起诉案件,为行业敲响警钟。开发团队通常会在系统中内置合规检测模块,自动识别敏感字段(如手机号、身份证号)并进行脱敏处理。

未来,随着AI技术的渗透,关键词监控或将从单一文本匹配升级为语义理解。例如,通过NLP模型识别关键词的隐含语境,过滤干扰信息。而在硬件层面,边缘计算与爬虫的结合,有望进一步降低响应延迟。

直接调用API接口替代传统爬虫,成为部分平台的新选择。这种方式虽需支付接口费用,但能规避法律风险,尤其适合对数据稳定性要求较高的企业。

相关软件推荐

随机软件推荐

自动生成报告工具(文本+图表整合)

在企业数字化转型浪潮中,市场分析、运营复盘等场景对动态报告的需求激增。某互联网公司市场部员工曾连续三天...

多语言输入法切换提示工具

在全球化的工作场景中,多语言输入需求日益频繁。无论是跨国协作、多语种文档撰写,还是日常沟通中的即时翻译...

文本转语音即时翻译工具

语言障碍始终是跨文化交流中最难攻克的难题之一。当人们尝试用翻译软件逐字输入文本时,往往因操作繁琐错过对...

Python编写文件属性修改工具(时间戳)

在软件测试与数据归档工作中,开发者常会遇到需要修改文件属性的实际需求。基于Python语言开发的FileTimeEditor工具,...

yapf代码风格统一器

代码格式化工具江湖里,YAPF像把锋利的手术刀,精准切割着程序员的风格焦虑。这个由谷歌工程师开发的Python工具,...

批量生成带艺术字体的二维码工具

数字信息传播进入视觉化时代,普通黑白二维码难以吸引受众注意。某团队近期推出的艺术字体二维码生成系统,正...

自动化Git仓库备份同步工具

在软件开发领域,代码仓库的备份与同步是保障团队协作和数据安全的核心环节。随着分布式开发的普及,许多团队...

批量转换视频格式为MP4的小工具

在数字化信息爆炸的时代,视频内容已成为主流媒介形式。无论是个人用户保存家庭影像,还是企业处理海量宣传素...

数字取证文件哈希校验分类器

在电子证据固定与数据溯源领域,哈希校验技术长期扮演着基石角色。随着电子设备存储量呈指数级增长,传统人工...

基于内容的重复文件检测工具

重复文件堆积是数字时代普遍存在的管理难题。当用户在不同设备间传输文件或使用多账户云存储时,常常会产生内...

模型部件分离导出工具

在三维建模领域,复杂模型的拆解与导出长期困扰着从业者。某设计团队曾为导出机械臂模型花费三天时间手工分离...

日志备份文件JSON-CSV批量转换工具

数据清洗的最后一公里 运维工程师李明最近在排查服务器故障时,发现传统日志处理方式存在明显短板——当需要同...

CSV文件分析工具

在数据驱动的时代,CSV文件作为轻量级数据存储格式,频繁出现在办公场景与开发流程中。面对动辄数万行的数据表...

本地文件夹实时差异对比工具

在数字资产管理日益重要的今天,文件同步过程中的版本混乱问题困扰着众多用户。某款名为DeltaSync的本地文件夹差...

批量图片尺寸调整与JPG压缩工具

数字时代催生了海量图片处理需求,无论是电商平台的商品详情页优化,还是社交媒体内容的快速发布,从业者常面...

视频封面批量提取工具(按时间点截取帧)

打开视频文件瞬间,密密麻麻的进度条总让人犯难。创作者常陷入两难境地:手动截取封面耗时费力,随机生成的缩...

Pillow批量图片格式转换器

在数字图像处理领域,文件格式转换是高频操作需求。设计师经常需要将PSD源文件批量转为网页适用的PNG格式,摄影...

简易音乐播放器(MP3列表)

在数字化时代,音乐播放器几乎成为手机或电脑的标配工具。对于追求轻量化操作的用户而言,一款功能简洁、界面...

自动邮件定时发送工具(带附件支持)

现代职场中,邮件处理效率直接影响着工作节奏。某科技公司市场部员工小王曾因时差问题,凌晨三点蹲守电脑前发...

多格式文档全文搜索工具

数字时代的信息管理困境从未如此突出。一份2023年的行业报告显示,普通职场人平均每天需处理超过15种不同格式的...

系统资源使用统计报告工具

服务器机房内,运维人员紧盯屏幕,CPU使用率曲线突然飙升到95%。系统资源统计工具自动触发告警,详细报告显示某...

自动生成目录结构图的树状图绘制工具

在代码项目的迭代过程中,开发者小王面对超过200层的嵌套目录陷入迷茫。当他打开某款树状图生成工具,整个项目...

钉钉审批结果自动发送邮件的通知系统

在企业日常运营中,审批流程的效率直接影响业务推进速度。钉钉作为国内主流办公平台,其审批功能覆盖了大多数...

测试覆盖率分支差异可视化器

在团队协作开发中,分支管理与代码合并常因测试覆盖率差异埋下隐患。某次上线后出现的偶发崩溃,可能就源于某...

图片格式转换任务邮件通知系统

在现代办公场景中,图片格式转换已成为高频需求。无论是设计团队处理素材,还是市场部门制作宣传内容,跨平台...

剧本对话关键词情绪分析器

在剧本创作过程中,角色对白的情绪拿捏往往是编剧的痛点之一。一句台词的语气偏差可能导致人物塑造失衡,甚至...

CSV文件数据箱线图异常检测工具

在数据质量直接影响决策精度的当下,一款专注于CSV文件数据清洗的箱线图异常检测工具正悄然成为数据分析师的新...

网络爬虫数据抓取工具(指定URL与规则)

一、核心功能解析 网络爬虫工具通过输入目标URL与规则参数,即可实现自动化数据抓取。用户只需在可视化界面配置...

CSV文件内容关键词替换器

在日常数据处理中,CSV文件因其结构简洁、兼容性强,成为企业及个人常用的数据存储格式。面对海量数据时,针对...

图书页码自动校对与异常检测器

纸质书籍与电子文档的交叉使用场景中,页码系统的准确性直接影响着读者的检索效率和出版物的专业形象。某技术...

网络流量异常报警通知工具

在数字化业务高速运转的当下,网络流量的稳定性直接影响企业核心系统的可用性。一次突发的流量激增或异常访问...

身份证号-手机号正则验证工具

身份证号与手机号作为高频使用的个人标识信息,在各类系统中常需进行格式校验。正则表达式凭借精准的匹配能力...

图书借阅管理追踪系统(CSV-JSON双备份)

纸质图书管理在数字化时代面临双重挑战:既要满足读者对借阅流程便捷化的需求,又要确保数据存储的可靠性与可...

多文件内容合并工具(支持多种格式)

日常办公与资料整理场景中,常会遇到分散的文档需要整合的情况。比如市场部需要将Excel表格、Word报告与PDF合同合...

验证码图片生成器(随机文本图像)

在数字化浪潮席卷全球的今天,网络安全已成为不可忽视的议题。当用户注册账号、提交表单或进行高风险操作时,...

音频频谱可视化工具(根据播放音乐显示波形)

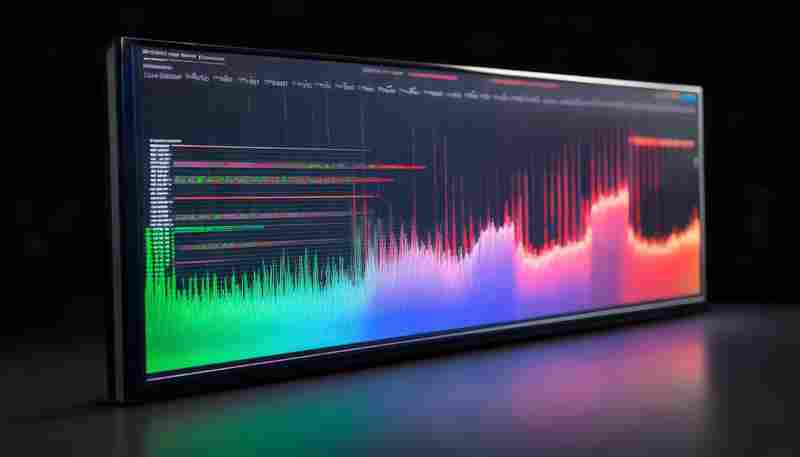

当《波西米亚狂想曲》的华丽和声在耳机里炸开时,屏幕上的光谱突然分裂成六道彩虹,实时跳动着对应每位乐队成...

简易待办事项清单(支持增删改和保存)

任务管理软件市场长期被复杂系统占据,普通用户常陷入功能冗余的困扰。一款基于浏览器本地存储的待办工具打破...

键盘输入记录分析器(热键统计可视化)

办公室的机械键盘声此起彼伏,程序员小张突然停下手里的工作——他已经第三次在代码编辑器里误触组合键了。这...

邮件正文批量发送工具

在数字化营销场景中,邮件依然是触达客户的核心渠道。根据第三方机构统计,2023年全球企业邮件日均发送量突破...

带GUI的图片隐写术加密解密工具(LSB算法)

午后的咖啡馆里,程序员老张对着电脑屏幕皱起眉头——客户要求将200MB的商业数据伪装成普通图片传输,还要确保肉...