网页源码关键词批量抓取工具

在信息爆炸的互联网时代,如何快速从海量网页中提取目标数据,成为企业、研究者和个人用户共同面临的难题。网页源码关键词批量抓取工具应运而生,这类工具通过自动化解析网页结构,精准定位并提取用户预设的关键词或数据字段,大幅降低人工筛选的时间成本,成为数据分析、竞品调研、舆情监控等场景的实用利器。

核心功能:从复杂到简洁的转化

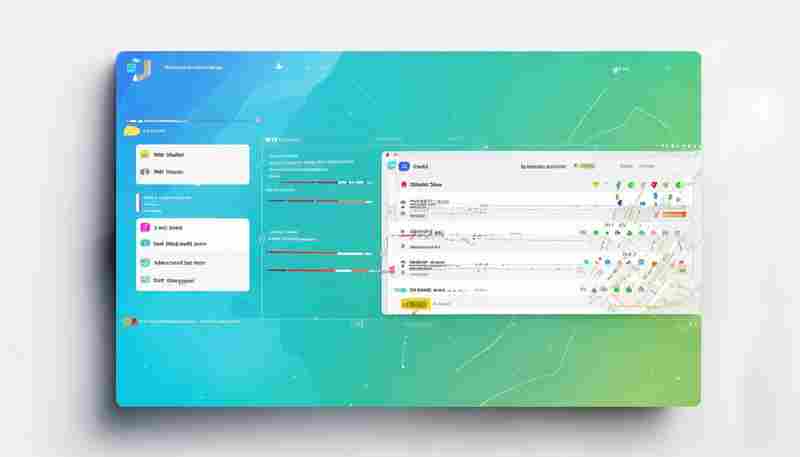

传统的数据采集依赖人工复制粘贴或简单爬虫脚本,效率低且容错性差。现代批量抓取工具的核心优势在于两点:多层级解析能力与规则自定义设计。工具通过识别网页的HTML、CSS或JavaScript结构,自动遍历目标页面中的标签、类名或特定属性,批量提取嵌套在源码中的文本、链接或元数据。用户只需通过可视化界面设定关键词规则(如正则表达式、XPath路径),即可在几分钟内完成上千页面的定向抓取。

以电商平台商品信息采集为例,用户可设定抓取商品标题、价格、评论数等字段,工具会自动跳过广告模块或无效弹窗,仅保留结构化数据,最终生成Excel或JSON格式的报表。这种“精准”式的工作流,尤其适用于需要高频更新数据的场景。

技术突破:动态渲染与反爬策略

随着网页技术的复杂化,许多平台采用动态加载(如Ajax)、登录验证或IP限制等手段阻挡自动化抓取。新一代工具通过模拟浏览器行为解决这一问题:内置无头浏览器(Headless Browser)技术,可完整渲染JavaScript生成的内容;同时支持设置请求头(User-Agent)、代理IP池和访问间隔参数,规避反爬机制触发封锁。

工具的另一亮点是容错机制。例如,当目标页面因改版导致标签路径失效时,系统会通过模糊匹配算法自动定位相似内容,或提醒用户更新规则库,减少因网页结构调整导致的数据断层。

应用场景:从科研到商业的覆盖

1. SEO优化监控:批量抓取搜索引擎结果页(SERP)中的关键词排名,分析竞品网站的元标签与内容策略,快速调整自身页面的SEO配置。

2. 舆情分析与危机预警:实时抓取社交媒体、新闻网站的特定关键词(如品牌名、产品型号),生成情感分析报告,及时发现负面舆论。

3. 学术研究支持:在论文数据收集中,自动提取学术平台上的文献摘要、作者信息及引用量,构建结构化数据库。

4. 价格追踪与市场调研:电商平台商品价格的波动、促销活动的更新均可通过定时抓取实现监控,为决策提供实时数据支撑。

工具选择:轻量化与专业化的平衡

当前市面上的工具分为两类:开源框架(如Scrapy、BeautifulSoup)适合有编程基础的用户,灵活性高但需自行处理反爬与存储逻辑;SaaS化平台(如八爪鱼、火车采集器)则提供“零代码”操作界面,适合业务团队快速上手。

对于普通用户,建议优先选择支持云同步、多线程任务且提供API接口的工具;若涉及大规模数据采集,需关注工具的分布式部署能力与数据清洗功能,避免因单机性能瓶颈导致任务中断。

数据安全始终是核心考量。合规使用工具,遵守网站的Robots协议,合理控制请求频率,才能避免法律风险。部分平台已集成数据脱敏功能,确保用户隐私与商业机密在传输和存储环节的安全性。

- 上一篇:网页源代码结构化信息抓取工具

- 下一篇:网页源码快速下载器

相关软件推荐

BeautifulSoup实现的简易网页爬虫工具

发布日期: 2025-04-09 09:33:01

(正文开始) 工具定位与特点 BeautifulSoup作为Python生态中经典的HTML解析库,常被用于构...

随机软件推荐

基于正则表达式的编码过滤与转换器

在数据处理领域,编码格式的复杂程度常让工程师头痛不已。某款基于正则表达式的智能过滤工具近期在开发者社区...

基于PyAutoGUI的桌面端问卷星自动填表工具

在数字化调研场景中,基于问卷星的在线表单已成为常见的数据收集方式。某技术爱好者近期开发了一款基于PyAutoG...

团队协作日程共享同步工具

现代职场中,跨部门协作的时间损耗常成为项目推进的痛点。某互联网公司市场部曾因会议时间冲突导致产品发布会...

基于配置的多文件内容合并工具

在代码开发与文档处理场景中,开发者经常需要面对跨文件的内容整合难题。传统手工合并方式耗时易错,基于配置...

CSV数据噪声过滤工具

在数据爆炸的时代,海量CSV文件已成为企业运营的标配载体。当某跨国零售集团发现其销售数据存在10%的异常值时,...

文件注释批注管理工具

在信息爆炸的时代,文档处理的复杂度与日俱增。无论是团队协作中的合同修订、学术研究中的文献分析,还是产品...

带版本回退的日期归档工具

办公桌上的文件夹摞到第三层时,程序员老张对着显示器露出苦笑。半年前某次误删的项目文档,此刻正躺在客户重...

图片元数据批量删除工具

在数字影像无处不在的今天,手机相册里随手拍下的街景照片,可能无意间暴露了家庭住址;社交媒体分享的工作样...

简易区块链哈希生成演示器

互联网档案馆的某个角落躺着这样一条用户评论:"学区块链两年,直到看到哈希值动态生成的过程,才真正理解什么...

解剖学试题库智能组卷评分系统

随着医学教育数字化进程加快,解剖学教学正面临题库资源分散、试卷编制耗时长、主观题批改标准不统一三大痛点...

运动数据加密备份与恢复工具

在数字化运动管理领域,数据安全与便捷备份逐渐成为用户的核心需求。针对这一痛点,市面上出现了一类专注于运...

简易待办事项列表管理器(TXT-CSV存储)

办公室玻璃杯升起的热气还未消散,程序员小王又对着电脑抓起了头发——第8版项目排期表被产品经理第3次推翻。桌...

合并数据自动生成API接口工具

在数据驱动的商业环境中,企业常常面临多源数据分散、接口开发周期长等问题。传统的手动编写API接口不仅耗时,...

家庭宠物健康记录数据库

夏日的宠物医院候诊室里,一位女士正翻阅着泛黄的笔记本,上面密密麻麻记录着爱犬"球球"近三年的饮食变化、疫苗...

批量重命名指定扩展名文件的自动化工具

日常工作中,重复性文件处理任务常让人头疼。面对成百上千个格式混乱的文档、图片或音频文件,手动修改不仅耗...

日志文件分析器(按关键词-时间过滤)

服务器运行状态的监控离不开日志文件的追踪。面对动辄数十GB的日志数据,传统文本编辑器已难堪重任。某技术团队...

基于翻译记忆的重复段落自动替换引擎

在专业文档翻译领域,重复段落处理始终是影响效率的关键瓶颈。某国际专利事务所的案例颇具代表性:技术团队在...

文件时间属性备份恢复工具

在数字资产管理过程中,文件的时间属性(创建时间、修改时间、访问时间)往往承载着重要信息。某IT公司技术团队...

使用NumPy的随机数据统计可视化工具

在数据科学领域,生成模拟数据是验证算法和测试模型的重要环节。作为Python生态系统的基石工具,NumPy提供的随机数...

简易Markdown文档编辑器(实时预览模式)

市面上的写作工具大多追求功能堆砌,但有一类产品反其道而行——实时预览Markdown编辑器以极简界面搭配双向预览功...

请求参数完整性校验工具

互联网应用的每一次请求都可能携带数十个参数,这些参数如同进入系统大门的"访客"。2021年某电商平台因未校验优...

简易CPU内存监控器

日常使用电脑时,系统卡顿总是令人头疼。后台程序占用资源、硬件超负荷运行等问题频发,但普通用户往往缺乏专...

网页爬虫工具(特定关键词内容抓取)

网页爬虫工具:精准抓取关键词内容的高效助手 在信息爆炸的时代,如何快速从海量网页中提取特定关键词内容,成...

新闻头条定时抓取与Excel数据透视表工具

在信息爆炸的时代,新闻头条的实时监测与数据高效分析成为企业、研究机构乃至个人用户的刚需。一款结合新闻头...

基于Tkinter的简易文本差异对比器

许多程序员在日常工作中常遇到代码版本比对的需求,开源社区的文本对比工具虽功能强大,却普遍存在安装复杂、...

使用PyQt5开发的桌面时钟应用程序

窗口右下角跳动的数字时钟早已成为现代人的标准配置,但总有人想要更个性化的选择。某位程序员在深夜敲代码时...

抖音短视频时长统计与分类工具

在短视频内容井喷的时代,创作者常面临一个隐形挑战:如何精准把控作品时长与主题分类,以适应平台算法和用户...

命令行日历与日程安排工具

在键盘敲击声此起彼伏的开发者工作区,传统的图形化日历工具常显得格格不入。那些隐藏在终端窗口里的命令行工...

语音交互式命令行工具

当键盘输入遇到声波革命 传统命令行界面始终面临输入效率瓶颈。某研究机构数据显示,开发者在执行复杂指令时平...

简易博客文章生成器(模板化)

互联网时代,内容创作需求激增,但时间和精力始终有限。一款名为「QuickBlog」的工具近期在自媒体圈引发关注——...

PDF转EPUB交互元素移除工具

纸质书数字化浪潮下,PDF与EPUB两种格式长期主导电子文档市场。PDF凭借排版稳定性占据办公领域,EPUB则因自适应屏幕...

井字棋(Tic-tac-toe)对战游戏

井字棋(Tic-Tac-O)作为历史悠久的双人策略游戏,规则简单却充满博弈乐趣。近年来,随着线上线下工具的迭代,这...

简易物联网数据监控仪表板

工业车间里,设备温度突然飙升;农业大棚内,土壤湿度跌破警戒值;物流仓库中,货物定位信号丢失——这些场景...

国际专利申请文档格式转换工具

全球知识产权保护体系日益复杂,各国专利局对申请文件的格式要求存在显著差异。以PCT国际申请为例,申请人需要...

敏感信息批量过滤工具

在数字化转型的浪潮中,数据安全管理逐渐成为企业的核心课题。某医疗集团近期因内部人员误将患者隐私信息群发...

SQLAlchemy多数据库管理界面

数据库工程师老张最近遇到个头疼的问题:公司业务扩张后,数据量激增导致单个MySQL实例逐渐不堪重负。运营数据要...

简易待办事项管理应用(Tkinter GUI)

现代生活节奏快,任务繁杂,许多人需要一款操作简单、功能清晰的待办事项管理工具。本文介绍一款基于Python Tki...

系统声音控制增强工具(音量预设)

深夜赶工的视频剪辑师反复拖动进度条,游戏主播在团战关键时刻突然爆发的背景音,会议主持人手忙脚乱调整设备...

屏幕取色与色值转换工具

在数字设计领域,每个像素的色值都可能决定作品的最终呈现效果。当设计师调整网页按钮的明度时,当开发者核对...

使用Loguru的应用程序日志分析工具

打开任何一位后端工程师的电脑,都能在代码目录里发现名为error.log、debug.log的文件。这些看似普通的文本文件,记...