Nginx访问日志实时解析工具

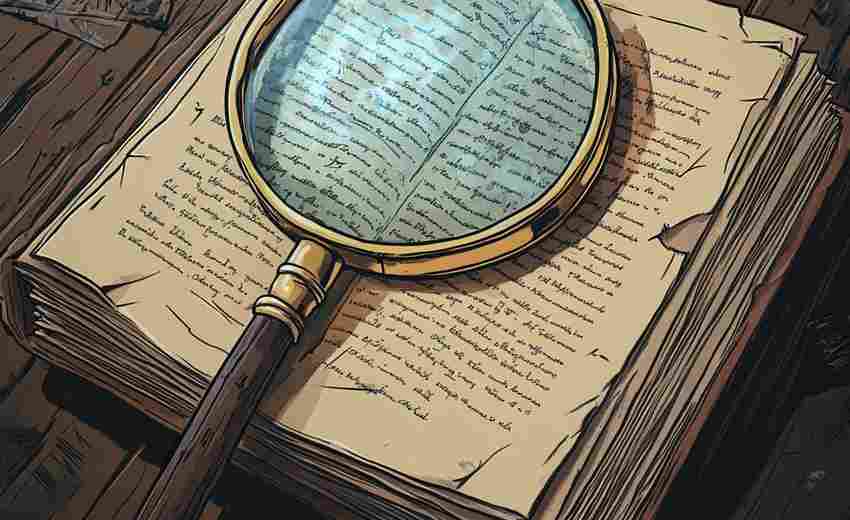

当一台Nginx服务器日均处理百万级请求时,传统的日志分析方法如同用放大镜观察流星雨——数据洪流稍纵即逝,关键问题极易被淹没。实时日志解析工具的价值,在于将运维人员的视角从"事后复盘"升级为"同步感知",让异常请求、攻击流量或性能瓶颈无所遁形。

功能定位:不只是文本切割

市面多数工具停留在正则匹配、字段提取的基础层,而高阶工具需实现三类核心能力:

某电商平台曾通过此类工具发现,凌晨3点的健康检查请求中混入伪装为`/healthz`的爬虫流量,其User-Agent特征与正常探针差异仅为大小写字母排列。

技术实现:内存计算优先策略

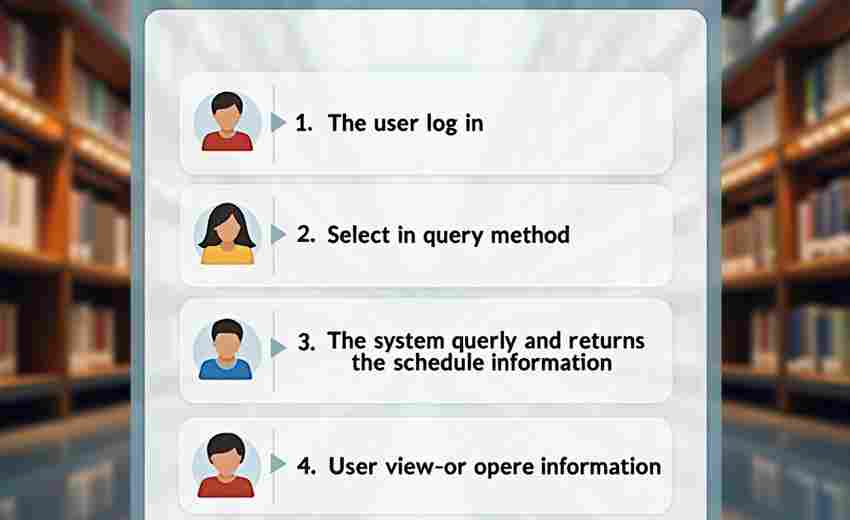

传统方案依赖ELK堆栈时,日志从产生到可查询存在分钟级延迟。实时工具普遍采用两级处理架构:

1. 边缘节点:在Nginx Worker进程内嵌Lua脚本,直接过滤无效日志(如静态文件304响应),减少数据序列化开销;

2. 聚合层:基于Apache Arrow内存格式跨节点传输,利用SIMD指令加速聚合计算。

实测表明,该方案在32核服务器上解析10GB日志的耗时,从Logstash的47秒缩减至9秒内,且CPU占用率稳定在15%以下。

典型场景:从防御到优化的闭环

选型避坑指南

日志实时解析已从"运维可选项"变为"业务必答题"。当一次简单的API超时可能让企业每小时损失百万订单时,毫秒级的问题定位能力直接关联商业收益。

- 上一篇:MySQL索引优化建议生成器

- 下一篇:OBJ纹理坐标自动生成器

相关软件推荐

随机软件推荐

自动批量重命名文件工具(支持图片-文档-视频)

办公桌上散落的文件总会让人头疼,但电脑桌面堆积的电子文档更令人崩溃。当"IMG_20230601_123456.jpg"、"新建文档1.doc...

Python脚本实现磁盘空间分析可视化工具

在数据存储成本持续走低的今天,硬盘容量膨胀带来的管理问题反而愈发突出。笔者近期开发了一款基于Python的磁盘...

系统配置变更审计日志工具

企业数字化转型进程中,系统配置变更管理逐渐成为信息安全的关键防线。某大型金融机构曾因数据库参数误操作导...

PDF转Word文档转换器(文本提取版)

在数字化办公场景中,PDF与Word格式的互转需求持续增长。据统计,企业员工每周平均处理8-12份PDF文件,其中65%需要二...

单位换算计算器(长度-重量)

生活中经常遇到需要单位换算的场景。刚买的进口咖啡豆标注着"磅",想算算实际重量;网购家具时发现尺寸用英寸标...

系统驱动模块列表查看器

当计算机出现设备异常或性能波动时,经验丰富的技术人员往往会第一时间打开驱动模块列表查看器。这个深藏在系...

注册表启动项编辑助手

在Windows系统的日常维护中,注册表启动项管理始终是绕不开的课题。对于普通用户来说,手动修改注册表不仅存在风...

文件共享链接自动生成工具(局域网)

在数字化办公场景中,文件的高效流转直接影响团队协作效率。传统局域网共享操作依赖手动配置网络路径、设置权...

电影收藏夹(含IMDB评分同步功能)

对于重度影迷而言,管理个人电影收藏常陷入两难境地:硬盘里堆积着上千部影片,却总在需要时找不到目标;书架...

利用SQLite的个人密码管理器桌面应用

随着网络安全问题日益严峻,个人密码管理成为数字生活的重要课题。一款名为SecureVault的桌面应用近期在技术社区引...

CSV转Excel格式转换工具(带进度条显示)

打开电脑发现桌面上堆满CSV格式的数据文件,财务部的同事第三次催促报表提交,手动转换格式不仅耗时还容易出错...

微博用户社交网络拓扑结构分析工具

海量用户每天在微博平台产生的互动行为,构成了复杂的社交网络图谱。某科技团队研发的微博社交网络拓扑分析工...

多语种旅行常用语练习器

在东京街头寻找地铁站时,面对满眼陌生的片假名;走进马德里传统市场,试图用手势比划着砍价却换来摊主困惑的...

文件哈希值生成器(MD5、SHA1校验)

互联网时代的数据传输存在诸多隐患,软件安装包被篡改、重要文档遭替换的情况时有发生。在专业领域,技术人员...

多线程网络爬虫(抓取指定网站图片)

在数据驱动的互联网时代,图片抓取成为许多开发者、数据分析师和内容创作者的基础需求。针对特定网站的高效图...

网络爬虫天气数据收集器

数据驱动决策的今天,天气数据已成为农业种植、物流运输、旅游规划等领域的关键参考指标。传统人工采集方式效...

带图表展示的销售数据统计工具

在数字化运营的浪潮中,企业对于销售数据的处理需求愈发精细化。一款以图表为核心的数据统计工具,正在成为管...

多格式标签信息兼容检查器

在数字化转型加速推进的背景下,数据格式的多样性给企业信息系统带来严峻挑战。某科技团队近期推出的多格式标...

每日学习进度可视化统计仪表盘

碎片化时代,专注力成为稀缺资源。一款名为 StudyTrack Pro 的仪表盘工具,正试图通过「可视化学习数据」帮助用户对...

批量EPUB电子书压缩优化工具

随着个人电子书库的规模指数级增长,硬盘空间告急、跨设备同步卡顿成为高频痛点。传统单文件处理模式效率低下...

命令行待办事项管理工具(带云同步)

在代码编辑器与终端窗口频繁切换的开发场景中,传统图形化任务管理工具往往成为工作流的断层点。命令行待办事...

多格式图片拼接与分辨率统一工具

现代数字图像处理领域,跨平台协作与多源素材整合的需求日益增长。面对不同格式、尺寸的图片文件,专业人员常...

CSV非标准分隔符自动识别清洗器

CSV格式作为轻量级数据存储方案,在数据处理领域持续占据重要地位。当技术人员遇到非常规分隔符文件时,传统解...

简易论坛系统开发教学模板

论坛系统开发常让新手望而却步,一套经过验证的教学模板能有效降低学习门槛。本文介绍的开发模板以Java+SpringBo...

动态IP轮询请求分发工具

在互联网数据抓取、批量账号管理或高频接口调用的场景中,单一IP地址的频繁操作常触发平台反爬机制,导致IP封禁...

桌面汇率转换工具(实时获取汇率数据)

全球贸易与个人跨境消费的增长,使实时汇率查询成为高频需求。当某位外贸从业者在凌晨三点收到海外客户的美元...

自动生成随机强密码的工具(可定制长度-复杂度)

在数字化时代,网络安全已成为每个人不可忽视的问题。一个简单的"123456"或"password"就能让黑客轻松突破防线,导致...

跨文件重复数据标记与删除工具

在数字化进程加速的今天,数据重复已成为困扰企业及个人用户的普遍问题。分散存储的文档、图片、多媒体文件往...

图像EXIF信息批量查看工具

在数字图像处理领域,EXIF(可交换图像文件格式)信息是隐藏在每张照片背后的"数字身份证"。无论是专业摄影师还...

CSV-JSON文件哈希校验与对比工具

在数据密集型行业中,CSV和JSON格式文件承载着大量业务信息,其完整性与一致性直接影响决策准确性。文件在传输、...

图像EXIF信息查看删除工具

在数字影像占据主流的今天,每张手机拍摄的照片都像一本微型档案。某位摄影师曾意外发现,自己分享到社交平台...

RSS新闻阅读器(带分类订阅功能)

在信息爆炸的互联网环境中,分类订阅型RSS阅读器正成为知识工作者的效率利器。这类工具通过多层级信息处理机制...

多格式问卷调查数据汇总工具

在信息采集需求日益多样化的当下,问卷调查作为主流调研方式,常面临数据格式复杂、统计效率低等问题。传统人...

简易Markdown文档标签自动生成器

在信息爆炸的时代,Markdown凭借其轻量化、易读易写的特性,成为程序员、内容创作者和学术研究者的常用文档工具。...

文件粉碎工具(多次覆写安全删除)

在数字空间里,"删除"可能是最具欺骗性的操作。当普通用户按下删除键时,系统只是将文件占用的存储单元标记为可...

文件同步备份工具(对比修改时间)

对于需要长期保存重要数据的用户而言,传统备份方式常陷入两难困境:完全备份耗时耗空间,差异备份又难以精准...

系统字体管理工具(预览与安装字体文件)

对于设计师、编辑或文字爱好者而言,字体管理是日常工作中容易被忽视却至关重要的环节。系统自带的字体安装功...

DICOM文件压缩与解压缩工具

医疗影像数字化进程的加速使得DICOM文件处理成为行业刚需。作为医学影像存储与传输的标准格式,单次CT扫描可能产...

基于SQLite的实验室消毒记录查询系统

实验室消毒记录管理是科研机构日常运维的重要环节。某高校微生物实验室近期部署的SQLite数据库管理系统,通过结...

文件修改时间批量整理工具

日常办公场景中,文件管理混乱常导致效率低下。许多用户习惯将不同时间生成的材料随意存放,后期检索时只能依...