分布式压缩任务分配工具

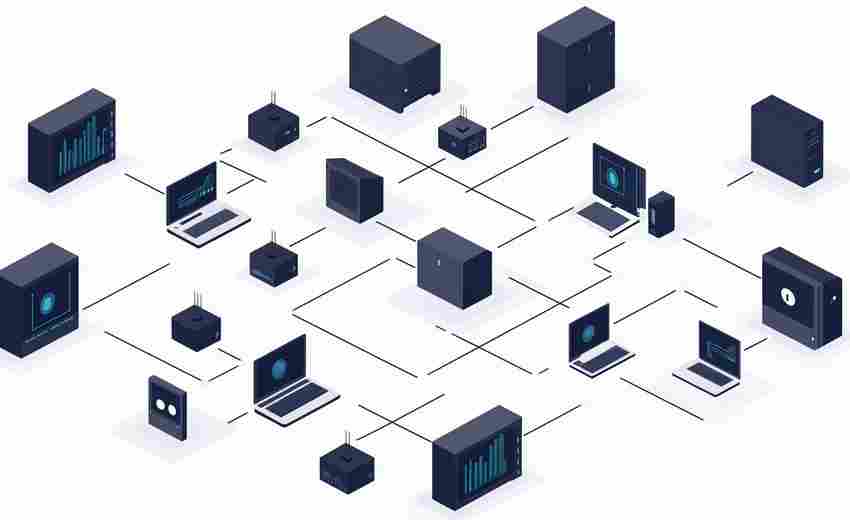

在大数据与云计算技术不断渗透的当下,企业对数据存储与传输效率的要求日益严苛。传统单机压缩模式在处理TB级数据时,常因计算资源瓶颈导致任务延迟,甚至引发系统崩溃。分布式压缩任务分配工具应运而生,通过多节点协同与智能调度机制,实现压缩效率的指数级提升,成为工业界解决高并发数据处理难题的关键技术之一。

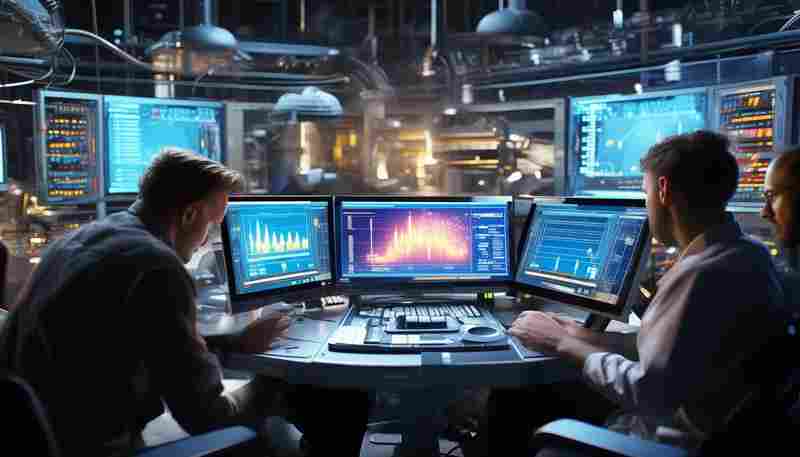

动态负载均衡:突破单机性能天花板

分布式压缩工具的核心在于任务拆分与资源分配逻辑。系统通过实时监测集群中各节点的CPU、内存及带宽占用率,动态调整压缩任务的分配权重。例如,在视频处理场景中,工具可将一段4K视频流按帧拆分为数百个子任务,优先分配至空闲节点处理,避免单一节点因负载过高产生性能抖动。某头部云服务商测试数据显示,相同硬件条件下,分布式压缩较单机模式缩短任务完成时间约78%,且资源利用率提升至92%以上。

多节点协作:从串行到并行的范式迁移

传统压缩流程依赖串行执行,而分布式架构支持多节点并行处理。工具采用“分片-压缩-聚合”三级工作流:先将原始数据切割为独立区块,通过一致性哈希算法分发至不同节点;各节点基于预设算法(如LZ4、Zstandard)完成本地压缩后,由协调节点进行数据重组。这种模式尤其适合非结构化数据场景。某电商平台在日志文件处理中应用该工具,单日压缩吞吐量从3TB提升至28TB,且数据完整性校验通过率达到99.99%。

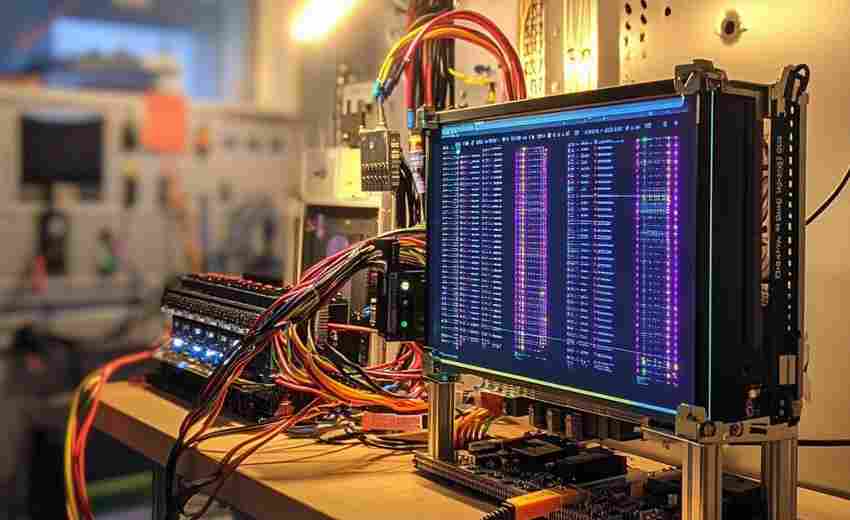

容错与弹性扩展:应对复杂生产环境

工业场景中硬件故障、网络波动等问题难以避免。分布式工具通过冗余计算设计,在主节点宕机时,备用节点可在50ms内接管任务,并通过断点续传机制避免数据重传损耗。系统支持“热插拔”式节点扩展。例如,某自动驾驶公司在路测数据回传高峰期,临时接入20台边缘服务器,集群压缩效率即时提升40%,任务队列积压问题得到显著缓解。

开源生态与行业适配

当前主流工具如Hadoop Compress、Spark-ZLib等,均已集成多算法库与接口标准。开发者可通过插件机制兼容HDFS、Kafka等数据管道,医疗影像领域已有企业通过定制DICOM格式压缩模块,将CT数据存储成本降低65%。随着5G与边缘计算的发展,轻量化分布式压缩框架在物联网设备端的部署案例正持续增加。

技术演进的本质在于解决生产力矛盾。分布式压缩任务分配工具的价值,不仅在于优化现有工作流,更在于为海量数据场景提供了可扩展的技术底座。当数据量突破ZB级时,资源调度精度与算法效率的进一步融合,或将成为下一代工具的核心竞争点。

- 上一篇:冬季路跑防滑鞋钉需求预测系统

- 下一篇:分布式文件搜索工具

相关软件推荐

随机软件推荐

语音转文本转录工具

键盘敲击声在会议室逐渐密集,市场部总监突然将手机推到桌面中央:"这是上周客户电话的录音,谁帮忙整理成文字...

简易日历工具(节假日标记与事件提醒)

打开手机应用商店搜索"日历工具",数百款功能繁复的应用令人眼花缭乱。在众多选择中,某款主打"极简设计+核心功...

Tkinter简易音乐播放器(MP3-WAV)

在Python生态中,Tkinter作为内置GUI开发库常被低估其潜力。近期尝试用其实现一款支持MP3/WAV格式的本地播放器,发现其...

PDF分页目录生成与内容提取器

纸质文档数字化浪潮下,PDF格式已成为企业办公与学术研究的标配载体。某互联网公司法务部员工李明发现,处理一...

网络服务端口占用检测器

在日常服务器运维中,端口占用问题常导致服务启动失败、进程冲突甚至安全隐患。传统排查手段依赖命令行输入,...

自动发送邮件定时器(支持附件)

办公室的传真机早已积灰,但邮件往来仍是现代职场的重要动脉。某位项目经理曾因时差问题,在凌晨三点强撑睡眼...

Excel图片嵌入与导出工具

在日常办公场景中,Excel表格内嵌入图片的需求日益普遍。无论是产品清单中的实物图展示,还是数据报表中的趋势图...

基于Flask的简易电商商品展示Demo

三年前某个创业团队需要验证商品展示功能时,用800行代码搭建起完整的商品系统。这个基于Flask框架的Demo至今仍在...

网页正文内容转语音工具

在信息爆炸的时代,人们每天需要处理大量文字信息。网页转语音工具应运而生,这类软件通过智能语音合成技术,...

简易加密聊天室(Socket网络编程实现)

两台电脑之间传输消息的原理不难理解,就像快递员在收发包裹。服务端好比物流中转站,客户端如同寄件客户,每...

简易论坛帖子关键词监控提醒器

刷论坛找信息有多累?用对工具能省下 80% 精力。这个关键词监控器由 Python 开发,支持 10 个主流论坛平台,能自动抓...

多线程网站响应速度测试器

在网站运维与开发过程中,响应速度直接影响用户体验和业务转化率。一款高效的工具能够帮助开发者快速定位瓶颈...

批量文件重命名工具(序号-日期格式命名)

杂乱无序的文件名如同散落一地的拼图碎片。某互联网公司发布的《2024数字办公行为报告》显示,78%的职场人每月至...

局域网聊天室(带关键词屏蔽)

在数字化转型浪潮下,即时通讯工具的便捷性需求与信息安全管控的矛盾日益突出。基于局域网的聊天室系统凭借其...

系统字体管理更换工具

日常办公或创意设计中,字体管理往往成为被忽略的痛点。当系统积累上千款字体后,启动速度变慢、软件闪退、排...

直播流定时录制与自动停止工具

在直播行业高速发展的今天,内容创作者和运营团队常常面临一个痛点:如何高效留存直播内容?手动录制不仅耗费...

桌面悬浮窗网速监测器

在互联网深度融入日常的今天,网络速度的稳定性直接影响着工作与娱乐的体验。无论是视频会议卡顿,还是游戏延...

浏览器标签页内存回收管理工具

每当工作电脑因为同时打开二十多个网页卡到怀疑人生,多数人都会意识到Chrome这类现代浏览器本质上是"内存杀手...

使用Asyncio的异步网络请求批处理工具

网络请求批处理在爬虫开发与API调用场景中具有关键作用。当面对需要同时处理上千个网络请求的任务时,传统同步...

Python版简易FTP服务器客户端

在数据交换需求频繁的办公场景中,FTP协议仍是跨平台传输的可靠选择。Python生态圈提供的开发工具包,让程序员能...

系统快捷键管理程序(热键绑定执行命令)

办公场景中频繁切换鼠标的操作常被视为效率杀手。桌面角落的咖啡早已冷却,而用户还在重复着点击、拖拽、查找...

多格式(JSON-XML)转换工具

在互联网数据传输过程中,JSON和XML两种格式如同现实世界中的通用语言,分别占据着API接口和传统系统的半壁江山。...

CSV日志异常值自动标注工具

在数据分析领域,日志文件是记录系统运行状态的核心载体,而CSV格式因其简洁性成为主流存储方式。面对海量日志...

简易二维码生成器(含内容解析功能)

二维码早已渗透进生活的每个缝隙。餐厅点餐、文件传输、活动签到——这个黑白小方块承载的信息量远超想象。随...

电脑空闲时间统计工具(记录屏幕活动时长)

打开电脑时总想着完成某个计划,回过神来却发现已刷了两小时短视频。这种时间黑洞困扰着95%的互联网使用者,而...

简易计算器桌面程序

在数字化工具层出不穷的当下,一款功能纯粹、操作流畅的桌面计算器软件仍是许多用户的首选。无论是学生、上班...

桌面倒计时提醒工具(可自定义提示音)

现代人常陷入专注力碎片化的困境。一款支持自定义提示音的桌面倒计时工具,正成为对抗注意力分散的实用解决方...

简易博客系统(支持Markdown文章发布)

清晨七点,咖啡机刚发出第一声嗡鸣,独立开发者张明已经打开了那款深色模式的Markdown编辑器。他敲下三级标题符号...

密码生成与管理工具(含加密存储)

当某科技公司员工因重复使用简单密码导致千万用户数据泄露时,全行业都意识到密码管理不再是个人事务。面对日...

基于PyMySQL的数据库备份恢复工具

在Python生态中,PyMySQL作为纯Python实现的MySQL客户端库,其轻量化特性深受开发者青睐。基于该库构建的数据库备份恢...

TensorFlow模型训练工具

数据预处理环节的tf.data模块显著提升了数据管道构建效率。通过Dataset对象的链式操作方法,工程师能够实现多线程数...

带异常重试机制的FTP同步工具

传输层协议(FTP)作为企业级文件传输的主流方案,其稳定性直接关系到业务连续性。传统FTP客户端常因网络抖动、...

设备端口映射关系可视化工具

在数字化转型的浪潮中,某科技公司研发中心最近收到二十余家客户单位的共性需求反馈。这些来自金融、制造、医...

天气预报查询工具(按城市显示多日数据)

清晨六点,北京某互联网公司的产品经理在洗漱时打开天气应用。滑动屏幕查看纽约、伦敦、东京三地的实时天气数...

请求异常自动重试控制器

网络抖动、服务超时、资源竞争...这些看似偶然的异常,在分布式系统中却成为影响稳定性的高频杀手。某电商平台...

容器核心文件生成监控工具

在云原生架构快速落地的当下,容器技术已成为基础设施的核心组成部分。容器环境中进程崩溃产生的核心文件(C...

Windows服务自动启停控制工具

在Windows服务器管理中,服务的启停操作看似简单,却隐藏着大量重复性劳动。凌晨三点的定时重启、特定进程异常后...

验证码识别失败自动重试工具

网络爬虫遭遇验证码拦截时,系统往往会陷入停滞状态。某款新型工具通过动态调整识别策略与重试机制的组合应用...

快捷键操作记录便签工具

在信息爆炸的时代,办公族常陷入多任务处理的漩涡。键盘快捷键的熟练运用,能将操作效率提升数倍,但多数人仅...

网页内容抓取器(指定URL列表)

网页内容抓取器作为数据采集领域的实用工具,正在被越来越多的开发者及企业关注。该工具的核心功能是通过预设...