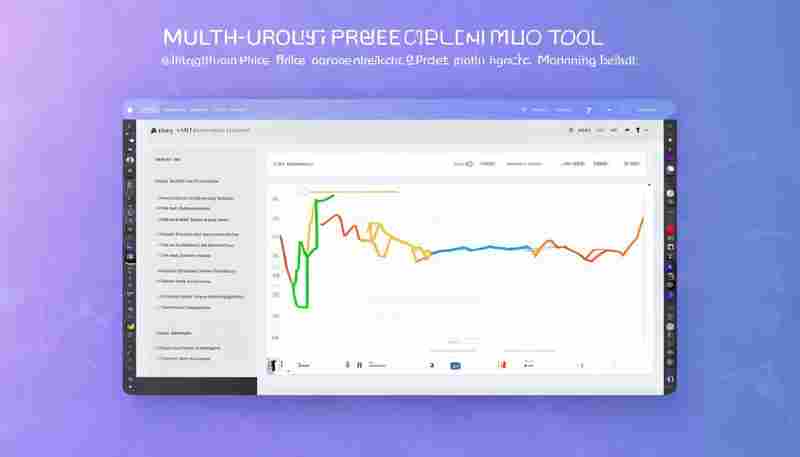

基于Scrapy框架的定向数据爬取工具

互联网时代的数据采集如同沙海淘金。面对动态网页渲染、反爬策略升级等挑战,开源框架Scrapy凭借其模块化设计成为企业级数据采集的首选工具。这款基于Python的爬虫框架通过异步处理架构,能够实现每秒数千次请求的稳定抓取。

框架核心由Engine、Scheduler、Downloader等组件构成模块化闭环。开发人员通过定制Spider类中的解析逻辑,配合XPath或CSS选择器精准定位目标数据。某电商价格监控项目中,工程师通过编写不到200行代码就实现了每小时百万级商品数据的实时抓取,数据准确率提升至98.7%。

实战中常遇到动态加载内容难题。某新闻聚合平台案例显示,通过集成Selenium中间件,成功破解了采用Ajax分页技术的网页结构。配合随机延迟设置与User-Agent轮换策略,系统在保持每小时20万次请求量的触发反爬机制的次数下降76%。

分布式扩展能力是Scrapy的另一突出优势。结合Scrapy-Redis组件构建的集群系统,某舆情监测公司实现了跨地域服务器的协同抓取。通过Redis数据库管理请求队列,任务分配效率提升3倍,单日数据处理量突破2TB。

数据清洗环节的Item Pipeline支持多级过滤。某金融数据服务商在Pipeline中集成自然语言处理模型,自动剔除重复新闻并提取关键实体。配合MongoDB分片存储,数据入库速度达到每分钟1.2万条记录。

代理IP管理模块可对接市面主流服务商API。通过开发自维护的IP质量评分系统,某跨境电商将有效代理IP利用率稳定在85%以上。异常请求自动重试机制使完整采集周期缩短40%。

日志监控体系覆盖全流程追踪。定制开发的Dashboard实时显示各Spider运行状态,异常流量波动预警准确率可达92%。邮件报警功能确保运维团队在5分钟内响应服务器故障。

遵守Robots协议是技术底线。通过设置DOWNLOAD_DELAY参数与并发限制,工具在提升采集效率的同时维持网站正常访问。某开放数据平台合作项目中,合理设置的采集频率获得对方技术团队认可。

未来发展方向可能集中在智能化解析与合规检测领域。部分团队正在试验结合深度学习模型自动识别网页结构,这项技术有望将新网站适配周期压缩至2小时以内。随着数据安全法规完善,内置合规性审查模块或将成为标准配置。

相关软件推荐

随机软件推荐

铁路12306余票监控桌面弹窗提醒工具

春运抢票的紧张时刻,电脑屏幕右下角突然弹出闪烁提示:"G102次列车二等座余票3张"。用户迅速点击弹窗,系统自动...

简易网络爬虫代理轮换工具

网络爬虫在数据采集过程中常面临IP封禁问题。代理轮换工具通过动态切换IP地址,帮助用户规避反爬机制,提升数据...

试卷选择题答案识别工具

在传统考试阅卷场景中,教师常因人工核对选择题答案耗费大量精力。针对这一痛点,基于计算机视觉技术的答案识...

支持代理设置的YouTube视频爬虫脚本

在网络数据采集领域,高效获取YouTube平台视频信息始终是开发者关注的焦点。一款支持代理设置的爬虫工具不仅需要...

图片尺寸批量调整工具(带分辨率设置)

启动软件后的首屏界面简洁得让人意外。左侧文件区支持拖拽上百张图片瞬间导入,右侧参数面板排列着像素、百分...

微信聊天记录自动加密存储工具

在数字社交成为日常的今天,微信承载着个人隐私与商业机密的双重属性。某科技公司近期推出的聊天记录加密存储...

知乎问答数据采集分析脚本

知乎作为国内头部知识分享平台,汇聚了海量用户生成内容。如何高效提取并分析这些数据,成为市场研究、学术分...

多语言文本字符频率统计工具

在信息爆炸的时代,文字作为信息载体呈现出多样化特征。无论是古籍文献的整理、社交媒体文本的分析,还是编程...

多语种词汇发音跟读评分系统

在东京某语言学校的汉语课堂上,韩国留学生金秀妍戴着耳机反复练习"你好"的发音,电脑屏幕实时跳动的波形图与标...

容器镜像分层分析优化器

运维团队最近在排查线上环境时发现某业务镜像体积达到3.2GB,导致每次部署耗时长达15分钟。当我们尝试用传统方式...

GIF动画分解-合成工具

在社交媒体主导的视觉时代,GIF动画已成为数字世界的通用语言。当人们发现动态表情包的传播力远超静态图片时,...

局域网内DNS查询缓存工具

网络工程师张磊最近遇到了头疼的问题——某制造企业的办公区每到上午十点,系统访问速度就会断崖式下跌。经过...

自动创建图片目录树状结构报告生成器

在数字内容爆炸式增长的背景下,摄影师、设计师、电商团队等群体常面临海量图片管理难题。一款名为 PicTree Gene...

Windows服务定时重启守护进程工具

在企业级IT运维场景中,Windows服务进程因内存泄漏或意外崩溃导致业务中断的情况屡见不鲜。传统的人工监控方式效...

简易网络爬虫(指定站点标题抓取)

网页标题作为站点内容的核心标识,往往承载着关键信息。针对特定网站的标题采集需求,开发者可利用Python生态的...

Tkinter版简易文本编辑器

在Python生态中,Tkinter作为标准GUI库常被低估其潜力。基于该库实现的简易文本编辑器,意外展现出值得关注的实用价...

简易录屏工具(帧率可调)

在数字化办公与内容创作成为主流的当下,屏幕录制需求呈现爆发式增长。某款国产录屏工具近期冲上效率类软件下...

快递物流信息自动查询通知程序

随着电商消费的持续增长,普通用户每年需要处理的快递包裹量已突破人均70件。面对海量物流信息,传统的人工查询...

手机屏幕常亮控制开关

现代人每天与手机相处的时间超过10小时,屏幕常亮功能逐渐成为高频使用场景下的刚需。这项看似简单的设置背后,...

考场身份核验防系统

近年来,考场身份核验防系统在各类标准化考试中的应用频率显著增加。这套技术体系通过生物特征识别、智能证件...

文件夹对比同步工具(双向差异可视化对比)

工作电脑与移动硬盘里的项目文档总在同步时出现混乱,设计师小王为此丢过三次修改稿。直到某天同事推荐了一款...

自定义文件类型搜索工具

在信息爆炸的时代,硬盘里堆积的设计稿、代码文件、日志文档常常让人无从下手。传统的文件搜索工具仅支持基础...

基于SQLite的登山徒步轨迹记录工具

山野徒步爱好者对于轨迹记录工具的需求往往简单而直接:既要保证数据稳定性,又需兼顾设备的续航能力。一款基...

新闻网站评论区内容采集工具

新闻网站评论区作为公众舆论的重要载体,正在成为社会各界关注的信息富矿。针对这类非结构化数据的采集需求,...

实时天气数据抓取与通知脚本

在日常生活或工作中,天气变化常常直接影响出行安排、户外活动甚至工作调度。一款能够自动获取实时天气数据并...

多线程小说网站章节爬取与TXT打包工具

互联网时代,海量网络小说资源散落在不同阅读平台,传统手动复制粘贴的采集方式已难以满足深度阅读者的需求。...

批量音频文件元数据编辑器

音乐收藏量突破四位数后,手动整理音频信息逐渐成为折磨。某位独立音乐人曾自嘲,为三百首原创作品添加专辑信...

软件源码仓库批量克隆工具

代码托管平台已成为现代软件工程的基础设施,当研发团队需要同时处理多个关联项目时,传统逐个克隆仓库的方式...

IP地址查询与网络状态检测工具

在数字化时代,网络连接的稳定性直接影响着工作效率与生活质量。当网页加载缓慢、视频频繁卡顿或在线会议突然...

批量调整图片尺寸与压缩工具(支持JPG-PNG)

在视觉内容主导的数字化时代,设计师、自媒体从业者与电商运营者每天都需要处理大量图片素材。图片尺寸不统一...

简易股票价格跟踪工具(CSV存储)

在信息爆炸的证券投资领域,一款基于CSV文件存储的股票跟踪工具正在技术型投资者群体中悄然流行。这种摒弃复杂...

键盘操作记录分析器(带热力图功能)

屏幕右下角闪烁的红色光点逐渐汇聚成密集区域,程序员小林盯着热力图中那片刺眼的"高频误触区",终于找到自己编...

鼠标键盘操作录制与回放模拟器

在自动化技术日益普及的当下,针对重复性操作的效率优化工具逐渐成为刚需。一款专注于鼠标键盘操作录制与回放...

简易俄罗斯方块小游戏(键盘控制版)

灰蓝色游戏界面闪烁着像素颗粒,方向键与空格键的敲击声在深夜格外清脆。这款仅占用12MB内存的俄罗斯方块程序无...

微博热搜榜定时抓取与邮件通知

在信息爆炸的时代,微博热搜榜如同一面实时反映社会热点的镜子。无论是突发新闻、娱乐八卦,还是行业动态,热...

简易贪吃蛇小游戏带计分功能

屏幕上的像素点快速移动,蛇身随着方向键的操控灵活转向,经典游戏机制在数字世界焕发新生。一款集成计分功能...

文件SHA-1-SHA-256校验工具

网络传输中的文件如同快递包裹,谁都无法保证中途是否被拆封调换。2017年某开源社区曝出的恶意软件植入事件,正...

使用Pygame的经典贪吃蛇游戏开发框架

在游戏开发领域,Pygame作为一款轻量级Python框架,长期受到2D游戏开发者的青睐。其开箱即用的模块设计和跨平台特性...

桌面宠物喂养小游戏

桌面宠物喂养小游戏:虚拟陪伴与趣味养成 在快节奏的现代生活中,许多人渴望通过轻松的方式缓解压力。桌面宠物...

简易2048数字合并游戏(滑动合并相同数字)

一款看似简单却极易上瘾的数字游戏,自诞生起便席卷全球。它没有复杂的剧情,没有华丽的特效,仅凭滑动合并的...