日志文件时间戳分析与过滤工具

在日志分析过程中,时间戳的混乱常常成为排查故障的绊脚石。不同系统、服务或地区生成的日志可能采用多样的时间格式(如ISO 8601、Unix时间戳、自定义格式),甚至混杂多时区数据。当工程师需要定位问题时,手动对齐时间、筛选关键时段的工作不仅耗时,还容易因人为误差导致疏漏。为此,针对日志时间戳的专项处理工具应运而生,成为提升运维效率的刚需。

核心功能:精准解析与智能过滤

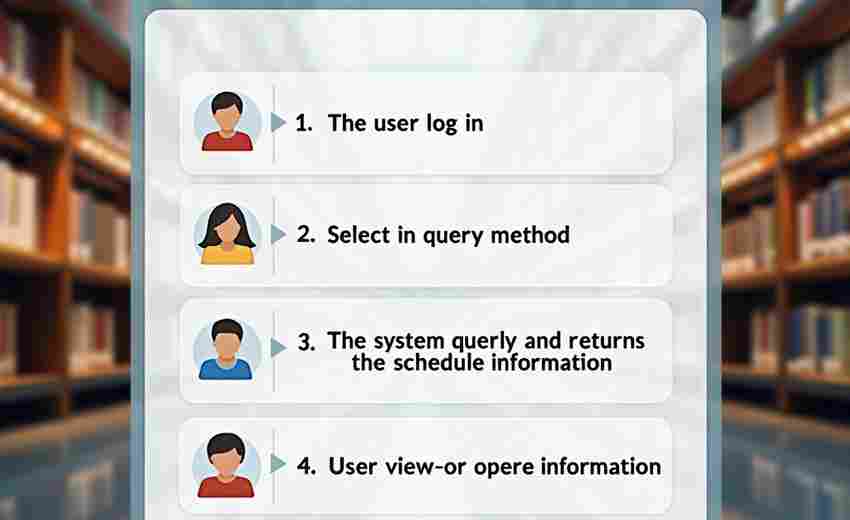

这类工具通常内置多种时间格式解析器,能够自动识别日志中的时间字段并将其转换为统一的基准时区。例如,某跨国电商平台的日志可能同时包含纽约服务器(UTC-5)和北京服务器(UTC+8)的时间戳,工具可将其统一为UTC时间,避免跨时区换算的繁琐。

时间范围过滤是另一项核心能力。用户可通过自然语言(如"2023-10-01 14:00至16:00")或相对时间(如"最近2小时")快速划定分析区间。更高级的版本支持正则表达式与时间条件组合过滤,例如提取“每秒请求量超过1000的时段”对应的日志片段。

场景实战:从海量数据中定位异常

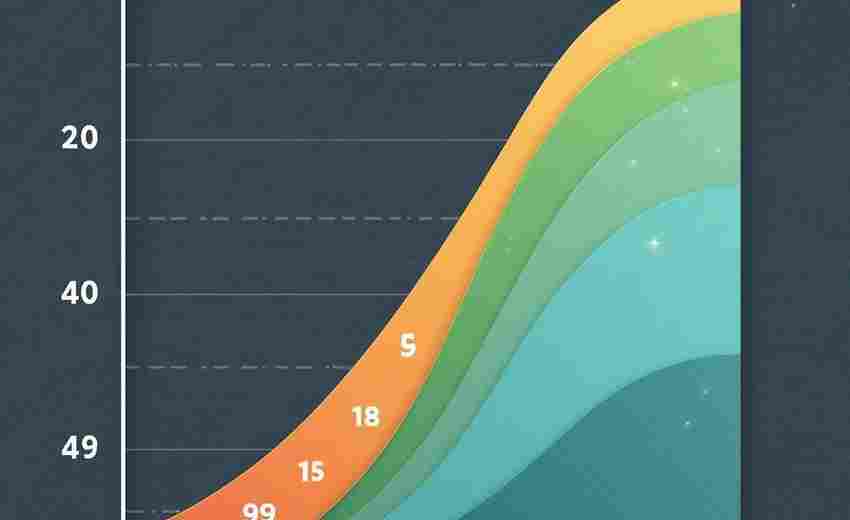

某视频平台曾遭遇直播卡顿问题,运维团队需从TB级日志中定位故障源头。传统的关键词搜索因时间范围模糊,耗费6小时仍未取得进展。而使用时间戳过滤工具后,他们首先将日志按5分钟粒度分段,结合带宽、延迟指标的突变时间点,迅速锁定异常发生在凌晨3:05至3:12之间。进一步分析该时段日志,发现某CDN节点因配置错误导致流量雪崩。整个过程压缩至20分钟,效率提升超过18倍。

扩展能力:兼容性与自定义规则

优秀的工具还需适应复杂环境。部分遗留系统可能使用非标准时间格式(如"Oct/01/2023-14:00:00"),此时需支持用户自定义正则表达式模板。对K8s、Flink等现代架构的日志集成能力也至关重要。例如,某工具通过插件机制兼容了容器环境的纳秒级时间戳,确保分布式场景下的时序对齐精度。

性能优化:速度决定体验

处理亿级日志时,工具底层算法直接影响效率。采用多线程解析、时间字段索引预构建、内存映射文件等技术,可将TB级数据的过滤耗时控制在秒级。某测试案例显示,对1亿行日志进行跨3天时间窗口的筛选,传统文本处理工具需12分钟,而专项工具仅需8秒。

未来,随着日志实时分析需求的增长,时间戳工具或将与流处理引擎深度结合,支持动态时间窗口内的即时告警与统计。这类演进方向,正在重新定义故障排查的边界。

- 上一篇:日志文件按时间过滤分析工具

- 下一篇:日志文件时间戳解析与统计工具

相关软件推荐

批量文件重命名工具(支持按规则替换、序号添加)

发布日期: 2025-04-04 19:48:02

日常工作中整理数百张会议照片时,总会出现"IMG_20230601_001(1)(备份).jpg"这类混乱文件名...

日志时间戳重命名批处理工具

发布日期: 2025-03-30 19:02:49

当服务器日志文件堆积如山时,"access_2023.log""error_log_1"这类随机命名的文件常让运维人...

随机软件推荐

多账号云盘文件搜索聚合工具

当代人手机里至少安装着3个以上云盘应用。百度网盘存放着工作文档,阿里云盘塞满影视资源,腾讯微云里躺着学生...

多线程网站死链扫描报告生成器

在网站运维过程中,"死链"如同隐形的绊脚石,不仅损害用户体验,还会导致搜索引擎排名下降。传统的人工排查方式...

社交媒体舆情摘要日报生成器

在信息爆炸的社交媒体时代,企业、机构甚至个人每天面对海量舆情数据,如何快速提炼核心信息成为痛点。一款名...

系统注册表查看器(仅读取功能)

在Windows操作系统中,注册表扮演着核心数据库的角色,存储着硬件、软件、用户配置等关键信息。直接通过系统自带...

学术论文查重报告摘要生成器

当前学术环境中,论文重复率检测已成为学术研究的重要环节。针对传统查重报告存在的冗长信息筛选难题,新型智...

桌面便签备忘录软件(支持文字置顶显示)

办公桌上堆积的便利贴逐渐被电子设备取代,但碎片信息管理难题依然存在。近期测试的一款桌面便签软件,凭借其...

自动化网页表单批量提交工具(支持CSV输入)

互联网时代,重复性表单填写成为行政办公、数据采集、用户运营等场景的痛点。某电商平台运营团队曾统计,人工...

二维码生成器(自定义内容-尺寸)

在数字化浪潮中,二维码成为连接线下与线上的重要载体。无论是产品包装、活动海报还是电子文档,用户对二维码...

系统垃圾文件自动清理工具(临时文件清理)

电脑右下角突然弹出"存储空间不足"的提示,系统盘图标不知何时染上了刺眼的红色。这种场景对Windows用户来说并不...

新闻标题关键词提取学习工具

新闻行业每天产生海量信息,如何快速捕捉核心内容成为从业者的必修课。新闻标题关键词提取工具应运而生,这种...

进程树状关系可视化查看器

在操作系统领域,进程间的层级关系如同错综复杂的神经网络。传统的命令行工具(如`pstree`或`tasklist`)虽然能展示...

系统字体查看与管理工具(字体预览)

系统字体库长期堆积的混乱状态,让很多设计师打开PS时都需面对加载缓慢、重复字体干扰的问题。此时专业字体管理...

基于终端的彩色压缩进度动画指示器

在服务器机房昏暗的灯光下,运维工程师盯着黑色终端界面,反复按动回车键刷新压缩进度。这种传统场景正在被新...

IP地址冲突自动检测报警工具

现代企业网络常因设备数量激增陷入管理困境,某中型制造企业曾因生产线设备IP冲突导致整网瘫痪6小时,直接损失...

文件夹结构递归遍历与统计工具

在数字化办公场景中,文件管理系统常面临结构混乱的挑战。某互联网公司运维团队曾因服务器存储空间告急,耗费...

命令行文件内容差异高亮显示工具

在代码审查或配置修改场景中,开发人员经常需要快速定位文件差异。传统的diff命令输出黑白文本,面对复杂修改时...

批量文件重命名工具(正则替换规则)

办公桌上散落着数百张手机照片,文件名是混乱的"IMG_2023_undefined(1).jpg";程序员面对着三天内生成的500个调试日志文...

网页爬虫数据采集器(带请求间隔控制)

在数据驱动决策的当下,企业对于公开网络数据的采集需求呈现指数级增长。针对这一需求,市场上涌现出多款支持...

社交媒体动态正文去广告保存工具

【社交平台内容净化指南】刷屏时代,广告与正文混杂的图文动态让人不胜其烦。当用户想保存旅行攻略里的干货路...

Python版磁盘空间分析器

当C盘突然飘红时,人们常陷入手忙脚乱的境地——删哪个文件?哪个文件夹占用了最大空间?系统自带的存储管理工...

论坛帖子自动备份与本地存储工具

互联网时代,论坛承载着无数珍贵的内容沉淀。某技术论坛版主最近发现,自己运营七年的编程讨论区因服务器迁移...

多用户协作文件时间备份管理器

在跨国广告公司的设计部门,每周都会上演惊险的"文件保卫战"。市场总监误删提案终稿、设计师覆盖同事的图层、法...

网络服务可用性轮询检测工具

服务器宕机导致用户流失,API响应延迟引发客户投诉,这类问题在互联网业务中屡见不鲜。某跨国电商平台曾因未及...

图层通道分离混合调试器

在数字图像处理领域,专业工具的迭代速度往往超过从业者的认知更新。近期在Adobe Photoshop CC 2023版中,图层通道分离...

网络Ping延迟测试工具(可视化结果输出)

盛夏午后,某游戏公司运维部传来键盘敲击声。张工盯着屏幕上忽高忽低的延迟曲线,快速锁定到上海机房的网络波...

简易电子书EPUB格式转换TXT工具

纸质书与电子书共存的年代,阅读场景变得愈发多元。地铁通勤时用手机看小说,咖啡馆里用平板做文献批注,深夜...

社交媒体消息朗读通知程序(多平台支持)

现代人日均接收的社交媒体消息量呈指数级增长,微信、微博、Twitter、Facebook、Instagram等平台的消息提醒不断冲击着...

图像颜色模式转换工具(RGB转CMYK)

在数字设计与印刷领域,色彩模式转换始终是绕不开的实用需求。当设计师将作品从电子屏幕转向实体印刷时,RGB向...

批量去除图片背景工具(简单抠图)

在数字图像处理领域,去除背景是许多设计师、电商从业者和普通用户的刚需。面对海量图片处理需求时,传统手动...

启动程序版本自动更新检查器

软件行业存在一个普遍痛点:近30%的用户流失源于版本更新引发的兼容性问题。开发团队若无法及时掌握终端用户的...

简易RSS阅读器(带文章摘要生成)

信息爆炸时代,每天面对海量资讯,如何高效获取有效内容成为现代人必修课题。近期一款名为「智阅」的RSS阅读工...

多语言键值对批量查找替换编辑器

在全球化的开发场景中,多语言键值对文件(如JSON、YAML)的管理常成为痛点。传统的手动修改方式不仅效率低下,还...

文件属性查看器(显示隐藏系统属性)

在Windows系统日常使用中,用户常会遇到需要查看特殊文件属性的场景。常规资源管理器仅显示基础信息,当需要查看...

桌面天气预报小部件(API数据获取)

清晨推开办公室窗户时,桌面右下角的圆形小部件正显示着实时湿度数据——67%的数值让准备浇花的行政主管收回了...

团队任务分配协作平台API

在数字化协作场景中,团队任务的高效流转与资源合理分配直接影响项目推进效率。 团队任务分配协作平台API 作为一...

日志文件空值检测工具

在数字化业务场景中,日志文件作为系统运行状态的记录载体,其数据完整性直接影响运维效率与故障排查的准确性...

TXT文本重复段落合并工具

日常处理文本时,重复段落常成为困扰。无论是整理访谈记录、校对稿件,还是分析数据日志,冗余内容不仅降低效...

表情包自动下载器(爬取热门素材)

当代互联网社交中,表情包早已突破"配图"功能,演变为一种独特的交流语言。面对群聊斗图时的手足无措,或是运营...

数据校验异常工单系统

在企业的日常运营中,数据异常如同暗礁,稍有不慎便会引发业务停滞甚至决策失误。传统的人工排查方式效率低下...

基于Tkinter的RSS订阅关键词过滤桌面应用

在信息爆炸的时代,RSS订阅依然是许多人获取垂直领域内容的核心渠道。面对海量更新,如何快速定位关键信息成为...