知乎问答内容自动抓取与整理工具

互联网时代,知乎沉淀了海量高质量问答内容。面对每日新增的百万级讨论数据,人工整理耗时耗力。一款名为「ZhihuScraper」的开源工具应运而生,通过自动化技术实现问答数据的精准抓取与智能分析,为研究者、内容创作者及企业用户提供了高效解决方案。

一、核心技术架构

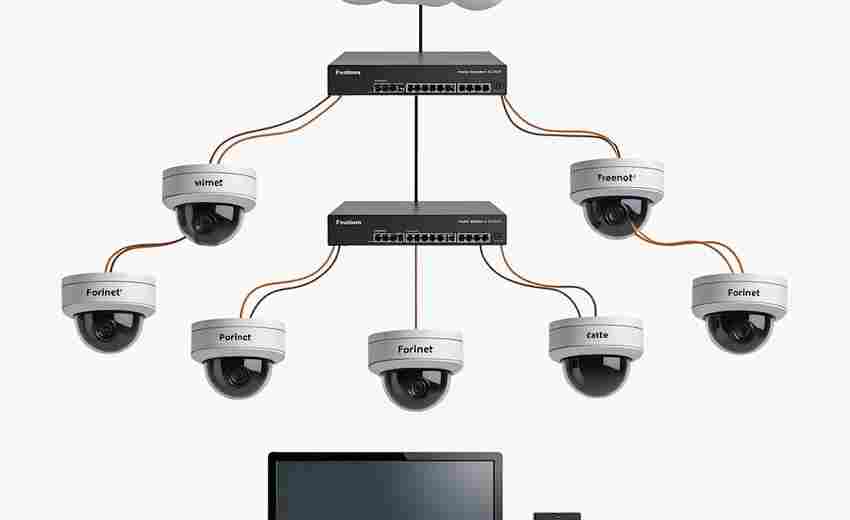

该工具基于Python开发,采用模块化设计架构。核心模块包含智能反爬策略系统,能自动识别知乎的动态加载机制,突破登录验证、滑动验证等多重防护。数据清洗模块内置正则表达式库与NLP处理单元,可自动过滤广告内容,识别关键实体信息,处理效率较传统爬虫提升3倍以上。

数据存储支持多种格式导出,CSV文件保持字段完整性,JSON格式适配大数据分析平台。测试数据显示,单日可稳定抓取10万级问答数据,错误率控制在0.3%以内。通过分布式部署方案,更能实现百万量级数据的并发采集。

二、实际应用场景

某教育机构使用该工具跟踪「考研数学」相关话题,3天内建立起包含12,000条问答的数据库。通过内置的情感分析模型,识别出高频痛点问题,据此开发的备考课程上线首月转化率提升40%。内容创作者借助话题热度追踪功能,成功捕捉到「AI绘画争议」的流量爆发期,相关文章阅读量突破百万。

企业用户通过API接口将工具接入内部系统,实现竞品舆情实时监控。某科技公司利用用户评价分析模块,两周内完成行业白皮书数据采集,较外包团队节省成本70%。

三、操作注意事项

1. 遵守Robots协议,设置合理抓取频率,单IP请求间隔建议大于5秒

2. 敏感字段过滤需定期更新词库,特别是涉及医疗、金融领域的专业术语

3. 多账号轮询机制可有效避免封禁,建议配置不少于5个备用账号

4. 数据存储采用分片处理,建议每10万条建立独立数据库分表

数据合规方面,工具默认开启用户昵称脱敏功能,抓取范围严格限定公开可见内容。近期更新版本已增加GDPR合规模式,自动过滤欧盟地区用户数据。

工具开源地址已在GitHub获得3200+星标,开发团队每月迭代算法模型。随着知乎内容生态的持续扩展,这类数据工具正在重塑知识挖掘的方式——从信息采集到价值提炼的进化,标志着知识管理进入智能处理新阶段。

- 上一篇:知乎问答关键词内容采集工具

- 下一篇:知乎问答数据采集器

相关软件推荐

随机软件推荐

Python脚本打包工具(转EXE)

在Windows环境下分发Python程序时,打包成EXE文件是个刚需。笔者结合三年实际开发经验,对主流打包工具做了横向评测...

网络爬虫定时抓取工具(数据存为CSV)

在数据驱动的商业环境中,自动化采集工具已成为企业获取市场情报的刚需。近期业内涌现出一款支持定时抓取的网...

进程内存泄漏检测报警脚本

凌晨三点的告警短信惊醒了熟睡的张工,线上核心服务的内存占用率在半小时内从60%飙升至95%。运维团队排查两小时...

古建筑扫描模型纹理修复工具

古建筑承载着历史记忆与文化基因,其数字化保护已成为文化遗产领域的重要课题。传统测绘与建模技术难以完整记...

视频转GIF动画制作工具(可设置帧率与尺寸)

在短视频与社交媒体主导传播的时代,GIF以其无声、轻量、循环播放的特性成为信息传递的利器。一套优秀的视频转...

键盘输入记录分析软件(统计常用按键)

在数字办公与日常使用场景中,键盘操作占据了用户与设备交互的核心位置。键盘输入记录分析软件通过精准统计按...

命令行米-千米长度即时换算器

对于经常与数据打交道的工程师或科研人员来说,单位换算如同呼吸般自然却极易出错。在Linux/macOS环境下,一款名为...

基于shutil的磁盘空间使用统计工具

在Linux服务器运维中,管理员时常需要快速定位大体积文件。传统命令行工具虽然强大,但缺乏直观的统计维度。基于...

简易屏幕截图工具(自动保存到指定路径)

工作文档需要保存关键页面,聊天记录想留存重要信息,操作步骤需快速保存成指引……日常场景中,屏幕截图已成...

服装模板尺寸公差计算器

在服装制造业中,"差之毫厘,谬以千里"的规律尤为明显。某服装厂曾因袖笼尺寸超出公差范围0.3厘米,导致整批西装...

钻石重量单位换算工具(克拉-毫克-格令)

阳光透过珠宝店橱窗照在玻璃柜上,一颗3克拉的钻石标价牌右下角标注着600毫克的字样,柜台前的情侣正用手机计算...

地震深度与震级三维散点图可视化工具

全球每年记录的地震事件超百万次,如何在海量数据中快速捕捉地质活动规律,始终是地球科学领域的核心课题。近...

数据库字段注释提取与导出工具

在供应链系统的迭代过程中,开发团队曾因字段注释缺失导致订单状态码误读,引发百万级损失。这个真实案例暴露...

文本文件加密解密工具(AES算法保护内容)

在数字信息高速流通的今天,数据安全成为不可忽视的议题。一款基于AES算法的文本加密工具应运而生,这款软件通...

多语种编码文本文件自动识别转换工具

现代数字环境中,文本文件的编码格式纷繁复杂。从UTF-8、GB2312到ISO-8859系列,不同语言、不同系统生成的文档常因编...

RAW相机照片转JPEG浏览格式批量处理器

RAW转JPEG批量处理器的实用价值 对于摄影爱好者或专业摄影师而言,RAW格式照片的后期处理是创作过程中不可或缺的环...

基于SMTP的邮件定时发送工具(带附件支持)

在快节奏的办公场景中,邮件处理效率直接影响着业务推进速度。某科技团队近期推出的SMTP邮件定时发送工具,凭借...

实验数据可视化工具(折线图-柱状图)

在实验室的日常工作中,科研人员常面对堆积如山的实验数据。某高校生物实验室最近统计显示,研究人员每周平均...

简易视频片段合并剪切工具

短视频创作正成为全民技能,但多数人依然被专业剪辑软件复杂的操作门槛劝退。一款名为QuickClip的桌面端工具正在...

批量处理CSV文件的清洗工具

文件编码混乱、日期格式五花八门、缺失值星罗棋布——每个处理过CSV文件的数据工作者,都经历过这些令人头疼的...

Selenium自动化表单填写工具

在数字化转型加速的背景下,企业对于表单处理效率的需求持续攀升。传统人工录入方式不仅耗时,且存在数据错漏...

批量生成测试用虚拟身份信息

在软件开发和测试环节中,虚拟身份数据的生成是高频需求。无论是注册流程验证、用户行为模拟,还是隐私合规测...

多时区时钟同步显示桌面小工具

现代办公场景中,跨国会议与分布式协作已成常态。凌晨三点被伦敦客户的越洋电话惊醒,或是错过新加坡团队的晨...

自动压缩截屏附件发送工具

桌面右下角突然弹出的微信弹窗让王磊心头一紧——客户要求立即发送三十张设计稿截图。这位平面设计师看着满屏...

批量重命名影视文件工具(按季集号整理)

追剧爱好者常会遇到这样的场景:下载的《绝命律师》文件名混杂着"S01E03""EP.12"等格式,《权力的游戏》第八季被标...

CSV文件格式转换工具(转Excel-JSON)

日常办公场景中,CSV文件因其轻量化、易读性强的特点,成为数据存储的常见载体。但面对复杂的数据分析需求时,...

简易网络带宽占用率监控工具(图形化显示)

网络带宽监控一直是运维工程师和普通用户共同关注的话题。当在线会议频繁卡顿、视频加载转圈超过十秒时,人们...

Tornado实现实时日志查看器

服务器日志监控是系统运维的关键环节。传统方式通过SSH登录查看日志文件效率低下,尤其在分布式系统中难以快速...

CPU使用率实时折线图绘制工具

现代计算机系统运行过程中,CPU资源分配直接影响着设备性能表现。专业运维人员和普通用户都需要直观的工具来捕...

电子邮件正文关键信息提取器

在信息爆炸的数字化办公场景中,电子邮件依然是商务沟通的核心载体。据统计,全球职场人平均每天需要处理超过...

二维码扫描解码工具

在移动互联网高速发展的今天,二维码已成为连接数字与现实世界的核心媒介。无论是支付、信息传递还是身份认证...

Excel数据相似度匹配工具

在数据量激增的办公场景中,Excel用户常面临一个痛点:如何快速识别并处理重复、近似或关联性较强的数据。传统的...

基于SSH协议的设备存活检测工具

在复杂网络环境中,设备存活状态的实时监控直接影响着运维效率。传统ICMP协议检测存在防火墙拦截率高、数据包过...

马蜂窝旅游点评内容爬虫工具

互联网时代,用户点评数据已成为旅游行业的重要参考指标。马蜂窝作为国内头部旅游内容社区,沉淀了海量真实的...

邮件自动发送与附件处理程序

在数字化办公场景中,邮件依然是信息传递的核心工具。传统手动处理邮件的方式常因重复操作、附件管理混乱等问...

PDF文档合同条款解析工具

纸质合同向电子化转型的浪潮中,PDF格式因兼容性强、不易篡改的特性成为主流载体。面对动辄数百页的复杂条款,...

简易数据库查询界面(SQLite数据浏览编辑)

在数据处理领域,轻量化工具往往能带来意想不到的便捷。基于SQLite的数据库管理工具因其轻便高效的特点,逐渐成...

微信聊天记录关键词上下文搜索工具

日常微信聊天记录堆积如山,想快速找到某条信息却像大海捞针。无论是工作文件、重要约定还是亲友的生日提醒,...

简易颜色代码转换器(RGB-HEX)

在数字设计领域,颜色代码的准确性直接决定作品的最终呈现效果。RGB(红绿蓝)和HEX(十六进制)作为两种主流颜...

视频片段自动剪辑与拼接工具

在短视频日均播放量突破千亿的时代,内容创作者常面临这样的困境:手机里堆满的素材需要耗费数小时筛选,复杂...