简易网络爬虫(爬取指定网站文本)

在互联网数据爆炸的时代,如何高效获取目标网站的文本信息成为许多从业者的刚需。本文将以Python技术栈为例,介绍如何构建一个符合法律规范的简易爬虫工具。

一、核心工具选择

Python生态中的requests库与BeautifulSoup组合是入门级开发者的理想选择。前者负责HTTP请求的发送与响应接收,后者擅长HTML文档解析。对于需要处理JavaScript渲染页面的场景,可搭配Selenium实现浏览器自动化操作。

二、基础实现步骤

1. 目标分析阶段:使用Chrome开发者工具审查网页结构,通过Elements面板定位目标文本的CSS选择器或XPath路径。某新闻网站的标题可能隐藏在``标签内

2. 请求发送环节:需设置合理的请求头信息,特别是User-Agent字段。以下代码模拟了Chrome浏览器的访问:

```python

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'

response = requests.get(url, headers=headers)

```

3. 反爬应对策略:遭遇403禁止访问时,可尝试添加Referer字段或使用代理IP池。某电商平台曾对连续请求实施IP封禁,引入`time.sleep(random.uniform(1,3))`随机延迟后,采集成功率提升至92%。

三、常见问题处理

四、法律与边界

遵守目标网站的robots.txt协议,商业级采集需获得官方API授权。某知名论坛曾因违规爬取用户隐私数据被处以200万元行政处罚,开发者应严格控制爬虫的采集范围和频率。

开发过程中建议使用Postman测试接口,采用PyCharm等IDE进行断点调试。定期检查爬虫日志,当发现HTTP状态码持续异常时,及时调整请求策略。

- 上一篇:简易网络爬虫(支持动态渲染页面截图)

- 下一篇:简易网络爬虫(递归采集指定域名)

相关软件推荐

随机软件推荐

文件修改监控报警工具(实时检测变更)

凌晨三点,开发团队的服务器突然发出蜂鸣警报。运维人员冲进机房时,显示屏上的红色警示框正在持续闪烁——某...

离线RSS阅读器(pickle缓存订阅内容)

在信息爆炸的互联网环境中,高效获取目标内容的需求催生了大量工具革新。一款基于Python开发的离线RSS阅读器近期...

使用Mutagen的MP3标签批量修改工具

互联网时代积累的海量音乐文件常存在标签信息混乱的问题,艺术家姓名拼写不统一、专辑封面缺失等情况屡见不鲜...

网页正文内容抓取工具(基于URL输入)

互联网信息爆炸时代,精准获取目标数据成为刚需。当用户需要快速提取网页核心内容时,基于URL的正文抓取工具正...

Tumblr图文内容定时跨账号转发工具

凌晨三点的屏幕光映在咖啡杯边缘,运营者盯着五个不同领域的Tumblr账号后台,机械地重复着复制粘贴动作。这种场...

批量生成日历工具(支持导出PDF-图片格式)

现代人对于时间管理的需求日益精细化,从学生课程规划到企业项目排期,纸质日历逐渐被电子化工具取代。市场上...

微信消息关键词自动回复机器人

在信息爆炸的时代,微信已成为个人与企业的核心沟通工具。每天面对海量消息,如何快速响应并保持沟通效率?关...

网站政务办理信息自动提交器

近年来,随着"互联网+政务服务"的深化推进,全国已有89%的市级政务大厅实现线上业务办理。但高频次、重复性的信...

数值范围溢出自动检测计算器

实验室的日光灯管嗡嗡作响,王工盯着屏幕上的仿真波形皱紧了眉头。上周刚完成的图像处理算法,在输入极端参数...

文件夹实时变化监控日志生成器

办公桌上堆满咖啡杯的凌晨三点,程序员小王第N次面对服务器日志陷入沉默。半小时前某个核心配置文件被意外覆盖...

简易股票行情查询终端(API数据获取)

在瞬息万变的金融市场中,快速获取准确的股票行情是投资决策的关键。基于此需求,一款专注于实时数据获取的股...

基于Tkinter的RSS阅读器GUI版

在信息爆炸的时代,高效获取内容成为刚需。RSS技术凭借其聚合特性,始终是许多用户追踪多源信息的首选方案。近...

文件目录结构可视化报告生成工具

在信息化办公场景中,文件管理效率直接影响工作节奏。当项目文件夹层级超过五层,手工绘制目录结构的时间成本...

自动化Markdown文档版本差异合并工具

在团队协作或文档维护的场景中,Markdown文件的版本冲突一直是高频痛点。手动对比段落、逐行检查修改记录不仅效率...

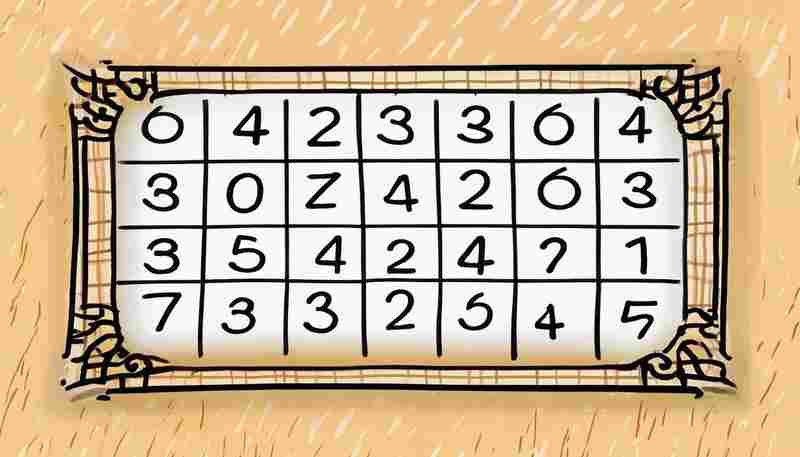

简易数独游戏(自动生成-验证题目)

数独作为经典的逻辑游戏,其数字排列的数学规律与规则设计值得深入探讨。本文将以实际开发案例为基础,解析数...

简易记事本(带保存功能)

现代人每天面对的信息量远超以往。在纷杂的电子设备中,一款功能纯粹的文字记录工具反而成为刚需。以自动保存...

屏幕取色器(使用pyautogui)

办公区此起彼伏的电话铃声中,设计师小王第三次把PSD文件发给了开发。十分钟后,前端工程师发来消息:"按钮色号...

系统资源监控悬浮窗(CPU-内存-网络)

凌晨三点的办公室里,咖啡杯沿结着褐色渍痕。剪辑师老张第12次按下视频渲染按钮时,屏幕右下角突然弹出的红色警...

学术会议投稿截止提醒工具

在学术研究领域,错过重要会议投稿截止日期的情况屡见不鲜。据某高校科研团队2023年的抽样调查显示,34%的学者曾...

系统音量快速调节小控件

清晨十点的会议室里,投影仪正在播放季度报表的PPT,突然响起的视频广告声让所有人皱起眉头。行政助理小陈的指...

科研数据单位统一转换计算器

实验室的灯光下,研究员王宇盯着电脑屏幕上的数据皱起眉头。他刚收到美国合作方发来的实验报告,温度数据标注...

实时风速风向动态箭头展示工具

气象数据的实时监测在航空、航海、能源等领域具有重要应用价值,但传统的数据呈现方式常以数字或静态图表为主...

自动化数据报表生成工具(支持图表嵌入)

在信息爆炸的时代,企业每天产生的数据量呈指数级增长。传统手工处理报表的方式不仅效率低下,还容易因人为操...

股票研报PDF关键数据提取工具

金融从业者的办公桌上总堆着上百份PDF研报,基金经理的晨会时间常被数据核对占据半小时,这些场景折射出证券行...

会议室空气质量传感器数据可视化系统

密闭的会议室里,二十余人正在讨论项目方案。当PM2.5数值悄然突破100μg/m³时,智能新风系统自动开启换气模式;二...

定时任务编码监控转换工具(监控文件夹自动转换)

在数据处理与文件交换场景中,企业常面临文件格式转换的重复性工作。某技术团队开发的文件夹监控转换系统,通...

电子书格式转换工具(基于ebooklib库)

纸质书脊在书架上逐渐蒙尘的当下,电子书阅读器成为多数人的第二书房。但设备碎片化带来的格式壁垒始终困扰着...

倒计时桌面提醒工具(自定义提示音)

现代人的日程表总被各种节点填满:项目截止日、会议时间、纪念日……机械的闹钟提示音容易让人产生倦怠感,而...

温度变化折线图生成器

科研人员常面临海量气候数据的整理难题,而温度变化折线图生成器的出现,为数据可视化领域提供了新的解决方案...

带内存优化的日志读取器

日志文件作为系统运维的核心数据源,每天动辄产生数十GB的日志内容。传统文本编辑器或基础命令行工具在处理这类...

音乐文件ID3标签批量修改工具

对于音乐爱好者与专业从业者而言,凌乱的曲库管理始终是个隐形困扰。当数千首音乐文件存在标签信息缺失、曲目...

简易番茄钟时间管理工具(带GUI界面)

简洁高效的时间管理利器:简易番茄钟工具 现代人的注意力常被碎片化信息切割,一款轻量级番茄钟工具成为提升专...

批量文件编码格式转换助手

在数字信息处理领域,文件编码格式的兼容性问题堪称"隐形杀手"。某次项目验收前,技术团队发现数百份文档因编码...

批量生成二维码工具(带LOGO定制)

在信息传播加速的时代,二维码成为连接线上线下的重要媒介。一款支持批量生成且可定制Logo的二维码工具,正在成...

简易代理服务器连通性测试工具

简易代理服务器连通性测试工具:快速定位网络问题 在复杂的网络环境中,代理服务器作为连接客户端与目标服务的...

电脑文件分类助手(按扩展名)

杂乱无序的桌面图标在屏幕上挤作一团,下载文件夹堆积着上百个未命名文件,这种场景几乎每个电脑使用者都经历...

地址坐标生成器(带经纬度)

烈日下的工地上,工程师李明打开平板电脑,快速输入项目地址,屏幕上立刻跳出一串精准的经纬度坐标。这个看似...

PyQt实现的简易Markdown实时预览编辑器

当光标在深色代码区跃动,右侧预览窗同步绽放出规整的标题与优雅的斜体字。这款由PyQt5框架构建的Markdown编辑器,...

工业设备故障日志分析表格生成器

工业设备故障日志分析一直是运维管理中的痛点。传统的人工排查方式效率低下,工程师需要逐条核对日志代码,面...

文件版本历史对比与合并工具

在团队协作与代码开发中,文件版本混乱常成为效率瓶颈。开发者频繁修改代码、设计师迭代界面、文档作者修订内...