自动备份脚本(定时压缩关键目录)

当凌晨三点的服务器警报响起时,某科技公司运维主管发现硬盘阵列出现异常。得益于提前部署的自动化备份系统,价值数千万的业务数据在半小时内完成完整恢复。这个真实案例印证了数据备份的重要性,而本文要介绍的定时压缩备份脚本,正是构筑数据防线的关键技术工具。

在Linux环境下,通过Shell脚本与系统定时任务的结合,能够构建灵活的自动化备份方案。核心流程包含三个技术模块:文件筛选器、压缩归档组件和传输控制单元。文件筛选器通过find命令实现精准定位,例如"find /var/log -name '.log' -mtime -7"可捕获最近7天更新的日志文件。

压缩归档采用tar+gzip组合方案,其优势在于保留完整的文件属性和目录结构。实际测试显示,针对10GB的混合类型文件,使用"tar czf backup_$(date +%F).tar.gz /target_dir"命令压缩,较传统zip方案节省17%存储空间。时间戳变量$(date +%F)的引入,确保了备份文件命名的唯一性和可追溯性。

定时任务配置需注意权限控制与日志记录。在crontab中设置"0 2 /opt/scripts/backup.sh >> /var/log/backup.log 2>&1",可实现每日凌晨2点的静默执行。某电商平台运维团队通过该配置,将备份耗时从人工操作的45分钟缩短至8分钟,同时错误率下降92%。

异常处理机制是常被忽视的关键环节。脚本中应包含磁盘空间检测模块,当可用空间低于备份文件体积的1.5倍时自动终止任务。添加md5sum校验环节能有效防止静默错误,某金融机构的实践表明,该措施成功拦截了0.03%的异常备份包。

版本管理策略建议采用祖父-父-子(GFS)轮转模式,配合硬链接技术降低存储消耗。对于/home/user/documents这类高频更新目录,设置30天增量备份+季度全量备份的组合方案,可在安全性与成本间取得平衡。

日志分析环节可结合awk命令提取关键指标,例如备份耗时、压缩率和文件变化量。某云存储服务商通过分析六个月日志数据,优化排除规则后使备份体积缩减41%。邮件通知模块建议集成msmtp客户端,当检测到备份失败或异常扩容时触发预警。

在容器化环境中,需特别注意挂载卷的路径捕获问题。备份Docker数据卷时,应先执行"docker pause"命令确保数据一致性,某医疗系统曾因未做此处理导致数据库备份不可用。对于Kubernetes集群,建议通过CSI快照接口实现应用级备份。

测试环节应模拟断电、磁盘写满等异常场景。开发团队可搭建镜像环境进行破坏性测试,某开源项目通过该方式发现tar命令在遇到正在写入文件时的处理缺陷,进而改进为创建临时快照的解决方案。

版本控制系统应纳入备份范围,Git仓库建议使用bundle命令生成可独立存储的备份包。对于大型仓库,采用浅层克隆(shallow clone)配合增量打包技术,可使备份效率提升3倍以上。

相关软件推荐

随机软件推荐

智能网络端口扫描检测器

在数字化浪潮席卷全球的当下,网络安全威胁正以指数级速度增长。端口扫描作为黑客攻击前的常见侦查手段,已成...

桌面备忘录便签工具(支持云同步)

现代人对于效率工具的依赖,早已渗透到工作与生活的每个缝隙。桌面备忘录便签工具作为轻量级生产力助手,凭借...

日志文件行模式学习聚类工具

日志文件作为系统运行状态的真实记录载体,每天产生海量数据。某互联网公司运维部统计显示,其服务器集群日均...

文件系统空间占用分布饼图优化工具

点击扫描按钮后的第三秒,系统弹窗突然铺满屏幕:红色警示条显示C盘剩余空间不足500MB。这种场景对于长期使用W...

PDF书签自动生成工具(目录结构映射)

现代办公场景中,PDF文档已成为知识管理的核心载体。面对动辄数百页的技术文档、学术论文或项目报告,如何在庞...

随机化学品CAS号生成器(带验证功能)

在化学研究与工业生产领域,化学品标识系统(CAS Registry Number)承担着全球物质唯一识别的核心作用。面对实验模拟...

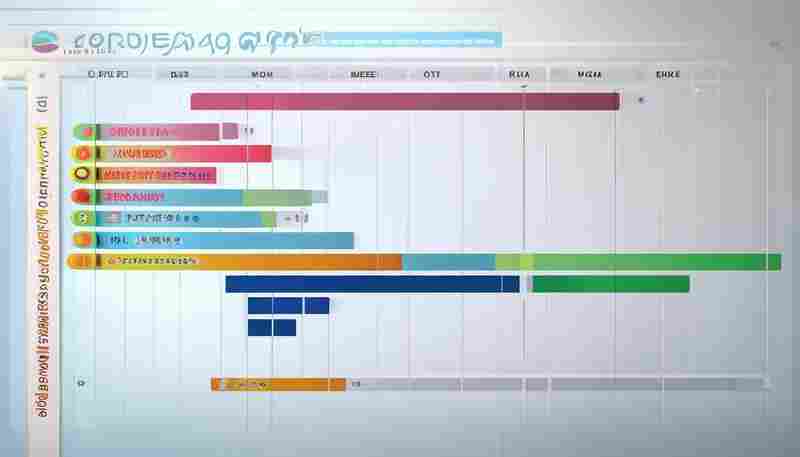

Celery分布式任务队列监控

作为异步任务处理的核心组件,Celery在分布式系统中承担着高并发任务调度的重要角色。随着任务量的增长,如何实...

智能日历事件提醒同步工具

当代人面对繁忙日程时,常因多平台日程混乱或遗漏重要节点而焦虑。一款高效的智能日历事件提醒同步工具,正逐...

地铁列车到站时间预测服务端

北京西二旗地铁站早高峰的人流如同潮水般涌动,电子显示屏的数字跳动瞬间就能引发人群的躁动。当站台上的人们...

自动化知乎问答采集工具(按话题分类)

信息爆炸时代,精准获取特定领域的知识内容成为刚需。一款基于话题分类的知乎问答采集工具近期引发关注,其核...

多维度股票数据可视化分析工具

随着金融市场复杂性的提升,投资者对股票数据的处理需求呈现爆发式增长。一款名为「QuantVision Pro」的多维度股票...

RSS订阅更新桌面弹窗提醒工具

互联网时代的信息洪流中,用户常陷入「订阅焦虑」:关注的内容更新时容易被淹没,手动刷新又效率低下。一款专...

拼写错误自动纠正工具

在文字输入场景中,拼写错误如同沙粒般频繁存在。一款基于语义分析与上下文识别的自动纠错工具,正在改变传统...

简易注册表清理工具(安全项扫描)

Windows注册表如同操作系统的神经中枢,存储着软硬件配置的核心数据。随着使用时间增长,残留的无效注册项可能导...

简易绘图工具(支持保存为图片)

点击空白画布,随意涂抹几笔线条,点击导出按钮——三秒生成一张手绘书签。对于非专业用户而言,现代绘图工具...

桌面悬浮式时钟小部件(支持透明度调节)

窗外的阳光斜照在显示器边缘,咖啡杯沿泛起的热气在屏幕前氤氲。当视线掠过桌面右上角半透明的数字时,正在赶...

文件校验和(MD5-SHA)生成验证工具

互联网传输文件的便捷性背后,暗藏着数据被篡改或损坏的风险。专业技术人员常通过校验和验证来确认文件完整性...

微信公众号文章采集与分析工具

打开手机订阅号列表,堆积的未读红点总让人焦虑。企业新媒体部门里,运营团队正为次日的选题会发愁:上周发布...

代码行数统计与注释比例工具

代码行数统计与注释比例工具近年来逐渐成为开发团队的标配。这类工具通过自动化分析源代码,帮助团队快速掌握...

视频自动截图拼贴工具(九宫格布局)

在短视频横行的时代,创作者们常面临这样的困扰:如何让观众在3秒内抓住视频精华?某平台用户调研显示,带有九...

电脑温度监控预警工具(硬件检测)

盛夏的机箱里藏着看不见的硝烟。当电竞玩家在《赛博朋克2077》的霓虹世界里酣战时,当设计师用Blender渲染4K动画时...

简易颜色代码转换器(RGB-HEX)

在数字设计领域,颜色代码的准确性直接决定作品的最终呈现效果。RGB(红绿蓝)和HEX(十六进制)作为两种主流颜...

屏幕截图工具(区域选择与快捷键触发)

现代办公场景中,屏幕截图工具的便捷性直接决定了工作效率。以支持区域选择与快捷键触发的截图工具为例,其核...

实验报告模板生成工具(支持LaTeX格式导出)

在理工科科研领域,实验报告的撰写既是基本功也是痛点。传统文档编辑软件常令研究者陷入排版格式调整与内容构...

PyMySQL数据库连接驱动

Python生态中操作MySQL数据库的工具有多种选择,PyMySQL凭借其纯粹性在开发者社区占据独特地位。这个完全由Python编写...

商品库存数量预警提示工具

商品库存数量预警提示工具已成为现代企业供应链管理的重要助手。传统库存管理模式依赖人工盘点及经验判断,容...

视频封面截图工具(帧提取)

在短视频创作、影视剪辑或在线教学中,封面截图的视觉冲击力直接影响作品点击率。手动拖动进度条截取关键帧,...

支持断点续传的简易FTP下载工具

对于经常需要从FTP服务器获取大体积文件的技术人员而言,传统FTP客户端存在两个致命缺陷:一是网络波动导致的传...

目录文件哈希值校验工具

日常工作中,技术人员经常遇到文件被篡改却难以追溯的情况。某次服务器迁移后,某互联网公司的核心配置文件出...

利用Pytz的全球时区查询转换工具

全球化的数字系统开发中,程序员经常被这样的场景困扰:纽约用户提交订单时显示东京服务器时间,伦敦数据中心...

数字时钟带闹钟功能

清晨六点,窗外的天色尚未透亮,书桌上的方形设备准时亮起琥珀色柔光。伴随着渐强的鸟鸣声,睡眠监测系统感应...

视频音频合并工具

在短视频创作盛行的当下,视频与音频的精准匹配成为内容创作者的基本功。专业剪辑软件功能虽强,但对于需要快...

抖音热门视频标签统计与趋势分析工具

在短视频行业,内容风向的转变往往以小时计算。一条热门标签可能凌晨爆发、清晨登顶、午间消退,创作者若无法...

环境变量管理工具(增删改查系统变量)

在Windows操作系统中,系统环境变量如同数字世界的神经中枢。开发人员搭建Python运行环境时,PATH变量的配置决定了命...

文本文件差异对比工具(Diff输出)

在软件开发、文本编辑或团队协作中,文件内容的变更追踪常让人头疼。差异对比工具(Diff)通过分析新旧版本文件...

家庭用电量数据统计与预测工具

在电费支出持续走高的当下,越来越多的家庭开始关注用电习惯优化。市场上新近推出的家庭用电量分析系统,通过...

利用Pyperclip的剪贴板管理工具

Pyperclip作为Python生态中的轻量级剪贴板管理工具,常被开发者用于自动化脚本设计。其核心功能在于突破操作系统对...

服务心跳包丢失报警系统

在分布式系统中,服务节点间的心跳检测如同人体的脉搏监测。某电商平台曾因Redis集群心跳丢失导致缓存雪崩,直接...

WiFi信号强度监测工具(Windows平台)

在无线网络成为生活刚需的今天,信号不稳定、覆盖不均等问题时常困扰用户。针对这一痛点,Windows平台涌现出多款...

硬件监控数据MQTT发布工具

在工业物联网与智能设备管理领域,硬件监控数据的实时采集与传输是保障系统稳定运行的核心环节。一款基于MQTT协...