跨平台文件编码自动检测与转换工具

在日常办公或开发场景中,文件乱码问题如同幽灵般频繁出现。不同操作系统、软件对文本编码的默认支持存在差异,导致同一份文档在Windows、macOS或Linux设备间传输时,常出现字符无法识别的情况。一款能够自动检测编码并快速转换的工具,成为许多用户的刚需。

核心功能:从检测到转换的无缝衔接

目前市面上的成熟工具通常内置多套编码识别方案。例如,某开源工具通过分析文件二进制特征,结合统计模型与机器学习算法,自动匹配UTF-8、GBK、ISO-8859等数十种常见编码类型。检测完成后,用户可直接选择目标编码格式,一键完成批量转换。

这类工具的优势在于兼容性。以某款工具为例,它支持Windows系统下ANSI编码与Unix/Linux环境常用编码的双向转换,同时对日文Shift-JIS、韩语EUC-KR等小语种编码提供专项优化。开发者甚至为其添加了"混合编码修复"功能——当单一文件内存在多种编码字符时,工具可自动分割处理并重新拼接,避免手动调整的繁琐。

实际应用场景:从普通用户到开发者的覆盖

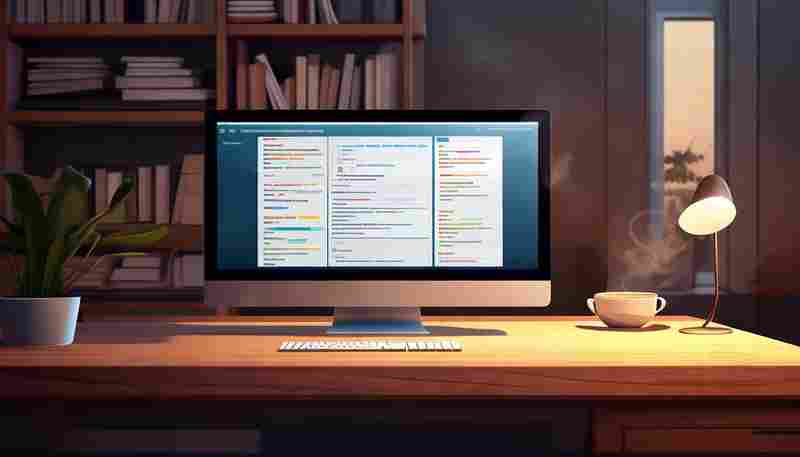

对于普通用户,这类工具的操作门槛极低。例如,某跨平台图形界面工具采用拖拽式交互设计,用户仅需将文件拖入窗口,3秒内即可看到系统推测的编码类型,点击确认后生成新文件。对于需要频繁处理数据的开发者,命令行版本则更受青睐。通过集成到Shell脚本或持续集成流水线中,工具能实时监控文件夹变动并自动执行转换,大幅提升工作效率。

某用户案例显示,某跨国团队曾因历史遗留的GB2312编码文档无法在英文版操作系统中正常显示,导致项目进度受阻。使用自动检测工具后,团队在10分钟内完成了2000余份文件的编码修正,避免了重新录入的人力浪费。

技术实现:平衡效率与准确性

编码检测的底层逻辑依赖概率计算。工具通常会对文件进行多轮扫描:首轮快速匹配BOM(字节顺序标记),若无明显标识则进入二轮基于字符频率的统计分析。以GBK为例,工具会计算双字节汉字出现的概率分布,再与预设模型对比。部分工具还引入动态阈值机制,当检测结果置信度低于90%时,自动向用户推送交互提示,降低误判风险。

转换环节的技术难点在于字符集覆盖完整性。Unicode标准持续迭代,工具需定期更新码表库。某知名工具在2023年的版本升级中,新增了对UTF-8变长编码中4字节字符的支持,解决了部分Emoji符号转换丢失的问题。

用户体验的持续优化方向

当前主流工具仍存在可改进空间。例如,在检测繁体中文Big5编码时,若文件混用台湾与香港地区字集,部分工具可能出现优先级误判。对于超大型文件(超过1GB),内存占用量控制成为新的挑战。某开发团队近期尝试引入流式处理技术,将文件分割为多个区块并行检测,使处理耗时降低约40%。

跨平台兼容性仍是基础需求。部分工具通过Electron框架实现界面统一,但因此带来的性能损耗引发争议。另一派开发者则坚持原生开发路线,为Windows、macOS、Linux分别编译独立版本,确保每秒处理速度稳定在50MB以上。

文件编码问题的彻底解决或许尚需时日,但现有工具已显著降低了跨平台协作的沟通成本。随着人工智能技术在模式识别领域的深入应用,未来编码检测的精准度有望突破99%阈值,而转换过程的资源消耗或将缩减至当前水平的十分之一。

- 上一篇:跨平台文件夹同步工具

- 下一篇:跨平台浏览器书签同步与备份工具

相关软件推荐

Git备份文件按日期分类存储工具

发布日期: 2025-05-18 19:12:01

场景痛点 程序员小张凌晨两点完成代码调试,随手执行`git commit -m "update"`后倒头就睡。...

使用Argparse的命令行文件批量重命名工具

发布日期: 2025-06-25 16:06:03

命令行文件批量重命名工具:用Python和Argparse解放双手 在日常工作中,文件批量重命名...

随机软件推荐

多平台账号粉丝数对比统计器

在数字化内容创作领域,账号运营者常面临一个现实问题:如何在微博、抖音、小红书等不同平台同步追踪粉丝增长...

基于机器学习的ARP行为异常分析器

网络协议的隐蔽角落往往暗藏安全风险,ARP协议作为局域网通信的基础协议,长期处于"信任但不可验证"的尴尬境地。...

文件哈希值二维码生成与校验器

在数字化场景中,文件传输的完整性与真实性常面临风险。传统校验方式依赖人工对比哈希值,效率低且易出错。为...

农历公历双向转换查询工具(带节气提示)

农历与公历作为两种历法体系,长期并行于社会生活的不同领域。传统节日、生辰八字常以农历为基准,而现代工作...

服装店尺码库存预警系统

服装行业库存管理如同走钢丝——积压导致资金压力,缺货造成客户流失。尺码库存预警系统的出现,让服装经营者...

网站访问地域响应时间分布图

全球网络环境存在天然的地域差异,即便同一国家的不同区域,网站访问速度也可能产生200ms以上的响应时间差。某款...

图片格式兼容性检测工具(含元数据校验)

图片格式兼容性检测工具正成为数字内容领域的热门需求。随着不同设备和平台对图像格式的支持差异日益明显,设...

音频文件格式转换与剪辑脚本(MP3-WAV)

格式转换与剪辑是音频处理中最常见的需求。无论是音乐爱好者整理素材库,还是视频创作者处理背景音效,总会遇...

配置文件控制的自动化测试报告生成工具

在持续集成与敏捷开发模式普及的当下,测试报告作为质量验证的重要载体,却常常陷入数据堆砌的困境。某开源社...

文本输入自动纠错统计器

在数字化办公与日常沟通场景中,文字输入的准确性直接影响信息传递效率。一款名为「语镜」的文本输入自动纠错...

哈希值快速搜索工具(本地文件库检索)

在数据爆炸的时代,如何在海量文件中快速定位目标内容成为技术人员的刚需。一款基于哈希值的本地文件检索工具...

本地邮件内容语音播报器

窗台上的绿萝在晨光中舒展叶片时,办公族们早已深陷未读邮件的泥潭。某科技公司研发的本地邮件语音播报器,正...

个人健康数据监测分析器(SQLite存储)

清晨六点,智能手环的震动唤醒用户,此刻的睡眠质量评分已自动生成。当运动爱好者完成五公里晨跑,血氧、心率...

按烹饪时间排序的快餐效率工具

现代人生活节奏快,外卖虽便捷却难以保障营养均衡。一款以烹饪时长为筛选维度的智能工具,正通过精准的时间管...

Tkinter屏幕取色工具

在数字设计领域,屏幕取色工具如同画家的调色板般重要。基于Python开发的Tkinter取色器凭借其轻量化特点,正在成为...

错误堆栈跟踪信息提取工具

调试系统崩溃时,屏幕上滚动着数百行堆栈信息。开发者的目光在密密麻麻的文本中反复搜索,试图抓住那个导致程...

系统资源监控小部件(CPU-内存使用率实时显示)

当视频剪辑进度条突然停滞,当游戏画面出现撕裂帧,人们才会想起那个藏在任务栏角落的透明窗口。系统资源监控...

简易计时秒表程序(圈速记录功能)

在快节奏的现代生活中,精准的时间管理工具正成为效率提升的关键。一款专为运动训练、技能练习甚至日常任务设...

文件属性修改工具(只读-隐藏-系统属性)

办公桌面的文档无法编辑,U盘里的资料突然消失,系统目录下总有几个灰色图标——文件属性管理是数字生活中绕不...

学术论文参考文献格式正则修正工具

学术论文写作中,参考文献格式始终是困扰研究者的难题。国际通行的APA、MLA、Chicago等十余种标准各成体系,不同期...

文件名特殊字符批量替换工具

日常办公场景中,许多用户都遭遇过文件命名带来的困扰:从网站下载的课件包含非法符号导致无法压缩,程序脚本...

系统声音控制增强工具(音量预设)

深夜赶工的视频剪辑师反复拖动进度条,游戏主播在团战关键时刻突然爆发的背景音,会议主持人手忙脚乱调整设备...

自动定时截图保存工具

日常工作中,许多人需要频繁截取屏幕内容作为工作记录或素材存档。手动操作不仅费时,还容易遗漏关键节点。针...

CSV数据加密与哈希处理工具

在数据驱动决策的时代,CSV文件因其简洁的表格结构成为企业与开发者常用的数据载体。明文存储的CSV数据易受泄露...

递归式文件夹权限批量修改工具

在企业级文件服务器管理中,运维人员时常面临多层嵌套目录的权限配置难题。某跨国科技公司曾因总部与分支机构...

天气数据JSON格式验证工具

天气数据校验工具正成为气象服务领域的基础设施。当某省级气象局在接入国际气象数据时,发现原始JSON结构中"pr...

二维码批量生成与Word文档自动插入工具

在数字化办公场景中,企业资料管理、活动物料制作常面临批量处理二维码的痛点。某技术团队近期推出的"QR DocMas...

简易CSV数据合并与拆分工具

日常工作中,许多岗位都需要频繁处理CSV格式的数据文件。无论是市场部门整合多源销售报表,还是开发工程师拆分...

番茄钟时间管理工具(倒计时与休息提醒)

在纽约曼哈顿的联合办公空间,东京银座的创业孵化器,北京中关村的科技园区,都能见到这样的场景:年轻人在笔...

多显示器配置资源分栏监控面板

办公桌上三块显示屏同时亮起,左边实时跳动服务器运行数据,中间铺满代码编辑器,右边挂着团队协作文档——这...

简易学生成绩统计分析系统

在教育场景中,成绩分析是教师了解教学效果、优化课程设计的重要环节。传统手工统计方式效率低、易出错,而复...

网页内容自动抓取工具(基于规则配置)

网页内容自动抓取工具近年来逐渐成为企业数据采集的重要助手。这类工具通过预设规则对目标网页进行结构化解析...

流程图文件整理助手(.vsdx .drawio)

在数字化办公场景中,流程图已成为项目管理、系统设计领域的核心工具。随着微软Visio(.vsdx)和Draw.io(.drawio)的...

番茄工作法计时器休息时段语录展示工具

办公室的键盘声此起彼伏,咖啡杯沿的水渍在阳光下泛着微光。当25分钟的专注时间结束,手机屏保突然浮现一行小字...

简易网络爬虫数据采集工具(支持CSV输出)

数据采集效率直接影响着信息处理的质量。针对中小规模的数据需求,一款支持CSV格式输出的网络爬虫工具正逐渐成...

基于CSV模块的电子表格数据统计工具

在数据处理领域,Python标准库中的csv模块长期被低估。这款仅需15行代码即可实现基础统计功能的工具,正在某些特定...

简易虚拟机管理工具(VBox命令行控制)

Oracle VirtualBox作为开源虚拟化方案,其图形界面虽直观但存在效率瓶颈。在服务器维护、批量操作等场景下,熟练使用...

自动化定时文件夹备份工具(支持ZIP压缩)

数字化时代,硬盘数据意外丢失如同悬在头顶的达摩克利斯之剑。市面上某款自主研发的文件夹自动备份工具,凭借...

虚拟货币汇率波动邮件提醒器

对于数字货币投资者而言,实时掌握汇率变化如同战场上的情报战。市场波动常在几秒内决定盈亏,人工盯盘不仅消...

批量视频元数据查看工具

在数字媒体爆炸式增长的今天,视频创作者、摄影师或影视团队常面临一个共同问题:如何快速整理与分析海量视频...