网络爬虫定时抓取与结构化数据存储工具

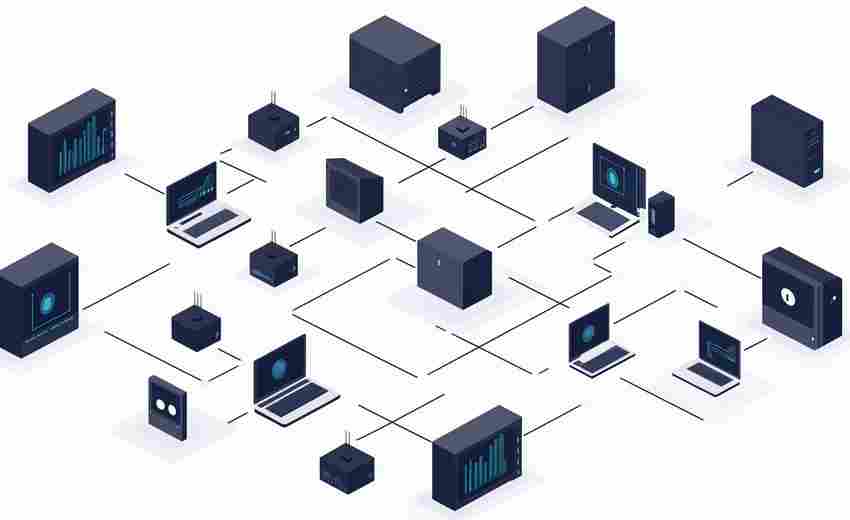

在数据驱动决策的时代,获取并管理互联网信息成为刚需。网络爬虫与结构化存储工具的组合,为高效处理海量数据提供了技术基础。本文将从定时抓取技术、数据清洗方案及存储工具适配性三个角度展开分析。

1. 定时抓取:平衡效率与合规性

主流爬虫框架如Scrapy、Apify支持通过Crontab语法或内置调度器实现分钟级任务触发。某电商价格监控案例显示,设置15分钟抓取间隔既能捕捉促销波动,又避免触发反爬机制。需注意目标网站的robots.txt协议,部分平台要求请求头添加明确身份标识,过度频繁访问可能导致IP封禁。

2. 数据清洗的三层过滤机制

原始网页数据常包含HTML标签、乱码等噪声。采用BeautifulSoup+XPath组合提取,配合正则表达式清洗,可使数据规整度提升60%以上。某新闻聚合项目实践表明,建立字段校验规则库(如日期格式检测、文本长度阈值)能有效拦截30%的异常数据。第三层清洗建议引入OpenRefine进行可视化校对,特别适用于地址、人名等半结构化信息。

3. 存储引擎的选型逻辑

MySQL仍是结构化存储的首选,其事务特性适合金融等高一致性场景。但当字段结构频繁变更时,MongoDB的Schema-free设计能降低70%的维护成本。时序数据库InfluxDB在物联网传感器数据存储测试中,写入速度比传统方案快3倍。混合架构渐成趋势:先用Redis缓存原始数据,经清洗后批量写入HDFS归档。

反爬策略升级倒逼技术迭代,部分企业开始部署动态IP代理池与请求指纹模拟系统。欧盟《数据治理法案》实施后,合规元数据记录功能成为存储工具的必备模块。

- 上一篇:网络爬虫天气数据获取器

- 下一篇:网络爬虫工具(自动提取网页结构化数据)

相关软件推荐

随机软件推荐

系统声音设备切换快捷键

多设备办公场景下,耳机、蓝牙音箱、显示器自带音响的频繁切换常困扰用户。Windows系统虽内置声音输出切换面板,...

网页快捷书签本地管理工具

当浏览器收藏夹累积到四位数时,上班族小李发现每次找资料都要滚动半分钟。某天他尝试导出书签文件,意外发现...

批量提取Excel表格数据到CSV工具

在数据密集型的工作场景中,Excel表格几乎是每个职场人无法绕过的工具。无论是财务部门的季度报表,还是市场部门...

扫描件自动旋转摆正工具

许多人在处理扫描文件时都遇到过这样的烦恼:手动调整歪斜的图片既费时又难以对齐,尤其是批量处理会议纪要或...

自动关机-重启计划工具(倒计时-定时执行)

日常办公或家庭环境中,电脑长时间运行容易产生资源浪费。部分用户遇到过下载大文件时需通宵开机、系统更新后...

屏幕取词翻译工具(划词翻译-多语种支持)

在信息全球化的今天,跨语言阅读已成为现代人的日常需求。当用户在浏览俄语技术文档时突然遇到专业术语,或是...

简易录屏工具(基于PIL截图拼接实现)

在数字内容创作需求井喷的今天,屏幕录制逐渐成为工作场景中的基础需求。市场上专业软件普遍存在安装包臃肿、...

PDF文本内容提取工具(带密码破解功能)

日常办公场景中,PDF文档以其稳定的跨平台特性成为主流文件格式。据统计,全球每天有超过20亿份PDF文档被创建,其...

客户满意度自动调查分发系统

在客户体验主导市场的时代,超过76%的企业将满意度调查视为核心运营指标,但传统人工分发模式常因效率低下、覆...

多屏显示临时文件清理器

现代办公环境中,由三块以上屏幕组成的多屏工作台已从科技公司的专属配置,逐渐渗透至设计师工作室、金融交易...

鼠标连点器自动化脚本工具

办公室的日光灯下,小王盯着屏幕上密密麻麻的表格数据,右手食指因频繁点击已隐隐发麻。这样的场景正在被一款...

交互式线性代数公式验证器

线性代数公式的推导过程常令学生与研究者感到头疼。传统纸质验算不仅效率低下,更难以实时验证逻辑链的严密性...

请求头重放攻击模拟检测工具

在网络安全攻防领域,请求头重放攻击(Header Replay Attack)是一种利用合法请求头信息绕过身份验证的常见手段。攻击...

系统剪贴板内容自动脱敏监听工具

在数字化办公场景中,剪贴板作为高频使用的数据中转站,往往承载着大量敏感信息——例如客户联系方式、内部系...

JSON时间戳模拟数据创建工具

在物联网设备调试现场,工程师小王第三次核对传感器接口文档时发现,测试环境的时间戳数据与实际设备运行存在...

网页内容抓取脚本(静态页面)

互联网数据洪流中,静态页面抓取技术如同精准的鱼叉。基于Python的Requests库与BeautifulSoup组合,已经成为数据工程师...

基于PyQt5的JSON数据格式化工具

在日常开发中,JSON数据格式的解析与校验常让开发者头疼。杂乱无章的原始数据、嵌套复杂的结构层次,往往需要借...

网站Cookies解析与编辑工具

互联网浏览痕迹正以Cookie形式被实时记录。当用户访问电商平台首页后,社交媒体的广告栏立即推送同类商品,这种...

Excel数据清洗工具(CSV-XLSX处理)

在金融公司担任数据分析师的李明,每个月都要处理来自全国300家分店的销售数据。手工核对商品编码、统一日期格...

网站死链检测爬虫(递归页面遍历)

打开某个精心设计的网页时突然跳出的"404 Not Found",这种体验就像新买的衬衫发现掉了一粒纽扣。对于日均访问量过...

源代码许可证声明批量更新器

在代码仓库管理领域,许可证声明更新是团队常面临的"技术债"痛点。某开源组织曾因未及时更新300余个项目的GPL声明...

系统注册表查看器(仅读取功能)

在Windows操作系统中,注册表扮演着核心数据库的角色,存储着硬件、软件、用户配置等关键信息。直接通过系统自带...

桌面天气预报小部件(实时温度-湿度显示)

清晨推开办公室窗户时,桌面上的圆形电子屏正跳动着24℃和65%的数字,湿度计图标微微泛着蓝光。这种无需掏出手机...

盲文学习进度跟踪软件

在视障教育领域,一款名为"BrailleTracker"的软件逐渐进入大众视野。这款工具通过数据化手段帮助盲文学习者建立系统...

股票RSI相对强弱指标生成器

证券营业厅的电子屏前,老张紧盯跳动的数字,手指在计算器上快速敲击。这位二十年股龄的老股民,正用最原始的...

网络丢包率统计与报告生成工具

网络卡顿、视频会议掉线、文件传输中断……这些问题背后往往存在同一个隐形杀手——网络丢包。某省级银行的科...

自动生成文件校验和报告工具

在数字化办公场景中,文件传输与存储的安全性始终困扰着使用者。某款近期投入市场的文件校验和生成工具,正通...

系统驱动备份恢复工具

凌晨三点半的电脑蓝屏总让人措手不及。面对闪烁的故障代码,多数人会突然意识到:那些系统盘里的驱动程序、注...

基于FTP协议的文件自动上传工具

在数字化办公场景中,企业文件传输需求呈现爆发式增长。某电商企业的运维部门发现,其每日需要上传的服务器日...

简易待办事项管理软件(带桌面提醒功能)

窗台上咖啡杯的热气还没散尽,电脑右下角的弹窗突然跳出来:"下午两点部门会议,材料已上传系统"。这样的场景,...

本地AES加密的DNS记录查询工具

在互联网隐私问题日益严峻的今天,一款名为SecDNS Explorer的工具悄然进入技术人员的视野。这款基于本地AES-256加密算...

系统进程监控仪表盘(显示CPU-内存占用)

服务器机房内,一名运维人员正紧盯屏幕上一块不断跳动的可视化面板。CPU占用曲线突然飙升到90%,内存使用率突破...

自动化测试日志比对工具

在软件测试环节,日志文件如同系统的"黑匣子",记录着程序运行的关键信息。面对动辄数万行的日志内容,人工逐行...

中文诗词随机生成器(基于语料库)

在数字技术蓬勃发展的今天,算法与人文的跨界融合催生出许多创新工具。中文诗词随机生成器,正是通过语料库技...

自动发送邮件工具(附件-多收件人支持)

在信息化办公环境中,邮件处理效率直接影响着团队协作质量。某款支持附件传输与多收件人群发的邮件自动化工具...

文件操作自动化工具(录制-回放操作序列)

在数字办公场景中,文件批量重命名、格式转换、目录整理等重复性操作占据着大量工作时间。某款基于操作序列录...

简易个人记账与消费分析工具

每月底翻看账单时,总有人对着数字发懵:钱都去哪儿了?当代年轻人逐渐意识到,想真正掌控生活,必须先从管理...

文件夹容量统计与可视化工具(树状图展示)

日常办公中,硬盘空间总在不知不觉间被各类文件占据。面对层层嵌套的文件夹和散落的零碎文档,手动统计容量如...

基于Tkinter的搞笑语录弹窗提醒软件

在办公室对着电脑屏幕发呆时,突然弹出一个窗口写着“努力不一定被看见,但摸鱼一定很显眼”,或是深夜加班时...

二维码生成与ASCII艺术字符转换工具

信息时代,工具类应用逐渐从单一功能转向趣味化与实用性的结合。在众多工具中,二维码生成器与ASCII艺术字符转换...