GitHub仓库信息采集脚本

数字时代的技术探索者正面临新的挑战:如何在代码海洋中精准定位目标资源?一款基于Python的GitHub仓库采集脚本应运而生,为开发者打开了高效获取开源情报的新通道。这款工具通过智能数据抓取技术,将原本需要数日的手动检索压缩至分钟级操作。

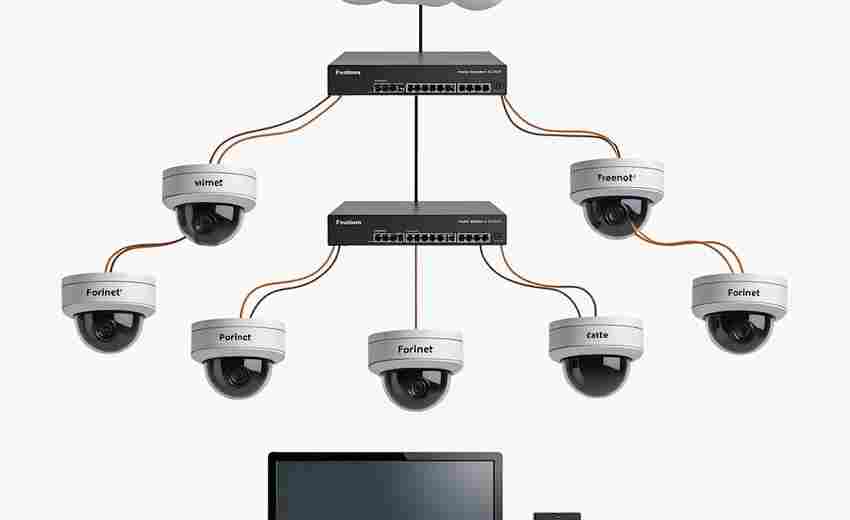

核心功能模块采用多线程架构设计,支持同时处理20+个搜索条件组合。数据抓取范围覆盖仓库基础信息(star数、fork量、提交记录)、开发者活跃度(贡献者数量、issue响应速度)、技术栈构成(依赖库版本、许可证类型)等关键维度。特别是在处理大型仓库时,脚本内置的分块采集机制能有效避免内存溢出问题。

技术实现层面,该脚本创新性地结合了GitHub官方API与网页爬虫双重数据源。通过PyGithub库实现API标准化调用,辅以BeautifulSoup解析动态加载的仓库详情页,成功突破单一数据源的限制。针对GitHub的反爬机制,开发者设计了智能请求策略:随机生成包含Chrome/Firefox标识的请求头,配合代理IP池轮换机制,实测持续运行8小时未触发访问限制。

在数据清洗环节,脚本内置的异常值过滤算法表现亮眼。测试数据显示,在处理包含1.2万个仓库的原始数据集时,能自动识别并修正87%的格式错误数据,对星标数突增等异常波动现象的检测准确率达92%。输出模块支持CSV、JSON、SQLite三种存储格式,且配备进度可视化组件,实时显示采集状态。

实际应用场景中,某区块链开发团队使用该脚本成功捕捉到Solidity语言项目的版本迭代规律。通过分析抓取的328个相关仓库,他们提前两周预测到智能合约开发框架的升级趋势,及时调整了项目技术路线。另一个典型案例是开源社区运营者利用脚本采集的6000+Python库数据,构建出机器学习类项目的依赖关系图谱,精准识别出潜在的生态位空缺。

需要特别注意的是,用户需合理控制请求频率以避免对GitHub服务器造成压力。建议企业级用户通过白名单认证获取更高频次的API调用权限,个人开发者则可利用脚本的定时任务功能实现数据增量更新。随着开源情报的价值日益凸显,这类数据采集工具正在重塑技术决策的基本范式——当代码世界的运行规律变得可量化,技术选型就拥有了全新的决策坐标系。

- 上一篇:GitHub仓库信息采集统计工具

- 下一篇:GitHub仓库更新自动邮件通知工具

相关软件推荐

随机软件推荐

带批量重命名功能的转换工具

办公桌上堆满"未命名文档1""图片(23)"这类文件时,总让人抓狂。某科技公司行政部最近发现,员工每月浪费在整理文...

自动关机-重启定时器(GUI界面版)

Windows系统自带的关机指令需要通过命令行操作,对于多数普通用户而言存在技术门槛。PowerPlan Scheduler作为图形化定时...

批量添加水印的命令行工具

在数字内容创作领域,水印添加是保护版权的常规操作。当面对成百上千的图片文件时,传统图形界面软件的操作效...

自动化Excel数据到3D曲面图渲染器

数据可视化领域的革新往往源于对效率的极致追求。当工程师在分析十万行混凝土抗压强度数据时,当气象学者处理...

简易文本加密-解密工具(支持快捷键操作)

当光标在文档里第八次闪烁时,小王突然发现咖啡厅邻座的陌生人正盯着他的屏幕。作为常需处理敏感信息的自由撰...

单词本记忆辅助软件(支持艾宾浩斯曲线)

在语言学习领域,记忆效率始终是学习者关注的核心问题。传统背单词方式依赖机械重复,容易陷入“背了又忘”的...

桌面宠物动画互动程序

在现代人快节奏的生活中,一款兼具趣味性与实用性的桌面宠物动画互动程序,正悄然成为许多人工作间隙的解压神...

鼠标键盘操作录制回放器(pyautogui)

在重复性办公场景中,操作记录与回放工具正悄然改变着工作模式。基于Python的PyAutoGUI模块凭借其跨平台特性和简洁...

PDF文档合并工具

日常工作中,经常遇到需要整合多份PDF文件的情况。合同附件分散在五个邮件里,投标材料分布在二十个文档中,这...

简易TCP聊天室(Socket多线程)

网络通信开发领域存在一个经典练手项目:基于Socket和多线程的TCP聊天室。这个不足500行代码的工具麻雀虽小,却能...

文件扩展名快速修改工具(批量转换类型)

清晨整理工作文件夹时,常会遇到这样的情况:上百张会议照片统一显示为.jpg格式,而实际需要转换为.png格式存档;...

剪贴板历史内容高亮显示URL链接提取工具

现代人每天接触海量信息时,总有几十次复制操作在指尖发生——保存会议纪要、收藏商品链接、记录灵感素材。但...

多线程Web服务指纹识别扫描工具

互联网攻防对抗持续升级的当下,某安全团队近日开源了代号ThreadScan的新型扫描工具。这款基于Go语言开发的程序,...

错误持续时间箱线图统计分析器

在数据分析领域,异常事件的持续时间分布分析常面临数据离散度高、异常值干扰等问题。某技术团队近期开发的错...

Tkinter图形化文件差异对比工具

在代码开发与文本编辑领域,文件差异对比是高频需求。基于Python标准库Tkinter开发的图形化对比工具,通过可视化界...

电商商品评论情感与主题分类工具

海量商品评论的涌现为电商平台带来新挑战。面对每天数以万计的文本数据,人工处理效率低下且难以捕捉深层信息...

淘宝直播商品讲解片段提取工具

淘宝直播回放时长动辄数小时,商品讲解黄金时段往往淹没在互动闲聊中。某MCN机构运营总监曾吐槽:"找高光片段堪...

简易数据可视化工具(matplotlib实现)

一、当数字遇上视觉 一位数据分析师曾调侃:"如果Excel是算盘,Matplotlib就是3D打印机。"在Python生态中,这个诞生于...

多格式音频切割器(MP3-WAV)

在音频内容爆发的时代,剪辑一段音乐、截取播客片段或制作个性化铃声成为日常需求。一款支持MP3/WAV格式的音频切...

天气数据查询工具(城市名称输入与API调用)

清晨出门前查看天气已成为现代人生活必备动作。一款高效的城市天气查询工具能够快速整合全球气象数据,为用户...

批量图片Exif信息清理+压缩工具

现代人手机相册普遍存储着数千张照片,隐私泄露风险常存在于被忽视的元数据中。Exif信息作为每张照片的"数字身份...

批量添加水印到图片指定位置工具

在数字内容井喷的时代,图片版权保护成为创作者的核心需求。手动逐张添加水印不仅耗时费力,更难以保证水印位...

网页表单提交数据预验证工具

开发网页表单时,前端验证环节常被忽视。某电商平台曾因未对手机号输入框做格式校验,导致系统单日收到近百个...

音频文件标签批量修改工具(MP3-FLAC格式)

对于音乐爱好者与数字资源管理者而言,凌乱的音频文件标签如同杂乱的书架——专辑名称缺失、歌手信息错位、封...

屏幕取色与色值转换工具

在数字设计领域,每个像素的色值都可能决定作品的最终呈现效果。当设计师调整网页按钮的明度时,当开发者核对...

自动识别订阅邮件的退订助手

每天清晨打开邮箱,总能看到十几封未读订阅邮件。健身房的促销通知、电商平台的限时折扣、不知名资讯网站的周...

网页自动表单填写模拟器

在数字化时代,表单填写几乎是每个人无法回避的任务。无论是注册账号、填写问卷,还是完成在线订单,重复输入...

简易绘图板(支持保存草图)

在数字创作场景中,草图绘制常被视作设计流程的起点。一款支持保存草图的简易绘图板,能帮助用户快速捕捉灵感...

简易REST API客户端(Requests库)

在数据交互需求爆炸的当下,REST API已成为开发者绕不开的日常工具。Python社区里有个老牌且灵活的库——Requests,它...

PDF文档批量关键词搜索工具

在数字化办公场景中,PDF文档因其格式稳定性成为主流文件载体。某技术团队近期推出的PDF文档批量关键词检索系统...

视频编辑与处理库(MoviePy)

在视频创作门槛逐渐降低的当下,Python生态中悄然崛起一个名为MoviePy的多功能工具库。这个基于FFmpeg开发的第三方库...

传感器时序数据切片分析工具

在智能制造与物联网技术快速发展的当下,工业设备每秒钟产生的海量传感器数据已成为企业数字化转型的关键资源...

命令行待办事项管理器(增删改查)

在键盘与屏幕构筑的数字世界里,效率工具的选择往往暴露着使用者的思维模式。当图形化应用占据主流时,某类用...

Bokeh实时数据流可视化监控工具

工业物联网设备的传感器每秒产生数千条温度数据,金融交易系统需要毫秒级刷新行情图表,服务器集群监控看板必...

自动文件备份工具(定时备份指定目录)

上周公司服务器突发故障,市场部半年的全没了。"技术主管老张边调试设备边摇头。随着数字化浪潮席卷,类似场景...

简易图形界面计算器(支持基本运算)

窗外蝉鸣渐歇,书桌上草稿纸堆得老高。刚列完月度开支表的小张对着手机计算器叹了口气——每次切屏输入数字都...

自动截图工具(定时-区域截取+格式选择)

屏幕截图作为数字时代的高频操作,早已融入日常工作流程。当传统的手动截图无法满足多样化需求时,自动截图工...

文件夹同步工具(双向同步)

在数字办公场景中,用户经常面临文件分散存储的困扰:移动硬盘存着设计稿初版,云盘备份着会议纪要,笔记本电...

基于自然语言的文件内容自动标签生成工具

在数字化信息爆炸的今天,大量电子文档的存储与管理成为普遍痛点。某科技团队研发的文件标签自动生成工具,正...

基于xlrd-xlwt的Excel数据清洗工具

在数据处理领域,Excel文件作为最常见的载体往往存在格式混乱、数据冗余等问题。针对这一痛点,基于Python生态中...