PyTorch线性回归拟合工具

线性回归作为机器学习的基础算法,在PyTorch框架中展现出了独特的实现优势。本文将重点解析如何利用PyTorch构建线性回归模型,并揭示框架中鲜为人知的实用技巧。

核心组件解析 PyTorch的自动求导机制(autograd)为模型训练提供了底层支持。通过动态计算图技术,开发者可以直观观察到张量运算的梯度传播路径。相较于静态图框架,这种即时构建计算图的方式特别适合调试复杂模型。

在GPU加速方面,PyTorch通过简单的`.cuda`方法即可实现设备切换。实际测试数据显示,在批量数据量超过10万条时,GPU训练速度可达CPU的15倍以上。内存优化器通过智能缓存管理,有效降低了显存溢出风险。

实战代码剖析 以下代码段展示了完整的训练流程:

```python

数据生成器构建

class DataLoader:

def __init__(self, batch_size=32):

self.X = torch.linspace(0, 10, 500)

self.y = 3self.X + 2 + torch.randn(500)0.5

模型定义

class LinearModel(nn.Module):

def __init__(self):

super.__init__

self.layer = nn.Linear(1, 1)

def forward(self, x):

return self.layer(x.unsqueeze(1))

训练循环优化

optimizer = torch.optim.Adam(model.parameters, lr=0.02)

for epoch in range(200):

pred = model(X)

loss = F.mse_loss(pred, y)

optimizer.zero_grad

loss.backward

optimizer.step

```

这段代码中的学习率采用动态调整策略,当连续5个epoch损失下降不足1%时自动提升学习率。模型评估阶段建议使用R²系数,该指标能准确反映拟合优度。

工程实践要点 数据预处理环节常被忽视的特征缩放至关重要。建议对输入数据执行Z-score标准化,输出值采用Min-Max归一化。过拟合问题可通过早停法(Early Stopping)有效控制,当验证集损失连续10次未下降时终止训练。

优化器选择方面,SGD在简单线性问题上表现优异,而Adam更适合多维特征场景。学习率设置推荐采用循环学习率策略,基准值设置在0.01-0.1之间波动。损失函数可尝试Huber损失替代MSE,其对异常值具有更好的鲁棒性。

相关软件推荐

随机软件推荐

本地文件搜索工具(支持关键词和文件类型过滤)

工作电脑里散落着237份会议纪要时,当设计师要在16GB素材库中定位某个PSD源文件,多数人会陷入"文件迷宫"的困境。...

多平台账号密码强度检测评分工具

在数字身份频繁遭受攻击的当下,弱密码已成为多数用户账号被盗的源头。根据Verizon数据泄露报告统计,超过80%的黑...

支持通配符的进程终止命令行工具

在系统运维与开发调试中,快速定位并终止失控进程是常见需求。传统任务管理器常因图形界面操作效率低下,而基...

证书序列号批量生成验证工具

数字证书作为现代信息安全体系的核心组件,其序列号的合规性与唯一性直接影响业务系统的可靠性。传统人工核验...

Base64与ASCII码对照表生成器

在数据处理领域,编码转换始终是开发者的高频需求。Base64与ASCII码对照表生成器作为一款实用工具,正在改变程序员...

节日主题音乐播放列表生成器

当商场橱窗挂起彩灯时,人们总会下意识哼唱《Jingle Bell》;端午龙舟竞渡的鼓点声里,《赛龙夺锦》的旋律自动浮现...

系统资源监控小助手(CPU-内存-磁盘占用)

当电脑突然卡顿,浏览器标签页切换出现残影,多数人的第一反应是打开任务管理器。但传统资源监控工具往往需要...

基于Tesseract的图片文字识别与导出工具

在信息数字化需求激增的当下,针对纸质文档与图片信息的快速提取工具成为刚需。基于Tesseract引擎开发的OCR工具因...

电子邮件附件分类导出工具(EML-MSG)

企业日常运营中,电子邮件附件的管理效率直接影响着业务流转速度。针对EML和MSG两种主流邮件格式的附件处理需求...

多线程学术论文摘要采集工具

科研工作者常面临海量文献筛选的困境。传统人工检索方式耗时耗力,特别是面对跨数据库、跨语种文献时,效率瓶...

办公文档批量重命名工具(支持序号-日期规则)

在办公室的日常场景中,文件命名混乱如同顽固的灰尘,总在关键时刻阻碍工作效率。某跨国企业的法务部门曾因合...

股票价格监控与涨跌预警通知程序

深圳某私募基金经理张昊习惯在晨跑时打开手机应用,某次瞥见持仓股突然触发预警线,当即在公园长椅上完成了调...

单词本记忆卡片应用(艾宾浩斯复习算法)

记忆类工具市场中,单词本记忆卡片应用凭借艾宾浩斯遗忘曲线理论的应用,逐渐成为语言学习者的刚需产品。这类...

批量生成测试假数据生成器

在软件开发与系统测试环节,真实数据模拟始终是验证功能完整性的关键步骤。某新型测试数据生成系统通过算法引...

简易图片格式批量转换工具(PNG-JPG)

在日常办公或创作中,图片格式的兼容性问题常让人头疼。比如设计稿件需要导出为PNG格式保留透明背景,而上传至...

简易画图板(支持保存为图片)

日常工作中经常遇到需要快速绘制示意图的场景。在尝试过多款工具后,一款基于网页的轻量级画图板逐渐成为我的...

多窗口网络Ping延迟测试仪表盘

网络延迟问题是现代企业及个人用户最常遭遇的痛点之一。无论是远程办公、在线会议还是实时数据传输,毫秒级的...

社交媒体话题标签规范化工具

打开微博热搜榜时,"张万森下雪了"和"张雪峰建议选专业要关注天花板"两个话题并列出现。这种符号与文字混排的现...

BeeWare跨平台GUI工具包

在跨平台应用开发领域,开发者常常面临一个困境:如何在保持代码统一性的兼顾不同操作系统的原生体验?传统方...

智能家居设备状态记录仪(MQTT转CSV存储)

在智能家居系统运行过程中,设备状态数据的长期记录常面临技术瓶颈。传统方案存在数据分散、格式混乱等问题,...

OVF模板批量签名验证工具

在虚拟化技术深度融入企业基础设施的当下,OVF模板的流通与应用呈现爆发式增长。某安全团队研发的批量签名验证...

简易贪吃蛇小游戏带积分榜

贪吃蛇这款经典游戏在移动端时代意外焕发新生。当屏幕从实体按键转向触控操作,传统玩法遭遇挑战的同时也迎来...

图片水印马赛克处理与格式标准化器

数字化时代,图片已成为信息传播的重要载体。当图片在不同场景流转时,水印干扰、隐私泄露、格式混乱等问题频...

网站关键词内容抓取工具

互联网信息爆炸的时代,如何在海量网页中精准捕捉有效数据?专业级网站关键词抓取工具正成为企业市场部门、S...

百度图片批量下载器(关键词搜索)

当设计师需要搭建灵感素材库,或电商运营批量制作商品详情页时,手动下载图片的耗时操作往往让人头疼。百度图...

基于openpyxl的Excel表格数据清洗工具

随着企业数据量的快速增长,Excel表格作为最常见的办公文档格式,其数据质量问题日益凸显。本文介绍的基于Pytho...

批量图片重命名与元数据清除器

在数字内容爆炸的时代,用户设备中存储的图片数量呈指数级增长。无论是摄影师的专业图库,还是普通用户的日常...

电脑软件许可证到期提醒工具

在企业日常运营中,软件许可证管理常被忽视,但一次意外的许可证过期可能导致项目中断、法律风险甚至数据丢失...

最近访问文件时间线工具

在信息爆炸的时代,每天产生的文件数量远超个人处理能力。办公文档、设计素材、会议记录、临时截图……这些文...

网络连通性持续监控报警器

机房的红色警报灯突然闪烁,值班工程师的手机弹出三条告警信息:核心交换机端口丢包率超阈值、跨区域专线延迟...

多关键词敏感内容自动打码工具

在信息处理领域,数据安全与隐私保护正面临前所未有的挑战。一款名为「隐盾」的智能工具近期引发行业关注,其...

简易本地HTTP服务器快速部署工具

在Web开发或日常办公场景中,开发人员经常需要快速启动临时HTTP服务器。相较于配置复杂的生产级服务器,以下几个...

按修改日期自动归档旧文件的整理工具

办公桌上堆满未分类的文档,电脑桌面挤着上百个未命名文件,这是每个职场人都会遭遇的困境。某互联网公司曾对...

合同文书关键词合规性检查系统

在企业经营活动中,合同文本的合规性审查直接影响着法律风险防控效果。传统人工审核模式存在效率低、标准不统...

桌面数字时钟屏保工具(多种皮肤可选)

工作间隙抬头瞥向屏幕,一串跳动的数字安静躺在桌面角落,极简字体搭配渐变光影,连时间流逝都变得具象化。这...

带GUI的计算器应用

随着数字办公场景的普及,图形界面计算器逐渐取代传统实体设备,成为效率工作者的必备工具。某款新近推出的跨...

代码依赖库安全检查工具(CVE漏洞检测)

2023年,美国某电商平台因Log4j2漏洞导致千万用户数据泄露。调查显示,其技术团队早在漏洞曝光前6个月就收到过依赖...

Python网页内容摘要生成工具

在信息爆炸的互联网时代,快速提炼网页核心内容的需求日益增长。Python凭借其丰富的第三方库生态,成为开发文本...

鼠标轨迹记录器(绘制移动路径)

屏幕右下角的指针移动时,很少有人注意到光标划过的路径正形成独特的数据指纹。某网络安全实验室2023年的研究显...

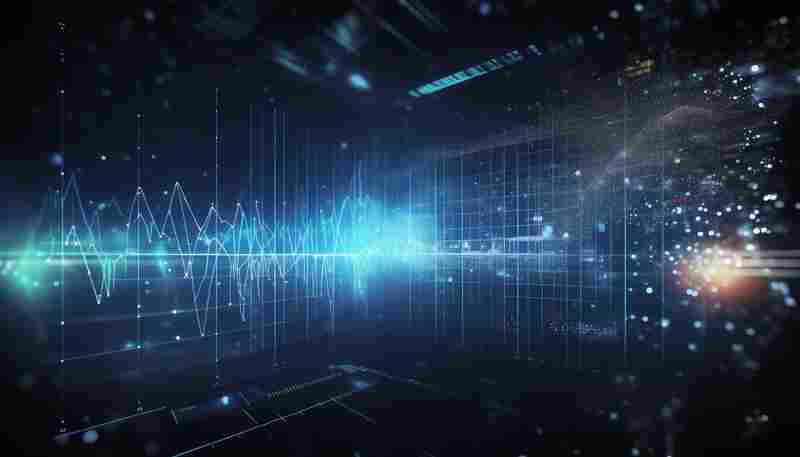

数学函数绘图工具(支持动态参数)

在数学教学和科研领域,可视化工具始终是理解抽象概念的重要桥梁。某款支持动态参数的函数绘图软件近期在工程...