中文分词统计工具(词频分析)

中文文本分析领域,分词工具扮演着基础而关键的角色。不同于英文等表音文字,中文的连续书写特性让计算机理解语义变得困难。现代中文分词工具通过算法创新,正在突破这一技术瓶颈。

主流分词系统普遍采用混合技术路线。基于词典的字符串匹配算法能快速识别已知词汇,隐马尔可夫模型通过概率计算处理未登录词,深度学习模型则擅长捕捉上下文关联。某开源工具测试数据显示,混合算法的准确率可达97.8%,较单一算法提升5-12个百分点。实际应用中,用户需注意专业术语词典的补充加载,特别是在处理医学文献或工程文档时,预设词典往往难以覆盖特殊领域词汇。

词频统计功能在舆情监测中展现独特价值。某品牌曾通过分词工具分析三万条社交媒体评论,发现"售后服务"出现频次较上月激增300%,及时排查发现物流环节存在系统漏洞。这种实时监测能力,帮助企业将危机处理响应时间缩短至48小时内。需要注意的是,停用词过滤设置直接影响分析效果,过度过滤可能丢失"虽然""但是"等具有情感倾向的关联词。

可视化模块正在成为分词工具的标配功能。某高校研究团队利用词云生成器分析百年党史文献,高频词大小差异形成直观的视觉层次,配合时间轴筛选功能,清晰呈现不同历史阶段的核心概念演变。这种时空维度的交叉分析,为研究者提供全新的文本观察视角。

开源社区贡献了超过60%的核心算法改进方案。PyPI平台数据显示,某中文处理库的季度下载量突破80万次,开发者论坛每月产生300+技术讨论帖。商业版本开始集成区块链存证功能,确保数据分析过程的可追溯性。跨语言处理能力仍是技术难点,中英混合文本的分词错误率比纯中文文本高出7.2个百分点。

- 上一篇:中文代码错误信息解释器

- 下一篇:中文古籍文献数字化处理工具

相关软件推荐

随机软件推荐

哈希链生成器(连续哈希计算)

在数字资产保护领域,哈希链生成器如同一套精密设计的密码齿轮组。这种通过反复执行哈希运算构建链条的工具,...

支持大文件分块对比的优化处理脚本

在数据量激增的数字化场景中,大文件对比需求频繁出现在开发调试、数据校验、版本控制等领域。传统文本对比工...

批量下载哔哩哔哩视频工具(需API)

哔哩哔哩(B站)作为国内知名的视频平台,许多用户希望将感兴趣的内容保存至本地,但官方未提供批量下载功能。...

文本换行符统一转换工具

打开一份从同事Mac电脑传来的文档,发现段落间距忽大忽小;将Linux服务器日志下载到Windows电脑查看时,所有文字挤...

工程图纸版本管理工具(自动追加修订日期标记)

建筑工地上的工人曾因图纸版本混淆导致返工,机械加工厂因未及时更新图纸造成材料报废,类似场景在制造业屡见...

本地音乐播放列表生成器(按BPM-流派)

手动整理本地音乐库的繁琐程度,每个重度音乐爱好者都深有体会。当硬盘里的曲目突破五位数时,传统按文件夹分...

字体文件结构可视化工具(显示轮廓-表格数据)

在字体设计领域,技术人员常需面对TTF/OTF文件复杂的二进制结构。某款专业字体文件可视化工具通过三维坐标系与数...

软件错误日志多语言模式识别工具

凌晨三点,某跨国电商平台的运维中心突然亮起警报。值班工程师盯着监控大屏上跳动的红色数字,面前同时弹出了...

天气查询软件(调用开放API显示实时数据)

打开手机应用商店搜索"天气",满屏图标让人眼花缭乱。真正能脱颖而出的天气查询软件,往往在细节处藏着匠心。这...

批量图片尺寸调整工具(保持长宽比或强制裁剪)

数字时代,图片处理成为日常工作中绕不开的环节。无论是电商平台的商品图统一规格,还是自媒体运营的多平台适...

自动化Excel报表合并拆分工具

传统财务及业务部门常面临多源数据整合难题。某医疗集团财务部每月需合并47家分院报表,人工操作平均耗费72小时...

校园活动信息发布与报名平台

每到开学季,校园公告栏总被各类活动海报覆盖。社团招新、学术讲座、体育赛事的信息层层叠叠,学生常常因错过...

PDF发票信息提取器

在现代企业运营中,发票管理是财务流程中不可或缺的环节。纸质发票的整理耗时耗力,电子发票虽普及,但PDF格式...

命令行历史记录搜索与分析工具

在终端操作场景中,用户每天可能输入数百条指令。当需要追溯三天前调试网络时使用的curl参数,或是统计本月使用...

系统电池状态提醒小工具

对于移动办公党来说,电量焦虑就像悬在头顶的达摩克利斯之剑。咖啡厅改文档时突然弹出的红色警告,会议室投屏...

SQLite数据库表内容导出为Excel工具

在日常数据处理中,SQLite因其轻量便携的特性成为许多开发者的首选数据库。当需要将数据分享给非技术人员或进行...

角度制(度数-弧度-百分度)转换程序

在工程设计、数学计算及地理测绘等领域,角度单位的灵活转换常成为关键环节。由于不同场景对角度制的需求差异...

百度贴吧自动签到工具

互联网社区文化中,"签到"始终是用户维系账号活跃度的常规操作。百度贴吧延续了传统论坛的签到机制,连续签到天...

哈希值计算与文件完整性校验工具

电脑屏幕前闪过一行十六进制字符串,看似杂乱无章的数字字母组合,却是现代数字世界最忠实的守门人。哈希值计...

多线程Docker镜像层下载加速器

某个周五下午,研发团队正准备上线新版本,当运维人员执行`docker pull`命令时,进度条突然停滞在某个镜像层。会议...

数据质量检测的医疗信息采集系统

医疗信息采集系统在数字化转型中承担着核心枢纽作用,其数据质量直接影响临床决策与科研分析的可靠性。某三甲...

SHP文件属性表快速查看器

地理信息数据处理领域,SHP文件作为主流矢量数据格式,其属性表的高效查看直接影响工作效率。针对传统GIS软件启...

办公文档目录自动生成器

整理办公文档目录曾是多数职场人避不开的枯燥流程。某科技公司市场部的张敏对此深有感触:去年筹备上市材料时...

文本敏感信息正则过滤清洗工具

在信息交互日益频繁的数字化时代,某款基于正则表达式的文本清洗工具悄然成为企业数据安全的守门人。这款工具...

Windows服务监控告警工具(日志记录功能)

在IT运维领域,Windows服务异常可能导致业务中断、数据丢失等严重后果。某款针对Windows服务设计的监控告警工具,凭...

知乎回答点赞数趋势分析工具

深夜两点,电脑屏幕的蓝光映在张伟脸上。作为某MCN机构的资深内容策划,他刚写完一篇关于"年轻人返乡创业"的知乎...

文件夹大小统计工具(树状图可视化显示)

办公电脑C盘突然飘红,手机相册只剩500MB可用空间,许多人面对存储危机时往往手足无措。传统存储管理工具提供的...

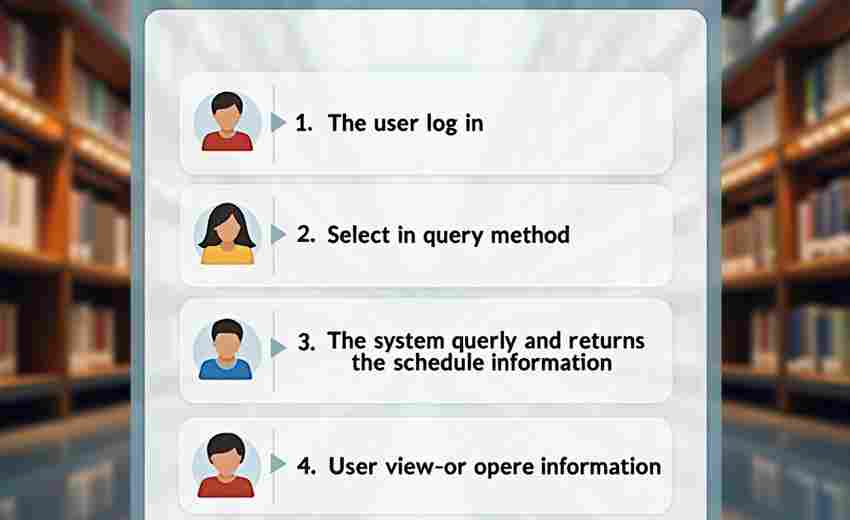

会议预约及日程提醒系统

现代职场中,频繁的跨部门协作与外部会议常导致时间协调困难。据统计,企业员工平均每周耗费3.7小时处理会议安...

多设备登录状态同步监控工具

在数字化办公场景中,用户频繁通过手机、平板、电脑等多终端设备登录系统已成为常态。多设备登录带来的账号安...

简易个人每日待办事项提醒弹窗程序

工作日的早晨总是兵荒马乱。很多人习惯用手机记事本罗列当日任务,但往往写着写着就淹没在信息洪流里。最近实...

网络设备ARP表分析工具

在复杂的网络环境中,ARP表作为二层通信的核心枢纽,承载着IP地址与MAC地址的动态映射关系。传统的手工排查方式效...

番茄钟时间管理工具(倒计时与休息提醒)

在纽约曼哈顿的联合办公空间,东京银座的创业孵化器,北京中关村的科技园区,都能见到这样的场景:年轻人在笔...

网络端口扫描工具(多IP段扫描)

某科技公司安全团队在2022年的内网渗透测试中,意外发现攻击者使用新型分布式端口扫描技术,在12小时内完成对1...

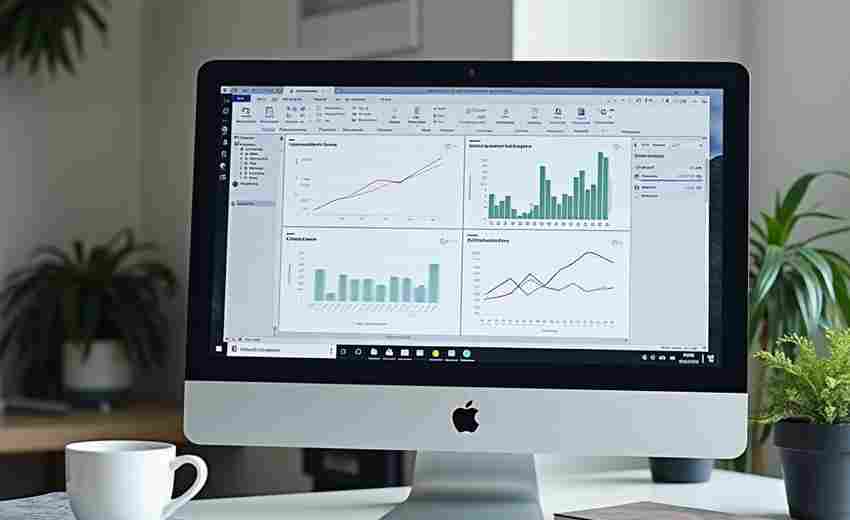

动态图表生成器(CSV数据转柱状图-折线图)

数据图表是信息传递的高效载体。但对于多数非专业人士而言,从原始数据到可视化呈现的转化过程往往存在技术门...

命令行实时打字速度测试器

在键盘敲击声主宰效率的时代,打字速度早已成为数字世界的基础技能。对于程序员、文字工作者或极客群体而言,...

简易屏幕取色器(RGB-HEX格式输出)

当设计师在PS里反复调试配色方案,或程序员需要精确匹配网页色值时,屏幕取色器往往能省去肉眼辨色的烦恼。市面...

文件同步工具(双目录差异对比)

在数据量指数级增长的数字化环境下,如何实现跨存储设备的精准同步成为刚性需求。基于双目录差异对比的同步工...

电商产品图批量白底优化工具

在电商行业竞争日益激烈的当下,商品主图质量直接影响转化率。专业摄影师拍摄的原图往往存在背景杂乱、光线不...

基于Flask的轻量博客系统

在个人建站需求日益增长的今天,开发者们常常陷入框架选择的困惑。当Django这类"全家桶"式框架显得过于沉重时,一...

文件签名验证工具(PGP-GPG)

在数字化信息交换中,数据完整性与身份认证是核心需求。PGP(Pretty Good Privacy)及其开源实现GPG(GNU Privacy Guard)作...