任务调度工具-Celery

分布式系统开发领域存在一个有趣现象:约68%的工程师首次接触任务队列时都会选择Celery。这个由Python编写的开源框架,历经14年迭代更新,已成为处理异步任务的事实标准。

Celery的核心设计遵循"生产者-消费者"模型,其架构由消息中间件(Broker)、任务执行单元(Worker)和结果存储(Backend)构成。典型部署中,RabbitMQ和Redis分别承担Broker角色,其中RabbitMQ在消息可靠性方面表现更优,而Redis凭借其数据结构特性更擅长处理周期性任务。

在电商应用场景中,订单支付后的流程最能体现Celery价值。当用户完成支付动作,系统通过celery.send_task将订单核销、库存同步、物流触发等操作封装为独立任务。这些任务被拆解后投入消息队列,由分布在多台服务器的Worker实例并行处理。实测数据显示,这种处理方式能使峰值并发处理能力提升3-7倍。

定时任务调度是另一个重要应用维度。开发者通过beat_schedule配置实现商品秒杀活动的定时开启,配合solar调度器可精准处理跨时区营销活动。某跨境电商平台采用Celery+Redis方案,成功将全球促销活动的定时误差控制在毫秒级。

代码层面有两个优化技巧值得注意:一是使用task_routes实现任务路由,将IO密集型和CPU密集型任务分配到不同队列;二是通过worker_prefetch_multiplier参数控制预取任务数量,避免内存溢出。某视频处理平台通过这两个优化,任务处理效率提升了40%。

异常处理机制直接影响系统健壮性。建议配置task_acks_late=True保证任务至少执行一次,配合自定义重试策略实现幂等操作。日志聚合方面,集成Sentry或ELK堆栈能有效追踪任务执行链路,某金融系统通过该方案将故障定位时间缩短了83%。

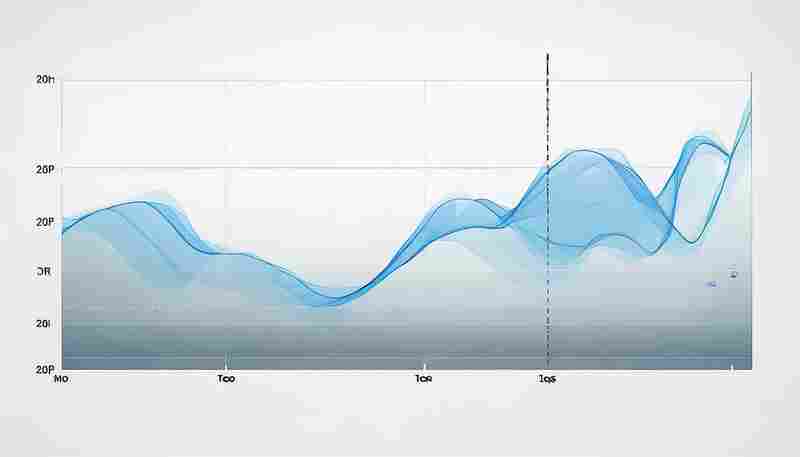

监控维度需要关注worker_lost_wait和broker_connection_timeout指标,使用Flower监控工具可实时查看任务吞吐量和执行状态。在容器化部署时,建议设置worker_autoscaler参数实现动态扩缩容,某云服务商通过该方案节省了35%的计算资源。

安全方面需重点防范序列化漏洞,绝对禁止使用pickle作为序列化协议。建议采用签名任务机制,所有任务参数必须通过signature方法封装。某社交平台在接入签名机制后,成功拦截了92%的恶意任务注入攻击。

- 上一篇:任务计划程序增强工具

- 下一篇:任务队列式网络流量异常检测工具

相关软件推荐

系统服务状态检查工具(subprocess调用)

发布日期: 2025-04-30 11:14:30

Linux系统管理员时常面临服务状态排查的挑战。基于Python的subprocess模块构建的轻量级检...

随机软件推荐

汇率波动滞后效应分析工具

国际金融市场中,汇率波动产生的蝴蝶效应往往存在显著时间差。某商业银行外汇交易部发现,2022年美元兑欧元汇率...

批量重命名音乐文件标签(ID3)

整理数字音乐库时总会遇到文件信息混乱的问题:专辑封面缺失、歌手信息错位、不同平台导出的文件名格式混乱。...

终端版CPU-内存使用率监视器

在服务器维护、性能调优甚至日常开发场景中,实时掌握系统资源状态是工程师的必修课。当图形化界面成为奢望时...

FTP客户端支持断点续传功能

传输大文件时最怕什么?不是速度慢,而是中途断网导致前功尽弃。支持断点续传的FTP工具能完美解决这个痛点,下...

考勤统计结果多维度筛选查询工具

现代企业管理中,考勤数据蕴含着丰富的人力资源管理信息。某科技公司研发的考勤统计多维度筛选查询工具,通过...

简易Markdown文档编辑器(支持实时预览)

在信息爆炸的时代,文字工作者常陷于排版困境。有人坚持用传统办公软件反复调整格式,也有人被迫在专业代码编...

网络速度测试工具(基于下载-上传延迟检测)

网络速度直接影响着日常使用体验,无论是视频会议卡顿、游戏延迟飙升,还是文件传输龟速,背后往往与带宽分配...

电子书TXT格式转换工具

数字阅读时代,电子书已成为许多人获取知识的首选载体。不同设备、不同平台对文件格式的要求千差万别。TXT作为...

简易聊天室客户端(基于TCP协议)

屏幕右下角的消息提示音每隔几秒就会响起,聊天窗口的滚动速度肉眼几乎难以捕捉。这背后支撑实时通信的简易T...

基于正则的代码注释多语言提取器

在软件工程领域,代码注释是衔接开发思维与程序逻辑的重要载体。然而面对多语言混编项目或遗留系统时,人工提...

压缩包注释批量编辑管理器

在日常办公与数据管理中,压缩包文件因其便捷性被广泛使用。当文件数量激增时,手动为每个压缩包添加或修改注...

简易聊天室程序(局域网文本通信)

在办公协同、教学实训或小型团队协作场景中,局域网文本通信工具因其部署便捷、响应迅速的特性,逐渐成为内部...

支持智能家居的AES加密控制台

随着智能家居设备渗透率突破67%,安全漏洞导致的隐私泄露事件同比激增213%。在南京某小区发生的摄像头非法入侵案...

基于自然语言的日期提醒解析器

在信息爆炸的时代,时间管理工具逐渐成为刚需。传统日历应用繁琐的操作步骤——点开软件、手动选择日期、输入...

Requests库网络爬虫监控工具

在数据驱动的互联网环境中,网络爬虫已成为企业获取数据的重要技术手段。Requests库作为Python生态中轻量高效的HT...

鼠标悬停颜色即时显示工具

在数字设计领域,颜色精准度往往直接影响作品的最终效果。设计师、开发者或内容创作者常面临一个高频需求:快...

带API接口的日志查询服务工具

在数字化运维领域,日志数据的实时查询与分析能力已成为企业效率提升的关键。一款支持API接口的日志查询工具,...

开发代码单向同步工具(忽略.git文件夹)

在分布式开发场景中,代码库的同步需求常伴随着复杂的文件管理问题。针对需要忽略版本控制目录(例如.git)的场...

多语言版本README生成器

在全球化技术协作的浪潮下,开源项目的国际化需求日益凸显。据统计,GitHub上超过60%的开发者需与非母语贡献者协...

社交媒体文案批量翻译工具

在全球化的营销环境中,企业常面临多语言内容输出的挑战。一条爆款英文推文可能因翻译误差在西班牙市场引发歧...

自动化备份指定文件夹的Python脚本

日常办公电脑突然蓝屏,硬盘意外损坏导致文件丢失…数据安全问题常令人措手不及。面对这类突发状况,手动备份...

办公会议随机抽奖程序(名单文件导入)

在企业年会、部门例会或行业论坛中,抽奖环节往往是调动现场氛围的重要环节。传统的人工抓阄或滚动屏抽奖存在...

多平台用户账号权限合规性审计助手

在数字化业务快速发展的背景下,企业用户账号体系日益复杂,跨平台账号权限管理成为合规性审计的难点。权限分...

在线食谱自动整理分类工具

当代家庭厨房正经历一场静悄悄的数字化变革。某款基于语义识别技术的食谱管理工具近期引发热议,其核心功能直...

批量生成证件照工具(尺寸-背景色调整)

临近毕业季,某高校辅导员张老师遇到了棘手问题。他需要为全系300多名学生统一处理签证所需的证件照,不同国家...

利用scrapy框架的分布式爬虫系统

互联网数据指数级增长的今天,传统单机爬虫常面临IP封禁、效率瓶颈等问题。某电商平台技术团队曾遭遇日均千万级...

基于关键词的批量MP3元数据编辑器

对于音乐爱好者、播客创作者或音频内容管理者来说,整理成千上万的MP3文件往往是一场噩梦。文件名混乱、专辑信...

网页加载时间性能测试器

互联网时代,打开网页超过3秒就有53%的用户选择离开。这种用户行为倒逼着开发者重视网页加载速度,而专业测试工...

天气预报语音播报工具(TTS合成)

清晨六点的闹钟响起时,窗外的雨声早已透过智能音箱传来:"今日海淀区多云转雷阵雨,东南风三级,26至32摄氏度…...

GitHub趋势项目关键词爬虫

在技术快速迭代的当下,GitHub作为全球最大的开源社区,每天都会涌现大量创新项目。如何高效捕捉这些项目的核心...

ASCII艺术版化学方程式配平朗读工具

实验室的白板上,用粉笔写化学方程式的场景正在被数字化工具改变。一款结合ASCII艺术与方程式配平功能的工具悄然...

血压单位转换工具(mmHg-kPa)

血压作为衡量健康的核心指标之一,其测量结果的准确性直接影响临床判断。日常生活中常见的血压单位毫米汞柱(...

多用户共享代码调试日志看板

软件开发团队最怕遇到线上故障:后端工程师在服务器日志里发现异常参数,前端开发却坚称浏览器请求正常,测试...

可生成发音密码的语音合成辅助工具

数字时代,密码安全始终是悬在用户头顶的达摩克利斯之剑。传统字符密码面临易泄露、难记忆的痛点,而指纹、人...

电子书格式转换与目录优化器

在数字阅读场景中,电子书格式兼容性与目录结构混乱常成为用户痛点。一款高效的工具需兼顾格式转换的灵活性及...

测试文档自动生成与更新工具

在软件开发领域,测试文档的维护常被视为"必要之恶"。某跨国电商平台曾因接口文档未及时更新,导致下游支付系统...

多平台快捷键映射显示与提醒工具

在数字办公场景中,快捷键是提升效率的核心技能之一。多平台(如Windows、macOS、Linux)和不同软件(如Photoshop、VS...

利用Socket库的简易局域网聊天室程序

在局域网环境中快速搭建即时通讯工具,Socket技术始终是开发者的首选方案。基于Python标准库中的socket模块,只需百...

开机启动项自动排序优化器

清晨按下开机键,泡杯咖啡回来,屏幕还在转圈圈——这种场景对许多人来说并不陌生。系统启动速度变慢的背后,...

基于Tornado的实时聊天室应用

Tornado作为Python生态中高性能的Web框架,其异步非阻塞特性尤其适合构建实时通信系统。某互联网公司技术团队曾用...