关键词数据标准化与归一化处理工具

数据标准化与归一化处理工具是数据分析与机器学习领域的基础设施。面对不同量纲、不同分布的数据源,算法模型往往需要将数值调整到统一尺度才能稳定运行。市面上主流工具已形成从传统统计分析软件到现代编程框架的完整生态链。

数据处理工具的分类逻辑

目前主流的工具可分为三类:第一类是以Python的scikit-learn、R语言caret包为代表的编程库,通过MinMaxScaler、StandardScaler等函数实现自动化处理;第二类是Tableau、Power BI等可视化平台内置的数据预处理模块,支持交互式参数调整;第三类则是Excel这类通用工具,借助内置公式完成简单缩放。其中编程类工具在处理百万级数据时展现出明显优势,某电商平台曾用Spark MLlib在15分钟内完成2亿用户行为的标准化处理。

具体工具操作差异

以Python的MinMaxScaler为例,其默认将数据压缩到[0,1]区间,但实际使用时需警惕异常值影响。某医疗数据分析项目就曾因未剔除极端体温值,导致归一化后的数据集中99%的数值挤在0.05-0.15区间。相比之下,z-score标准化对异常值的鲁棒性更强,某银行风控系统采用这种方法后,客户信用评分分布更符合正态假设。

工具选择的技术考量

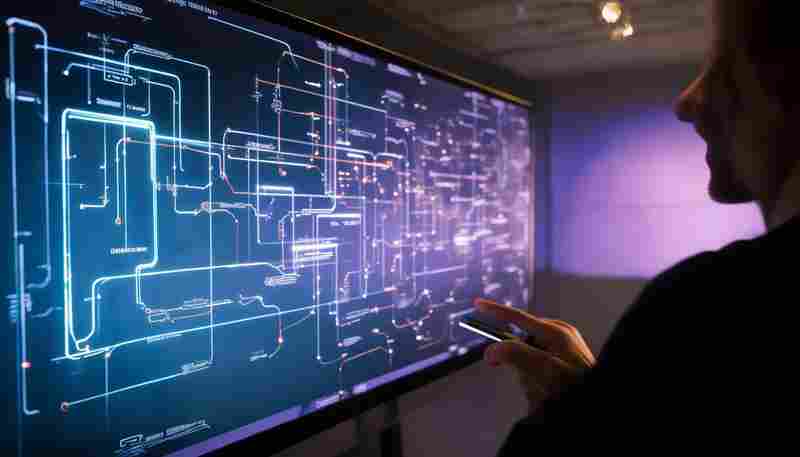

TensorFlow等深度学习框架开始集成自适应归一化层,这类工具能动态调整缩放参数。但传统制造业的工程师更倾向使用KNIME这类图形化工具,某汽车零件厂质量检测部门通过拖拽节点就完成了产线传感器数据的实时标准化。工具性能差异直接影响处理效果:某遥感图像处理项目对比发现,GPU加速的CuML库比CPU版sklearn快37倍。

数据分布形态决定该选用最大最小值法还是标准差法;算法类型影响是否必须去量纲化——例如K近邻算法对特征尺度敏感,而决策树类算法则相对免疫。计算资源限制常迫使工程师在精度与效率间权衡,流式计算场景下,Spark的分布式处理能力优势明显。某些特殊场景需要保留原始分布特征,金融反欺诈系统就曾因过度归一化导致交易金额模式失真。

- 上一篇:共享文件重复内容自动清理工具

- 下一篇:关键词触发系统状态检测工具

相关软件推荐

Excel数据到PowerPoint图表生成工具

发布日期: 2025-04-04 14:03:01

Excel到PowerPoint图表生成工具:让数据汇报高效升级 在企业汇报、学术研究或市场分析场...

随机软件推荐

pip(Python包管理工具)

作为Python开发者,几乎没有人能绕开pip。这款工具自2011年成为Python标准库组件后,逐渐成为管理第三方库的核心方案...

实时股票价格语音查询工具

金融市场瞬息万变,股价波动往往以秒计算。对于股民而言,紧盯屏幕刷新的方式不仅低效,还可能错过关键交易时...

自动截屏拼接全景图工具

滚动截屏功能早已普及,但遇到超长网页或聊天记录时,传统分段截屏需要人工拼接,常出现错位、重复或漏页问题...

跨地域服务延迟对比报警工具

在全球化网络服务架构中,某跨国电商曾因巴黎机房到巴西用户的网络抖动未被及时发现,导致当地"黑色星期五"促销...

数据库敏感信息模糊化处理工具

随着数据安全法规的日益严格,某科技公司近期推出的"幻影盾2.0"数据处理系统引发行业关注。这款专注于数据库敏感...

局域网简易聊天室(TCP-IP协议实现)

在办公协同场景中,局域网即时通讯工具因其低延迟、高安全性的特点备受青睐。基于TCP/IP协议开发的聊天室程序,...

密钥证书与私钥匹配性检查工具

在数字证书与密钥管理领域,密钥证书与私钥的匹配性检查是确保通信安全的关键环节。一套失效的证书或错误的密...

基于SQLite的办公用品库存管理系统

日常办公物资管理常面临台账混乱、数据更新滞后等问题。某科技团队针对中小企业需求,研发了一款基于SQLite数据...

多格式表格数据关键词分析器

在数据驱动的现代商业环境中,表格数据作为信息载体的重要性不言而喻。面对Excel、CSV、JSON等多种格式的表格文件...

简易FTP客户端(支持上传下载和目录浏览)

在网络文件传输领域,FTP(文件传输协议)作为经典的数据交换方式,至今仍被开发者、运维人员甚至普通用户广泛...

随机密码强度测试报告生成器

数据安全领域近年频发的密码泄露事件不断敲响警钟。2023年某跨国企业因员工使用"123456"作为系统密码导致数千万用...

岗位需求与求职者画像匹配度计算器

在人力资源行业,企业招聘与求职者应聘之间的信息不对称问题长期存在。岗位需求描述模糊、简历筛选效率低下、...

多文件合并CSV转Excel处理器

在日常办公和数据分析场景中,CSV文件因其轻量化和通用性被广泛使用。面对成百上千个分散的CSV文件时,手动合并...

跨平台日志文件统一监控告警框架

凌晨三点,某电商平台数据库突发异常。运维团队通过日志监控系统捕捉到毫秒级延迟波动,在用户感知前完成故障...

疫情实时数据统计工具

全球疫情监测已进入常态化阶段,一款专业可靠的疫情数据追踪工具成为公众日常刚需。本文重点解析某权威疫情数...

多线程批量文本文件XML格式校验工具

本地化部署的XML格式校验工具正逐步成为企业数据治理的标配。传统单线程校验工具面对上千个文件时,常出现响应...

文件系统Inode健康度评分计算器

在Linux服务器运维领域,文件系统的Inode管理常被称为"隐形杀手"。某中型电商平台曾因Inode耗尽导致订单系统瘫痪12小...

本地文件关键词搜索工具(支持多格式文档检索)

面对海量电子文档的日常管理,多数人都有过这样的困扰:硬盘里堆积的合同扫描件、会议纪要、技术文档混杂着P...

自动化Chrome扩展管理工具

面对浏览器中日益臃肿的插件库,多数用户都经历过这样的困扰:重复安装的插件挤占内存,失效的扩展拖慢运行速...

会议讨论内容敏感词过滤工具

数字化办公场景下,会议记录的安全管控成为企业管理的关键课题。某信息安全团队开发的智能过滤系统,通过对语...

多语言词库合并与去重工具

在全球化进程中,多语言词库的整合需求日益增长。无论是跨境企业的术语管理、翻译团队的语料优化,还是学术研...

网页内容抓取工具(表格-链接提取)

在信息化时代,网页数据的高效采集已成为企业和个人获取资源的重要途径。针对表格与链接这类结构化数据的抓取...

项目Commit消息格式校验脚本

又双叒叕是commit message不规范!"某项目组的晨会上,技术负责人把咖啡杯重重放在会议桌上。墙上的Git提交记录显示...

文件差异备份工具

坐在电脑前修改设计稿的第三个小时,设计师小王无意间碰倒了咖啡杯。手忙脚乱擦拭键盘时,他忽然意识到最近两...

天气查询命令行工具(集成第三方天气API接口)

在终端场景下实现气象数据的高效获取,是提升开发效率的有效路径。本文将以WeatherCLI工具为例,解析如何通过命令...

多语言二维码翻译模板生成器

在全球互联时代,二维码已成为链接线上线下的核心工具。无论是产品包装、活动宣传还是公共设施,扫码获取信息...

视频封面批量提取工具(指定时间截取)

短视频创作者常面临一个痛点:如何在成百上千的视频文件中快速提取封面图?传统截图工具需逐帧查找关键画面,...

桌面天气时钟小工具(带实时天气图标显示)

窗外的雨点敲击玻璃时,桌面右下角的小云朵同步凝出水珠;晨光穿透窗帘的瞬间,像素风格的太阳准时爬上数字时...

简易RSS阅读器(终端界面显示)

在信息爆炸的时代,如何高效追踪内容更新成为技术从业者的刚需。基于终端的RSS阅读器凭借其极简主义设计和低资...

命令行简易防火墙规则配置工具

在Linux服务器运维中,防火墙配置是每个工程师的必修课。面对复杂的网络环境和瞬息万变的安全威胁,掌握高效的防...

系统剪贴板历史管理工具(最近10条记录)

对着电脑处理文档时,总会出现这样的场景:刚复制了客户的电话号码,突然需要粘贴半小时前查到的产品参数,却...

SSH密钥对批量部署与权限管理工具

在分布式系统与云计算环境中,服务器规模动辄成百上千台。传统密码登录方式不仅效率低下,还存在密码泄露风险...

屏幕颜色取词工具(OCR识别选定区域)

午后阳光斜照进办公室,设计师小王第三次打开PS调色板,试图还原客户发来的网页截图色值。这种机械式的手动取色...

日志文件按时间戳分段存储工具

凌晨三点,服务器警报声突然响起。运维工程师老张盯着屏幕上滚动的报错信息,发现需要检索某台设备过去24小时的...

图形化界面的文件哈希校验器

在数字化时代,文件传输过程中的完整性验证变得尤为重要。曾有位摄影爱好者因系统镜像文件损坏导致三天工作成...

音频文件重命名与格式同步修改工具

随着数字音频文件数量的激增,音乐制作人、播客创作者常面临两大难题:一是多设备采集的音频命名混乱,二是跨...

桌面便签小工具(透明置顶显示)

办公族常遇到这样的场景:屏幕挤满文档窗口,重要事项被覆盖在层层叠叠的界面下。某次会议记录需要随时调阅,...

RSS新闻订阅阅读器(带摘要显示功能)

清晨七点,地铁车厢里挤满刷手机的人群。当多数人淹没在社交平台瀑布流时,资深媒体人李默已经通过RSS阅读器完...

文件夹空文件与临时文件清理工具

许多用户习惯手动清理硬盘空间,但面对层层嵌套的文件夹和各类专业软件生成的临时文件时,常规操作往往力不从...

博物馆藏品信息批量导出工具

数字化浪潮席卷全球博物馆行业,数据管理效率成为衡量机构现代化水平的重要指标。面对动辄数万件的藏品信息,...