利用NLTK的词频统计与可视化工具

自然语言处理工具包NLTK作为Python生态中的重要组件,其内置的文本分析功能常被应用于语言学研究和数据清洗工作。本文将围绕词频统计与可视化两个核心功能展开讨论,重点解析具体操作方法及实践价值。

安装NLTK库后需执行`nltk.download`命令获取语料库资源,建议勾选book选项载入预设数据集。当处理自定义文本时,文本清洗环节需注意特殊符号过滤与大小写统一,可通过正则表达式配合`re.sub`实现初步处理。对于英文文本,`nltk.word_tokenize`的分词效果优于简单字符串拆分,能准确识别缩略语与复合词。

在词频统计环节,`FreqDist`函数生成的统计对象包含`most_common`等实用方法。研究者可通过设置参数筛选高频词,例如`fd = FreqDist(tokens); print(fd.most_common(20))`可输出前20位高频词汇。需特别注意的是,需提前加载停用词表过滤无意义词汇,避免影响分析结果。

可视化模块中,`plot`方法可直接生成频率分布折线图,通过`cumulative=True`参数可转换为累积频率曲线。对于长文本分析,建议使用`dispersion_plot`制作词汇分布散点图,该方法能直观显示特定词汇在文本中的位置分布,适用于研究作者用词习惯或主题演进。

Matplotlib库可与NLTK配合实现深度定制可视化,通过修改`nltk.draw.dispersion_plot`源码中的坐标参数,可调整图表尺寸与颜色方案。某研究团队曾用该方法分析《傲慢与偏见》不同章节的情感词汇分布,成功验证了文学评论界关于叙事视角转换的假说。

数据处理过程中常会遇到生僻字符编码问题,建议在文件读取阶段指定`encoding='utf-8'`参数。词频统计结果导出为CSV格式时,可使用`pandas.DataFrame(fd.most_common).to_csv`保持数据结构完整。学界已有利用该技术完成方言文本量化研究的成功案例,为濒危语言保护提供了数据支撑。

- 上一篇:利用NLTK的英文文本词频统计工具

- 下一篇:利用OpenCV的简易图像批量处理器

相关软件推荐

Python-Seaborn-统计图表生成工具

发布日期: 2025-08-03 14:48:01

在数据科学领域,可视化是探索数据特征的重要方式。Python生态中的Seaborn库凭借其优雅...

利用Pycryptodome的AES加密工具

发布日期: 2025-05-02 12:16:30

在数据安全领域,AES加密算法如同数字世界的钢铁卫士。作为Python开发者,Pycryptodome库...

利用configparser的INI配置管理器

发布日期: 2025-08-01 13:54:01

轻量化配置管理利器:Python configparser模块实战指南 在软件开发中,配置管理直接影响...

随机软件推荐

系统文件重复查找器(按内容比对删除冗余)

在数据爆炸的现代办公环境中,某科技公司研发团队近日推出的FileDedupe Pro软件引起了行业关注。这款基于内容比对的...

CSV文件字段内容快速筛选导出工具

日常工作中常会遇到这样的场景:面对上百兆的CSV数据文件,需要快速提取特定字段内容。传统方法需导入Excel处理,...

日志文件二进制异常检测工具

日志文件二进制异常检测工具近年来逐渐成为运维领域的热门研究方向。随着企业服务器规模的指数级增长,传统基...

多格式电子书语言翻译批处理工具

纸质书向电子化转型催生了海量多格式数字内容。面对EPUB、MOBI、PDF等主流格式混杂的文献库,传统翻译工具常因格式...

网易云音乐歌单歌曲列表导出脚本

网易云音乐作为国内主流音乐平台之一,积累了大量用户自建歌单。当用户面临账号迁移、本地备份或跨平台分享需...

窗口置顶工具带热键配置功能

屏幕右下角任务栏图标闪着微光,双击后弹出不足指甲盖大小的设置面板。这是笔者最近深度体验的WindowStickyPro工具...

Tkinter版简易文本编辑器

在Python生态中,Tkinter作为标准GUI库常被低估其潜力。基于该库实现的简易文本编辑器,意外展现出值得关注的实用价...

重复音乐文件查找器(基于音频指纹)

音乐发烧友的硬盘里常积压着数千首重复曲目——演唱会版本、混音版本、不同平台下载的同名文件往往占据大量存...

二维码生成与Excel数据联动工具

在日常办公场景中,数据管理与信息传递的效率直接影响业务推进速度。传统的数据录入与核对流程往往依赖人工操...

网络爬虫数据自动存储CSV与词云生成工具

在大数据时代,信息采集与分析成为企业和个人的刚需。一款集网络爬虫、数据存储与词云生成功能于一体的工具,...

微博评论情感极性心形可视化分析器

在社交媒体的信息洪流中,微博评论的实时情感捕捉始终是舆情分析领域的难点。某研究团队近期推出的情感极性心...

简易CSV柱状图绘制工具

数据可视化已成为现代工作中不可或缺的环节,尤其在处理大量结构化数据时,直观的图表能显著提升信息传递效率...

键盘鼠标操作记录器(pyautogui实现)

在自动化办公与软件测试领域,键盘鼠标操作记录器是提升效率的利器。基于Python的`pyautogui`库,开发者可快速构建轻...

打印机状态监控缺纸提醒工具

在商务楼宇的走廊里,时常能看见抱着文件疾走的行政人员,他们最不愿遇见的场景莫过于打印机突然亮起缺纸提示...

股票价格实时查询与提醒工具

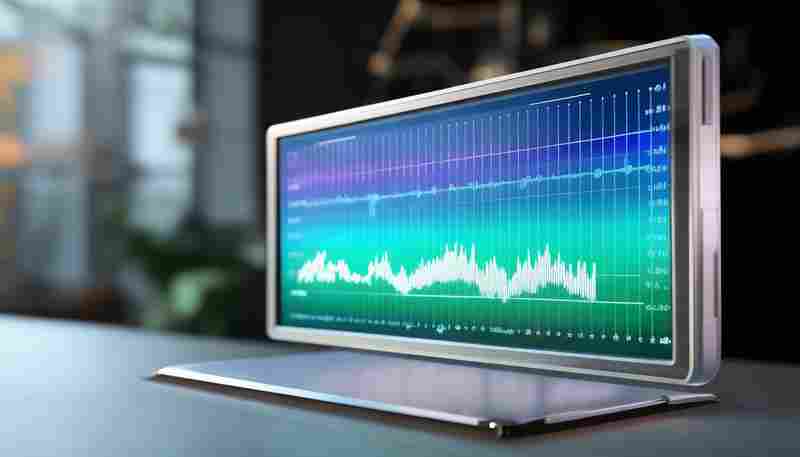

金融市场瞬息万变,股价的波动往往在分秒之间决定投资者的盈亏。对于普通投资者而言,实时掌握股票动态并快速...

社交媒体数据采集分析器

互联网每分钟产生数百万条社交动态,如何从海量信息中提炼有效价值?某款社交媒体数据采集分析器近期在多个行...

自动文件同步工具(本地-远程目录)

办公室电脑的PSD源文件与家中笔记本的素材库总是版本错乱?远程服务器上的数据库备份经常需要手动更新?这些场...

TMDb电影数据库检索与推荐系统

当观众在凌晨三点打开流媒体平台,面对上万部电影却陷入"片荒焦虑"时,TMDb电影数据库检索与推荐系统正在后台默...

系统服务日志批量重命名工具(正则表达式支持)

面对服务器集群每日生成的数千条日志文件,运维工程师常陷入命名格式混乱的困境。某跨国电商平台曾因日志命名...

文本文件关键词统计工具(支持导出CSV)

在信息爆炸的时代,如何快速从海量文本中提取核心信息成为刚需。一款专注于关键词统计与数据导出的工具,正成...

带图形界面的JSON数据校验工具

在软件开发的日常流程中,数据校验环节常令开发者陷入两难境地。传统命令行工具虽能满足基本需求,却让非技术...

数据库表结构对比工具(生成差异SQL脚本)

在数据库版本迭代与团队协作开发场景中,技术人员常会遇到表结构不同步导致的数据冲突问题。某企业开发团队在...

网页自动登录操作模拟工具

在数字化办公场景中,重复性的网页登录操作常成为效率瓶颈。无论是企业内部的系统管理,还是个人用户的多账号...

网页链接有效性验证器

互联网环境中存在大量失效链接。某技术团队统计发现,平均每个中型网站每月会产生3%-5%的失效链接,这些"数字断...

桌面天气预报预警通知小工具

清晨推开窗,雨点毫无预兆砸向窗台——十分钟后即将出门的人这才匆忙翻找雨具。类似场景在生活中频繁上演,直...

多格式系统配置文件合规检查工具

在数字化转型浪潮中,企业IT系统复杂度呈指数级增长。不同设备、平台的配置文件格式差异大,人工审核效率低且易...

简易微积分符号运算练习器

微积分符号运算常让初学者感到棘手。复杂的导数规则、积分技巧以及极限计算不仅需要逻辑推导能力,更依赖对符...

电商产品图批量白平衡+分辨率调整器

在电商领域,商品图片的质量直接影响用户购买决策。光线偏差导致的色差问题、低分辨率造成的细节模糊,往往成...

个人健康数据监测分析器(SQLite存储)

清晨六点,智能手环的震动唤醒用户,此刻的睡眠质量评分已自动生成。当运动爱好者完成五公里晨跑,血氧、心率...

IP地址归属地智能家居控制工具

现代家庭对智能设备的依赖日益加深,但跨地域使用场景中的设备适配问题却常被忽视。比如一台在北京购买的智能...

随机密码强度检测评分工具

数字时代,密码如同守护个人隐私与资产的门锁。但如何确保这串字符足够坚固?随机密码强度检测评分工具应运而...

外汇投资盈亏计算器

外汇投资市场中,交易者常被一个问题困扰:如何精准计算每笔交易的潜在盈亏?传统的手动计算依赖公式推导,但...

简易计算器工具(支持单位换算与历史记录)

厨房台面堆着食谱和量杯时,手机里的计量单位转换功能总能救急。现代人手机里必备的计算器工具早已突破传统数...

基于UDP的实时传感器数据传输工具

在工业自动化、物联网及智能设备领域,实时传感器数据的传输效率直接影响系统响应速度与可靠性。基于UDP协议的...

书签导出结果语音播报工具

日常网络浏览中,用户常通过收藏书签积累大量资料,但手动整理耗时费力。针对这一痛点,一款支持将书签导出结...

键盘输入记录器(记录所有按键事件到日志)

任何接触过计算机安全领域的人,都不会对键盘输入记录器(Keylogger)感到陌生。这类软件通过实时监控键盘活动,...

二维码批量生成与Word文档自动插入工具

在数字化办公场景中,企业资料管理、活动物料制作常面临批量处理二维码的痛点。某技术团队近期推出的"QR DocMas...

PyQt5开发的JSON数据可视化校验工具

调试API接口的深夜,望着控制台里层层嵌套的JSON报文,某个瞬间突然萌生开发可视化校验工具的想法。作为浸淫数据...

网页爬虫数据采集器(静态页面版)

清晨八点的办公室,市场部总监第五次刷新竞品网站的价格页面。这个动作他重复了三个月,直到某天发现电脑里多...

多文件内容版本历史对比回溯工具

在软件研发、文档协作或数据管理领域,版本迭代频繁的场景下,如何快速定位文件变更、回溯历史内容,成为许多...