基于MD5校验的快速文件去重器

数字时代下,电子文件呈爆发式增长,重复文件挤占存储空间、降低工作效率的问题日益突出。传统人工筛查耗时费力,而基于MD5校验算法的文件去重工具,正成为解决这一痛点的技术方案。

功能概述:精准识别与秒级处理

该工具的核心能力在于快速识别重复文件。通过计算文件的MD5哈希值——一种不可逆的128位字符串,每个文件生成唯一"数字指纹"。即使文件名被修改或存储路径不同,只要文件内容完全一致,其MD5值必然相同。工具通过扫描目录、生成哈希数据库并实时比对,可在数秒内完成TB级文件的去重操作。用户可自定义保留策略,例如优先保留最新文件或指定路径下的版本,避免误删关键数据。

技术原理:算法优化与资源控制

MD5校验虽然具备高碰撞抗性,但传统算法在大体量文件处理中存在性能瓶颈。该工具通过三点优化提升效率:

1. 分块计算:将大文件拆分为固定大小的数据块并行处理,降低内存占用;

2. 增量更新:仅对新增或修改文件进行哈希计算,减少重复扫描;

3. 缓存机制:建立本地哈希库,二次扫描时直接调用历史数据。

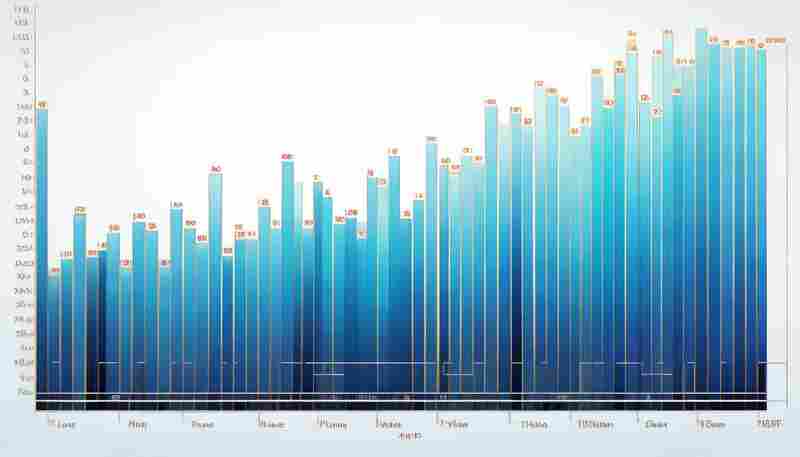

实测数据显示,处理10万份平均大小为50MB的文件时,速度较未优化版本提升近3倍,CPU占用率稳定在15%以下。

使用场景:从个人到企业的全覆盖

某设计团队反馈,使用该工具后项目文件夹体积缩减42%,协同编辑时文件检索效率显著提升。

对比优势:轻量化与兼容性

相比同类工具,该方案摒弃复杂的图形界面,采用命令行与脚本化操作,更适合批量处理。支持Windows、Linux、macOS多平台运行,并能通过插件对接Nextcloud、Synology等NAS系统。开源版本的代码已通过社区安全审核,杜绝潜在后门风险。

用户评价与迭代方向

部分技术用户建议增加SHA-256校验选项以满足更高安全需求;开发者社区正在测试基于机器学习的分层存储功能,未来或实现"冷热数据"自动归类清理。(字数:798)

- 上一篇:基于MD5哈希值的重复图片检测工具

- 下一篇:基于MQTT的物联网设备服务监控器

相关软件推荐

简易翻译工具(基于googletrans库)

发布日期: 2025-04-23 10:46:27

在全球化协作日益频繁的当下,基于Python的googletrans库为开发者提供了快速实现多语言...

随机软件推荐

本地数据库查询工具(SQLite界面)

在数据处理需求日益增长的今天,轻量级数据库SQLite凭借其零配置、单文件存储的特性,成为移动端应用、嵌入式设...

Python实现屏幕时间统计工具

现代人的工作娱乐几乎离不开电子屏幕。一位程序员朋友上周向我抱怨:每天对着电脑十几个小时,却说不清时间具...

代码文件行尾符统一转换器

在某个深夜的代码提交记录里,开发工程师李明突然发现Git提示存在数百行变更。当他颤抖着手点开差异对比时,满...

进程资源阈值自动控制器

在分布式系统与云计算普及的当下,服务器资源争抢导致的进程崩溃、服务中断等问题频发。传统运维依赖人工监控...

备份文件内容增量查重工具

数据备份如同现代人的数字保险箱,但反复存储的冗余文件往往让硬盘空间不堪重负。某互联网公司运维团队曾发现...

带历史记录功能的单位换算计算器

在日常生活与工作中,单位换算的失误往往带来意想不到的麻烦。工程师可能因工程图纸单位混淆导致施工误差,烘...

简易文件同步工具(目录监控)

办公桌前的咖啡早已凉透,王明第三次打开U盘确认文档版本时,屏幕右下角的时钟显示凌晨1:47。这样的场景在数字化...

简易词云生成器(基于文本内容分析)

在信息爆炸的时代,快速提炼文本核心内容成为刚需。词云生成器作为一种直观的可视化工具,正被越来越多领域应...

代码行数统计工具(目录递归扫描)

在项目复盘或技术评审环节,开发团队常需要快速掌握代码库规模。基于目录递归扫描的代码行数统计工具,凭借其...

使用OpenCV库的图片格式批量转换工具

在数字图像处理领域,文件格式转换是高频基础需求。基于OpenCV的开源特性与跨平台优势,我们设计了一款支持多线...

Chrome书签多设备同步工具

在智能终端普及的今天,用户平均持有3.7台联网设备已是常态。当用户在地铁用手机收藏的网页,回到办公室却找不...

二次方程求根计算器

数学课上最令人头疼的瞬间,莫过于解二次方程时卡在复杂的根式运算上。无论是学生、工程师,还是需要临时计算...

智能合约代码哈希白名单执行平台

在区块链生态中,智能合约的漏洞和恶意代码攻击频发,导致数十亿美元资产损失。传统审计工具依赖人工排查,效...

文件夹同步备份工具(单向-双向同步配置)

信息爆炸时代,数码设备中的文件管理如同走钢丝。某互联网公司研发部曾因未及时同步代码库,导致三个工作日的...

客户评论情感倾向环形图工具

在互联网时代,用户评论已成为企业洞察市场的核心渠道。但面对海量文本数据,如何快速识别其中的情绪倾向成为...

文件类型分类整理工具(基于shutil库)

桌面上散落着387个未整理文件——这是上周清理硬盘时触目惊心的发现。从PDF技术文档到JPG旅游照片,各类文件像失...

网络服务质量评分工具

网络服务质量的优劣直接影响用户体验,如何准确评估网络性能成为运维领域的核心课题。某通信设备厂商研发的网...

终端进度条生成工具(ASCII动画)

黑底白字的命令行终端常给人以冰冷感。当程序进入耗时操作时,光标静止带来的不确定感尤为明显。此时若出现动...

番茄钟工作法计时器(可视化时间区块)

番茄钟工作法诞生三十余年,依然活跃在效率工具排行榜前三名。这个把时间切割成25分钟"番茄块"的方法,在智能时...

多线程网络爬虫数据抓取工具(含去重功能)

互联网数据以每秒百万级的速度增长,企业对于高效数据采集工具的需求持续攀升。某开源社区近期推出的多线程网...

简易问卷调查系统(支持单选-多选题型导出结果)

在教育培训机构的会议室里,张老师正用平板电脑操作一套问卷系统。她需要快速收集家长对课后服务的意见,系统...

增量式加密配置历史管理工具

在软件工程领域,配置文件的版本管理与安全性问题长期困扰开发团队。某开源项目组近期推出一款基于增量式加密...

邮件定时发送任务调度管理器

在快节奏的数字化办公场景中,邮件定时发送功能逐渐成为提升效率的刚需。某款针对企业用户开发的邮件任务调度...

单词拼写检查工具(基础字典匹配)

在文字处理场景中,单词拼写检查工具如同无声的校对助手。这类工具主要依托内置的基础词库进行自动比对,通过...

古诗接龙生成器(唐诗宋词语料库)

漫步千年诗海,若有一款工具能让人与李白对饮、同苏轼泛舟,该是何等妙事?古诗接龙生成器的诞生,正悄然拉近...

多媒体播放器解码资源优化工具

在视频播放领域,硬件资源消耗与播放流畅度始终是用户体验的分水岭。解码资源优化工具的出现,正逐步打破传统...

多语言版本内容同步校验系统

在全球化业务扩张的浪潮中,跨国团队常面临这样的困境:某款产品的中文说明更新后,西班牙语版本仍停留在三周...

TCP连接状态异常报警系统

在网络运维领域,TCP连接的稳定性直接关系到业务连续性。一次握手失败、一次异常断开,都可能引发服务中断甚至...

屏幕录制工具(指定区域录制为GIF)

办公桌前的程序员正对着一段报错代码抓耳挠腮,网课老师反复拖动着几何画板的动态演示,电商设计师在商品详情...

批量图片元数据查看编辑器

在数字图像爆炸式增长的今天,无论是专业摄影师还是普通用户,都面临着海量图片的管理难题。隐藏在每张照片背...

批量删除重复文件工具

机箱指示灯在深夜高频闪烁,D盘标红的存储空间不断弹出警告弹窗——这是数字时代最常见的焦虑场景。重复文件如...

PyCharm社区版

在Python开发领域,选择一款趁手的集成开发环境(IDE)能显著提升编码效率。JetBrains推出的PyCharm社区版凭借其开源免...

抖音短视频热门标签统计工具

在短视频内容井喷的时代,抖音平台每天涌现的海量标签中,如何精准捕捉流量趋势,成为创作者和品牌方的核心诉...

基于Requests的股票价格实时监控工具

上海陆家嘴某私募基金交易员李明习惯性按下F5刷新行情页面,屏幕右下角突然弹出的红色弹窗引起他的注意——自研...

支持代理的跨子网文件传输工具

企业级网络环境中,跨子网文件传输的需求正以每年23%的速度递增。医疗机构的影像数据归档、制造企业的产线日志...

简易区块链哈希生成演示器

互联网档案馆的某个角落躺着这样一条用户评论:"学区块链两年,直到看到哈希值动态生成的过程,才真正理解什么...

合同到期预警与续签管理工具

随着企业经营复杂度提升,合同生命周期管理逐渐成为法务、行政及业务部门的核心痛点。合同到期预警与续签管理...

系统环境变量快速编辑工具

对于开发者或系统管理员而言,配置环境变量是绕不开的高频操作。无论是调试Python项目时需要精准定位第三方库路...

多平台账号注册自动化测试工具

在数字化场景日益复杂的今天,企业及开发者常面临多平台账号批量注册与管理的效率难题。传统人工操作不仅耗时...

Python+SQLite构建的简易论坛系统

打开代码编辑器,新建一个forum.db文件——这便是构建轻量级论坛的起点。Python与SQLite的组合如同现代木匠手中的凿子...