基于Python的Excel数据清洗助手

点击保存键前突然弹出的格式错误提示,导入系统时频繁报错的日期字段,核对数据时发现的重复行——这些场景几乎每天都在折磨着数据处理人员。某金融机构的数据分析师曾透露,他们团队每周要花12个小时专门处理电子表格的格式问题。当Python遇上Excel,一套开源工具链正在改变这种低效的工作模式。

在数据清洗领域,Pandas库的DataFrame结构堪称处理二维表格的利器。通过read_excel函数读取文件后,df.drop_duplicates能快速消除重复记录,df.fillna可智能填补缺失值。这些基础操作看似简单,但配合条件判断和链式调用,能在三行代码内完成传统手动操作半小时的工作量。

格式混乱的日期字段常是数据清洗的"重灾区"。某电商平台的技术团队分享过真实案例:他们用dateutil库的parser模块,成功将采购表中"2023年12月1日"、"01-Dec-2023"等七种不同格式的日期统一为ISO标准格式。这种自动识别能力,让处理30000行订单数据的时间从三天压缩到两小时。

数据校验环节往往需要定制化规则。Openpyxl库提供了单元格级别的精细控制,配合正则表达式模块,可以构建专属校验体系。某医疗机构的病案管理系统就设置了这样的规则:身份证字段必须满足18位校验规则,检验数值不能超出医学参考范围,这些检查在数据入库前自动完成。

当遇到超百万行的大文件时,传统的Excel操作界面常会卡顿崩溃。Dask库的并行处理能力可将数据分块读取,某物流公司的运单处理系统利用这个特性,把20GB的运输记录清洗时间控制在15分钟内完成。处理过程中的内存占用始终稳定在4GB以下,这对普通办公电脑来说完全可承受。

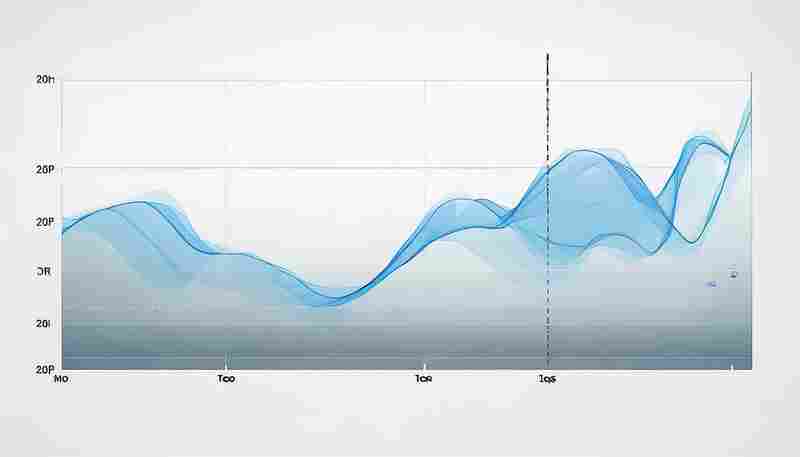

数据可视化监控是清洗过程中容易被忽视的环节。借助Matplotlib的绘图功能,可以在清洗流水线中插入数据分布图。某市场研究公司通过这种方式,在删除异常值时同步生成数据分布变化对比图,确保清洗动作不会扭曲原始数据的统计特征。这种可视化验证机制,使他们的数据质量合格率提升了40%。

清洗完成的数据回写同样存在技术细节。使用ExcelWriter保存文件时,设置encoding='utf-8-sig'能避免中文乱码问题,datetime_format参数可确保日期字段在Excel中正确显示为日期类型而非文本。这些细节处理,让清洗后的表格能无缝对接其他业务系统。

在开源社区活跃的今天,Jupyter Notebook里逐渐积累起各种数据清洗模板。某快消品企业的数据分析部建立了包含27个常用清洗场景的代码库,新员工入职即可调用现成方案处理80%的表格问题。这种知识沉淀机制,让团队效率产生了复利式增长。

当Python脚本与Windows任务计划程序结合,定时自动清洗成为可能。某制造企业的设备巡检报表,每天凌晨自动完成数据规整,上班时工程师打开邮箱就能收到标准格式的报表。这种自动化处理,每年为该企业节省了超过600个人工时。

工具的进化永无止境。Polars库凭借Rust语言的高性能优势,正在成为处理海量Excel数据的新选择。xlwings库则打通了Python与Excel的实时交互通道,让脚本运行和界面操作可以自由切换。技术演进带来的可能性,持续重塑着数据处理的效率边界。

相关软件推荐

基于Python的简易HTTP服务器搭建工具

发布日期: 2025-04-10 11:15:28

命令行窗口弹出黑色背景,光标闪烁的瞬间,许多开发者会本能地敲下`python -m http.se...

Python+Django实现的个人博客系统工具

发布日期: 2025-03-27 18:52:02

当开发者需要搭建个人博客时,Python+Django的组合正成为越来越多技术从业者的选择。这...

随机软件推荐

健身房设备使用频率统计工具

现代健身房常面临设备资源分配难题——热门器械高峰时段排队严重,冷门设备长期闲置造成资源浪费。某科技公司...

使用QRCode库生成的二维码制作工具

扫码支付、信息传递、广告投放——二维码早已渗透现代生活的各个角落。面对多样化的应用场景,如何快速生成功...

定时关机助手(自定义倒计时设置)

电脑右下角突然弹出"系统即将更新"的提示时,正在渲染视频的设计师后背瞬间冒汗;游戏更新进度卡在99%的深夜,眼...

SFTP文件自动编码检测转换工具

传输文件时遭遇乱码困扰,几乎是所有跨国协作团队或跨系统开发者的共同痛点。某互联网公司运维部曾因日文版订...

监控指定文件夹变化自动触发备份的程序

办公电脑突然蓝屏的瞬间,设计师张明手心沁出了冷汗——项目方案文档刚完成最后修改还没来得及保存。这种场景...

桌面文件自动备份工具(定时同步)

场景痛点与解决方案 日常办公场景中,桌面文件误删、系统崩溃导致数据丢失的情况时有发生。某互联网公司测试部...

启动项注册表虚拟化检测器

在Windows系统管理中,启动项注册表始终是安全攻防的必争之地。随着恶意软件逐渐采用注册表虚拟化技术绕过传统防...

视频转GIF制作工具(截取片段生成动图)

刷短视频时遇到想保存的魔性片段?聊天对话框急需新鲜表情包救场?一款轻量化视频转GIF工具正成为内容创作者的...

批量合并PDF文档工具(PyPDF2库应用)

日常工作中频繁遇到多份PDF文档需要整合的场景。合同归档时需合并签字页与附件,学术论文提交要求整合正文与图...

文件编码格式批量检测重命名工具

在日常办公或跨平台协作时,文件编码格式差异导致的乱码问题困扰着许多用户。例如,从Windows系统向MacOS传输文件...

PDF转文本定时批量处理器

纸质文档电子化浪潮中,PDF文件因其跨平台特性成为主流格式。但海量PDF文档的文本提取需求,让传统单文件处理模...

TXT文件编码检测与转换工具(自动识别BOM头)

日常办公中打开TXT文档时,突然跳出的乱码常让人手足无措。不同系统默认的编码格式差异、跨平台传输导致的字符...

键盘按键测试可视化工具

键盘作为人机交互的核心设备,其按键状态直接影响用户体验。一款专业的键盘按键测试可视化工具能够帮助用户快...

桌面便利贴工具(支持颜色标记)

办公桌前的显示器边缘总贴着五颜六色的便利贴,这个场景在数字化时代有了新注解。当纸质便利贴遇上电子化浪潮...

网络配置自动优化建议生成器

在数字化转型浪潮下,企业网络架构复杂度持续攀升。面对多分支组网、混合云部署以及动态流量调度等场景,传统...

cx_Freeze多平台打包工具

对于Python开发者而言,如何将代码转化为可独立运行的应用程序始终是个痛点。cx_Freeze作为一款开源工具,凭借其轻...

简易论坛热词词云生成器

在信息爆炸的时代,论坛、贴吧等社区平台每天产生海量讨论内容。如何从繁杂的文本中快速提取核心话题?一款名...

多格式电子书内容关键词批量提取工具

随着电子书市场的爆发式增长,编辑、学术研究者和内容创作者常面临一个共同难题:如何从海量电子书中快速定位...

网页内容自动简繁转换工具

在互联网信息爆炸的时代,跨越简繁体中文的阅读障碍始终存在。据统计,全球使用繁体中文的网民超过1.2亿,而支...

环境变量管理工具(增删改查系统变量)

在Windows操作系统中,系统环境变量如同数字世界的神经中枢。开发人员搭建Python运行环境时,PATH变量的配置决定了命...

自动化构建产物校验系统

开发团队常面临这样的困境:某次版本更新后,测试环境运行正常的代码在线上突然崩溃。经排查发现,构建环节的...

文件夹加密与伪装工具(伪系统目录)

在数字资产价值飙升的时代,加密技术正经历着从"保险箱模式"向"隐形斗篷模式"的进化。传统的文件夹加密技术如同...

系统启动时间记录分析器

现代操作系统的启动过程涉及数百个服务与进程的协同工作,但用户往往只能感知到进度条或转圈动画。当系统启动...

简易数据库查询结果导出助手

办公区键盘敲击声此起彼伏,开发工程师李明盯着屏幕上成片的SQL查询结果,第3次尝试将两万条订单数据导出为可视...

用户行为日志热力图可视化分析工具

在互联网产品运营领域,海量用户行为日志往往堆积在服务器中难以有效利用。某科技团队研发的用户行为日志热力...

自动截图分类保存工具

在数字化办公逐渐普及的当下,电脑屏幕里堆积如山的截图成为困扰多数人的难题。会议纪要、操作流程、灵感素材...

网站重定向链分析检测器

在互联网生态中,重定向技术广泛应用于流量分发、广告追踪或页面跳转优化,但复杂的重定向链也暗藏风险——加...

智能键盘快捷键自定义配置工具

在数字办公逐渐普及的当下,键盘快捷键早已成为提升生产力的关键工具。市面上的软件快捷键设计往往基于通用逻...

支持模板的文档批量生成器

在信息处理效率至上的数字化环境中,企业常面临大量重复性文档的编写需求。传统的手动编辑不仅耗时耗力,还容...

抖音音乐榜单爬虫与播放量统计工具

随着短视频平台的爆发式增长,抖音已成为音乐传播的核心阵地。其音乐榜单不仅反映流行趋势,更直接影响音乐人...

测试结果可视化图表生成工具

软件测试领域每天产生海量数据,传统的Excel表格与文字报告已无法满足快速分析需求。某款创新型可视化工具通过智...

多用户协作式在线日历

现代职场中,时间管理效率直接影响团队生产力。传统日历工具常因信息孤岛、更新延迟等问题导致协作障碍,而多...

RSS新闻聚合阅读器(定时更新)

在社交媒体推送与算法推荐主导信息获取的今天,一个诞生于互联网早期的技术工具正在重新进入大众视野。RSS(简...

利用numpy的矩阵运算快速计算工具

在Python科学计算领域,NumPy库的矩阵运算功能犹如一柄精准的手术刀。当处理十万级数据表格时,传统循环结构需要...

软件许可证声明批量插入工具

在软件开发过程中,为代码文件添加统一的许可证声明是一项基础但繁琐的任务。尤其当项目涉及成百上千个文件时...

文件夹内容树状结构生成器(输出为TXT)

办公桌面上散落着十几个未命名的文件夹,程序员望着显示器揉着太阳穴——项目文件已呈失控状态。这种场景催生...

批量图片压缩工具(支持调整分辨率与质量)

手机内存不足的红色警告,网站上传失败的报错提示,工作群文件超限的尴尬提醒——数字时代的海量图片需求背后...

基于钉钉机器人的CDN缓存刷新结果通知工具

在互联网业务高速发展的当下,CDN缓存刷新效率直接影响用户体验与业务稳定性。传统的刷新结果通知方式往往依赖...

Excel数据合并工具(多表格VLOOKUP)

在数据分析场景中,跨表格匹配信息是高频刚需。某连锁企业市场部曾因手动核对200家门店的销售数据,导致季度报...

内存清理助手(手动释放缓存工具)

手机弹出"存储空间不足"的提示时,不少人会本能地点开清理软件。但面对自动清理工具力不从心的场景,手动释放缓...