指定深度的知乎问答数据爬虫脚本

在信息爆炸的时代,知乎作为高质量内容社区,汇聚了大量专业讨论与观点碰撞。针对研究人员、产品经理或内容创作者而言,高效获取结构化数据成为刚需。本文探讨一款基于Python开发的知乎问答定向爬虫工具,重点分析其设计逻辑与应用场景。

工具定位与核心功能

该工具专注于按主题关键词或用户ID抓取指定深度的问答数据,支持多层评论展开及用户互动信息提取。相较于通用爬虫,其优势在于灵活配置采集深度,例如设定仅抓取回答前50赞的评论,或追踪某话题下三个月内的更新内容。数据输出格式包含JSON与CSV,可直接用于舆情分析或知识图谱构建。

技术实现关键点

工具采用异步请求库(如aiohttp)提升采集效率,通过模拟登录绕过部分反爬限制。针对知乎动态加载内容,利用Selenium与API反向解析结合的策略:先通过浏览器自动化触发页面加载,再解析接口数据减少资源消耗。数据清洗模块内置正则表达式模板,可自动过滤广告内容与重复回答。

风险规避与考量

高频访问易触发反爬机制,工具提供自动代理IP切换及请求间隔随机化功能。开发者强调遵守Robots协议,默认采集频率限制为每秒1次,且支持排除匿名用户数据。建议使用者遵循《网络安全法》,避免用于商业爬取或侵犯隐私场景。

典型应用案例

某社科团队曾借助该工具分析“职场性别歧视”话题下十年间的回答演变,发现早期讨论聚焦个体遭遇,近年转向制度批判,为研究提供了定量支撑。另一案例中,自媒体运营者通过抓取高赞回答的热词,优化了内容创作方向。

数据采集仅是起点,如何从海量文本中提炼价值,仍需结合人工研判。技术中立,但使用者的目标决定了工具的意义边界。

- 上一篇:指定文件夹内重复文件名自动检测与标记工具

- 下一篇:指定目录文件类型统计分析工具

相关软件推荐

简易网络爬虫(指定站点抓取)

发布日期: 2025-04-05 13:55:36

当我们需要快速获取特定网站公开数据时,基于Python的Requests+BeautifulSoup组合已成为技术...

随机软件推荐

动态二维码生成器(支持自定义LOGO插入)

传统黑白二维码早已无法满足商业场景的视觉需求。某科技团队开发的动态二维码生成器,通过可变色域与动画效果...

DHCP协议分配记录跟踪工具

在局域网管理中,DHCP协议作为IP地址自动分配的核心技术,极大简化了网络配置流程。当出现地址冲突、终端设备异...

网络设备存活状态检测工具

网络设备存活状态检测工具作为IT运维领域的"听诊器",其核心价值在于实时掌握网络设备的运行状态。这类工具通过...

剪贴板历史管理器(支持搜索与快捷粘贴)

对于频繁处理文本信息的人来说,"复制粘贴"几乎是每天点击最多的操作。但系统自带的剪贴板往往只能保存最后一次...

计算机硬件参数监控仪表盘

在数据中心运维室的主控屏幕上,六块弧形液晶屏拼接成270度环幕,实时跳动的数字与折线图构成科技感十足的视觉...

校园餐厅特色菜供应提醒应用

食堂的糖醋排骨每周二限量供应,炸鲜奶只有周四中午出现,麻辣香锅档口经常排起长队……对于高校学生来说,错...

自动化文件内容脱敏处理工具

企业日常运营中,财务报告、等敏感文件频繁流转于各部门之间。某金融机构曾因员工误发未处理合同副本,导致客...

农历日历与节日提醒工具

窗台上的台历翻到腊月二十三,厨房飘来糖瓜的甜香,李奶奶眯着眼核对手机上的提醒——"明日小年,祭灶扫尘"。这...

多显示器色彩校准同步工具

在数字影像创作领域,显示器之间的色彩偏差常成为困扰设计师、视频剪辑师的核心痛点。当两台相邻的显示器呈现...

桌面便利贴管理系统

办公桌上五颜六色的便利贴,记录着会议要点、待办事项或创意灵感,却总在关键时刻消失不见。数字化浪潮下,桌...

自动删除无效备份版本工具

数据备份是保障信息安全的重要手段,但长期积累的备份文件常带来存储资源浪费、管理成本攀升等问题。某技术团...

自动生成数据可视化报告

在数字化浪潮推动下,数据可视化工具正经历革命性升级。近期面世的DataVision Pro软件,凭借其独特的自动化报告生成...

CSV与Excel表格数据互转批量处理工具

在金融分析师林悦的办公桌上,三台显示器同时闪烁着不同格式的表格文件。这个场景折射出企业数据处理中的典型...

简易RSS阅读器(文章摘要抓取与分类)

当代互联网的信息爆炸让高效阅读成为刚需。一款名为FeedMaster的轻量级RSS阅读工具,通过独特的智能抓取与分类系统...

批量处理图片EXIF信息工具(GPS清除)

智能手机与数码相机的普及让影像记录变得触手可及,但隐藏在每张照片里的EXIF元数据正成为隐私泄露的隐形通道。...

本地文件搜索工具(支持多关键词检索)

办公室电脑存储着三万份文档的设计师小王,曾因找不到半年前的投标方案险些错过项目截点。类似场景在信息爆炸...

批量调整图片分辨率工具(指定长宽-比例)

在数字内容创作中,图片分辨率调整是高频需求。无论是网站优化、印刷排版还是社交媒体适配,不同场景对图片尺...

电影评分数据聚合分析器

在信息爆炸的影视市场中,一部电影的口碑往往分散在数十个评分平台与社交媒体的角落。某款名为CinemaScore Pro的电...

自动分类压缩文件的ZIP-RA件管理器

日常工作中,堆积如山的ZIP/RA件往往令人头疼。解压后散落各处的文档、混杂的图片视频、重复的压缩包版本,让文...

视频GIF片段制作工具

在社交媒体聊天时突然词穷?一段魔性GIF往往能拯救尴尬局面。随着短视频内容爆发式增长,将视频精彩片段转化为...

简易论坛内容抓取分析工具

互联网论坛作为信息沉淀的重要载体,每天产生海量用户讨论数据。针对这一场景开发的简易论坛内容抓取分析工具...

自动化Excel报表生成工具(模板数据填充)

在日常办公场景中,Excel报表的重复性制作常被视为效率瓶颈。财务人员需要反复核对数据模板,销售团队每周手动更...

抖音视频信息爬取分析工具

随着短视频内容生态的爆发式增长,抖音平台沉淀的海量视频数据逐渐成为品牌运营、学术研究及内容创作的重要参...

CSV实验数据按分钟粒度统计器

在工业监控、环境监测等场景中,高频采集的实验数据常以CSV格式存储。某开源数据处理工具近期推出的分钟级统计...

单词本记忆卡片系统(艾宾浩斯复习算法)

翻开单词本时,那些似曾相识的字母组合总让人陷入纠结——昨天刚背过的词汇,今天却像从未见过。这种遗忘困境...

实时日志流关键词监控仪表盘

数据中心机房的警报声骤然响起,某电商平台的交易成功率曲线突然下跌两个百分点。运维团队打开监控仪表盘,红...

办公文档段落自动对齐优化工具

在数字化办公场景中,文档格式混乱始终困扰着职场群体。尤其当多人协作编辑同一份文件时,段落缩进不一、间距...

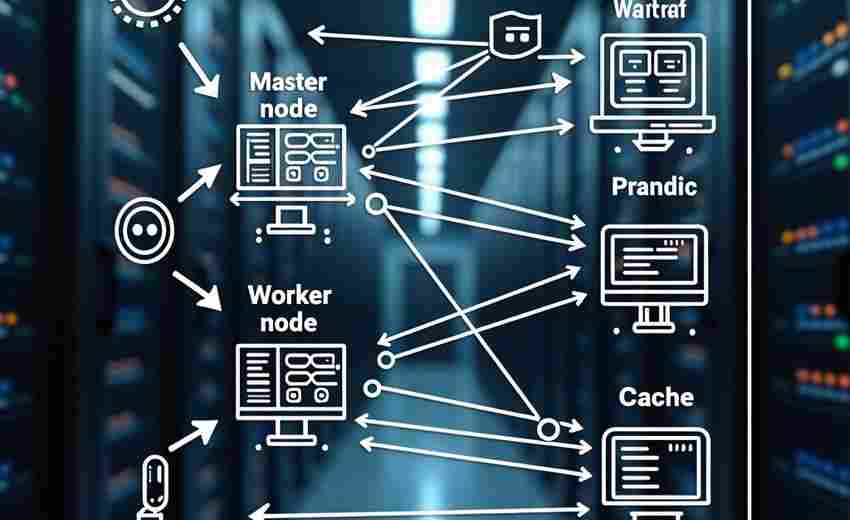

应用程序依赖关系分析工具

在软件工程领域,项目规模的膨胀往往伴随着依赖关系的复杂化。一个中型微服务系统可能包含数百个组件,依赖库...

窗口化农历-公历双向转换工具

农历七月初七和公历8月10日哪个先到?老一辈坚持要过"真正的生辰",年轻人盯着手机日历犯难。当传统历法遇上现代...

基于Socket的多人在线井字棋游戏

井字棋作为规则简单的经典游戏,天然适配在线多人对战场景。基于Socket通信技术实现的多人对战框架,为开发者提...

简易防火墙规则生成器(iptables封装)

在Linux服务器管理领域,iptables始终是网络安全的基础防线。这个存在了二十多年的工具链至今仍在生产环境中广泛使...

自动卸载软件残留文件清理助手

日常使用电脑时,用户总会遇到一个普遍痛点:明明已经卸载了软件,硬盘空间却迟迟未见释放。注册表冗余、临时...

电子邮件附件智能压缩管理器

在深圳某跨境电商公司的办公室里,行政主管李薇正盯着电脑屏幕皱眉——季度财报的PPT因包含大量图表导致附件体...

屏幕颜色拾取器(坐标定位版)

在数字设计领域,色彩的精准捕捉直接影响作品的专业性。屏幕颜色拾取器(坐标定位版)凭借其坐标定位功能,成...

简易多线程文件下载器

互联网时代,用户对于大文件传输的需求持续增长。单线程下载工具常因速度慢、稳定性差被诟病,而专业级下载软...

YouTube视频评论情感分析辅助爬虫

随着全球视频创作者数量突破5000万,YouTube平台日均新增评论量超过20亿条。面对海量的用户反馈数据,传统人工分析...

命令行计算器(支持单位换算和科学计算)

打开终端窗口,输入一行代码就能完成复杂算式、单位换算甚至汇率转换——对于程序员、工程师或科研人员而言,...

简易电子商务商品管理系统

打开笔记本电脑,某淘宝店主陈婷正在核对库存数据。三天前新上的春装套装突然冲上店铺热销榜,但后台显示的库...

自动生成数学题练习器(四则运算)

数学基础能力的巩固离不开大量练习,而传统人工出题效率低、题型重复率高的问题长期困扰学生与教师群体。一款...

简易电子表格工具(CSV数据编辑)

在需要快速处理结构化数据的场景中,Excel这类专业软件常显得笨重。当面对需要跨平台协作、代码对接或临时数据清...