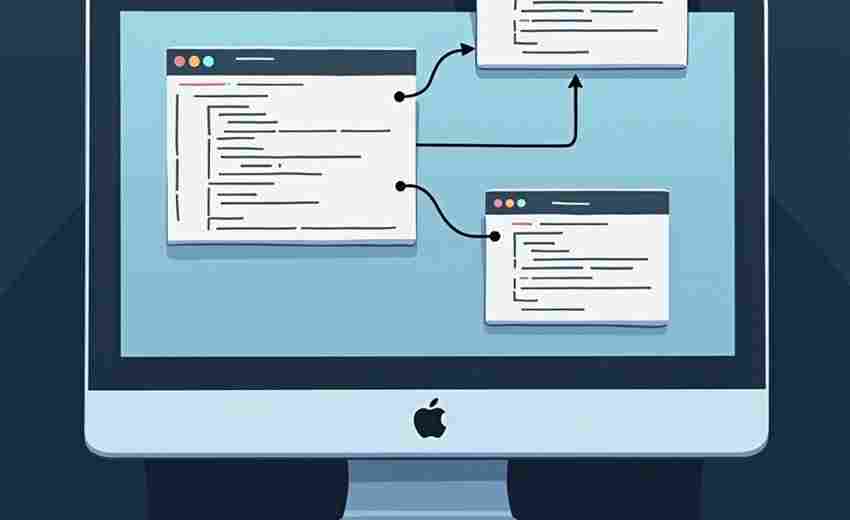

简易多线程网页爬虫采集工具

互联网时代的数据采集需求持续增长,一款名为QuickCrawler的轻量化工具近期在开发者社区引发热议。这款基于Python语言开发的开源爬虫框架,凭借其独特的多线程设计与极简操作逻辑,成为中小规模数据抓取场景中的新晋利器。

核心功能锚定效率痛点

QuickCrawler最突出的特征体现在线程池的动态调控机制。不同于传统爬虫固定线程数的设计,该工具能够根据目标网站的响应速度自动调整并发数量。实测数据显示,在访问电商类网站时,工具可将平均采集速度提升3-5倍,同时将CPU占用率控制在35%以下。这种智能调节既避免了因过量请求触发反爬机制,又最大限度压榨了硬件性能。

异常处理模块展现出实用主义设计理念。面对403禁止访问或验证码拦截时,系统不是简单终止任务,而是自动切换备用User-Agent,并激活内置的代理IP池进行重试。开发团队在GitHub文档中透露,其重试策略采用指数退避算法,有效规避了连续失败请求引起的IP封禁风险。

配置门槛颠覆行业认知

工具的学习曲线显著低于同类产品。基础爬虫任务仅需配置目标URL和XPath路径,复杂场景支持加载Lua脚本扩展功能。某科技论坛用户反馈,参照官方示例代码,20分钟内就完成了新闻网站的定时采集设置。这种低代码特性使其在非专业开发者群体中快速普及。

数据导出环节摒弃了繁琐的参数设置,提供CSV、JSON、MySQL三种存储模式的一键切换。特别开发的断点续传功能,在应对百万级数据抓取时表现优异。当网络波动或程序异常中断后,重启时可自动读取进度文件,避免重复劳动。

潜在瓶颈与适配场景

需要客观指出的是,工具的异步IO模型在极端高并发场景下存在性能天花板。测试数据显示,当单机并发线程超过200时,内存占用会呈现指数级增长。这决定了其更适合中小型数据采集项目,超大规模分布式爬取仍需配合专业级解决方案。

法律合规方面,工具虽然内置了请求间隔随机化等反侦察功能,但开发者仍需自觉遵守robots协议。今年某企业就曾因使用类似工具过度采集商业数据引发法律纠纷,这提醒使用者必须把控数据抓取的道德边界。

- 上一篇:简易多线程文件批量重命名工具

- 下一篇:简易天气信息API查询工具

相关软件推荐

随机软件推荐

词频统计工具(分析文本文件中的单词频率)

在信息爆炸的数字时代,文字工作者常常需要面对海量文本处理需求。某款自主研发的词频统计工具凭借其独特功能...

会议纪要自动模板生成器(时间-参会人记录)

一场两小时的部门例会结束后,行政专员张婷对着录音笔和潦草的笔记皱起眉头。整理会议时间轴需要反复核对录音...

多显示器环境自适应取色器

在纽约某广告公司的开放式办公室里,资深设计师Emily对着三块不同型号的显示器皱起眉头。她的MacBook Pro连接着专业...

批量音频文件元数据编辑器

音乐收藏量突破四位数后,手动整理音频信息逐渐成为折磨。某位独立音乐人曾自嘲,为三百首原创作品添加专辑信...

办公文档密码移除工具

在日常工作中,加密文档因密码遗忘或交接疏漏导致无法访问的情况时有发生。针对这一痛点,市面上出现了多款专...

基于正则表达式的会议记录时间点标注提取工具

会议记录的时间点标注是提升信息检索效率的关键环节,但在实际工作中常因文本格式混乱导致效率低下。某开发团...

数据热编码转换工具

数据热编码转换工具作为机器学习预处理环节的重要助手,正被越来越多数据分析师纳入技术栈。当原始数据中存在...

工业传感器数据转Excel预测分析工具

在工业制造领域,传感器实时采集的温湿度、压力、振动等数据是生产优化的核心依据。面对海量、碎片化的原始数...

电子书合并工具(多文件拼接为单一文件)

纸质书时代,读者习惯用便签记录零散知识点。而在电子阅读时代,用户更希望将分散的文档资料整合为系统性文件...

窗口标题自动翻译工具(调用翻译API)

在全球化的工作场景中,跨语言操作软件已成为许多人的日常。面对英文软件界面或外语文件标题时,反复查词典或...

简易计算器带历史记录功能(GUI版)

在数字化办公场景中,一款兼具基础运算与历史追溯功能的计算器,往往能大幅提升工作效率。近期上线的 简易计算...

博物馆藏品信息批量导出工具

数字化浪潮席卷全球博物馆行业,数据管理效率成为衡量机构现代化水平的重要指标。面对动辄数万件的藏品信息,...

多层级电影评分网站数据抓取脚本

在影视行业数据研究领域,获取多平台评分数据常面临技术门槛。某开源社区近期发布的专业级数据采集工具,通过...

PDF转TXT正则过滤工具

在日常办公或学术研究中,PDF与TXT格式的转换是高频需求。PDF文件因其稳定性被广泛使用,但直接提取文本时,常面...

密码生成日志审计追踪系统

在数字化安全管理领域,密码生成与日志审计的结合正成为企业防御内部风险的关键手段。传统模式下,密码管理与...

系统服务进程管理器可视化界面

在计算机系统管理中,服务进程的监控与调度直接影响着设备运行的稳定性。传统命令行工具虽功能强大,但对非专...

自动生成报告工具(文本-表格)

数据爆炸时代催生了大量文本与表格处理需求。一款名为SmartReporter的智能报告生成工具近期引发市场关注,该软件通...

系统资源占用周报自动生成工具

在复杂的IT运维场景中,服务器、数据库及各类应用的资源监控一直是团队的核心工作。传统模式下,运维人员需手动...

Python进程内存泄漏检测工具

在Python开发过程中,最让工程师头疼的问题莫过于内存泄漏。笔者曾参与维护过一个Django项目,在线上运行三个月后...

系统USB设备连接历史追踪器

Windows操作系统在每次接入USB设备时,都会在注册表路径"HKEY_LOCAL_MACHINESYSTEMCurrentControlSetEnumUSB"生成记录数据。这些看...

利用os模块的文件夹大小统计工具

日常开发中常会遇到需要统计文件夹体积的需求。无论是清理磁盘冗余数据,还是分析项目文件分布,快速获取目录...

li网站Cookie管理器工具-li

互联网时代,网站Cookie几乎无处不在。用户访问电商平台时,首页自动推荐昨天浏览过的商品;登录社交媒体账号时...

社交媒体帖子情感倾向分析器

社交媒体平台每天产生海量用户生成内容,如何快速捕捉这些信息背后的情绪价值,成为企业市场洞察的关键突破点...

简易绘图板GUI工具(鼠标绘制图形)

绘图板主界面采用极简设计,左侧垂直排列着八种基础图形工具。圆形与矩形工具的边角处隐藏着进阶选项——长按...

命令行米-千米长度即时换算器

对于经常与数据打交道的工程师或科研人员来说,单位换算如同呼吸般自然却极易出错。在Linux/macOS环境下,一款名为...

多语种电子书格式转换器(EPUB-MOBI)

数字阅读时代,电子书格式的兼容性问题一直是读者和创作者的共同困扰。EPUB与MOBI作为主流格式,分别对应不同阅读...

文件夹自动备份工具(增量-定时备份)

凌晨三点的办公室灯光下,王工长按删除键时手抖了一下。五年积累的工程图纸在屏幕上瞬间消失,这个场景成为他...

京东商品评论情感分析数据采集器

京东商品评论情感分析数据采集器是一款聚焦电商场景的数据处理工具,主要服务于市场研究人员、品牌运营团队及...

文件空行自动删除脚本

办公桌上散落着十几个待处理的代码文件,老张盯着屏幕上密密麻麻的空白行叹气。这些文件来自不同开发人员,代...

简易HTTP请求日志记录代理服务器

请求参数为什么没传过去?""第三方接口返回的数据格式不对?"开发调试时,这类问题常让开发者抓狂。一个能完整...

配置项继承关系管理器

在软件开发与系统部署领域,配置管理始终是团队协作的痛点。某企业曾因三个环境共用的基础配置发生冲突,导致...

简易GIF动画制作工具(多帧图片合成与调速)

电脑屏幕上跳动着十几张旅游风景照,用户将图片批量拖入软件界面,调整好每帧停留时长。点击生成按钮后,原本...

使用FastAPI的RESTful接口服务

在Python生态中,当开发者需要构建高性能API服务时,FastAPI正成为越来越多技术团队的首选框架。这个基于Starlette和...

自定义规则文件分类归档助手

办公桌上堆叠的纸质文件令人头痛,电子设备里的无序文档同样消耗精力。当某位设计师在紧急项目中发现客户合同...

日志文件交互式命令行查询工具

凌晨三点的服务器告警响起,工程师在键盘上敲下第20次grep命令后,终于意识到传统的日志分析方式遇到了瓶颈。这...

图像拼图游戏(滑块拼图)

在维多利亚时代风靡欧洲的木质拼图玩具,如今已进化成数字时代的全民娱乐。图像拼图游戏凭借其独特的魅力,在...

图片ASCII艺术生成器(终端显示版本)

在黑白字符构筑的终端世界里,ASCII艺术生成器像一台复古打印机,将图片、LOGO甚至视频帧转化为由字母、符号组成...

网络流量协议类型分布可视化工具

互联网环境中每台设备每秒都在产生海量数据流,不同协议类型的数据包如同血管中的红细胞持续流动。某款网络流...

自动截屏拼接全景图工具

滚动截屏功能早已普及,但遇到超长网页或聊天记录时,传统分段截屏需要人工拼接,常出现错位、重复或漏页问题...

简易收支记录工具(按支出类型和月份分类)

打开手机应用商店搜索"收支管理",跳出的上百个应用让人瞬间犯起选择困难症。真正实用的工具往往不需要复杂功能...