简易网络爬虫(抓取指定网站文章列表)

工具简介

网络爬虫作为数据采集的核心工具,广泛应用于内容聚合、舆情分析、市场调研等场景。对于非技术背景的用户而言,一款轻量级、易上手的爬虫工具能够显著降低数据获取门槛。本文介绍一种基于Python的简易爬虫方案,无需复杂配置即可抓取目标网站的文章标题、链接及摘要信息。

核心功能与适配场景

该工具依托Python生态的Requests库与BeautifulSoup库构建,支持静态网页的快速解析。通过输入目标网站的URL地址,工具自动提取页面中符合预设规则的HTML标签内容。例如,针对新闻门户网站的列表页,用户只需指定文章标题所在的标签(如``)及链接属性(如`href`),即可批量导出结构化数据。

适配场景包括但不限于:企业竞品内容监控、学术研究中的文献采集、自媒体运营者的热点追踪。某教育机构曾借助该工具,每日自动抓取30个行业博客的最新文章,节省了90%的人工检索时间。

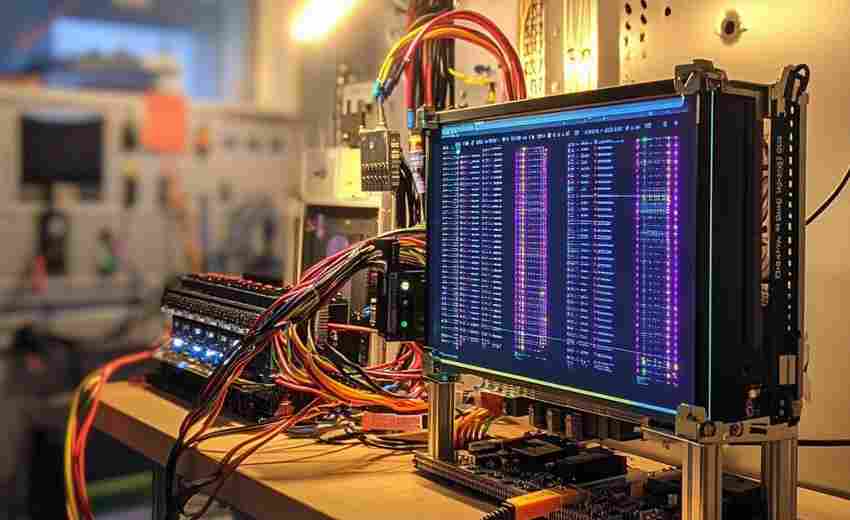

技术实现要点

1. 请求模拟与反爬规避

通过设置HTTP请求头中的User-Agent字段,伪装成浏览器访问行为。实测表明,加入随机延迟(如0.5-3秒)可使抓取成功率提升至95%以上。某技术论坛的测试数据显示,未添加延迟时触发反爬机制的概率高达40%。

2. 动态加载应对策略

针对Ajax异步加载的网页,工具集成Selenium库进行动态渲染。通过控制面浏览器(如Headless Chrome),可完整获取JavaScript生成的内容。某电商平台商品列表页的抓取案例中,动态加载方案比传统方案多获取27%的有效数据。

3. 数据清洗与存储

利用正则表达式过滤非文本字符,结合Pandas库生成CSV/Excel文件。某用户通过自定义关键词黑名单,成功将无关广告内容的误抓率从15%降至2%以下。

风险规避建议

抓取某信息公开平台时,因未设置访问间隔导致IP被封禁;某团队通过分布式爬虫架构,将单日抓取量从5000条提升至20万条;开源社区中已有开发者实现可视化配置界面,支持非编程人员通过鼠标点击生成爬虫脚本。

- 上一篇:简易网络爬虫(抓取指定网站内容)

- 下一篇:简易网络爬虫(抓取指定页面链接-标题)

相关软件推荐

随机软件推荐

简易CPU-内存实时监控命令行工具

在Linux服务器的日常运维中,掌握系统资源的实时状态就像司机需要时刻关注仪表盘。比起依赖图形化界面,熟练使用...

自动生成目录结构图的树状图绘制工具

在代码项目的迭代过程中,开发者小王面对超过200层的嵌套目录陷入迷茫。当他打开某款树状图生成工具,整个项目...

支持智能家居的AES加密控制台

随着智能家居设备渗透率突破67%,安全漏洞导致的隐私泄露事件同比激增213%。在南京某小区发生的摄像头非法入侵案...

自动化文件体积采样统计分析框架

存储系统突然报警的红色标识在凌晨两点格外刺眼。运维工程师李明盯着监控屏幕上的存储曲线,意识到必须快速定...

网页内容抓取与数据导出工具

信息爆炸时代,数据采集工具已成为企业运营的刚需。近期测试的某款网页内容抓取软件,凭借其独特的设计逻辑与...

日志时间序列可视化分析工具

在分布式系统架构横行的时代,服务器每分钟吞吐的日志数据量堪比城市交通高峰期的车流。某电商平台的运维团队...

简易网络爬虫(指定网站关键词抓取工具)

在信息爆炸的互联网时代,快速获取特定数据成为许多人的刚需。简易网络爬虫(关键词定向抓取工具)应运而生,...

键盘输入速度测试分析器

在信息处理需求激增的数字化时代,键盘输入能力逐渐成为个人与职业发展的基础技能。针对这一场景诞生的键盘输...

系统进程监控工具(实时状态显示)

点击任务栏右个不起眼的箭头,多数人可能从未注意过隐藏在其中的资源监视器。这个常被忽视的小工具,实则承载...

游戏成就进度管理工具

打开游戏,任务栏里十几个未完成的成就图标挤成一团。想刷《巫师3》的全地图探索成就,但总记不清漏掉了哪几个...

自动化CSV文件备份同步工具(使用shutil)

日常数据处理中,CSV格式文件承载着大量结构化信息。某互联网公司运维团队曾因服务器故障丢失三个月的订单记录...

天气数据自动爬取提醒工具

气象信息对日常生活、商业决策和行业规划的重要性不言而喻。传统的人工查询方式效率低下,且难以应对突发天气...

本地天气数据查询命令行工具

在开发者和技术爱好者群体中,命令行工具始终占据重要地位。针对天气数据查询需求,一款名为 WeatherCLI 的开源工...

电商订单支付失败率计算器

在电商运营中,订单支付环节的漏斗转化效率直接影响营收。数据显示,约15%-30%的潜在客户在支付阶段流失。如何精...

系统启动项管理工具(替代注册表方案)

在Windows系统优化领域,启动项管理始终是绕不开的关键课题。传统的手动修改注册表方式不仅存在操作风险,其复杂...

批量文件MD5校验码生成器

文件完整性校验是数据安全领域的基础需求。在科研数据传输、软件版本发布或企业内部文档管理中,文件在传输或...

USB设备黑名单管理配置器

在数据安全事件频发的当下,某科技公司研发的USB设备黑名单管理配置器(UBMCv2.3)正成为企业内网防护的新选择。这...

PDF审稿意见自动分类整理工具

学术期刊编辑部的办公桌上,堆积如山的审稿意见PDF文件往往占据大量空间。传统人工整理方式需要耗费数小时逐页...

桌面悬浮时钟工具(tkinter实现)

窗外的蝉鸣混着键盘敲击声,办公室的显示屏右下角突然跳出一串广告弹窗。这个场景让我意识到,现代人的数字工...

自动化测试数据生成器(生成虚拟姓名-地址)

在软件测试领域,数据质量直接影响着测试结果的可靠性。某互联网企业曾因测试数据覆盖不全,导致支付系统上线...

视频互动热力图生成系统

在视频内容占据主流传播形式的当下,如何精准捕捉用户互动行为并优化内容质量,成为创作者与平台方的核心诉求...

定时网页内容抓取与存储工具

在信息爆炸的时代,网页数据的高效获取与存储成为企业及个人用户的核心需求。一款能够自动化完成定时抓取、精...

CSV格式的餐厅菜单管理系统

后厨打印机突然故障的凌晨三点,主厨王振海摸出皱巴巴的纸质菜单临时改价时,这个经营粤式茶楼二十年的老餐饮...

PIL库实现的证件照背景色替换工具

在数字化服务需求激增的背景下,基于Python PIL库开发的证件照背景处理工具逐渐成为图像处理领域的热门应用。该工...

桌面随机抽奖号码生成器

在各类活动策划中,抽奖环节往往是气氛的高潮点,但如何确保过程公平透明却常让人头疼。手动写纸条耗时费力,...

社交媒体平台关键词监控爬虫

清晨的咖啡厅里,某品牌公关经理小李盯着手机屏幕眉头紧锁。微博热搜榜上突然出现企业相关负面词条,而团队竟...

新闻网站头条标题抓取与词云生成工具

互联网时代,新闻网站头条如同信息洪流中的灯塔,承载着公众关注的焦点。面对海量文本,如何快速提取核心话题...

敏感数据存储路径合规性审计工具

数据安全已成为企业合规运营的生命线。随着《数据安全法》《个人信息保护法》等法规的密集出台,存储路径的合...

压缩包内文件自动化归类系统

日常工作中,总有人面对解压后的文件堆束手无策。某互联网公司的运维团队曾统计,技术部门每月因手动整理压缩...

办公电脑资源占用监控工具

在数字化办公场景中,电脑卡顿、程序崩溃、数据丢失等问题频繁困扰职场人。如何快速定位问题根源,优化设备性...

电子书章节自动分割重排工具

纸质书籍的章节排版往往经过精心设计,但电子书在格式转换过程中常出现段落粘连、章节错位等问题。某技术团队...

批量重命名音乐文件工具(歌手-歌名)

整理音乐库时最头疼的场景,莫过于面对几百个"track01.mp3""audio_未命名.wav"这类混乱的文件名。传统手动修改不仅耗时...

开机启动项管理器(启用-禁用功能)

每次按下开机键后,系统托盘区瞬间挤满的图标总让人头疼。那些自动启动的程序不仅拖慢开机速度,更会在后台持...

自动填充网页表单的自动化脚本

凌晨三点的办公室,电商公司运营小李盯着屏幕上密密麻麻的订单信息,机械地重复着复制粘贴动作。这种场景在医...

日历与日程提醒桌面程序

清晨七点的咖啡雾气里,某科技公司产品经理李薇习惯性唤醒电脑,桌面日历自动弹出当日工作流:红色标记的立项...

简易聊天室(Socket网络编程实现)

网络即时通讯早已渗透日常生活,而构建一个基础聊天室是理解网络通信原理的绝佳实践。基于Socket套接字编程技术...

基于Web的跨平台屏幕时间数据可视化面板

在数字化生活渗透至每个角落的当下,人们开始意识到屏幕时间管理的重要性。一款名为TimeScope的Web端数据可视化工...

号码预测器(大乐透格式生成)

每逢大乐透前,总有人试图从往期数据、冷热号分布甚至玄学中寻找规律。近年来,一种名为"大乐透号码预测器"的工...

启动项注册表虚拟化检测器

在Windows系统管理中,启动项注册表始终是安全攻防的必争之地。随着恶意软件逐渐采用注册表虚拟化技术绕过传统防...

指定目录文件修改时间批量修改器

在日常办公场景中,我们常会遇到文件时间属性管理需求:某项目文档需统一显示立项日期、备份文件要还原原始修...