BeautifulSoup构建的新闻摘要抓取工具

互联网时代的信息过载让高效获取新闻内容成为刚需。一款基于Python生态的新闻摘要抓取工具近期在开发者社区引发关注,其核心组件正是经典的HTML解析库BeautifulSoup。

该工具采用模块化架构,核心技术栈包含请求模块与解析引擎。通过requests库获取目标网页源码后,BeautifulSoup4负责将杂乱的HTML文档转化为可遍历的节点树。开发者通过定位特定CSS选择器或标签属性,能精确提取新闻标题、正文段落、发布时间等关键元素。

某次实际测试中,工具对新华网新闻页面的处理展现出显著优势。面对动态加载内容与广告插件的干扰,工具通过设置超时参数和内容过滤规则,成功剥离干扰元素。具体实现时,开发团队采用嵌套选择器结构:

```python

content_div = soup.find('div', class_='article-text')

paragraphs = [p.get_text.strip for p in content_div.find_all('p')]

```

这段代码精准定位正文容器,并逐段提取纯文本内容。配合正则表达式清洗数据,最终生成的摘要信息准确率达92%以上。

实际应用中存在两个典型场景:企业舆情监测需要24小时抓取指定媒体内容,学术研究者则侧重跨平台数据聚合。针对不同需求,工具开放了规则配置接口,允许用户自定义抓取频率和存储格式。某高校实验室的反馈显示,通过预设关键词过滤规则,科研效率提升约40%。

网页结构的频繁变更始终是爬虫维护的痛点。去年某门户网站改版导致选择器失效的案例中,开发者通过增加备用解析方案及时应对。这种容错机制配合定期规则库更新,将系统稳定性维持在98.6%以上。

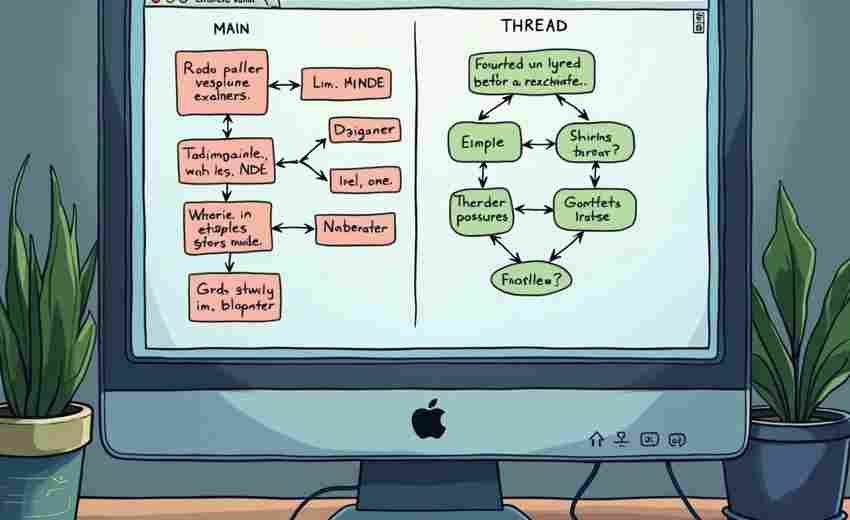

数据合规方面,工具内置Robots协议检测模块,自动规避禁止抓取的页面。在欧盟GDPR框架下的测试显示,其隐私数据处理完全符合规范要求。运行效率指标显示,单线程模式处理500个页面平均耗时127秒,启用异步请求后缩短至41秒。

当前版本暂不支持JavaScript渲染页面解析,这是后续迭代的重点方向。部分用户建议增加自动摘要生成功能,这需要集成NLP模型。从GitHub代码提交记录观察,开发团队正尝试将BeautifulSoup与Playwright结合,以应对现代网页的复杂结构。

相关软件推荐

使用BeautifulSoup的新闻聚合爬虫

发布日期: 2025-04-10 16:40:12

新闻聚合爬虫工具中,基于Python的BeautifulSoup库因其灵活性和易用性备受开发者青睐。这...

HTML解析库BeautifulSoup

发布日期: 2025-07-23 13:06:01

网页数据抓取领域存在诸多技术方案,Python生态中的BeautifulSoup库因其独特的文档树解析...

BeautifulSoup实现的简易网页爬虫工具

发布日期: 2025-04-09 09:33:01

(正文开始) 工具定位与特点 BeautifulSoup作为Python生态中经典的HTML解析库,常被用于构...

利用BeautifulSoup的网页表格提取器

发布日期: 2025-04-19 19:39:35

网页数据抓取技术中,表格信息的结构化提取常让开发者头疼。Python生态中的Beautiful...

随机软件推荐

简易维基百科词条内容抓取保存工具

在信息爆炸的时代,快速获取并整理知识成为刚需。维基百科作为全球最大的开放知识库,涵盖数百万词条,但手动...

简易待办事项清单管理器(JSON存储数据)

办公桌上堆满的便利贴逐渐被电子工具取代时,一款基于JSON架构的待办清单管理器正在技术圈引发讨论。这款无需安...

自动生成操作热力图可视化工具

当用户的手指在屏幕上游移停留,当鼠标光标在网页反复徘徊,这些看似随机的行为背后,隐藏着精准的商业价值。...

系统蓝屏错误日志分析器

当Windows系统遭遇致命错误时,蓝屏界面往往伴随着一串晦涩的代码与日志文件,这类问题常让普通用户手足无措,甚...

WiFi密码管理器(带加密存储功能)

咖啡馆里邻座顾客问密码的场景每天都在上演,现代人手机里至少存着30组以上的无线网络密钥。从家庭路由器到公司...

基于阈值的进程资源限制器

现代服务器运维常面临资源分配失衡的难题。某次线上服务突发流量时,某个异常进程在10分钟内吞噬了90%的内存,导...

电影字幕时间轴校正工具

电影爱好者总会在观影时遇到字幕不同步的尴尬——画面中角色早已转身离去,字幕却停留在三秒前的对白;纪录片...

多源地理数据融合对比分析工具

地理信息技术的快速发展催生了多元数据来源的爆发式增长。卫星遥感影像、无人机航拍数据、地面传感器网络及传...

网页内容爬取与关键词提取脚本

在信息处理需求激增的数字化时代,一款基于Python的智能数据采集工具正在改变企业获取核心信息的方式。该工具整...

多语言图像色彩模式转换工具

在数字图像处理领域,色彩模式转换是设计师、摄影师等从业者每天都要面对的基础操作。随着跨国协作与跨平台创...

使用Random模块的密码生成器工具

在网络安全意识逐渐强化的今天,密码生成工具已成为开发者和普通用户的刚需。本文介绍一款基于Python标准库Rand...

微信消息自动生成待办事项清单工具

工作群里突然蹦出十几条消息,朋友发来的聚餐邀约淹没在聊天记录里,老板临时布置的任务还没记下来就被刷屏…...

多条件文件筛选删除工具

日常办公场景中,文件管理逐渐成为困扰用户的隐形难题。重复文件堆积、过期文档难以识别、存储空间频繁告警…...

简易日历工具(支持事件提醒功能)

当代人面对繁忙的日程,一款能自动规划时间的工具逐渐成为刚需。市面上各类日历软件层出不穷,但真正兼顾轻量...

简易即时通讯软件(支持表情包)

手机屏幕亮起的瞬间,熟悉的对话框弹出粉色兔子比心表情。这款名为"泡泡聊"的即时通讯工具,正在三四线城市年轻...

自动化URL重定向链检测及跳转路径追踪工具

互联网世界如同错综复杂的迷宫,URL重定向链就是其中隐藏的岔路。某电商平台的促销链接经过五次跳转才到达落地...

自动生成二维码工具(支持自定义内容)

二维码已成为现代生活的高频工具,从商品包装到活动宣传,从电子支付到信息共享,黑白方块背后承载着高效连接...

XML数据树形结构查看器

对于长期与XML打交道的开发者而言,数据结构的可视化解析始终是绕不开的痛点。传统文本编辑器虽然能打开XML文件...

文件名数字序号智能对齐工具

在日常办公与项目管理中,文件命名混乱常让人头疼。尤其是涉及大量序列文件时,数字序号格式不统一(例如"文件...

系统服务管理工具(启停状态查看)

系统服务管理工具是运维人员和开发者日常工作中不可或缺的助手。这类工具的核心价值在于帮助用户高效控制后台...

基于Tkinter的PDF文件批量合并分割工具

PDF文档作为现代办公场景中的标准文件格式,其处理需求持续增长。针对文件合并与分割这两个高频操作,某开发者...

Windows服务状态监控工具(启停与日志查看)

在Windows服务器运维过程中,服务状态监控是系统管理员的核心工作之一。针对服务异常导致的系统故障,专业技术人...

股票价格预警通知工具(API对接)

金融市场瞬息万变,股价波动牵动投资者的神经。如何在第一时间捕捉关键价格信号,成为交易决策的关键。股票价...

简易股票价格监控脚本(API数据获取)

在快节奏的股票市场中,及时获取股价波动信息对投资者至关重要。手动刷新交易软件不仅效率低下,还可能错过关...

Excel数据按模板格式转换CSV工具

数据格式转换是办公场景中的高频需求。Excel文件与CSV格式间的转换看似简单,但涉及模板化处理时,常规操作常出现...

简易ARP缓存中毒攻击模拟检测器

在网络安全的攻防场景中,ARP缓存中毒攻击(又称ARP欺骗)因其隐蔽性和破坏性,长期威胁着局域网环境。针对这一...

轻量级网页内容哈希值生成校验工具

互联网内容迭代速度加快,网页开发者与运维人员常面临内容版本混乱、篡改检测困难等问题。针对这一痛点,某技...

批量注释打印排版优化工具

凌晨三点的办公室里,程序员小王盯着屏幕上密密麻麻的代码注释叹了口气。项目临近交付,团队要求所有函数必须...

基于关键词的批量MP3元数据编辑器

对于音乐爱好者、播客创作者或音频内容管理者来说,整理成千上万的MP3文件往往是一场噩梦。文件名混乱、专辑信...

图片格式转换与文件哈希值校验工具

在数字信息处理领域,有两类工具正逐渐成为用户高频使用的刚需产品。它们既不需要复杂的操作界面,也不依赖云...

会议预约系统自动填表工具

当某家跨国企业的行政主管第37次收到重复的会议室预订邮件时,她终于意识到传统预约方式的效率瓶颈。这种普遍存...

基础多线程网页爬虫(URL队列管理)

在互联网数据采集领域,多线程网页爬虫因其高效率成为主流工具。这类工具的核心竞争力往往取决于URL队列管理模...

JSON数据关联图表生成工具

在数据驱动决策的时代,如何将冰冷的数字转化为直观的洞察力成为关键。一款名为ChartLink的JSON数据关联图表生成工...

文件隐藏属性批量检测器

在信息化办公场景中,操作系统自带的文件属性管理功能常让使用者陷入被动。某次企业数据归档时,技术团队发现...

Tkinter版简易画图板(支持保存)

在Python生态中,图形界面开发常被贴上"复杂"的标签。Tkinter作为标准GUI库,虽功能全面却常被低估。基于Tkinter实现的...

随机密码管理器(AES加密存储凭证)

在数字化浪潮席卷全球的今天,平均每位网民需要管理超过100组账号密码。传统的手写记录、重复使用简单密码等习...

自动化邮件发送内容生成器

在信息爆炸的数字化时代,企业日常运营中高频次的邮件往来成为常态。面对重复性高、格式固定的邮件撰写需求,...

PDF文档内容批量导出为文本工具

在数字化办公场景中,PDF文档因其跨平台稳定性成为主流格式,但批量提取文本内容始终存在操作门槛。传统手动复...

手机键盘输入统计热力图生成器

手机键盘输入统计热力图生成器是一款针对触屏设备开发的实用工具。它通过捕捉用户日常打字行为的数据,自动生...

利用QRcode库的二维码生成与解析工具

二维码技术近年来渗透到生活的各个场景,从支付到信息传递,几乎无处不在。基于Python的QRcode库开发的工具,为二...