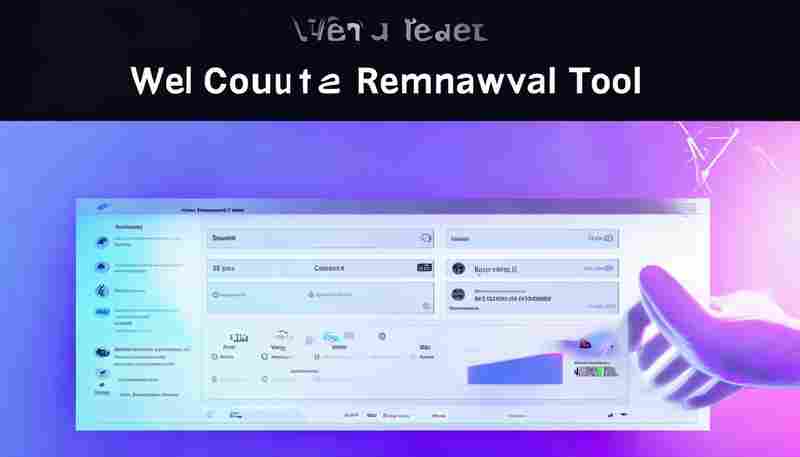

JSON数组元素去重工具

在日常开发或数据处理中,JSON数组的应用极为普遍。但重复的数组元素常导致数据冗余,影响后续的分析与存储效率。手动筛查重复项耗时费力,尤其当数据量级较大时,几乎无法实现精准操作。一款高效的JSON数组元素去重工具,往往成为开发者工具箱中的必备品。

功能定位与核心逻辑

这类工具的核心目标是通过特定算法,快速识别并剔除数组中的重复元素。例如,处理用户提交的表单数据时,若JSON数组中包含多个相同ID的条目,去重工具可自动保留唯一值,确保后续流程(如数据库写入)的稳定性。其实现逻辑通常分为两种:

1. 完全匹配模式:严格比对元素的每个字段及值,仅保留完全一致的第一个元素。

2. 属性筛选模式:根据用户指定的关键属性(如`id`、`timestamp`)进行局部匹配,适用于嵌套结构或部分字段重复的场景。

典型应用场景

工具使用体验

以某开源工具为例,其支持命令行与图形界面两种操作方式。用户只需输入JSON文件路径,选择去重模式(完全匹配或属性匹配),即可在秒级内生成清理后的结果。若数据中存在复杂结构(如多层嵌套对象),工具还提供正则表达式过滤功能,进一步细化处理逻辑。

工具并非万能。例如,当元素中包含动态字段(如随机生成的`UUID`)时,完全匹配模式可能失效。此时需结合业务逻辑,手动调整关键属性,或通过脚本预处理数据。部分工具对大规模数据(如百万级条目)的处理性能有限,需根据实际需求选择适配版本。

开发者注意事项

1. 去重前务必备份原始数据,避免误操作导致信息丢失。

2. 针对特殊字符(如换行符、Unicode编码),需确认工具的兼容性。

3. 若需保留重复元素的出现次数等元信息,建议输出独立的统计报告。

JSON数组去重工具的价值不仅在于“删除冗余”,更在于其背后对数据一致性的保障。随着数据结构复杂度的提升,工具的设计也需兼顾灵活性与执行效率。毕竟,好的工具应当如瑞士军刀般,在特定场景下精准解决问题,而非盲目追求功能堆砌。

- 上一篇:JSON数据采样工具(按比例随机提取子集)

- 下一篇:JSON文件批量格式化校验工具

相关软件推荐

音效素材库去重同步工具

发布日期: 2025-04-22 19:30:02

硬盘里躺着3T音效素材,每次打开文件夹都能看到"风声_01""风声_final""wind_new_version"这类...

随机软件推荐

本地文件夹重复图片自动识别与删除工具

现代人手机或电脑中常堆积大量重复图片,手动清理耗时耗力。针对这一痛点,本地重复图片自动识别工具应运而生...

单位转换结果复制到剪贴板工具

日常工作中,工程师常遇到代码里混合使用毫米与英寸,化学实验报告需要换算摩尔浓度与百分比浓度,跨境电商运...

智能邮件附件分类器

现代职场人每天需要处理数十封邮件,其中近半数附带不同类型的文件。面对混杂的合同、报表、图片或压缩包,手...

健身动作要领语音提示系统

在健身房训练过程中,动作规范度直接影响训练效果与安全系数。传统训练模式依赖教练现场指导,存在时间成本高...

简易Flask在线代码片段分享平台

在程序员日常协作中,代码片段的即时共享始终是刚需。最近在技术社区频繁出现的Flask Snippet Hub,凭借其极简设计和...

文本加密日记本(带时间戳记录)

深夜的台灯下,大学生小林快速输入手机密码,打开某个黑色图标的软件。键盘敲击声混着雨滴敲窗的节奏,屏幕上...

服务器访问日志安全威胁正则检测工具

在互联网安全攻防战中,服务器访问日志如同战场上的监控录像,记录着每一次网络请求的轨迹。攻击者的SQL注入、...

字体文件云端同步管理工具

办公桌上凌乱的U盘、电脑里重复命名的字体文件夹、团队协作时频繁传输的压缩包——这些困扰设计师多年的场景,...

多设备Ping延迟对比测试工具

网络延迟就像数字世界的隐形路障,游戏卡顿、视频会议掉帧、文件传输中断等场景中,这个毫秒级的指标往往成为...

社交媒体舆情摘要日报生成器

在信息爆炸的社交媒体时代,企业、机构甚至个人每天面对海量舆情数据,如何快速提炼核心信息成为痛点。一款名...

基于platform的BIOS版本查询工具

在计算机维护与系统调试领域,BIOS版本信息的快速获取是硬件兼容性判断与系统优化的关键步骤。传统手动查询方式...

PPT幻灯片文本提取工具(.pptx)

办公场景中,PPT文件承载着大量核心信息,但逐页复制文本效率低下。针对这一痛点,PPT文本提取工具通过自动化技...

浏览器插件式实时网速悬浮窗

电脑右下角的网络图标总像个沉默的哑巴,点开任务管理器又得中断手头工作。当视频突然卡顿、会议画面冻结时,...

自动排除隐藏文件的同步助手

清晨八点的办公室,技术部王工面对屏幕皱起眉头:耗时三小时的文件同步操作又失败了。本地开发目录里散布着数...

复杂任务依赖关系分析工具

当某汽车制造商的新能源车型研发项目连续三次推迟交付时,项目经理发现传统甘特图已无法清晰呈现两千多个任务...

基于所有者的存储迁移校验工具

在数字化转型进程中,企业存储系统的迁移常伴随数据归属混乱、权限校验缺失等风险。传统迁移工具往往聚焦于数...

系统风扇转速监控调节工具

机箱内此起彼伏的风扇呼啸声,往往暴露着硬件系统的健康隐患。当CPU温度攀升至警戒值时,传统的主板温控策略常...

命令行式SHA256校验和生成及验证工具

在数字化时代,数据完整性验证是开发者和运维人员的日常刚需。无论是软件发布、文件传输还是系统备份,SHA256校...

打印任务队列监控管理器

现代办公场景中,打印任务的管理常被忽视,却直接影响工作效率。当多台设备同时提交打印需求时,任务堆积、优...

Markdown 文件预览工具

对于习惯用Markdown写作的用户而言,纯文本编辑的清爽体验与格式渲染后的可视化呈现之间,往往隔着一道体验鸿沟。...

自动备份指定文件夹脚本(zipfile库)

办公电脑突然死机蓝屏,U盘意外进水损坏,移动硬盘摔落发出异响...这些意外时刻提醒着数据备份的重要性。对于需...

支持拖拽的PDF页面合并拆分工具

PDF文档的日常管理中,页面重组需求往往让人头疼。传统工具需要反复点击菜单栏或记忆复杂快捷键,操作效率低下...

批量下载YouTube视频标题工具(API版)

在信息爆炸的时代,YouTube每天新增数百万条视频内容。无论是自媒体运营、学术研究还是市场分析,快速获取特定频...

GIF动态图合成分解工具(Pillow实现)

GIF动态图因其轻量化和循环播放特性,成为网络传播中最受欢迎的格式之一。针对开发者或设计爱好者而言,手动处...

CSV数据查看编辑器

在数据驱动的现代办公场景中,CSV格式文件以其轻量化、兼容性强的特性,成为跨平台数据交换的通用载体。面对动...

基于itchat的微信消息处理机器人

近年来,基于Python的itchat库在开发者社区持续走热。这款基于微信个人账号的API工具包,为各类消息自动化处理场景...

局域网文件传输工具(支持多设备同步传输)

在数字化办公场景中,多设备协同工作的需求日益增长。面对会议室里频繁切换的手机、平板和笔记本电脑,传统文...

股票数据股东人数变化分析器

市场波动背后,股东人数的微妙变动常被投资者忽视。作为衡量分布的核心指标,股东人数变化暗含主力资金动向与...

MD5哈希值生成结果批量打印工具

在数据管理与信息安全领域,MD5哈希值作为经典的校验工具,广泛应用于文件完整性验证、密码存储等场景。面对大...

多账户财务收支记录分析仪(饼图报表)

多账户财务收支记录分析仪(饼图报表)作为一款聚焦个人及家庭财务管理的数字工具,正在成为越来越多用户的记...

窗口化数独游戏生成与解答器

在数字谜题领域,一款名为SudokuMaster Pro的窗口化工具近期引发热议。该软件以可视化操作界面为核心,集合智能生成...

配置文件自动回滚管理器

在分布式系统与微服务架构普及的今天,配置文件的管理逐渐成为运维工作的核心痛点。一次错误的配置推送,可能...

批量恐龙化石信息生成工具

在地球漫长的历史中,恐龙化石作为生命演化的关键证据,承载着破解远古生态密码的重要使命。近年来,随着古生...

批量PDF转TXT文本转换器

随着数字化办公需求激增,纸质文档电子化处理成为刚需。面对堆积如山的PDF合同、学术论文或财务报表,传统逐页...

游戏操作宏录制与回放工具(支持快捷键绑定)

深夜的电脑屏幕前,左手边的冰镇可乐凝结出水珠,右手边的机械键盘第三次发出规律敲击声。玩家小张盯着《永恒...

实时股票价格推送看板

金融市场瞬息万变,投资者对实时信息的依赖程度远超以往。一款高效的实时股票价格推送看板,已成为职业交易员...

YAML转INI配置文件批量处理器

在软件开发与系统运维领域,配置文件格式转换是常见的技术需求。针对YAML与INI两种主流格式互转的场景,专业技术...

文件扩展名批量修改器(安全格式转换)

在数字文件管理中,文件扩展名错误或格式混乱常导致系统无法识别内容。传统的手动修改方式不仅效率低,还可能...

简易设备报修工单管理系统

在设备运维管理中,手工记录故障、电话沟通维修的传统模式常导致响应滞后。某款轻量级报修工单管理系统通过流...

会议日程邮件自动提醒工具

在快节奏的职场环境中,会议安排的高效管理直接影响团队协作的质量。据统计,约30%的职场人曾因遗忘会议时间或...