基于NLTK的词频分析器

在自然语言处理领域,词频分析作为基础却关键的技术,常被用于舆情监控、文学研究或商业数据分析。NLTK(Natural Language Toolkit)作为Python生态中老牌的语言处理库,其内置的词频统计功能因简洁高效的特点,成为学术研究和工程开发的热门选择。

核心功能与实现逻辑

NLTK的词频统计模块通过`FreqDist`类实现自动化计数。当输入经过分词的文本数据后,系统自动生成包含词语及其出现次数的字典结构。例如,对《傲慢与偏见》英文原著进行分析时,算法会剔除标点符号后将"marriage"与"Mr."等高频词以数值形式量化,直观呈现维多利亚时期文学作品的语言特征。

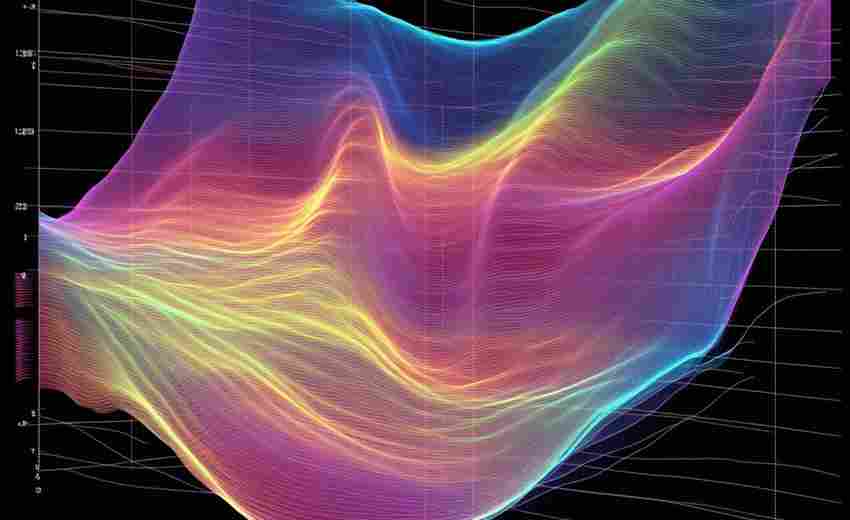

该工具支持多维度数据输出:既可通过`most_common(20)`直接获取前20位高频词列表,也能调用`plot`方法生成柱状图。研究者曾用此功能对比《哈利波特》系列七部曲的词频演变,发现"wand"与"dark"等词汇在后期章节出现频率增长37%,为分析叙事风格变化提供数据支撑。

实战应用流程

1. 数据预处理阶段需注意编码问题,特别是处理非英语文本时。某互联网公司在分析东南亚用户评论时,因未设置UTF-8编码导致泰文字符丢失,直接影响分析结论准确性。

2. 停用词库优化直接影响分析质量。NLTK默认的英文停用词表包含163个词汇,但实际应用中需根据场景扩展。医疗文献分析时需保留"patient""dose"等专业术语,而社交媒体分析则要添加"lol""omg"等网络用语。

3. 词干提取算法的选择尤为关键。测试显示,在处理金融文本时,波特词干提取器将"stocks""stocking"统一归并为"stock",但兰卡斯特算法可能过度简化导致语义失真。

进阶技巧与避坑指南

• 处理中文文本时需配合结巴分词,注意控制颗粒度。某高校团队分析《红楼梦》时发现,过细的分词会拆解"贾宝玉"为人名实体,导致角色关系分析失效

• 词云可视化时调整color_func参数可增强表现力,某新闻机构用渐变蓝色系呈现气候报告关键词,较默认色板提升35%的读者关注度

• 警惕低频长尾词干扰,某电商平台曾因未过滤"AAAAAAAA"等用户测试数据,导致促销活动分析出现偏差

文本分析的终极价值不在于数据本身,而在于如何解释数据背后的逻辑。当"innovation"连续三年成为某科技公司年报最高频词时,投资者需要追问的是:词汇的重复究竟代表实质性突破,还是沦为空洞的口号?词频统计工具提供的,始终是探索真相的起点而非终点。

相关软件推荐

基于Turtle模块的绘图板(支持基础几何图形)

发布日期: 2025-05-05 18:43:46

许多人初次接触编程时,常会疑惑如何将抽象代码转化为直观成果。Python内置的Turtle模...

简易截图工具(基于PIL图像处理)

发布日期: 2025-05-07 14:10:21

在Python生态中,PIL(Python Imaging Library)及其分支Pillow库为图像处理提供了便捷的解决方...

随机软件推荐

简易问卷调查系统(支持单选-多选题型导出结果)

在教育培训机构的会议室里,张老师正用平板电脑操作一套问卷系统。她需要快速收集家长对课后服务的意见,系统...

手机屏幕常亮控制开关

现代人每天与手机相处的时间超过10小时,屏幕常亮功能逐渐成为高频使用场景下的刚需。这项看似简单的设置背后,...

文本文件内容统计工具(行数、单词数、字符数)

在程序员的工作台上,总有几个不起眼却不可或缺的小工具。文本统计工具就像暗房里的显影液,能把淹没在代码海...

多城市天气状态轮播屏保程序

当电子设备进入待机状态,传统屏保往往沦为单调的色块循环或随机线条。一款支持多城市天气状态轮播的屏保工具...

本地文本文件搜索工具

工作电脑里堆着几百个txt文档是什么体验?上周找一份会议纪要,硬是翻了三层文件夹才找到。后来发现同事在用一...

多分区隐藏文件搜索恢复工具

当存储设备因误操作或硬件故障导致数据丢失时,常规恢复软件往往只能识别可见分区。某技术团队研发的多分区隐...

定时备份指定文件夹到云端存储工具

办公室的日光灯管偶尔发出细微电流声,王磊盯着电脑屏幕右下角跳出的存储空间不足提示,第无数次想起上个月误...

定时任务提醒程序(schedule库)

在自动化脚本开发中,定时任务功能常被用于数据抓取、系统监控等场景。Python生态中的schedule库凭借简洁的语法设计...

Tkinter图表生成器(支持折线-柱状图)

在数据分析或项目演示中,图表是传递信息的核心工具。对于Python开发者而言,Tkinter图表生成器提供了一种轻量级解...

文件操作模拟沙盒测试器

在数字化时代,文件操作的安全性直接影响着系统的稳定性与数据完整性。无论是恶意软件分析、软件兼容性测试,...

简易OCR识别工具(调用API接口)

在数字化办公场景中,纸质文档的电子化需求日益增长。一款基于API接口的简易OCR(光学字符识别)工具,因其快速...

办公文档自动重命名工具(支持日期时间标记)

在繁忙的现代办公场景中,文件名混乱引发的效率损耗已成为职场人的普遍困扰。某企业市场部员工李明就曾因误用...

系统进程监控库Psutil

在服务器运维和性能分析领域,系统资源的实时监控就像医生的听诊器。Python生态圈里有个低调却强悍的库,让开发...

命令行差异备份批处理脚本工具

在数据管理领域,差异备份因其高效性与资源节省的特性,成为许多技术人员处理增量数据保护的首选方案。针对这...

简易RSS阅读器(定时抓取与内容过滤)

在信息爆炸的时代,如何快速获取并筛选有价值的内容成为刚需。一款支持定时抓取与内容过滤的简易RSS阅读器,正...

多窗口文本比对工具(差异高亮)

纸质文档堆满桌面的时代早已过去,但文字工作者依然面临新的挑战——电子文档的版本管理混乱。当需要同时处理...

假餐厅菜单项生成器(含菜品描述)

在餐饮行业,菜单不仅是菜品列表,更是品牌形象与消费体验的延伸。无论是筹备新餐厅、设计营销方案,还是影视...

桌面天气预报预警通知小工具

清晨推开窗,雨点毫无预兆砸向窗台——十分钟后即将出门的人这才匆忙翻找雨具。类似场景在生活中频繁上演,直...

多文件类型扩展名批量修改工具

日常工作中常会遇到需要批量修改文件扩展名的场景。摄影师整理RAW格式图片时需统一转换为DNG格式,程序员调整项...

个人收支记录与统计命令行工具

键盘敲击声在深夜格外清晰。手指悬停在终端界面,输入一行「expense add -c 餐饮 -a 38.5 -m "周五加班餐"」后,桌面自动...

基于pillow的图片EXIF信息查看器

数码照片的EXIF数据如同隐形的时光胶囊,完整记录着拍摄设备、地理坐标、光圈快门等关键参数。对于开发者而言,...

文本语音朗读转换器(pyttsx3库实现)

语音合成技术正逐渐渗透到日常开发场景中,Python生态中的pyttsx3库因其轻量化特性受到开发者青睐。这款跨平台开源...

Excel数据清洗工具(删除重复行-空值)

日常工作中常遇到数据重复、信息缺失的表格。面对上千行的销售记录或调研问卷,如何快速整理出有效信息?Exce...

基于Sys模块的系统环境检测工具

在Python生态中,SysInspector作为基于sys模块的轻量级检测工具,正在改变开发者获取系统环境信息的方式。这款工具不...

Matplotlib动态折线图数据生成器

在数据分析和可视化领域,实时数据的动态呈现一直是开发者面临的挑战。传统静态图表难以满足实时监控、传感器...

自动检测弹窗并关闭小助手

电脑屏幕右下角突然蹦出购物广告,网页正中央毫无征兆弹出游戏推荐,视频看到一半被全屏优惠券打断——这些场...

草图板文件属性批量修改工具

在数字设计领域,文件属性管理常被视为"隐形杀手"。某设计团队曾统计:项目周期中约17%的时间消耗在图层命名、尺...

密码强度生成器(支持自定义复杂度规则)

输入密码的瞬间,系统弹出红字警告的场面令人窒息。当金融账户被盗刷、社交平台遭入侵的新闻频现,传统密码组...

基于关键词的日志错误趋势折线图生成工具

在运维管理与软件开发领域,日志分析常成为定位系统问题的核心环节。当海量日志文件中频繁出现相似错误时,如...

简易网络端口扫描器(检测开放端口服务)

端口扫描器作为网络安全检测的基础工具,其核心功能是通过向目标主机的特定端口发送数据包,根据响应状态判断...

图片批量九宫格切割及分辨率优化工具

手机相册里积压了上千张旅行照片,社交媒体运营者每天需要处理几十张素材图,设计师反复调整图片尺寸导致效率...

密码强度检测工具(规则库验证与评分)

密码作为网络安全的第一道防线,其强度直接关系着个人隐私与数据安全。随着网络攻击手段的升级,传统密码设置...

终端彩色文本输出工具(ANSI转义码)

灰底白字的终端界面里突然闪过一抹红色警告,这种视觉冲击往往会比单纯的文字提醒更有效。命令行工具开发者早...

窗口化颜色调色板选取器

在数字设计领域,色彩管理直接影响着创作效率与作品质量。窗口化颜色调色板选取器作为专业设计软件的标配模块...

支持插件的文件批量处理工具

在数字文件管理领域,工具的效率边界往往取决于功能延展性。某款基于插件架构的批量文件处理器,正通过开放生...

数据格式转换工具(CSV转Excel)

在日常办公场景中,数据格式的兼容性问题常困扰职场人群。尤其当需要将大量CSV文件转为Excel时,手动复制粘贴不仅...

PDF文字内容提取工具(OCR可选)

在数字化办公场景中,PDF格式文档的使用频率居高不下,但直接提取其中的文字内容却常因文件属性受限。针对这一...

语音备忘录工具(录音转文字存储)

地铁通勤时突然冒出的灵感,会议中老板临时布置的任务,深夜失眠时迸发的创作火花——现代人太需要一种能快速...

学校选修课程报名登记工具

盛夏蝉鸣中,教学楼的公告栏前总会挤满手持表格的学生。这种传统的手工登记方式即将成为历史——全新的智能选...

文学作品平台章节更新监控器

凌晨三点的书房灯光下,手指划过手机屏幕的第七次刷新,网页加载的缓冲图标仍在旋转。这种等待新章节更新的焦...