基于Requests的网页内容自动抓取与保存工具

在数据驱动的互联网时代,高效获取并存储网页信息成为许多业务场景的刚需。基于Python的Requests库,结合轻量级自动化脚本,开发者能够快速搭建一套灵活、稳定的网页内容抓取与存储工具。本文将从工具设计思路、核心功能及实际应用案例展开介绍。

1. 技术选型与核心依赖

Requests库作为Python生态中处理HTTP请求的标杆工具,凭借其简洁的API设计与高效的性能表现,成为网页抓取的首选方案。相较于其他爬虫框架,Requests无需依赖复杂的环境配置,仅需配合`BeautifulSoup`或`lxml`实现解析逻辑,即可完成从请求发送到数据提取的全流程。通过`pandas`或原生文件操作模块,可将数据持久化存储为CSV、JSON或数据库格式。

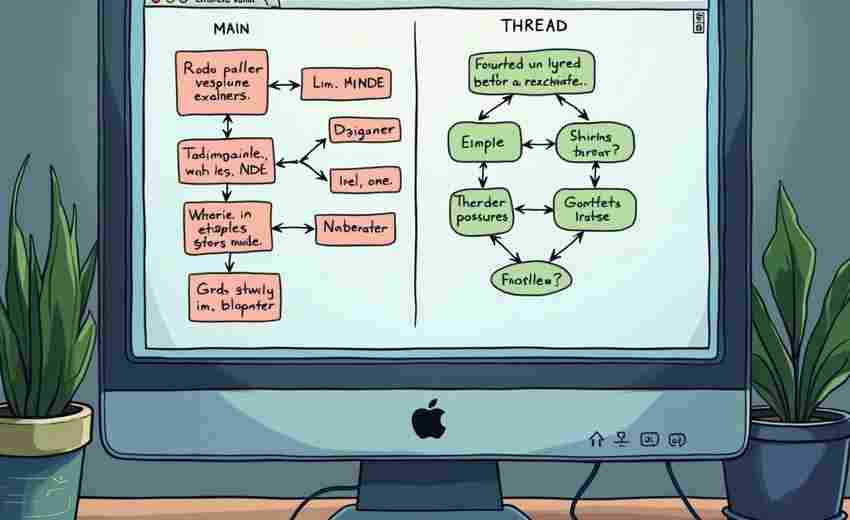

工具的核心逻辑分为三部分:请求管理、内容解析与异常处理。通过自定义请求头(User-Agent、Cookie)模拟浏览器行为,结合随机延时策略(如`time.sleep(random.uniform(1,3))`),可有效规避反爬机制。

2. 功能实现与代码示例

以下为一个基础版工具的实现框架:

```python

import requests

from bs4 import BeautifulSoup

import csv

def fetch_url(url):

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36'}

try:

response = requests.get(url, headers=headers, timeout=10)

response.raise_for_status

return response.text

except requests.exceptions.RequestException as e:

print(f"请求失败: {e}")

return None

def parse_html(html):

soup = BeautifulSoup(html, 'lxml')

示例:提取标题与正文

title = soup.find('h1').text.strip if soup.find('h1') else ''

content = soup.find('div', class_='article').text.strip if soup.find('div', class_='article') else ''

return {'title': title, 'content': content}

def save_to_csv(data, filename):

with open(filename, 'a', newline='', encoding='utf-8') as f:

writer = csv.DictWriter(f, fieldnames=['title', 'content'])

if f.tell == 0:

writer.writeheader

writer.writerow(data)

示例调用

url_list = [' '

for url in url_list:

html = fetch_url(url)

if html:

parsed_data = parse_html(html)

save_to_csv(parsed_data, 'output.csv')

```

此脚本支持多页面循环抓取,通过异常捕获机制保障程序稳定性。对于动态渲染页面,可引入`Selenium`或`requests-html`作为补充方案。

3. 扩展能力与优化方向

某电商价格监控项目中,该工具曾实现日均百万级数据的采集,通过请求频率控制和分布式存储(MongoDB分片集群),数据可用率超过99%。

4. 注意事项与合规边界

数据存储时建议增加去重与校验机制,例如SHA-256校验文件完整性

相关软件推荐

随机软件推荐

网络爬虫(指定网页内容抓取与保存)

互联网数据抓取领域存在多种技术方案,本文将从实际应用角度剖析不同工具的特点。以Python技术栈为例,当前主流...

PyQt5文件内容多关键词并行搜索工具

在信息爆炸的时代,电子文档管理已成为现代办公的痛点。某技术团队开发的基于PyQt5框架的多关键词并行搜索工具,...

智能冲突检测的文件扩展名批量重命名工具

在数字化办公场景中,文件命名混乱导致的工作效率低下一直是高频痛点。例如,设计师团队协作时,同一素材可能...

文件夹实时监控与变更日志工具

办公电脑的D盘突然多出3GB临时文件,项目文档被误删后无法追溯操作者,服务器日志每小时增长上千条冗余信息……...

学术论文查重报告摘要生成器

当前学术环境中,论文重复率检测已成为学术研究的重要环节。针对传统查重报告存在的冗长信息筛选难题,新型智...

简易音乐播放器(MP3列表)

在数字化时代,音乐播放器几乎成为手机或电脑的标配工具。对于追求轻量化操作的用户而言,一款功能简洁、界面...

图片像素画生成器(将图片转换为字符画)

打开电脑里那张泛黄的老照片,或是手机中刚拍的旅行风景,只需点击几下鼠标,它们就能变成由字符组成的数字艺...

文件加密解密批处理工具(AES算法)

数据安全焦虑正在成为现代人的集体困扰。一份泄露的合同可能毁掉商业信誉,几张私人照片流出足以摧毁社交关系...

CPU内存占用实时监测工具

市面上一款名为SysTrack的资源监测工具近期引发技术圈关注。这款仅12MB的绿色软件无需安装即可运行在Windows/Linux双平...

基于Requests的股票价格实时监控工具

上海陆家嘴某私募基金交易员李明习惯性按下F5刷新行情页面,屏幕右下角突然弹出的红色弹窗引起他的注意——自研...

简易绘画板(基于Tkinter画布)

在Python生态中,Tkinter作为标准GUI库常被低估其潜力。通过Canvas画布组件实现的简易绘画板,恰好展现了如何用不足百...

PDF文本内容提取工具(带密码破解功能)

日常办公场景中,PDF文档以其稳定的跨平台特性成为主流文件格式。据统计,全球每天有超过20亿份PDF文档被创建,其...

CSV文件重复数据自动清理工具

在数据驱动的时代,CSV格式因其结构简单、兼容性强,成为存储表格数据的首选。人工录入、系统对接等场景下,重...

文本语音朗读转换器(pyttsx3库实现)

语音合成技术正逐渐渗透到日常开发场景中,Python生态中的pyttsx3库因其轻量化特性受到开发者青睐。这款跨平台开源...

多文件内容相似度检测工具(基于文本指纹算法)

数字信息爆炸的时代,文字重复已成为困扰创作者的高频问题。某互联网公司近期发现,其签约作者的原创内容中,...

简易数独生成解题器(自动填充校验)

对于数独爱好者而言,传统的手动解题常遭遇两个痛点:设计初始盘面需要反复试错,验证填数正确性需消耗大量时...

简易聊天客户端(socket实现基础通信)

工具概述 基于Socket实现的简易聊天客户端,本质是通过TCP/IP协议建立稳定双向通信通道的工具。开发者只需调用操作...

基于Python的全球地表温度变化可视化工具

气候问题日益成为全球关注的焦点,地表温度变化数据作为核心指标之一,其可视化呈现直接影响公众认知与科研决...

图片格式兼容性检测修复工具

在数字图像处理中,格式兼容性问题是许多人踩过的“坑”。一张在电脑上显示正常的图片,传到手机可能无法打开...

批量生成二维码工具(带LOGO定制)

在信息传播加速的时代,二维码成为连接线上线下的重要媒介。一款支持批量生成且可定制Logo的二维码工具,正在成...

基于Python的摄像头视频流录制工具

在计算机视觉和多媒体处理领域,实时捕获摄像头视频流并保存为本地文件是常见需求。本文将介绍一种基于Python语...

科学计算器支持复数运算和矩阵运算

科学计算器作为科研、工程领域的实用工具,其功能边界不断被技术突破重新定义。当前主流型号的计算器已突破传...

文件权限批量修复工具(Linux-MacOS)

在Linux和MacOS系统中,文件权限混乱是用户常遇到的棘手问题。无论是误操作导致关键目录不可访问,还是恶意程序篡...

文件权限历史版本比对工具

在复杂的系统运维与安全管理中,文件权限的变更往往牵一发而动全身。一次误操作可能导致服务中断或数据泄露,...

屏幕锁定时间统计工具

现代人每天面对电子设备的时间越来越长。工作邮件、社交软件、短视频平台……屏幕仿佛成了身体器官的延伸。这...

系统U盘写入保护检测工具(只读状态检测)

当U盘突然无法保存文档或出现"磁盘被写保护"提示时,多数用户会陷入操作困境。系统U盘写入保护检测工具正是为解...

网络故障自动检测日志工具

在数字化转型加速的今天,网络系统的稳定性成为企业运维的核心挑战。一款名为LogInsight的日志分析工具,凭借其故...

简易版局域网文件传输共享工具

办公场景中常遇到这样的尴尬:同事急需一份设计稿,U盘却怎么也找不到;想给会议室投影仪传PPT,微信提示"文件过...

系统服务管理助手(启动-停止)

在服务器运维和软件开发场景中,服务进程的精准控制直接影响系统稳定性。传统命令行操作存在响应延迟、可视化...

简易注册表清理器(Windows系统)

日常使用电脑时,多数人都会忽略注册表这个关键系统组件。这个存储着软硬件配置信息的数据库,随着系统使用时...

li网站Cookie管理器工具-li

互联网时代,网站Cookie几乎无处不在。用户访问电商平台时,首页自动推荐昨天浏览过的商品;登录社交媒体账号时...

终端版短链接生成与还原器

互联网时代,短链接技术早已渗透到日常信息交互中。无论是社交媒体分享还是营销推广,长URL的臃肿问题始终困扰...

天气查询命令行客户端(调用API获取数据)

在终端场景下直接获取天气信息的需求,正被越来越多的开发者纳入效率工具清单。基于OpenWeatherMap API开发的Weather...

股票数据爬虫可视化工具(K线图绘制)

在金融交易领域,数据可视化工具正成为投资者不可或缺的决策助手。基于Python技术栈构建的股票分析工具,能够实...

Steam游戏折扣信息自动通知工具

对于热衷于Steam平台的玩家来说,错过心仪游戏的限时折扣堪称年度遗憾。手动刷新商店页面、反复比价、计算促销周...

命令行版数字计算器(支持加减乘除)

在终端环境中处理数学运算时,多数人习惯打开桌面计算器或切换至电子表格软件。但对于高频处理数值任务的技术...

邮件自动归档存储管理系统

某国际物流公司的IT部门最近发现,员工平均每天花费47分钟处理邮件整理工作。传统的手动归档方式不仅消耗时间,...

简易RSS阅读器(解析XML订阅)

窗外的梧桐叶飘落时,桌面右下角准时弹出了科技专栏的更新提醒。这是笔者使用LeafReader第三十七天养成的阅读习惯...

快速文件内容搜索工具(grep.py)

办公桌上堆叠的日志文件突然需要紧急排查,代码库数十万行中寻找特定函数调用,这种场景让很多开发者头皮发麻...

简易DNS查询工具(含缓存功能)

在网络运维和开发场景中,DNS解析效率直接影响着问题排查和服务响应速度。传统命令行工具如`nslookup`或`dig`虽然功...