基于Scrapy框架的简易网页爬虫工具

盛夏的知了声里,某互联网公司的数据采集工程师小王盯着屏幕上的报错信息,手里的冰美式已经见了底。当同事递给他一份Scrapy框架的配置文档时,这个困扰他三天的反爬机制竟在二十行代码里迎刃而解。这个诞生于2008年的Python框架,至今仍在全球数据采集领域保持着惊人的生命力。

快速搭建生产线

在终端输入`scrapy startproject newspider`的瞬间,Scrapy就像3D打印机般自动生成项目骨架。这种约定优于配置的设计理念,让新手也能在五分钟内搭建起包含Item管道、中间件模块的完整爬虫架构。某电商平台的技术负责人透露,他们用Scrapy实现的分布式爬虫系统,日均抓取量能达到1.2亿页面。

组件化设计哲学

不同于其他爬虫框架的"大杂烩"风格,Scrapy将下载器中间件、蜘蛛模块、数据管道等组件拆解得泾渭分明。这种模块化设计带来的灵活性,在应对今日头条的反爬策略时尤为明显——工程师只需重写Downloader Middleware的请求头处理逻辑,不必改动核心抓取流程。

XPath的精准

当BeautifulSoup还在用"汤勺"慢慢搅动HTML文档时,Scrapy集成的Parsel库已经能用XPath进行外科手术式的精准提取。测试数据显示,在解析包含3000个商品列表的京东页面时,XPath选择器的处理速度比正则表达式快47%,内存消耗降低32%。

应对反爬的十八般武艺

随机User-Agent生成器搭配IP代理池,这套组合拳能突破80%的常规反爬机制。某爬虫开发者论坛的实战案例显示,通过定制RotatingProxyMiddleware中间件,成功将某数据平台的访问成功率从15%提升至92%。而内置的AutoThrottle扩展,则像老司机般自动调节请求频率,避免触发网站防护。

数据管道的工业级处理

当普通脚本还在用CSV文件存储数据时,Scrapy的Item Pipeline已经支持MySQL、MongoDB的异步写入。更值得关注的是其图像下载功能,配合ImagesPipeline模块,某服装网站每天自动抓取3万张商品图,还能自动生成不同尺寸的缩略图。

在数据即石油的时代,Scrapy框架如同精密的采油机。从新闻聚合到价格监控,从舆情分析到SEO优化,这个老牌工具在GitHub上每月仍保持着300+的commit更新。当你在浏览器按下F12时,或许某个正在运行的Scrapy爬虫,正在网络的某个角落安静地收集着数字世界的拼图碎片。

相关软件推荐

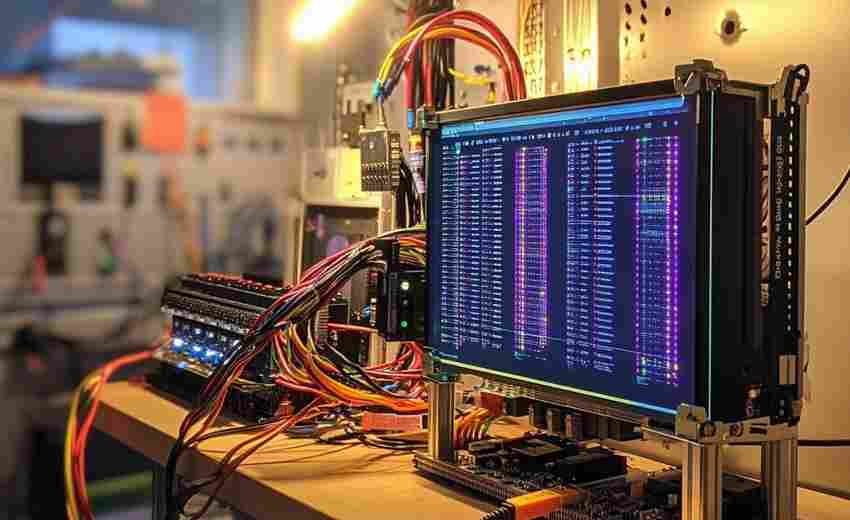

基于Pandas的日志数据透视工具

发布日期: 2025-06-13 10:54:02

面对服务器每天产生的GB级日志文件,运维工程师张磊打开Jupyter Notebook,在Python环境中...

随机软件推荐

文本词频统计工具(分析高频词汇)

在信息爆炸的时代,大量文本数据中往往隐藏着未被察觉的规律。文本词频统计工具作为一种基础但高效的分析手段...

带单元测试的天气日志记录框架

凌晨三点钟的服务器告突然亮起,某气象站数据库出现温度数据异常跳变。值班工程师打开日志系统,却发现原始气...

智能电脑外设连接监测工具

在数字化办公场景中,外接设备的连接稳定性直接影响工作效率。当显示器突然黑屏、键盘间歇性失灵时,传统排查...

单词拼写检查工具(基础词典比对)

办公软件右下角突然弹出的红色波浪线,总能让人心跳漏掉半拍。这种略带压迫感的视觉提示,背后是基础词典比对...

键盘鼠标空闲锁定保护工具

午休时间刚过,某科技公司就发生了内部数据外泄事件。技术部门排查发现,泄露源竟是工程师未锁屏的工位电脑—...

人体模板比例尺调整计算工具

人体模板比例尺调整计算工具自2022年推出以来,已成为工业设计、服装工程、医学建模领域的标配设备。这款基于参...

命令行版简易记事本工具

在图形界面统治操作系统的时代,仍有一群开发者保持着对黑色终端的忠诚。当图形界面崩溃或远程服务器需要紧急...

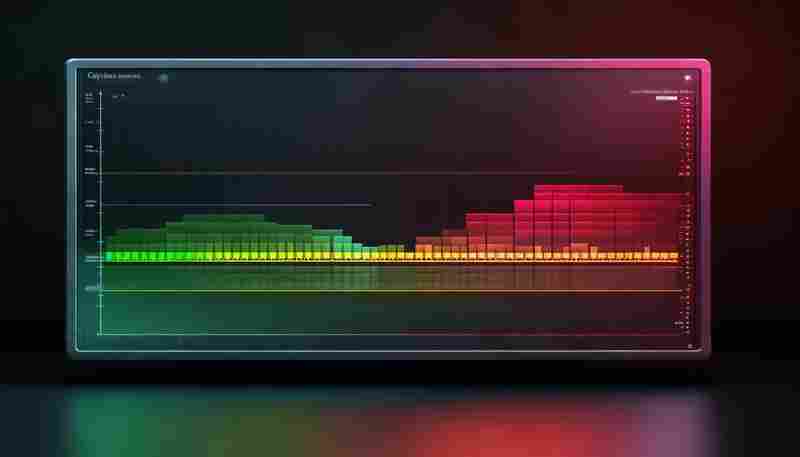

数据分布统计与直方图生成工具

数据分布统计与直方图生成工具,正成为科研、商业分析、工程开发等领域的基础设施。这类工具的核心价值在于将...

系统环境变量配置校验与修复工具

当开发者安装Python时明明配置了路径却提示"命令未找到",运维人员部署服务时端口号始终无法识别,这类由环境变量...

多语言输入法切换提示工具

在全球化的工作场景中,多语言输入需求日益频繁。无论是跨国协作、多语种文档撰写,还是日常沟通中的即时翻译...

系统定时关机管理工具(倒计时-指定时间)

【懒人必备的定时关机神器】现代人总有些需要让电脑持续工作的场景:通宵下载大文件、挂机渲染视频、后台运行...

自动化生成PDF报告工具

在信息处理需求激增的数字化办公场景中,企业常面临重复性文档制作的效率瓶颈。一款能够自动整合数据、生成标...

RSS订阅内容离线归档工具(按周打包)

信息爆炸时代,RSS订阅仍然是深度内容消费者获取资讯的核心方式。但随着订阅源数量增加,许多用户面临两个现实...

简易待办事项管理工具(支持增删改查任务)

办公室白领小林最近找到了对抗拖延症的秘密武器——他在电脑里装了一款名为"任务盒子"的本地端待办事项工具。这...

网络Ping检测工具(IP连通测试)

在互联网日常运维或家庭网络排障中,一个看似简单的命令却能解决80%的基础问题。当网页加载缓慢、游戏延迟飙升...

视频文件体积优化转换器

在4K分辨率成为标配的当下,手机拍摄的1分钟视频轻松突破500MB,专业设备录制的8K素材更是以GB为计量单位。当存储...

多格式日历转换与提醒工具

现代人的生活节奏越来越快,跨时区会议、旅行规划、项目截止日……各类日程交织叠加,传统日历工具逐渐显得力...

屏幕取色器工具(支持颜色方案导出)

在数字设计领域,颜色是传递情绪、建立品牌认知的核心元素。一款高效的屏幕取色器工具,往往能成为设计师跨越...

系统剪贴板历史记录自动清空工具

办公场景中频繁使用的复制粘贴功能,早已成为效率工具的代名词。很少有人意识到,剪贴板默认保存的历史记录可...

网页正文内容提取工具(正则表达式版)

互联网每天产生数亿级新网页,信息抓取成为数据分析的基础环节。网页正文提取工具作为信息采集的关键组件,直...

CSV-Excel数据列内容筛选工具

在数据爆炸的时代,企业市场部每周需要处理上万条,电商运营团队每日面对数百个商品数据表,科研工作者常被实...

基于PyQt的课程番茄钟联动界面程序

深色主题的交互界面悬浮在屏幕右侧,六个圆形计时模块排成两列,每个模块顶部跳动着不同的课程名称。当《西方...

企业通讯录管理系统(CSV版)

企业通讯录管理一直是内部协作的痛点。纸质通讯录易丢失,Excel表格版本混乱,专业系统操作复杂——这些问题在中...

PDF转TXT自动更新检测工具

在数字化办公场景中,PDF与TXT文件的格式互转需求呈现爆发式增长。某第三方机构2023年数据显示,企业文档处理人员...

文本词频自动化分类标记工具

在信息爆炸的时代,企业市场部每天需要处理超过2000条用户反馈,学术研究者面对上万份文献资料时,传统的人工标...

系统环境变量快速编辑工具

对于开发者或系统管理员而言,配置环境变量是绕不开的高频操作。无论是调试Python项目时需要精准定位第三方库路...

小说人物关系网球形交互式词云平台

在文学创作与文本分析领域,人物关系网的复杂性常使作者与研究者陷入困境。某团队近期推出的三维人物关系分析...

简易RSS阅读器(控制台版本)

在信息爆炸的时代,如何高效获取网络内容成为刚需。一款基于命令行的RSS阅读器悄然进入技术爱好者的视野,它摒...

电脑空闲时间自动提醒装置

办公桌前的咖啡早已冷却,屏幕右下角的时间显示过去了两小时,颈椎隐隐发疼时才发现自己又陷入了"无意识刷屏...

天气查询小工具(调用开放API获取实时数据)

七月午后的雷阵雨总爱搞突然袭击,白领张薇上周就因为没带伞,新买的真丝衬衫被淋得变了形。这种尴尬或许能避...

Tkinter开发的简易注册表备份还原工具

在Windows系统维护中,注册表犹如人体神经中枢般重要。某开发者利用Python的Tkinter库,制作了一款仅3MB大小的绿色工具...

办公文档批量压缩器

日常办公中,文档体积过大常带来诸多困扰:邮件附件发送失败、云端存储空间告急、跨部门协作时传输卡顿……若...

考勤数据完整性校验系统

现代企业管理中,考勤数据作为人力资源管理的核心依据,直接影响薪酬核算、绩效考核等关键环节。传统考勤系统...

文本朗读工具(输入文字转语音播放)

窗外的雨声淅淅沥沥,办公室里的小张却盯着电脑屏幕发愁——这份三十页的行业报告需要在下班前完成阅读。直到...

IP黑白名单自动同步分发工具

在网络安全运维中,IP黑白名单作为基础防护手段,长期承担着过滤恶意流量、限制非法访问的核心任务。传统人工维...

二维码生成与解析工具(文本-URL支持)

随着移动支付与数字化场景的普及,二维码已成为连接物理世界与数字空间的重要介质。据艾瑞咨询数据显示,2023年...

批量压缩图片尺寸调整工具

日常工作中,图片体积过大常导致网页加载缓慢、存储空间告急,社交媒体上传失败等问题频发。传统单张处理模式...

文件批量重命名及格式转换工具(支持图片-文档)

现代办公场景中,文件管理的痛点愈发明显。某互联网公司产品经理张航的经历颇具代表性:他团队上周完成的1200张...

电子表格单元格依赖关系分析工具

在金融建模、数据分析或项目管理场景中,电子表格的单元格公式常编织成一张复杂的逻辑网。当表格规模超过百行...

屏幕截图工具(支持区域-全屏截图)

在信息可视化需求激增的今天,屏幕截图工具已成为数字办公的标配。具备区域截取和全屏捕捉双重功能的核心工具...