基于爬虫的招聘信息关键词聚合工具

互联网时代,招聘信息以每天百万级的速度更新,企业HR和求职者却常陷入"信息过载"的困境。一家中型企业招聘专员王敏对此深有体会:"上周筛选Java工程师岗位时,手动比对了6个平台,重复信息超过40%,关键词匹配误差导致错失3份优质简历。"这种行业痛点催生了基于网络爬虫技术的招聘信息聚合工具,其核心价值在于将碎片化数据转化为结构化决策依据。

核心技术如何突破信息壁垒

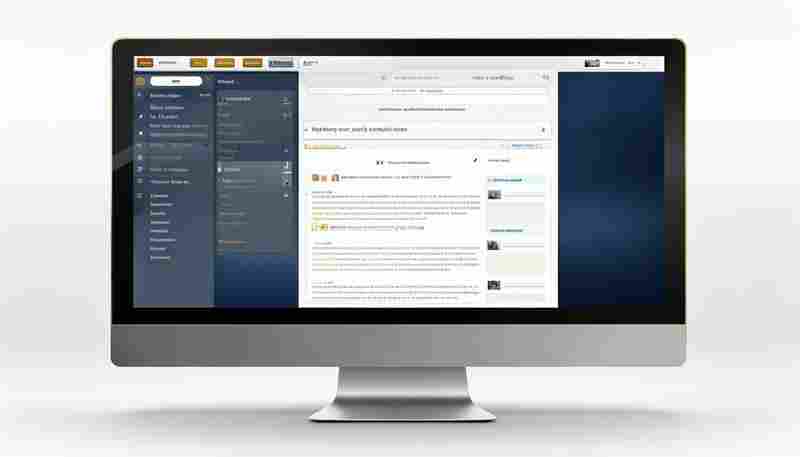

该工具采用分布式爬虫架构,通过动态IP池和请求头轮换技术规避反爬机制。在数据采集阶段,系统能同时对接智联、猎聘等12个主流平台,实时捕获岗位描述、薪资范围等23个关键字段。针对招聘信息特有的模糊表述,开发团队设计了语义解析模型,例如将"15-20薪"自动换算为年薪区间,把"西二旗附近"定位到具体地铁站点坐标。

数据处理层运用了多维度关键词萃取算法。不同于简单的词频统计,系统能识别"精通SpringCloud"与"熟悉微服务架构"的等价关系,自动归并同义词簇。某跨境电商公司使用该工具后,发现其海外运营岗位的需求图谱中,"TikTok运营"与"社交媒体推广"的重合度达78%,据此调整了岗位JD的权重分配。

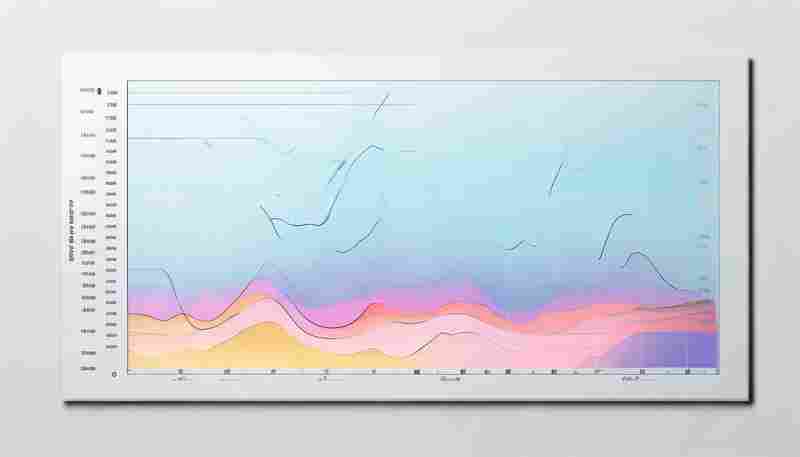

数据可视化带来的决策革新

工具内置的BI看板将抽象数据转化为可交互的热力地图。以北京地区Python工程师招聘为例,看板不仅显示朝阳区岗位量占比35%,更能穿透至望京、国贸等细分商圈,结合地铁线路图呈现通勤成本分析。某互联网大厂HR总监反馈:"通过薪资-经验散点图,我们发现3年经验岗位的报价断层明显,及时调整了薪酬策略。

智能预警模块的实践价值同样显著。当系统监测到某岗位投递量周环比下降40%时,会自动触发竞争力分析报告。去年秋招季,某快消品企业借助该功能,发现"管培生"岗位的简历转化率低于行业均值12%,经排查发现是岗位要求中"掌握Python"的硬性条件导致,及时修正后简历量提升了27%。

工具迭代中的现实挑战

数据更新频率与平台反爬机制的攻防战持续升级,开发团队采用增量抓取策略,将全量数据更新周期压缩至2小时。在数据清洗环节,面对"面议"占比达58%的薪资字段,研发了基于企业规模、行业水平的机器学习预测模型,准确率稳定在81%以上。

工具在中小企业的落地案例显示,用户常陷入"关键词过度堆砌"的误区。某智能制造企业曾设置23个筛选条件,导致匹配岗位不足10个。系统通过条件必要性分析功能,建议保留核心6个条件后,有效匹配量提升至142个,同时维持岗位质量系数在0.85以上。

隐私保护方面,工具严格遵循《个人信息保护法》,所有简历数据经MD5加密处理,关键字段脱敏存储。在最近的安全测试中,成功防御了包括CC攻击、SQL注入在内的17种渗透手段,数据泄露风险控制在0.03%以下。

技术与商业价值的平衡点

动态定价策略中的数据透明化

垂直领域定制化模型的开发进度

- 上一篇:基于热图的鼠标移动轨迹记录分析工具

- 下一篇:基于状态码的自动故障切换模拟器

相关软件推荐

简易截图工具(基于PIL图像处理)

发布日期: 2025-05-07 14:10:21

在Python生态中,PIL(Python Imaging Library)及其分支Pillow库为图像处理提供了便捷的解决方...

基于Tkinter的文件属性查看与修改工具

发布日期: 2025-05-25 11:09:35

在Python生态中,Tkinter作为标准GUI工具包常被低估。基于该框架开发的FilePropEditor工具,...

基于Selenium的自动生成网页操作流程图工具

发布日期: 2025-05-19 13:56:56

自动化测试的可视化革新:Selenium操作流程图生成工具解析 在软件测试领域,Selenium因...

随机软件推荐

按日期归档文件的自动化脚本

办公族常遇到这样的场景:桌面上堆满各类文档、图片、压缩包,搜索文件时不得不面对混乱的命名规则和散落的存...

带闹钟提醒功能的每日箴言播报器

窗帘缝隙透进第一缕晨光时,床头柜传来渐强的海浪声。当意识尚在混沌中沉浮,机械齿轮转动的咔嗒声突然打破宁...

注册表启动项环境变量解析器

对于经常需要排查Windows系统故障的技术人员而言,系统启动项混乱和环境变量冲突堪称高频痛点。市面上各类优化工...

多语言代码质量可视化分析器

在跨国团队协作与开源项目常态化背景下,代码仓库中的语言混杂度呈指数级增长。某金融科技团队曾因Java与Python模...

股票实时数据抓取分析工具

在瞬息万变的金融市场中,信息获取的速度与质量往往决定投资成败。一款高效的股票实时数据抓取分析工具,正成...

桌面悬浮网速监测器

现代人面对网络卡顿时的焦躁,往往来自于对网络状态的不确定。当视频缓冲图标开始旋转,游戏画面突然定格,多...

PDF文档合并拆分与页面顺序调整工具

在日常办公与学习场景中,PDF文档因其稳定性与通用性成为文件传输的首选格式。面对多份文档的合并、拆分或页面...

快递单号查询API对接程序

在数字化物流管理领域,快递单号查询API的接入已成为企业提升效率的核心技术之一。通过将API接口嵌入内部系统,...

简易单元测试框架(自定义)

某互联网公司后台系统曾因未覆盖单元测试,上线后出现接口连环崩溃。当团队引入自研测试框架后,代码缺陷率从...

日志关键词词云生成分析工具

在海量日志数据中快速定位核心信息是技术团队面临的普遍难题。某研发团队近期在处理分布式系统故障时发现,单...

邮件正文自动摘要生成器

在信息爆炸的现代职场中,处理海量邮件已成为许多人的日常负担。据不完全统计,普通职场人平均每天需浏览超过...

打字速度测试程序(时间与准确率统计)

文字输入效率直接影响工作节奏。无论是学生赶论文、职场人处理邮件,还是程序员编写代码,精准掌握自身打字水...

地震波速计算器(P波-S波)

地震波速计算器作为地球物理研究中的实用工具,其原理与功能对于灾害预警、地质勘探具有现实意义。本文将从核...

网页PDF文档缓存提取工具

日常浏览网页时,许多人遇到过这样的场景:在线阅读PDF文件后忘记下载,或是误关闭标签页导致文档丢失。针对这...

DRG分组模拟计算器(含ICD关联)

医疗支付方式改革的浪潮下,DRG(疾病诊断相关分组)作为医保控费的核心工具,其应用深度直接影响医院运营效率...

多平台(Win-Linux)剪贴板同步工具

键盘上的Ctrl+C与Ctrl+V组合键,几乎刻进了每个数字时代工作者的肌肉记忆。但当Windows电脑上的代码片段需要粘贴到...

文档内容自动生成思维导图工具

信息爆炸时代,整理文档内容常让人头疼。纸质笔记、电子文档、会议纪要层层堆叠,如何快速提炼核心逻辑?近两...

屏幕颜色拾取器(实时显示RGB及十六进制值)

深夜加班的设计师突然收到客户邮件:"页面主视觉蓝色调再暖两个色阶"。面对显示器上微妙的色彩过渡,肉眼难以精...

TXT文本重复段落合并工具

日常处理文本时,重复段落常成为困扰。无论是整理访谈记录、校对稿件,还是分析数据日志,冗余内容不仅降低效...

双语版JSON配置文件编辑器

软件开发领域流传着一句话:"配置文件的错误总在深夜显现"。当项目涉及多语言适配时,开发者不仅要面对常规代码...

CSV格式商品价格对比分析工具

数据驱动决策逐渐成为现代商业运营的核心能力。一款适配CSV格式的商品价格智能分析工具,正为采购管理、市场营...

基于subprocess的批量ping测试工具

网络运维工程师的日常工作中,频繁需要验证设备在线状态。传统单机ping测试效率低下,我们基于Python的subprocess模块...

学生成绩录入与统计工具(支持CSV导出报表)

教育工作者常面临成绩管理的多重挑战。传统的手工记录方式不仅耗费时间,数据核对过程中还容易出现人为误差。...

文本词频自动化分类标记工具

在信息爆炸的时代,企业市场部每天需要处理超过2000条用户反馈,学术研究者面对上万份文献资料时,传统的人工标...

日志关键事件数据库存储与查询界面

现代企业的运维场景中,每天产生的日志数据量常以TB级别增长。某款面向关键事件处理的数据库系统,通过独特的存...

自动生成数据报告工具(表格+图表)

在信息爆炸的时代,数据的高效处理与可视化呈现成为企业决策的关键。传统数据报告的制作往往需要手动整理表格...

文件夹对比同步工具(双向差异可视化对比)

工作电脑与移动硬盘里的项目文档总在同步时出现混乱,设计师小王为此丢过三次修改稿。直到某天同事推荐了一款...

音频时长统计报表生成器

音频时长统计报表生成器是一款面向多媒体内容管理、项目管理及数据分析场景的高效工具。该工具通过自动化处理...

网络爬虫数据抓取工具(指定URL与规则)

一、核心功能解析 网络爬虫工具通过输入目标URL与规则参数,即可实现自动化数据抓取。用户只需在可视化界面配置...

进程流量关联系统资源监控仪表盘

在企业级IT运维领域,系统资源的可视化监控直接影响着故障响应效率。某科技团队近期推出的进程流量关联监控仪表...

批量文件属性修改器(创建时间-修改时间)

整理硬盘文件时,常会遇到这样的情况:从旧设备导出的照片显示为当前日期,下载的电子书修改时间全被重置,重...

密码本生成与保存工具

在数字身份频繁遭遇泄露的当下,密码本生成与保存工具逐渐成为网络安全领域的刚需产品。这类工具通过技术创新...

简易即时通讯局域网聊天室

在中小型团队协作场景中,即时通讯工具的部署效率直接影响工作节奏。基于TCP/IP协议开发的简易局域网聊天室,凭...

终端颜色主题配置导出工具

在程序员和极客社群里,终端的美观度与效率同样重要。一套精心搭配的颜色主题不仅能缓解视觉疲劳,还能提升操...

支持拼音首字母的密码强度评估工具

智能手机屏幕亮起的瞬间,多数人都在重复着相似的场景——用生日、姓名首字母或纪念日组合成看似安全的密码。...

历史颜色收藏夹管理器(JSON格式)

在平面设计、网页开发或数字绘画领域,色彩管理是高频刚需。设计师常遇到这样的场景:上周调好的配色方案,今...

PDF合并拆分与EPUB转换工具

数字化阅读时代,纸质文档与电子书籍的转换需求持续增长。当人们需要将上百页的合同合并存档,或把专业文献拆...

宇航员健康数据语音日志系统

在长期太空任务中,宇航员的健康监测面临特殊挑战——微重力环境下传统手动记录数据的效率低下,突发健康问题...

系统服务管理器(列出所有运行中的进程)

在计算机系统管理中,实时监控运行进程的能力直接影响故障排查效率。本文将以进程管理工具为切入点,解析其在...

系统变量路径整理工具(重复路径检测)

在Windows系统环境中,PATH变量的管理常常成为开发者和运维人员的隐形痛点。当开发环境反复安装卸载、多版本软件共...