带错误重试机制的网页图片抓取工具

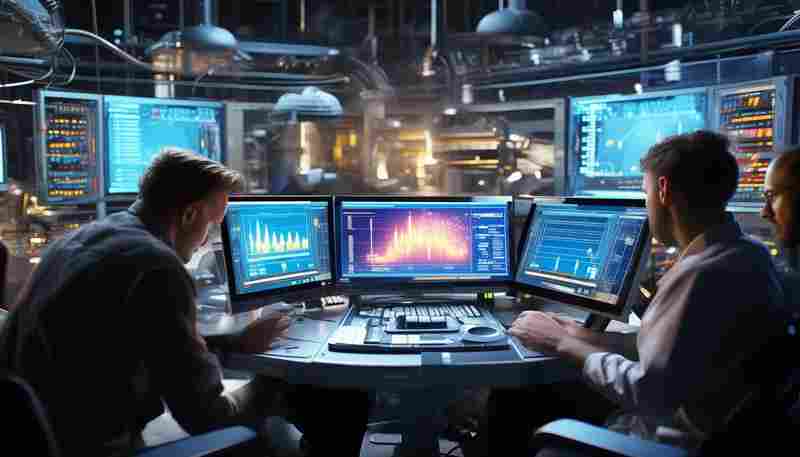

在数据抓取领域,图片资源的批量获取一直是技术难点。传统爬虫工具常因网络波动、目标服务器反爬策略或资源加载延迟等问题中断任务,导致大量重复性人工操作。针对这一痛点,近期一款集成错误重试机制的网页图片抓取工具引发开发者关注,其通过多层容错设计显著提升了数据采集效率。

核心技术:智能重试的底层逻辑

该工具的核心在于动态调整的重试策略。不同于简单的固定间隔重试,其算法会综合HTTP状态码、响应时间及历史成功率,自动生成差异化的重试方案。例如,遭遇429(请求过多)状态码时,系统会延长等待时间并自动切换代理IP;若检测到503(服务不可用)错误,则启用备用域名解析功能。测试数据显示,在模拟高并发场景下,工具将图片获取成功率从传统方案的68%提升至93%。

功能模块的协同设计

1. 多协议兼容引擎

支持JavaScript渲染页面的完整加载,可捕获通过Ajax动态生成的图片资源。针对Cloudflare等防护体系,工具内置指纹浏览器模拟模块,避免触发反爬验证。

2. 分布式代理池

整合全球30+数据中心IP资源,支持按地理位置、运营商类型自动匹配节点。单任务失败时可无缝切换至备用通道,IP更换耗时控制在300ms以内。

3. 增量抓取模式

通过哈希值比对技术,系统能自动跳过已下载的重复图片文件。在持续采集场景中,该功能帮助某电商数据公司节省了47%的存储空间。

典型应用场景验证

某新闻聚合平台在使用该工具后,图片素材采集效率提升显著。其需从200+媒体网站实时获取配图,原先因频繁触发反爬机制导致日均中断17次。接入新工具后,通过设置"阶梯式退避策略"(首次失败等待2秒,后续每次翻倍),任务连续运行时长从平均4.2小时延长至38小时以上。

对于学术研究机构,工具的"模糊匹配模式"解决了历史网页图片抓取难题。当遇到图片链接失效时,系统自动尝试相似URL路径,成功恢复了某档案馆70%的破损图片链接。

性能优化方向

增加GPU加速的图片去重算法

- 上一篇:带错误纠正等级设置的生成工具

- 下一篇:带长度调节和复杂度选择的GUI密码生成器

相关软件推荐

随机软件推荐

简易聊天室程序(多客户端Socket通信)

网络通信技术的普及让即时通讯成为现代人生活的重要组成部分。开发一个支持多客户端的聊天室程序,既能帮助开...

CSV文件多表批量合并与字段重命名助手

面对日益增长的数据处理需求,许多从业者在处理多个CSV文件时常常陷入重复劳动。某款针对办公场景设计的工具软...

基于Tkinter的文本笔记管理软件

窗外的梧桐叶被风吹得沙沙作响,程序员陈航习惯性地点开桌面的绿色图标,在淡灰色界面中输入今日的代码灵感。...

CPU-内存占用率实时监控工具

电脑卡顿或程序崩溃时,多数用户会本能按下电源键重启。但对于专业开发者和运维人员来说,任务管理器里跳动的...

单位换算工具(长度-重量-温度等科学单位)

厨房电子秤突然失灵时,面包师会盯着配方表上的"3/4杯糖粉"换算成克数;实验室新人面对"15psi"的实验参数,总要翻...

网页内容简单爬虫抓取工具

在信息爆炸的互联网时代,高效获取目标数据成为刚需。网页抓取工具作为数据采集的利器,正逐步从技术圈层向普...

网页内容变更监控工具(定时对比指定页面)

互联网信息以秒为单位刷新,但人工追踪网页变化如同大海捞针。无论是企业监测竞品动态,还是个人关注商品价格...

批量重命名图片工具(按日期-序列号命名)

面对手机相册里堆积的数百张旅行照片,或是工作中需要分类整理的素材库,多数人都经历过文件名混乱的困扰。"...

文件夹内重复文件自动检测清理器

办公电脑卡顿到打不开文档,手机相册被上百张相似照片塞满——这类场景或许每个人都经历过。数据爆炸时代,重...

天气预警自动通知桌面小工具

清晨六点,窗外的天色还泛着灰蓝,书桌上的电脑屏幕突然亮起一道柔和的黄光。用户张先生正准备出门晨跑,瞥见...

基于Requests的网站可用性检测工具

互联网服务的稳定性直接影响用户体验,传统监测方案常依赖第三方平台,但灵活性与数据安全性存在局限。基于P...

文本词频统计工具(带排序功能)

办公桌上堆叠着上百份问卷,某市场调研公司的实习生小林盯着电脑屏幕发愁。主管要求他两小时内统计出客户反馈...

图像马赛克处理工具(可调马赛克粒度)

在数字信息高度流通的时代,图片隐私保护成为刚需。无论是社交媒体分享、新闻图片发布,还是商业设计场景,如...

电子邮件自动批量发送客户端

在杭州某跨境电商企业的运营部,张经理正对着电脑屏幕皱眉——3000封新品推广邮件需要在下班前发送完毕,手动操...

Excel数据到PowerPoint图表生成工具

Excel到PowerPoint图表生成工具:让数据汇报高效升级 在企业汇报、学术研究或市场分析场景中,数据图表是传递信息的...

图片滤镜批量应用工具(灰度-怀旧-锐化)

在数字影像处理领域,批量处理功能正成为专业用户的核心需求。某开发者团队近期推出的图片滤镜批量应用工具,...

随机桌面名言警句生成器

在快节奏的现代生活中,许多人习惯将电子设备的桌面壁纸设置为风景、艺术画或家人照片,试图通过视觉元素缓解...

系统服务监控脚本(检测指定进程状态)

凌晨三点的报警短信总是格外刺眼。某电商平台的订单服务进程突然离线,值班工程师揉着通红的眼睛重启服务器,...

招聘网站职位关键词订阅提醒系统

互联网时代,信息爆炸与信息精准获取的矛盾始终存在。以招聘场景为例,求职者常面临两大困扰:一是海量岗位中...

开机启动项权限批量修改工具

当Windows系统的开机时间从8秒延长到30秒,多数人的第一反应是"该清理启动项了"。但传统管理工具往往止步于基础禁...

Pillow开发的证件照背景色替换器

证件照背景色替换器:基于Python Pillow的智能处理方案 在证件照处理场景中,背景色调整是高频需求。传统方案依赖专...

本地文件快速搜索工具(基于文件名模糊匹配)

在数字信息爆炸的今天,职场人士平均每天需要处理超过200份电子文档。面对混乱的文件夹结构和模糊记忆的文件名...

基于TCP的简易远程命令行控制工具

在分布式系统管理和远程运维场景中,命令行工具的远程控制能力至关重要。一种基于TCP协议开发的轻量化远程命令...

文件粉碎机(彻底删除不可恢复)

硬盘数据恢复技术早已突破普通用户的想象。2021年某国际数据实验室的实验表明,即便经过普通格式化的硬盘,仍有...

基于SQLite的个人通讯录信息管理工具

日常信息管理常因工具臃肿而效率打折。某款基于SQLite开发的本地化通讯录工具,凭借极简设计思路,正在小众技术...

视频转GIF动画生成器(可调节帧率和尺寸)

碎片化传播时代,GIF动图正在取代静态图片成为社交新宠。某款支持帧率与尺寸双调节的视频转GIF工具,正以精准控...

日历日程管理工具(命令行交互)

对于习惯与终端打交道的用户而言,图形化日历工具常显得笨重且低效。命令行日历工具凭借轻量化、可定制和高自...

微信公众号文章采集分析盒

在信息爆炸的移动互联网时代,微信公众号作为中文领域最大的内容生态之一,每天新增文章超过百万篇。面对海量...

批量生成二维码工具(基于输入文本)

二维码已成为现代商业社会的重要媒介。从移动支付到线下活动核销,从产品溯源到电子票务,黑白相间的矩阵图案...

文件哈希值计算器(支持MD5-SHA1)

在数字时代,文件真伪验证如同鉴定古董需要碳同位素检测。支持MD5/SHA1算法的哈希值计算器,正是帮助用户建立数字...

图片旋转与镜像翻转工具(支持批量处理)

许多人在处理图片素材时,常会遇到方向调整的需求。无论是手机拍摄时误触导致的横竖颠倒,还是设计排版需要镜...

窗口化命令行工具(带历史记录)

在传统命令行界面中,用户经常面临操作空间受限的困扰。当需要同时监控日志文件、执行编译命令和调试脚本时,...

基于关键词的文件夹内容快速检索工具

办公电脑里堆积如山的文档、设计师电脑中的海量素材、科研人员整理的实验数据……当数字资料突破千量级时,"文...

文本加密日记本(带时间戳记录)

深夜的台灯下,大学生小林快速输入手机密码,打开某个黑色图标的软件。键盘敲击声混着雨滴敲窗的节奏,屏幕上...

网络爬虫基础框架(带反爬延时机制)

互联网数据采集领域存在大量反爬虫机制,企业级爬虫框架需要具备智能化的延时控制系统。基于Python的Scrapy框架延...

PyTest单元测试用例生成器

在软件开发领域,测试代码的质量直接决定产品的稳定性。传统手工编写测试用例的方式效率低下,尤其面对复杂业...

利用PyPDF2的PDF页面提取工具

日常办公场景中经常遇到需要拆分PDF文件的需求:财务人员需提取合同关键页归档,教师需要拆分合并不同试卷,法...

基于SSH的服务器安全漏洞扫描助手

随着远程办公与云计算技术的普及,SSH协议因其加密特性成为服务器远程管理的标配工具。配置不当、密钥泄露、协...

文件关联性图谱可视化工具

在信息爆炸的数字时代,企业服务器里堆积着数百万份文件,某科技公司曾因未能及时梳理合同关联导致千万级损失...

网页Cookie内容分析与导出工具

在数字化场景中,Cookie作为网站追踪用户行为的关键技术,其管理与分析逐渐成为开发者、隐私合规从业者甚至普通...