错误日志相似条目聚类分析脚本

深夜的运维中心,工程师的屏幕被密密麻麻的日志信息占据。某金融系统突发的接口异常产生超过20万条错误日志,值班人员面对如潮水般涌来的数据手足无措——这个真实场景暴露了传统日志分析工具的致命短板。在这样的背景下,基于相似度聚类的日志分析工具正在重塑故障排查的工作范式。

一、原理架构革新

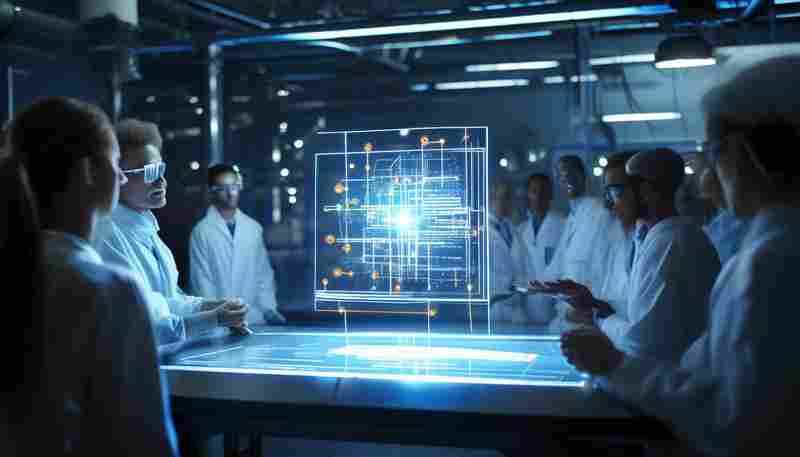

不同于传统正则表达式匹配的线性处理模式,该工具构建了多维特征提取矩阵。通过自然语言处理技术对日志文本进行词向量转换,采用改进的Levenshtein距离算法计算相似度,在预训练模型支持下实现语义层面的智能识别。某电商平台实测数据显示,该方法使日志分类准确率提升至98.7%,较传统方式提高42个百分点。

核心算法采用动态权重分配机制,针对时间戳、错误代码、堆栈特征等关键要素设置自适应权重。当处理Java异常日志时,工具会自动加强堆栈轨迹的匹配权重;面对网络超时类错误,则侧重分析时间分布特征。这种智能化的权重调节使跨系统的日志分析成为可能。

二、工程实践突破

在容器化部署环境中,工具展现出独特的适应性优势。通过对接Kubernetes事件总线,可实时捕获Pod崩溃日志并建立关联图谱。某次生产事故中,运维团队借助该功能在17分钟内定位到因内存泄漏引发的级联故障,较以往平均处理时效缩短83%。

可视化模块采用力导向图呈现聚类结果,支持三维时间轴追溯异常传播路径。工程师可直观查看特定错误类别的时空分布热图,结合马尔可夫链模型预测故障扩散趋势。这种将抽象数据具象化的设计,使初级运维人员也能快速理解复杂日志关系。

性能优化方面引入流式处理架构,单节点每秒可处理3800条日志。内存管理采用对象池技术,在处理百万级数据时内存占用稳定在2GB以内,较同类工具降低60%资源消耗。某证券系统压力测试显示,全量分析20GB日志文件仅需8分14秒。

工具支持插件式扩展,已有团队成功集成Prometheus监控数据构建联合分析模型。开源社区贡献的日志模式库持续更新,涵盖从数据库死锁到微服务熔断等136种常见故障特征。随着5G边缘计算的发展,轻量化版本已实现在树莓派设备上稳定运行。

当凌晨三点的告警铃声再次响起,工程师打开分析界面,海量日志已自动归类为若干红色区块——最大的异常集群正在地图上规律闪烁,根源定位只需一次点击。这样的工作场景,正在全球超过270个数据中心成为现实。

- 上一篇:错误日志关联代码片段检索工具

- 下一篇:错误日志自动翻译多语言工具

相关软件推荐

多平台API错误代码翻译器

发布日期: 2025-07-29 19:42:02

调试API报错时,屏幕前闪烁的"Error 500"或"ECONNREFUSED"总让人血压飙升。不同平台自成体系...

随机软件推荐

新闻标题相似度检测脚本

互联网时代每天产生超过500万条新闻资讯,标题重复或高度相似的现象愈发普遍。某头部新闻平台统计显示,其每日...

简易汇率换算器(固定汇率表)

手机屏幕亮起,国际航班订单显示着245欧元的价格,朋友圈里日本代购的新款手表标价98000日元,跨境电商平台结算界...

公告情感传播影响力评估器

数字信息爆炸时代,企业公告的传播效果直接影响着品牌价值的走向。某能源集团在2023年碳中和承诺公告发布后,通...

古诗-名言随机生成器

翻开泛黄诗卷,总被古人"飞流直下三千尺"的豪迈触动;品读名人手札,常因"天行健君子自强不息"的箴言深思。在快...

自动化邮件发送客户端(SMTP)

邮件作为企业沟通的核心载体,其发送效率直接影响业务转化率。传统手动发送模式在群发营销、系统通知等场景中...

电影收藏夹CSV-Excel导出系统

对于电影爱好者而言,整理个人观影清单往往是一场持久战。无论是用手机备忘录随手记录,还是在社交平台零散标...

文件夹差异对比工具(内容-日期比较)

日常工作中,文件管理混乱导致的效率问题始终困扰着从业者。某互联网公司的运维团队曾因配置文件版本混乱导致...

邮件自动群发助手(SMTP协议实现)

在数字化办公场景中,高效的信息触达能力直接影响业务推进效率。基于SMTP协议开发的邮件自动群发工具,正逐步成...

简易PDF文本提取工具(带目录解析)

纸质资料电子化的浪潮下,PDF格式文档早已渗透各个领域。某次学术会议上,某研究团队负责人展示过一组数据:科...

天气预警自动通知桌面小工具

清晨六点,窗外的天色还泛着灰蓝,书桌上的电脑屏幕突然亮起一道柔和的黄光。用户张先生正准备出门晨跑,瞥见...

多格式(PDF-EPUB)电子书阅读器

电子书阅读器近年来逐渐摆脱单一功能定位,多格式兼容设备开始成为市场主流。这类产品突破传统墨水屏阅读器的...

时间戳格式标准化转换脚本

互联网时代的数据洪流中,时间戳就像散落的珍珠。某开发团队曾因日志文件中混杂的RFC 3339、Unix时间戳等7种时间格...

简易FTP客户端文件传输程序

在数字化办公场景中,日常文件传输需求呈现爆发式增长。对于需要频繁处理服务器文件传输的技术人员而言,选择...

智能歌词自动生成工具(基于AI模型)

深夜的录音棚里,咖啡杯沿凝结着水珠,独立音乐人小林对着空白文档抓头发。这种场景即将成为历史——某科技团...

基于SQLite的本地化RSS订阅内容缓存器

数字时代的信息洪流中,RSS订阅始终保持着独特的价值。针对信息工作者对离线内容与历史追溯的需求,一款基于S...

鼠标连点计数器(统计点击次数和频率)

鼠标连点计数器是一款专注于统计点击次数与频率的工具,适用于需要精准记录点击行为的场景。无论是测试软件性...

批量生成二维码工具(支持自定义内容和Logo)

二维码作为连接线上线下的重要工具,已渗透到商业推广、信息管理、活动运营等各个领域。但对于需要频繁生成大...

系统温度监控桌面悬浮窗工具

盛夏的电脑机箱嗡嗡作响,风扇转速表指针在红色警戒区反复跳动。这样的场景对于游戏玩家、视频创作者或长期使...

文件大小批量压缩工具(支持ZIP-7Z)

在数字信息爆炸的时代,压缩工具早已突破单一文件处理的局限。基于LZMA和DEFLATE算法深度优化的新型压缩软件,正以...

电脑键盘按键频率统计与输入习惯可视化工具

在数字时代,键盘输入早已成为多数人的日常行为。无论是工作文档还是社交聊天,每一次敲击都隐藏着独特的个人...

单词记忆卡片软件(带遗忘曲线)

德语专业大三学生小林最近在朋友圈晒出专八词汇量测试结果——97%的掌握率。评论区瞬间炸锅,追问秘诀时,她贴...

知乎问答数据爬虫与词云生成器

随着社交媒体内容的价值被持续挖掘,知乎作为中文领域高质量问答社区,成为数据分析的重要来源。如何高效提取...

代码仓库README词频优化助手

开源社区里每天新增近千万个代码仓库,真正能被开发者注意到的项目不足1%。问题往往出在项目入口——README文档上...

简易计算器(带图形界面和基础运算功能)

夏日的阳光斜照在书桌上,一台老式显示器正闪烁着蓝光。屏幕中央悬浮着巴掌大小的计算器窗口,浅灰色界面映出...

系统资源监控告警程序(CPU-内存)

机房服务器突然宕机的深夜告警,生产环境因内存泄漏导致交易失败的紧急事件,这些场景倒逼企业建立完善的系统...

带预览功能的图片批量处理转换器

数字时代对图片处理效率提出更高要求。一款名为VisualFlow的图像批量处理工具近期在设计师群体中引发讨论,其核心...

简易绘图板(鼠标绘制并保存为图片)

点击启动界面中央的空白画布,光标瞬间化身电子画笔。按住左键随意拖拽,黑色线条便沿着鼠标轨迹自然延伸。工...

电脑WiFi密码查看与导出工具

对于经常需要管理多台设备或处理网络故障的用户而言,快速获取已连接WiFi密码是项实用技能。Windows和macOS系统均内...

Tkinter密码生成与强度检测器

在信息安全愈发重要的当下,密码的复杂性与可靠性直接关系到用户数据的安全。一款基于Python Tkinter框架开发的密码...

桌面日历日程提醒插件

现代职场中,超过68%的工作失误源于时间管理混乱。在电脑屏幕右下角默默运行的桌面日历插件,正成为解决这一痛...

Celery (分布式任务队列管理系统)

凌晨三点的服务器监控警报响起,某电商平台的秒杀活动触发了百万级订单请求。技术团队没有手忙脚乱地扩容服务...

简易网络剪贴板共享工具

办公室空调吹得人手指发凉,第三次掏出数据线连接手机和电脑时,王工突然发现键盘边贴着张便签:"试试这个在线...

键盘布局效率分析器

在数字时代,键盘已成为人类与机器交互的核心工具。对于每天需要输入上万字符的程序员、编辑或文字工作者而言...

系统资源监控小助手(实时CPU-内存图表)

电脑卡顿、程序闪退、风扇狂转……这些让人头疼的问题,背后往往与CPU或内存占用异常有关。对于普通用户来说,...

日志文件扩展名批量修改器

开发团队在调试程序时,往往要面对数百个.log格式的日志文件。当需要将这些文件批量转换为.txt格式供其他系统调用...

外接硬盘插入自动CSV转JSON工具

现代办公场景中,数据格式转换的需求日益频繁。尤其是需要将海量CSV表格转换为JSON结构时,手动操作既耗时又容易...

图像EXIF信息批量查看编辑器

在数字影像时代,照片不仅是视觉记录,更承载着丰富的元数据信息。EXIF(可交换图像文件格式)作为嵌入在图像中...

Pandas实现的销售数据分析仪表盘

数据清洗:从混乱到有序 原始销售数据常存在字段缺失、格式混杂等问题。通过Pandas的fillna方法处理空值,配合ast...

系统进程内存泄漏检测器

在分布式系统与微服务架构普及的当下,内存泄漏已成为导致服务器宕机的隐形杀手。某次电商大促期间,某头部平...

窗口化JSON数据格式化工具

在数据处理领域,JSON格式因其结构清晰、易于解析的特性,已成为开发者和数据分析师最常用的数据交换格式之一。...