简易网页爬虫(抓取指定URL内容)

工具定位

网页数据抓取已成为信息收集的常规手段。基于Python语言的轻量化爬虫工具因其低门槛特性,常被应用于市场调研、舆情监控等场景。这类工具主要通过发送HTTP请求与解析HTML文档完成数据采集。

核心组件

Requests库承担网络通信任务,相比内置urllib模块,其人性化的API设计显著降低代码复杂度。BeautifulSoup作为解析器,支持多种文档树遍历方式,XPath定位方式在复杂页面结构中更具效率。

实现流程

以采集新闻标题为例,开发者需完成请求头伪装,部分网站会验证User-Agent字段合法性。响应内容经utf-8编码处理后传入解析器,CSS选择器.class或id能精准定位目标元素。数据持久化阶段,csv格式兼顾存储效率与可读性。

```python

import requests

from bs4 import BeautifulSoup

headers = {'User-Agent':'Mozilla/5.0'}

response = requests.get(')

soup = BeautifulSoup(response.text,'lxml')

titles = [h2.text for h2 in soup.select('.news-title')]

```

反爬应对

动态加载内容需切换至Selenium方案,该工具能完整渲染JavaScript。IP封锁问题可通过代理池轮换解决,免费代理源需配合验证机制使用。验证码识别引入第三方OCR服务时,注意成本控制与识别准确率平衡。

测试验证

抓取结果应当包含完整性检查,通过对比页面可见元素数量与获取数据量,可发现潜在解析错误。异常重试机制建议设置3次尝试上限,避免陷入死循环。数据清洗环节要处理特殊符号、空白符等干扰项。

法律边界

Robots协议明确规定采集范围,违反者可能面临法律追责。商业性大规模采集必须获得网站授权,个人研究需控制请求频率。欧盟GDPR等数据保护法规对用户隐私数据有严格限定。

相关软件推荐

简易网络爬虫(指定站点抓取)

发布日期: 2025-04-05 13:55:36

当我们需要快速获取特定网站公开数据时,基于Python的Requests+BeautifulSoup组合已成为技术...

简易数据可视化工具(matplotlib实现)

发布日期: 2025-03-23 09:14:37

一、当数字遇上视觉 一位数据分析师曾调侃:"如果Excel是算盘,Matplotlib就是3D打印机。...

随机软件推荐

Excel工作表批量重命名工具

日常工作中,Excel用户常会遇到工作表标签管理混乱的问题。数十个甚至上百个未命名或命名不规范的工作表标签堆叠...

桌面数独游戏生成与解答工具

桌面数独游戏生成与解答工具近年来逐渐成为逻辑爱好者的必备软件。这类工具通过算法实现谜题快速生成与智能破...

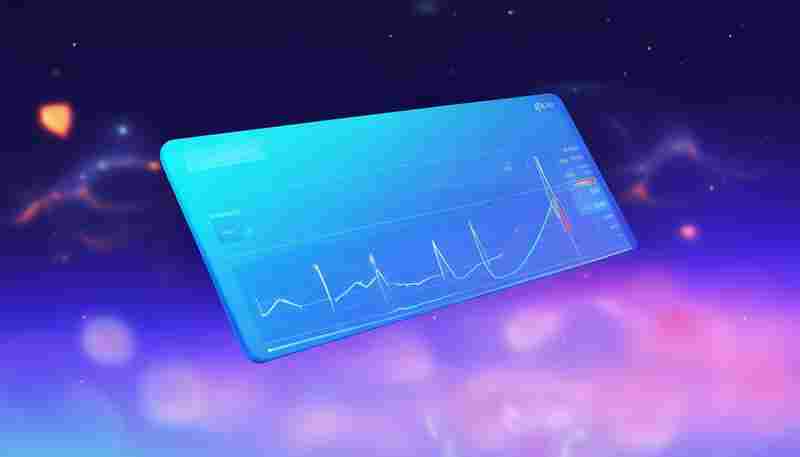

基础系统资源监控仪表盘(CPU-内存)

打开某电商平台的服务器后台,运维主管李明发现监控仪表盘上的CPU曲线连续三次突破。他迅速定位到某台数据库服...

ISO 22301业务连续性计划生成器

全球供应链中断事件频发时,某跨国制造企业通过业务连续性计划生成器,在72小时内完成了全区域应急预案更新。这...

自动截图分类保存工具

在数字化办公逐渐普及的当下,电脑屏幕里堆积如山的截图成为困扰多数人的难题。会议纪要、操作流程、灵感素材...

基于Flask的日志报警Web仪表盘

在服务器集群规模超过50台的生产环境中,运维人员每天需要处理超过200万条日志记录。某电商平台曾因未及时发现日...

简易在线投票系统(Flask+SQLite)

数据库文件生成瞬间,命令行提示符闪过蓝光。SQLite表结构在记事本里铺开,三张基础表构成核心:用户表存储哈希...

天气信息桌面小插件

清晨推开窗,阳光斜斜落在书桌一角,嵌在显示器边缘的天气小插件早已完成数据更新。城市上空漂浮的云朵图案旁...

自动化数据可视化生成器

某广告公司策划经理林薇打开电脑,屏幕上跳动着月度投放的二十组渠道数据。过去需要三天完成的竞品分析报告,...

批量生成PDF发票工具

在数字化办公逐渐普及的当下,企业处理票据的效率直接影响着运营节奏。传统手工录入发票信息的方式不仅耗时耗...

密码强度检测工具(规则库验证与评分)

密码作为网络安全的第一道防线,其强度直接关系着个人隐私与数据安全。随着网络攻击手段的升级,传统密码设置...

简易局域网聊天室客户端与服务器

局域网即时通讯工具在无外网环境或对数据安全要求较高的场景中具备实用价值。一套基础方案通常由服务端程序与...

简易邮件发送工具(支持附件与HTML正文)

在快节奏的现代办公场景中,邮件依然是商务沟通的重要载体。面对频繁的客户联络、营销推广或工作汇报,一款能...

多级目录扁平化处理工具

办公场景中,层级嵌套的文件夹结构常让人头疼。研发部门的历史项目库包含37层子目录,市场团队每年积累的上万份...

简易Markdown文档转PDF格式转换器

在信息处理效率至上的时代,文档格式转换已成为日常办公的刚需。对于习惯用Markdown编写内容的人群而言,如何快速...

简易音乐播放器(PyGame集成)

在Python生态中搭建多媒体应用常会遇到技术选型难题。作为SDL跨平台库的Python封装,Pygame自带的音乐模块(mixer)提供了...

简易画图工具(画笔-形状-颜色选择)

在数字创作领域,基础绘图工具始终占据重要位置。某款支持多平台运行的绘图软件,通过精简核心功能降低了操作...

带验证码识别的简易网络爬虫框架

互联网数据采集领域,验证码始终是自动化工具需要突破的技术难点。本文介绍一款集成验证码识别功能的轻量级网...

触摸屏灵敏度校准工具

现代智能设备中,触摸屏的灵敏度直接影响用户体验。无论是手机、平板还是公共自助终端,屏幕偶尔出现的“点不...

图片像素画风格转换器(可调色块大小)

在数字艺术领域,像素画凭借其复古感和独特的美学风格,始终占据一席之地。将普通图片转化为像素画并非易事—...

电子书格式转换工具(基于ebooklib库)

纸质书脊在书架上逐渐蒙尘的当下,电子书阅读器成为多数人的第二书房。但设备碎片化带来的格式壁垒始终困扰着...

微博情感分析文本预处理流水线工具

微博作为中文社交媒体的核心阵地,每日产生海量用户生成内容。针对平台短文本情感分析需求,一套高效的文本预...

文本输入自动纠错统计器

在数字化办公与日常沟通场景中,文字输入的准确性直接影响信息传递效率。一款名为「语镜」的文本输入自动纠错...

简易计算器GUI工具(支持基本数学运算)

数字时代,几乎每台电子设备都预装计算器软件。对于需要快速处理基础运算的群体而言,一款设计简洁、功能完备...

图片EXIF信息批量编辑器

在数字摄影时代,每张照片的EXIF信息如同一张隐形的“身份证”,记录了拍摄时间、设备型号、地理位置甚至光圈快...

在线课程学习平台

碎片化时代对学习效率提出更高要求,全球在线教育市场规模预计在2025年突破3500亿美元。各类学习平台持续迭代工具...

可导出记录的饮水提醒软件

水是人体正常运转的基础,但快节奏生活中,许多人常因忙碌忽略规律饮水。一款具备数据导出功能的饮水提醒软件...

正则表达式构建的密码强度检测器

密码安全是数字世界的第一道防线。随着网络攻击手段的升级,简单的字母数字组合已难以抵挡暴力破解。基于正则...

文件版本控制工具(基础版Git功能)

清晨的咖啡杯旁,程序员小王面对满屏报错代码,手指悬在删除键上迟迟不敢落下。屏幕右下角的Git图标突然让他想...

社交媒体关键词抓取统计器

在信息爆炸的社交媒体时代,品牌方、营销从业者甚至个体创作者都面临同一个问题:如何从海量内容中快速定位核...

批量提取Excel中超链接地址工具

Excel作为现代办公场景中应用最广泛的数据处理工具,其超链接功能常被用于整合资源信息。当表格内存在数十条甚至...

圣经用户反馈收集分析系统

在数字化浪潮冲击传统宗教传播模式的当下,圣经用户反馈收集分析系统应运而生。这款专为宗教场景设计的工具,...

带闹钟功能的桌面数字时钟(整点报时)

清晨六点,窗外的麻雀尚未苏醒,黑色方盒突然跃动的蓝光划破昏暗。这款带有整点报时的桌面时钟,正用蜂鸣声替...

简易计算器GUI应用程序(PyQt5)

在图形界面应用开发领域,PyQt5凭借其跨平台特性和丰富的组件库,成为许多开发者构建桌面工具的首选框架。基于...

离线版餐饮店菜单库存管理系统

后厨冰柜里冻品库存告急,前厅服务员误将售罄菜品推荐给顾客——这类场景在中小型餐饮门店频繁上演。当收银系...

预约信息自动生成会议纪要模板工具

在快节奏的现代职场中,会议管理往往消耗大量时间。从预约参会人员到整理会议记录,每个环节都可能因人为疏漏...

跨平台视频兼容性检测报告生成器

在视频内容爆炸式增长的今天,一段视频可能需要在手机、平板、网页、智能电视等多终端播放,但不同平台对视频...

局域网聊天室(文字传输)

打开电脑机房的金属门,扑面而来的是此起彼伏的键盘敲击声。二十台显示器蓝光闪烁的间隙,学生们看似专注操作...

简易日历应用(日期计算)

工作台角落堆满便利贴,手机里十几个效率应用来回切换,当代人总在寻找更"智能"的时间管理方案。当我们被复杂功...

取色记录时间轴管理系统

一款以色彩为语言的时间管理工具 在信息过载的日常工作中,如何快速定位关键节点、直观回溯任务轨迹,成为效率...