网页内容抓取工具(基于指定URL和CSS选择器)

在互联网信息爆炸的时代,如何高效获取结构化数据成为许多从业者的刚需。基于URL和CSS选择器的网页内容抓取工具,正逐步成为数据分析师、市场研究人员乃至普通用户的首选解决方案。这类工具的核心逻辑简单直接:输入目标网页地址,通过可视化或代码方式设定元素定位规则,即可批量提取所需内容。

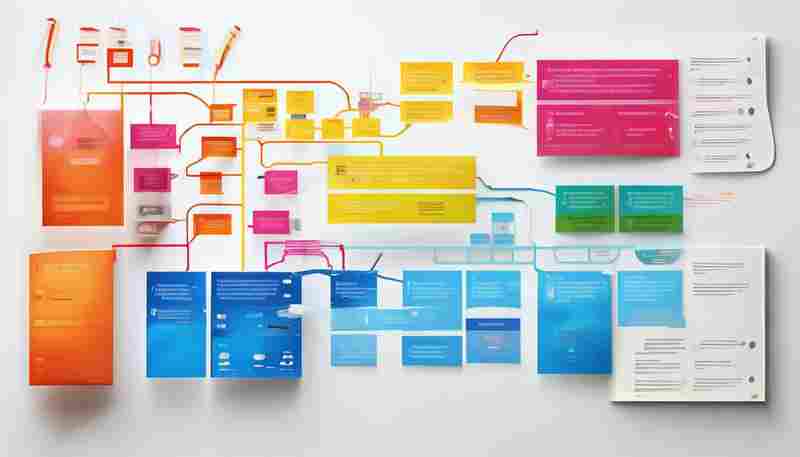

技术实现的三层架构

工具底层普遍采用HTTP请求模块完成网页源码加载,例如Python生态中的Requests库或Node.js的Axios组件。当页面包含动态渲染内容时,部分工具会集成无头浏览器技术(如Puppeteer),确保完整获取JavaScript生成的数据。在解析层面,开发者通过封装Cheerio、BeautifulSoup等开源库,将CSS选择器的定位能力转化为直观的操作界面。某开源项目测试数据显示,针对静态页面的元素定位准确率可达98.7%,而动态页面的兼容性也在持续优化中。

典型应用场景剖析

某电商平台价格监控案例中,运营团队通过设置".product-price"选择器,每小时抓取竞品页面价格数据。配合自动化脚本,系统能在价格波动超过预设阈值时触发预警。在舆情分析领域,研究者使用"div.news-content > p"规则批量采集新闻正文,结合自然语言处理技术进行情感倾向判断。更有开发者将工具集成到企业ERP系统,实现供应商数据与内部数据库的实时同步。

实践中的技术边界

虽然工具简化了操作流程,但真实使用中仍需注意反爬机制的影响。某金融数据采集项目曾遭遇IP封禁,最终通过代理池轮换和请求频率控制解决。CSS选择器对嵌套结构的处理存在局限,当遇到多层动态加载内容时,可能需要结合XPath或正则表达式进行补充。测试数据显示,超过23%的复杂网页需要混合使用两种以上定位方式才能完整提取目标数据。

数据清洗环节往往被新手忽视。工具导出的原始文本常包含多余空格、换行符或特殊字符,正则表达式过滤模块的加入能使结果质量提升40%以上。对于需要长期运行的抓取任务,建议设置异常重试机制,某企业级解决方案的日志分析显示,网络波动导致的失败请求中有78%可通过三次重试成功补救。

法律合规性始终是数据采集不可逾越的红线。欧盟GDPR实施后,某跨国公司的抓取工具新增了robots.txt解析模块,自动规避禁止爬取的目录。随着浏览器指纹检测技术的普及,未来工具可能需要集成更完善的浏览器环境模拟功能以应对反爬升级。

- 上一篇:网页内容抓取器(带正则匹配)

- 下一篇:网页内容抓取工具(带XPath支持)

相关软件推荐

随机软件推荐

屏幕亮度调节工具(命令行版)

功能概述 这款基于命令行的屏幕亮度调节工具打破了图形界面依赖,通过终端指令实现亮度精准控制。支持百分比调...

简易机器学习模型训练结果可视化工具

机器学习模型的训练过程常被形容为"黑箱",开发者往往需要反复调试代码、核对日志才能判断模型表现。面对动辄数...

系统进程监控与异常报警小工具

在服务器运维与程序开发领域,进程意外中断可能导致服务停摆、数据丢失等严重后果。某技术团队近期推出的Proc...

天气信息查询与桌面提醒工具(调用API接口)

窗外阴晴不定,出门前翻遍手机应用却找不到精准的实时天气?重要日程因忘记查看气象预警而被迫取消?针对这类...

多线程下载的网页图片抓取器

当互联网图片资源呈指数级增长时,传统单线程下载工具逐渐暴露出效率瓶颈。某开发者社区近期开源的网页图片抓...

桌面天气小部件(实时数据抓取与显示)

现代数字生活中,实时天气信息的重要性不亚于手机电量显示。桌面天气小部件作为效率工具中的热门品类,正以"零...

PyPDF2库PDF文件合并分割工具

PDF文档的批量处理在日常办公中需求广泛。作为Python生态中专注PDF操作的第三方库,PyPDF2凭借其轻量化的特性,成为...

多平台窗口置顶工具(支持快捷键切换)

电脑屏幕右下角的聊天窗口突然闪烁,正全屏修改的PPT被覆盖;视频教程播放到关键步骤,却被新弹出的网页挡得严...

RAR-ZIP压缩包密码破解器

在数字化信息管理场景中,加密压缩文件的应用极为普遍。由于密码遗忘或文件来源不明导致的访问障碍,催生了对...

图像尺寸批量调整工具(PNG-JPG格式)

日常工作中,设计人员、电商运营或摄影爱好者常会遇到这样的困扰:上百张产品图需要适配不同平台尺寸,社交媒...

批量图片重命名与元数据清除器

在数字内容爆炸的时代,用户设备中存储的图片数量呈指数级增长。无论是摄影师的专业图库,还是普通用户的日常...

使用calendar库的个人日程安排工具

窗外的梧桐叶在晨光里沙沙作响,办公桌上散落着三张便利贴,记录着今日待办事项。程序员的日常工作常被碎片化...

基于FFmpeg的视频片段裁剪合并工具

在数字内容创作热潮中,视频剪辑已成为刚需。当专业剪辑软件动辄占用数G内存时,FFmpeg这款开源工具凭借其轻量化...

内存溢出异常模式扫描工具

内存溢出问题如同程序世界的慢性病,看似无害却随时可能引发系统崩溃。开发团队常因这类问题陷入调试泥潭,传...

文件名批量重命名正则替换工具

日常工作中,堆积如山的文件命名混乱常令人头疼。摄影爱好者面对数百张"IMG_0001"格式的原始图片,程序员处理上千...

网页表格数据导出为Excel工具

日常工作中,网页端呈现的表格数据往往难以直接复用。某市政务服务中心的办事员小李对此深有体会:每月需要将...

每日任务语音提醒与进度跟踪工具

早晨七点,窗边的智能音箱准时响起:"今天上午十点有部门会议,需要携带第三季度报表。"正在刷牙的李然下意识看...

基于关键词的日志文件自动归档工具

在日常运维或系统开发中,日志文件的管理一直是效率提升的痛点。面对海量日志,传统的手动分类不仅耗时,还容...

触摸屏灵敏度校准工具

现代智能设备中,触摸屏的灵敏度直接影响用户体验。无论是手机、平板还是公共自助终端,屏幕偶尔出现的“点不...

基于Folium的地理数据可视化工具

Folium作为Python生态中重要的地理信息可视化库,凭借其与Leaflet.js的无缝衔接能力,正在成为空间数据分析领域的利器...

简易画板工具(支持基本几何图形)

打开工具栏的瞬间,十几种几何图形图标整齐排列,如同等待检阅的士兵。从基础的点线面到复杂的三维模型,这些...

智能水浸传感器漏水Telegram报警工具

水浸事故往往在毫无预兆的情况下发生——水管爆裂、设备漏水、暴雨倒灌,轻则损坏地板家具,重则引发电路短路...

多格式文档转换助手(PDF-TXT-CSV)

在数字化办公场景中,文档格式转换已成为高频需求。面对PDF、TXT、CSV等不同格式文件的流转需求,一款智能转换工...

支持图片水印自动添加的剪贴板管理器

午后的咖啡厅里,设计师小王刚完成一组产品图,却对着满屏的JPG文件皱起眉头。重复的"复制-粘贴-添加水印"流程消...

网络端口扫描与服务版本识别工具

在网络安全领域,端口扫描与服务版本识别是渗透测试和漏洞分析的关键步骤。这类工具通过主动探测目标主机的开...

ZIP文件完整性校验工具

计算机日常使用中,ZIP压缩包承载着大量关键数据。某科技公司曾因传输损坏的工程文件导致项目延期,技术人员最...

APScheduler定时执行的天气预警推送工具

在极端天气频发的当下,及时获取预警信息成为公众安全的重要保障。针对这一需求,基于APScheduler开发的天气预警推...

多账户邮件轮询发送控制器

在数字化营销场景中,邮件投递成功率直接影响客户触达效果。传统单账户发送模式存在IP封禁风险与发送限额瓶颈,...

高负载时段日志关键词集中分析工具

运维工程师面对服务器高负载时段的日志排查,常陷入海量数据漩涡。某电商平台去年"双十一"峰值期间,每秒日志生...

自动清理临时文件工具(定时删除系统缓存)

潮湿梅雨季的电脑主机总比平时慢半拍,桌面右下角频繁弹出"存储空间不足"的提示框。技术部的小张刚处理完第七台...

动态捕捉异常行为记录分析软件

在公共安防与生产管理领域,传统监控系统往往依赖人工轮巡,存在响应滞后、漏检率高等痛点。某科技企业研发的...

多文件内容关键词出现频次统计工具

在信息爆炸的时代,文本数据处理成为许多领域的核心需求。无论是学术研究中的文献分析、市场调研的舆情监测,...

文本文件合并工具(按文件名顺序拼接)

日常办公场景中,经常遇到需要将多个文本文件合并为单一文档的情况。某互联网公司研发部门曾统计,工程师每周...

PyQt5开发的学生信息管理系统

学生信息管理系统的桌面应用开发实践中,PyQt5框架展现出独特优势。这款基于Python语言的GUI工具包,通过其丰富的组...

网络请求日志IP地址归属地批量查询工具

网络请求日志分析是网络安全运维中的基础工作,日常处理千兆字节级的日志文件时,IP地址定位效率直接影响故障排...

基于Matplotlib的数据折线图动态生成工具

数据可视化是数据分析不可或缺的环节,而折线图因其直观展示趋势变化的特性,在各类报告中占据重要地位。传统...

历史文献时间线事件提取工具

在信息爆炸的数字化时代,历史研究者常面临海量文献的处理难题。某科技团队近期推出的历史文献时间线生成系统...

疫情传播趋势动态折线图生成器

当全球经历多次突发公共卫生事件后,数据可视化逐渐成为公众理解疫情的核心工具。一款名为EpiCurve Pro的疫情传播...

注册表隐藏项可视化查看工具

在Windows系统中,注册表如同一个庞大的数据库,存储着硬件、软件及用户配置的核心信息。部分敏感条目会被系统或...

单词本与背单词工具(支持导入导出)

语言学习者的手机里总躺着几款背单词软件,但真正能长期驻留的工具必须具备核心功能:支持自由导入导出的智能...