网页内容爬取与本地存储工具

互联网时代,海量公开数据成为企业及个人开发者的核心资源。面对分散的网页信息,如何高效完成内容采集与结构化存储?本文将介绍四类实用工具链及其典型应用场景。

一、轻量化采集方案

对于小型数据需求,Python Requests + BeautifulSoup 组合展现出极高灵活性。Requests库能绕过部分反爬机制获取动态渲染内容,配合XPath选择器快速定位网页元素。某电商平台价格监控案例显示,开发者通过定时抓取商品页DOM树,可在15分钟内搭建价格波动预警系统。

本地存储推荐使用SQLite嵌入式数据库,其单文件特性便于迁移。测试数据显示,百万级文本数据写入耗时低于3分钟,且支持标准SQL查询语法,大幅降低数据清洗门槛。

二、企业级爬虫框架

Scrapy框架凭借异步处理引擎,可将日均采集量提升至千万级。其中间件系统支持自动切换代理IP、模拟浏览器指纹等反封锁策略。某舆情监测机构采用分布式部署方案,成功突破目标网站的IP频次限制,数据完整率提升至98.7%。

存储端建议搭配MinIO对象存储,兼容S3协议的特性使其能够无缝对接Hadoop生态。实测对比发现,相同硬件环境下,JSON格式数据存储效率较传统MySQL方案提升3倍以上。

三、零代码采集工具

Octoparse等可视化工具开辟了非技术人员的获取通道。拖拽式操作界面支持翻页、滚动加载等交互模拟,内置的OCR引擎可识别验证码及图片文字。某市场研究团队仅用2小时即完成竞品网站5000条产品参数的采集,相较人工录入效率提升40倍。

数据导出支持CSV直连Google Sheets,配合AirTable的看板功能,用户可在云端完成多维数据分析。这种组合方案特别适合快速验证商业假设的场景。

四、混合存储策略

本地化存储不应局限于单一介质。LevelDB键值数据库在处理时序数据时展现出独特优势,其LSM树结构使写入速度稳定在5万条/秒。而Elasticsearch全文检索引擎,则为非结构化数据提供近实时查询能力。某金融机构采用混合存储架构,使历史数据回溯响应时间从分钟级压缩至亚秒级。

硬件层面,NVMe固态硬盘的4K随机写入性能是机械硬盘的80倍,这对高频数据更新场景至关重要。定期使用rsync增量同步工具,可实现多地容灾备份的自动化管理。

合规性问题始终是数据采集的底线,《网络安全法》第二十七条明确禁止破坏性爬虫行为。技术选型时应重点考察工具的请求间隔调节、Robots协议遵守等设计。多云存储架构正在成为新趋势,AWS S3与阿里云OSS的跨平台同步方案可有效规避服务商锁定风险。

- 上一篇:网页内容朗读器(TTS文本转语音播放)

- 下一篇:网页内容爬取工具(关键词过滤版)

相关软件推荐

随机软件推荐

使用SQLAlchemy的本地文件数据库管理器

在数据处理需求日益增长的开发场景中,开发者常面临数据库配置复杂、环境依赖多等痛点。SQLAlchemy作为Python生态中...

办公文档关键词提取工具

纸质文件堆积如山的场景早已成为历史,但数字文档的爆炸式增长带来了新困扰。某科技园区市场部的刘经理最近发...

CSV-JSON数据可视化仪表盘生成器

企业会议室里,市场总监正对着Excel表格中上万行的销售数据皱眉——这是每个数据工作者都熟悉的场景。传统的数据...

网络端口扫描与服务版本识别工具

在网络安全领域,端口扫描与服务版本识别是渗透测试和漏洞分析的关键步骤。这类工具通过主动探测目标主机的开...

文本转语音播放工具(调用本地语音引擎)

在数字化生活场景中,信息获取的便捷性愈发重要。某款基于本地语音引擎的文本转语音工具,凭借其独特设计正在...

基于关键词的批量MP3元数据编辑器

对于音乐爱好者、播客创作者或音频内容管理者来说,整理成千上万的MP3文件往往是一场噩梦。文件名混乱、专辑信...

电脑壁纸自动更换程序

清晨八点,办公桌前咖啡冒着热气,电脑屏幕从莫奈的睡莲渐变到冰岛极光——这种无需手动操作的仪式感,正成为...

摩斯电码实时编解码终端工具

在数字通信主导的时代,摩斯电码依然以其独特的符号系统活跃在无线电、航空航海及密码学领域。针对现代用户需...

使用shutil的文件备份同步工具

在数据安全备受重视的今天,文件备份与同步已成为数字资产管理的重要环节。Python标准库中的shutil模块凭借其简洁...

简易绘图板(支持画笔-颜色选择-保存为图片)

当灵感闪现时,如何快速捕捉脑中的图像?一款名为QuickSketch的桌面绘图工具正成为设计师和绘画爱好者的新宠。这款...

邮件列表去重与格式标准化工具

互联网企业市场部的张琳最近遇到了棘手难题:公司二十万条客户邮件数据中混杂着重复地址、大小写混乱的字符以...

基于Pandas的零售库存预警工具

在零售行业中,库存管理直接影响企业的资金周转与运营效率。传统的库存监控依赖人工盘点或简单表格统计,存在...

简易文件比较工具(文本差异)

日常工作中,文件版本对比是许多人的刚需。程序员需要核对代码改动,编辑得确认文稿修订,财务人员需校验数据...

窗口化JSON数据格式化工具

在数据处理领域,JSON格式因其结构清晰、易于解析的特性,已成为开发者和数据分析师最常用的数据交换格式之一。...

局域网设备在线检测器(ARP扫描弹窗通知)

局域网设备在线检测器(ARP扫描弹窗通知)是一款针对中小型网络环境设计的轻量化安全工具。该工具通过主动监测...

文件关键字批量重命名工具

在日常办公或资料整理中,许多人都会遇到一个难题:如何快速处理成百上千个文件名混乱的文件?手动修改不仅耗...

JSON文件合并拆分工具

在日常开发与数据处理中,JSON格式因其轻量、易读的特点成为主流数据交换标准。面对复杂业务场景时,开发者常需...

股票实时价格提醒工具(使用财经API)

股票市场瞬息万变,价格波动往往发生在分秒之间。基于财经API开发的实时价格提醒工具,正成为投资者把握交易时...

Tkinter文本差异对比工具(高亮显示差异)

办公桌上堆着两份不同版本的代码文件,光标在屏幕上反复跳跃。程序员盯着密密麻麻的字符,突然意识到自己需要...

拼音密码生成与破译工具

近年来,信息安全领域涌现出一批创新型工具,其中以拼音密码技术为核心的产品尤为引人注目。这类工具通过独特...

弱密码检测工具(字典暴力破解基础版)

在数字化浪潮中,弱密码成为多数网络安全事件的突破口。据统计,超80%的数据泄露事件源于密码强度不足。传统人...

古诗文随机生成器(内置语料库)

书房案头,墨香未散。屏幕右下角,光标闪烁于空白的文档——这是许多文学爱好者熟悉的创作困境。当灵感枯竭与...

Git仓库自动备份到百度网盘工具

对于开发者来说,代码仓库的备份是保障项目安全的关键环节。本地存储存在硬件损坏风险,而公有云平台虽然可靠...

PDF文档合并拆分加密批处理工具

现代办公场景中,PDF文档处理需求呈现几何级增长。某款近期在技术论坛引发热议的本地化工具,凭借其独特功能设...

临时文件定期清理工具

日常使用电脑时,D盘突然弹出的红色存储警告总让人措手不及。系统自带的磁盘清理功能往往治标不治本,手动查找...

网站访问日志地理分布图生成器

互联网时代,网站流量分析如同航海图般重要。某次服务器突发故障时,技术团队通过访问日志中的异常IP集群,仅用...

JPG图片色彩模式转换器(RGB转灰度算法版)

屏幕前划过一张张色彩斑斓的图片时,总有人需要褪去它们的颜色外衣。专业设计师处理印刷稿件时,传统媒体工作...

实验化学反应速率动态绘图仪

化学反应速率动态绘图仪作为现代实验室的重要工具,其核心价值在于将抽象的反应动力学数据转化为直观的可视化...

代码文件相似性检测与优化工具

在软件开发领域,代码复用与协作效率之间的矛盾长期存在。随着项目规模扩大和团队分散化,开发者常面临代码重...

实验数据波动范围分析工具

在科研与工程领域,实验数据的波动范围分析是验证结果可靠性的关键环节。随着数据量的指数级增长,传统人工统...

快递包装规格合规性检查工具

近年来,随着电商与物流行业的爆发式增长,快递包装的合规性问题逐渐成为行业痛点。包装尺寸超标、填充物不规...

桌面天气时钟(集成时间与天气API)

亚克力面板与金属边框的碰撞营造出简约科技感,6英寸IPS显示屏在任意角度都保持着清晰的显像效果。这款桌面天气...

天气数据自动爬取提醒工具

气象信息对日常生活、商业决策和行业规划的重要性不言而喻。传统的人工查询方式效率低下,且难以应对突发天气...

调用Twilio API的短信验证码发送程序

短信验证码工具的技术实现与应用价值 在互联网产品的用户身份验证环节,短信验证码作为核心验证手段,直接影响...

文件类型检测工具(根据扩展名)

在数字文件的海洋中,文件扩展名如同船舶的旗帜,直观标识着各自的身份属性。专门针对文件扩展名设计的识别工...

批量科学计数法转换工具(支持Excel数据处理)

科研工作者和数据分析师常面临一个共同挑战:如何高效处理海量科学计数法格式的数值。传统Excel表格中,当数字超...

窗口化计算器支持公式运算

现代工作场景中常出现这样的画面:工程师在调试设备参数时频繁切换计算器与图纸,科研人员处理实验数据需要同...

桌面倒计时工具(支持多个事件提醒)

窗外的阳光斜斜洒在办公桌上,左边堆着未拆封的会议纪要,右边电脑屏幕跳动着五颜六色的工作群消息。当现代人...

正则表达式文件名拼音转换工具(支持多音字)

正则表达式文件名拼音转换工具上线以来,成为开发者处理中文路径的利器。这款工具针对中文文件名在跨平台传输...

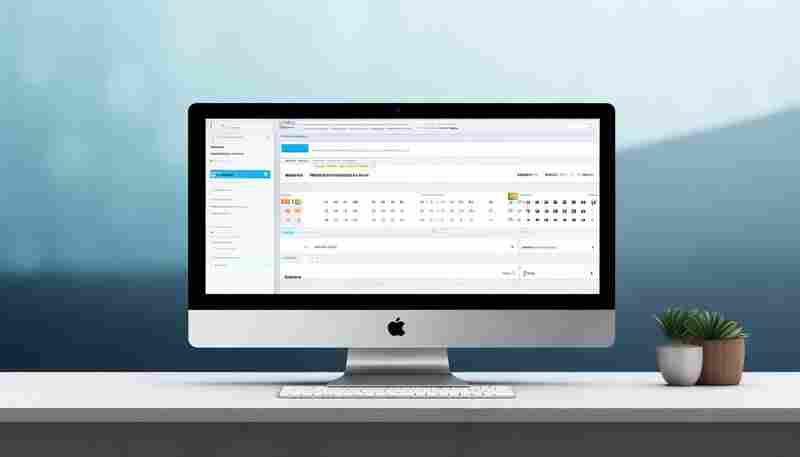

日历日程管理工具(支持iCal格式导入)

日历管理工具早已成为现代人对抗碎片化生活的必需品。当用户需要整合来自不同平台的日程数据时,支持iCal格式导...