网站访问量统计爬虫脚本

在数字化运营中,实时掌握网站访问量数据是优化用户体验、调整市场策略的重要依据。传统的数据统计工具虽然便捷,但在灵活性与深度分析层面存在局限。一款轻量级、可定制化的爬虫脚本,成为许多技术团队解决这一痛点的选择。

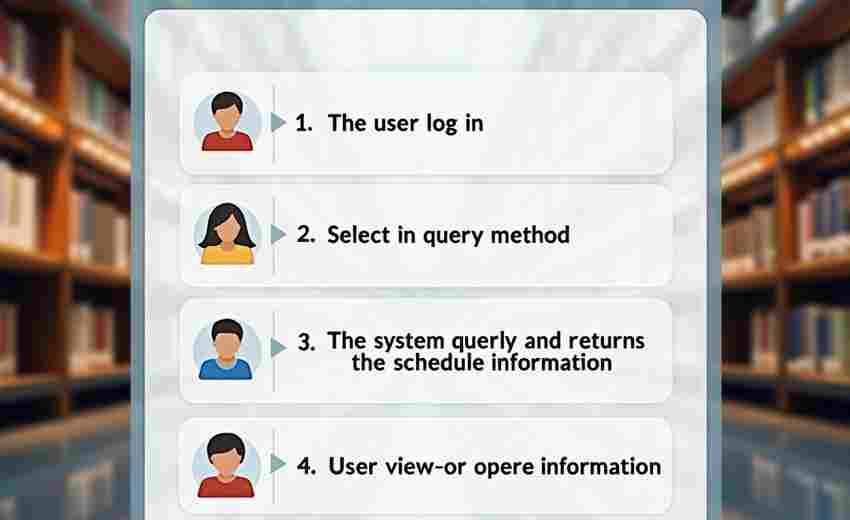

这类脚本的核心功能是通过模拟用户访问行为,抓取目标网站的页面流量、用户停留时长、访问路径等关键指标。技术实现上,通常基于Python语言开发,结合Requests库或Scrapy框架发送HTTP请求,并通过正则表达式或XPath解析返回的HTML数据。部分脚本会集成代理IP池与随机请求头功能,以应对反爬虫机制。

适用场景与优势

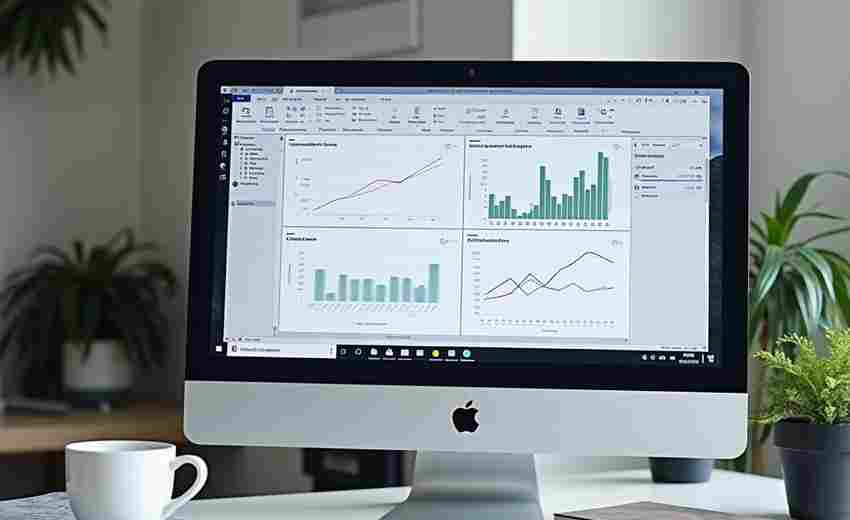

对于中小型网站,尤其是缺乏成熟数据分析后台的团队,爬虫脚本能以极低的成本实现数据采集。例如,电商平台可通过脚本追踪促销活动期间不同页面的流量波动;内容型网站则能分析热门文章的点击规律,优化推送策略。脚本支持自定义数据存储格式,如直接导入MySQL数据库或生成可视化报表,方便与其他业务系统联动。

爬虫脚本并非万能。其局限性主要体现在动态网页的数据抓取上。例如,依赖JavaScript渲染的页面元素(如用户行为埋点)可能需要配合Selenium等工具实现动态加载,这会导致代码复杂度与运行耗时增加。高频访问可能触发目标服务器的防护机制,需通过调整请求间隔或分布式部署来规避风险。

注意事项

法律合规性是首要前提。在部署脚本前,需确认目标网站的Robots协议是否允许爬取,并避免涉及用户隐私数据。对于需要登录的页面,建议通过官方API接口获取授权,而非暴力破解。

脚本的稳定性依赖持续维护。例如,目标网站改版可能导致数据解析规则失效,需定期更新代码逻辑。建议在脚本中增加异常处理模块,记录访问失败日志,便于排查IP封禁或网络波动问题。

数据清洗环节不可忽视。爬取的原始数据常包含重复或无效信息,需通过去噪、归一化等操作提升分析准确性。例如,过滤爬虫程序自身的访问记录,或剔除因页面跳转导致的重复统计。

合理控制爬取频率,避免对目标服务器造成过大负载。通过设置随机延迟参数,既能降低被封禁概率,也能体现技术的边界意识。

- 上一篇:网站访问日志分析工具(流量统计可视化)

- 下一篇:网站证书到期提醒监控工具

相关软件推荐

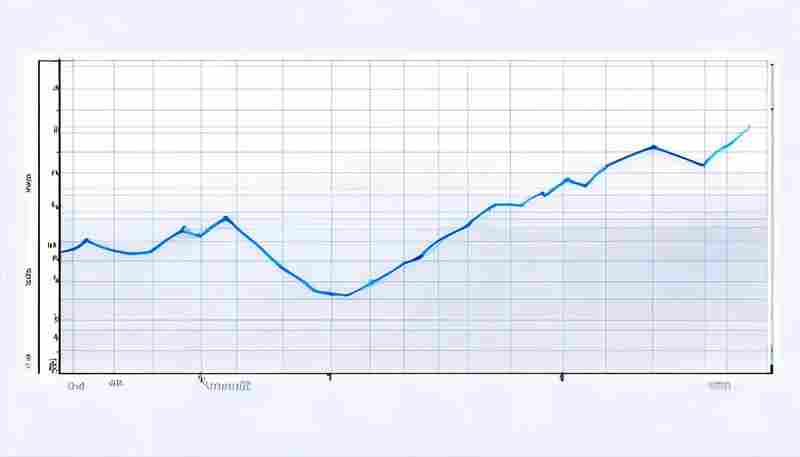

利用Matplotlib生成数据统计折线图工具

发布日期: 2025-05-04 10:08:46

Matplotlib作为Python生态中应用最广泛的可视化工具库,在数据统计分析领域占据着不可替...

随机软件推荐

数字取证文件哈希校验分类器

在电子证据固定与数据溯源领域,哈希校验技术长期扮演着基石角色。随着电子设备存储量呈指数级增长,传统人工...

自动生成检测统计图表工具

数据可视化领域近年来涌现出一批创新工具,其中基于AI的统计图表自动检测系统正引发行业关注。这类工具突破了传...

基于Bokeh的交互式数据可视化面板

当数据规模突破传统图表承载极限时,工程师们常陷入静态报表与动态需求间的矛盾。某金融科技团队曾遭遇典型困...

Flask-轻量级Web应用框架

在Web开发领域,工具的选择往往直接影响项目效率与维护成本。对于追求灵活性与简洁性的开发者而言,Flask凭借其轻...

Tkinter可视化正则表达式测试器

许多开发者都有过这样的体验:面对密密麻麻的正则表达式代码,即便反复检查语法也难以及时验证匹配效果。某位...

系统资源占用实时监控桌面悬浮窗工具

电脑突然卡顿的瞬间,设计师刚渲染到90%的工程文件突然崩溃,程序员调试中的代码界面陷入静止,这种场景让每个...

基于PySpark的大数据处理入门工具

在大数据技术生态中,PySpark凭借其独特的混合架构逐渐成为企业级数据处理的首选方案。作为Spark计算框架的Python接...

外接存储设备空间监控器

现代办公场景中,外接硬盘、U盘、NAS等存储设备已成为数据流转的核心载体。某互联网公司近期因未及时清理监控视...

日志文件行内容长度分布分析工具

运维工程师张磊盯着屏幕上持续刷新的日志文件,密密麻麻的字符流中突然出现数行超过2000字节的记录。这种异常现...

定时任务进程调度监控器

在服务器运维领域,定时任务(Cron Job)的稳定性直接影响业务系统的可靠性。从数据备份到日志清理,从报表生成到...

办公文件内容批量搜索工具(跨文档检索)

在数字化办公场景中,文件管理效率直接影响工作质量。面对海量文档、邮件、表格与幻灯片,传统搜索工具常因功...

多用户带宽配额使用进度条监控

在数字化办公场景中,网络带宽的动态分配与监控直接影响团队协作效率。针对企业或机构内多用户共享带宽的场景...

科学实验温度湿度数据记录器

在精密科研领域,环境参数的毫厘偏差可能导致实验结论的颠覆。一台手掌大小的黑色长方体设备,常被科研人员固...

带提醒功能的待办事项清单管理器

纸质便签贴在电脑屏幕边缘的日子正逐渐远去。数字时代的时间管理工具正在经历一场静默革命,核心战场聚焦在如...

网页爬虫数据自动保存到SQLite数据库工具

在数据驱动的互联网时代,网页爬虫技术已成为企业及开发者获取信息的重要手段。如何高效存储和管理海量爬取数...

请求参数完整性校验工具

互联网应用的每一次请求都可能携带数十个参数,这些参数如同进入系统大门的"访客"。2021年某电商平台因未校验优...

批量替换HTML文件中链接的迁移工具

某次网站架构升级时,我在服务器日志里发现上百个失效链接。传统文本编辑器处理多层级嵌套标签经常出错,手动...

Tkinter制作的定时休息提醒工具

长时间面对电子屏幕工作已成为现代职场常态,随之而来的颈椎劳损、视觉疲劳等问题不断困扰着从业者。基于Pyth...

屏幕截图工具带矩形选区功能

日常办公中,超过83%的职场人每周截图超过20次。在众多截图工具里,矩形选区功能看似基础,实则藏着影响效率的关...

简易数独游戏(难度选择提示功能)

1. 界面简洁,门槛低 打开工具的初始界面,用户会直接看到三个难度选项按钮:初级、中级、高级。这种直白的设计...

批量压缩包文件名规范化工具

日常工作中经常遇到这样的情况:从不同渠道获取的压缩文件,文件名混杂着日期、版本号、临时编号等无序信息。...

热搜日报自动同步到微信公众号助手

对于新媒体运营者而言,每日追踪热点并转化为公众号内容是一项耗时的工作。手动搬运热搜不仅效率低,还容易错...

短视频封面图批量提取与合成工具

短视频创作者常被一个问题困扰:如何在有限时间内高效管理海量素材。面对每天数十条视频的封面处理需求,手动...

多文件合并分割处理工具

面对日常办公或项目协作中堆积如山的文件,如何快速整理分散内容或拆分大型文档成为痛点。一款功能全面的多文...

定时备份任务完整性验证程序

在数字化时代,备份任务已成为企业数据保护的标配操作。许多场景下,用户往往陷入"备份即安全"的认知误区,忽视...

CSV文件跨平台兼容性检测工具

CSV文件作为数据交换领域的通用格式,几乎渗透到所有行业的日常工作中。这种以逗号分隔的文本文件看似简单,却...

评论内容自动翻译多语言工具

当一条中文产品评论被墨西哥用户精准理解,当法语用户的反馈实时转化为日语呈现在开发者面前,语言差异带来的...

办公文件自动归档分类工具(按扩展名-日期)

桌面上散乱的PDF、月末成堆的Excel报表、项目文件夹里混杂的图片文档,这些场景对职场人来说都不陌生。为解决文件...

网络爬虫结果自动保存为CSV工具

在数据采集领域,网络爬虫的产出管理直接影响着工作效率。当海量数据如潮水般涌来时,如何实现结构化存储成为...

植物养护提醒工具(生长周期记录)

朋友家阳台上的琴叶榕又秃了。她盯着手机日历叹气:"明明上周浇过水,叶子怎么又黄了?"这场景养植物的人都不陌...

成语接龙成语接龙接龙成语接龙接龙对战回放查看器

在传统文化与现代科技碰撞的当下,一款名为"成语烽火台"的在线对战平台正悄然掀起热潮。其内置的接龙对战回放系...

简易网络爬虫框架(带反爬策略)

互联网数据采集领域持续上演攻防战。某第三方统计平台显示,2023年全球网站部署反爬策略的比例较三年前增长217...

基于Sys模块的系统环境检测工具

在Python生态中,SysInspector作为基于sys模块的轻量级检测工具,正在改变开发者获取系统环境信息的方式。这款工具不...

自动化系统备份工具(按计划任务执行增量备份)

深夜的机房响起警报声,某电商平台的数据库服务器突发故障,运维人员打开备份管理系统,鼠标轻点就恢复了半小...

定时截图工具(支持自定义保存路径)

屏幕截图作为现代办公高频操作,传统手动截取方式已无法满足特定场景需求。近期测试中发现一款支持定时截图及...

股票价格波动邮件预警工具

股票市场瞬息万变,价格波动往往在几分钟甚至几秒内决定投资者的盈亏。对于普通投资者而言,全天候盯盘既不现...

简易网络爬虫(抓取公开API数据)

互联网时代的数据获取方式早已从传统网页解析转向更高效的API接口调用。对于普通开发者或数据分析师来说,掌握...

分布式节点响应时间聚合分析平台

在数字化业务高速扩张的背景下,全球某头部电商平台曾因突发的响应延迟导致当日交易额下降37%。事后分析发现,...

文件操作回收站系统

当办公电脑的存储空间被临时文件占满时,很多人会下意识按下Shift+Delete组合键。某医疗机构的档案管理员张敏正是...

扫描文档转WebP工具(自动二值化处理)

纸质文档的数字化处理一直是办公场景中的刚需。传统扫描工具生成的PDF或JPG文件常因体积过大、清晰度不足影响传...