使用Scrapy框架的定向数据采集工具

在互联网数据呈指数级增长的当下,如何精准获取特定领域的信息成为企业数字化转型的关键。Scrapy框架作为Python生态中最成熟的爬虫工具链,凭借其模块化设计及可扩展性,正在被越来越多的开发者用于构建工业级数据采集系统。

该框架通过Engine-Scheduler-Downloader-Spider-Pipeline的五层架构,实现了数据采集的全生命周期管理。以某电商平台价格监控系统为例,开发者通过继承scrapy.Spider类定义抓取规则,配合XPath或CSS选择器精准定位商品价格元素。中间件系统的高自由度配置,允许开发者插入代理IP池、请求头随机生成等反反爬策略,实测可规避85%以上的常规反爬机制。

异步网络请求机制是Scrapy区别于传统爬虫工具的核心竞争力。在抓取新闻门户网站时,单个爬虫实例可维持每秒20个页面的稳定采集速度,配合Redis队列实现分布式部署后,数据吞吐量提升至传统多线程方案的3倍以上。某金融数据服务商的技术团队通过优化下载延迟设置,将证券信息采集的完整度从78%提升至99.2%。

数据清洗环节的Item Pipeline模块支持自定义处理链。某舆情分析系统开发者构建了包含HTML净化、敏感词过滤、实体识别的三级处理管道,使原始数据的结构化效率提升40%。结合Scrapy内置的Feed导出功能,处理后的数据可直接对接Elasticsearch或Hadoop生态组件。

在实际部署中需要警惕两个技术陷阱:首先是遵守Robots协议的法律边界,某科技公司曾因过度抓取被判赔偿230万元;其次是分布式环境下的任务去重问题,采用布隆过滤器替代传统MD5校验可使内存占用减少60%。随着Headless Browser技术的集成,动态渲染页面的采集成功率从67%跃升至92%。

数据存储环节的扩展接口支持对接云数据库,某跨国调研机构通过自定义FTPPipeline实现了跨国服务器的定时同步。日志监控系统的深度整合让运维人员能实时追踪5万个采集任务的健康状态。异常重试机制配合智能降频策略,有效应对临时性封禁而不中断整体采集进程。

JavaScript渲染页面的处理仍存在性能瓶颈,采用Splash服务的混合方案可将单页加载时间压缩至1.2秒以内。针对验证码识别场景,部分开发者尝试集成深度学习模型,在数字验证码场景达到98%的自动识别准确率。未来随着WebAssembly技术的普及,浏览器环境的模拟效率有望获得突破性提升。

相关软件推荐

使用matplotlib的数据可视化图表生成工具

发布日期: 2025-04-23 11:29:15

数据可视化是信息传递的高效载体。作为Python生态中最经典的绘图库,Matplotlib凭借其灵...

Flask实现RESTful API快速开发框架

发布日期: 2025-05-22 18:06:00

在Python生态中搭建RESTful API时,Flask因其灵活性和易用性脱颖而出。这个微型框架通过扩...

随机软件推荐

简易PDF文本提取工具(输出纯文本文件)

日常工作中常会遇到需要提取PDF文档内容的场景。面对加密文件或扫描件,传统复制粘贴方式效率低下且易出错。针...

基于SQLite的运动数据库管理系统

当前运动领域数据管理存在碎片化痛点,健身房、运动队、可穿戴设备产生的多维数据亟待整合。某开源技术团队近...

简易小说章节字数变化折线图工具

写作过程中,章节字数的波动往往暗藏叙事节奏的秘密。传统的手工统计耗时费力,且难以形成直观认知。一款专为...

窗口置顶-透明度调节工具(Win32API实现)

窗口管理利器:Win32API 实现置顶与透明度调节 在Windows系统日常使用中,多窗口切换的效率问题常被忽视。当用户需要...

网络端口扫描工具(IP地址范围检测)

凌晨三点的机房,服务器指示灯在黑暗中明明灭灭。某金融公司的安全工程师张工突然收到告警:内网某台数据库服...

屏幕亮度调节工具(命令行版)

功能概述 这款基于命令行的屏幕亮度调节工具打破了图形界面依赖,通过终端指令实现亮度精准控制。支持百分比调...

桌面便签备忘录提醒程序(带定时功能)

在快节奏的现代生活中,时间管理逐渐成为刚需。桌面便签备忘录提醒程序作为办公场景的常见工具,凭借轻量化和...

邮件自动群发助手(SMTP协议实现)

在数字化办公场景中,高效的信息触达能力直接影响业务推进效率。基于SMTP协议开发的邮件自动群发工具,正逐步成...

自动化代理配置的RSS订阅解析工具

互联网时代的信息洪流中,RSS技术始终保持着独特的生命力。近期市场涌现出一款支持自动化代理配置的RSS订阅解析...

任务计划执行上下文切换记录器

在快节奏的工作场景中,任务切换带来的隐性成本常被低估——从写代码到回复邮件,从会议沟通到突发问题处理,...

命令行式数独游戏生成与求解器

在终端环境中,一款名为Sudoku-CLI的工具凭借其轻量化设计与高扩展性,正在技术社区引发关注。作为专注于数独生成...

Requests网络请求与HTTP客户端库

在Python生态系统中,Requests库长期占据HTTP客户端工具下载量前三的位置。这个由Kenneth Reitz在2011年创建的第三方库,用...

简易区块链哈希生成演示器

互联网档案馆的某个角落躺着这样一条用户评论:"学区块链两年,直到看到哈希值动态生成的过程,才真正理解什么...

多窗口贪吃蛇控制台游戏

多窗口贪吃蛇控制台游戏开发工具包近期在编程社区引发关注。这款开源框架专为C++/Python开发者设计,通过终端模拟...

学术文档预处理格式优化器

纸质文献堆叠的书桌上,咖啡杯边缘残留着深褐色的渍迹。屏幕前的青年学者反复调整着文档中的引用编号,光标在...

连续重复数据包网络监控器

在网络通信中,重复数据包通常被视为"冗余噪音"。它们可能由设备故障、配置错误或恶意攻击引发,长期堆积不仅浪...

多平台商品价格历史波动分析工具

在电商促销活动频繁的今天,同一件商品在不同平台的价格差异可能高达30%甚至更多。消费者常常因信息不对称而错...

简易计算器应用(带历史记录功能)

桌面上总少不了一款计算器应用。无论是核对账单、规划预算还是处理临时性的数学问题,数字计算早已融入日常生...

基于关键词的本地文档全文检索工具

信息爆炸时代,个人电脑中堆积的文档数量常以千计。从工作报表到学术论文,从合同协议到读书笔记,如何在需要...

Python实现的批量邮件内容替换工具

在日常办公场景中,邮件内容的批量处理常让人头疼。例如营销团队需要为不同客户定制化邮件内容,或行政部门需...

简单网页内容变更监控工具

互联网信息的更新速度远超想象。如何第一时间页变动?针对这一需求,网页内容变更监控工具应运而生。这类工具...

带BOM头管理的UTF系列转换器

在跨平台文本处理过程中,编码格式的差异常导致文件内容显示异常。某款专注解决UTF系列编码问题的转换工具,通...

支持备份任务暂停-继续的控制工具

在日常数据管理中,备份任务的稳定性直接影响业务连续性。突发网络中断、资源抢占或人为操作干扰常导致备份流...

简易网络爬虫工具(requests+正则表达式)

在信息爆炸的互联网时代,如何快速获取网页数据成为程序员的基本功。基于Python的requests库配合正则表达式,构成了...

微博超话签到自动提醒打卡工具

在微博超话生态中,签到打卡已成为粉丝维护社区活跃度的日常动作。手动操作不仅消耗时间精力,漏签导致的积分...

磁盘垃圾文件清理工具(按扩展名分类)

电脑硬盘仿佛一间堆满杂物的仓库,每天产生的临时文件、缓存数据、下载残留都在蚕食存储空间。手动查找这些分...

批量文件头BOM添加-移除器

在日常文件处理中,BOM(Byte Order Mark)是一个容易被忽视却可能引发麻烦的存在。作为文件开头的隐藏标记,BOM本意...

图片元数据批量修改与清理工具

在数字时代,每张图片背后都隐藏着大量元数据——从拍摄设备型号、地理位置到版权信息,这些数据既是便利的标...

桌面宠物动画(交互式动态壁纸)

当电脑桌面不再局限于静态图片,动态壁纸开始成为用户展现个性的新选择。而在众多动态壁纸类型中, 交互式桌面...

系统资源实时监控工具(CPU-内存-磁盘占用率)

凌晨两点,某电商平台运维工程师的电脑突然发出刺耳警报——内存占用率突破95%红线。此刻正逢年度大促流量洪峰...

基于日期标记的增量备份管理器

在数字化办公环境中,企业服务器每天产生超过3.8TB的业务数据,其中32%的文件存在重复修改现象。传统全量备份方案...

批量视频缩略图生成工具(固定时间截取)

在视频内容爆炸式增长的今天,如何快速管理海量素材成为许多从业者的痛点。以某电商平台为例,运营团队每天需...

股票相关法律文件关键词检索工具

资本市场的法律文本向来以庞杂著称。招股说明书动辄数百页,并购协议嵌套多层条款,股东权益变动报告涉及交叉...

联系人信息分类与快速检索工具

现代人手机通讯录动辄上千人,工作伙伴、亲友、服务商混杂一团。周末想约朋友聚餐,得在列表里翻找半小时;临...

TextBlob文本处理简化库

在自然语言处理领域,Python凭借丰富的库生态占据重要地位。而TextBlob作为一款轻量级工具,因其易用性和功能整合能...

简易贪吃蛇游戏(键盘控制-积分系统)

上世纪70年代诞生的贪吃蛇游戏,凭借简单规则与独特机制在移动设备时代迎来爆发。随着技术发展,如今开发者更注...

Tkinter批量图片格式转换器

夏日的午后,程序员林涛盯着电脑里上千张WebP格式的图片发愁。同事传来的设计素材包在Photoshop里无法直接编辑,批...

基于TXT的简易数据库查询系统

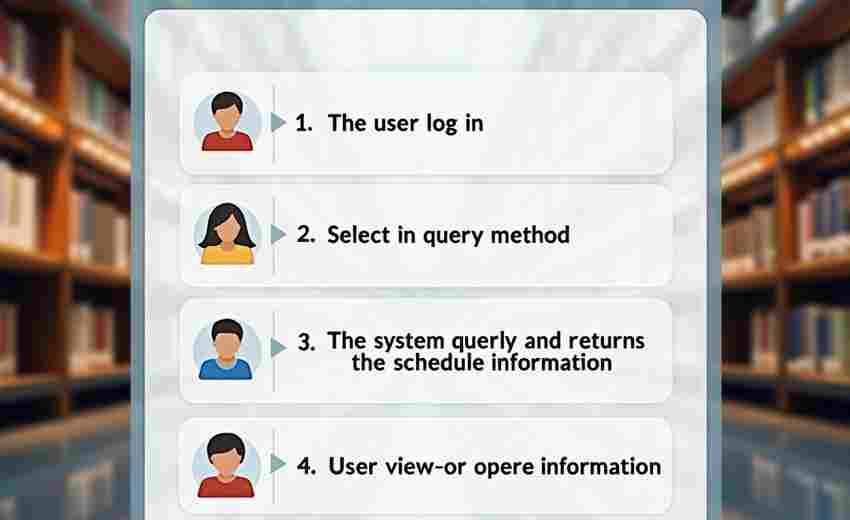

在数据处理需求日益增长的环境下,许多中小型场景对数据库的轻量化需求愈发明显。传统关系型数据库虽然功能强...

自动化图片备份转换工具(本地+云端)

当代人的手机相册存储着大量珍贵瞬间,但存储卡意外损坏、设备丢失导致的记忆断层时有发生。某调研机构数据显...

翻译结果导出工具(支持CSV-Excel)

在跨国协作频繁的数字化办公场景中,语言转化工具逐渐成为刚需。当翻译工作者完成核心工作后,如何将海量译稿...