基于Requests的网页内容定时抓取工具

Requests库作为Python生态中最受欢迎的HTTP客户端工具,凭借其简洁的API设计和高效的网络请求能力,在网页数据抓取领域占据重要地位。结合定时任务机制构建的自动化采集系统,可有效解决持续监控网页内容变化的实际需求。

核心模块的协同运作

定时抓取工具由三个基础组件构成:请求调度器、内容解析器、数据存储器。请求调度器采用APScheduler或schedule实现周期性任务触发,通过Requests的Session对象维持持久连接。内容解析模块通常搭配BeautifulSoup或lxml完成节点定位,异常重试机制需内置在请求层应对反爬策略。

关键代码实现细节

设置随机User-Agent头可规避基础反爬检测,通过fake_useragent库动态生成请求头效果更佳。代理IP池的集成需要构造requests.adapters.HTTPAdapter子类,建议在每次请求前调用代理服务API获取可用IP。针对JavaScript渲染页面,可设置隐性等待时间配合Selenium辅助抓取,但会显著增加资源消耗。

```python

from apscheduler.schedulers.blocking import BlockingScheduler

import requests

from bs4 import BeautifulSoup

def crawler_task:

session = requests.Session

response = session.get(' timeout=15)

soup = BeautifulSoup(response.text, 'lxml')

数据提取与存储逻辑

scheduler = BlockingScheduler

scheduler.add_job(crawler_task, 'interval', hours=2)

scheduler.start

```

典型应用场景拓展

价格监控系统可通过XPath定位商品价格节点,设定阈值触发邮件预警。新闻聚合平台需要建立正文提取算法,结合发布时间戳进行增量采集。社交媒体监听则依赖API调用频率控制,需严格遵守平台规定的请求间隔。

必要注意事项

目标网站的robots.txt协议必须预先解析,避免触发法律风险。分布式部署时建议采用Redis作为任务队列中间件,配合Celery实现横向扩展。存储环节推荐使用SQLAlchemy进行ORM映射,方便兼容多种数据库类型。日志系统需要记录完整的请求轨迹,包括响应状态码、耗时等诊断信息。

数据去重机制可采用布隆过滤器优化内存占用,对于动态加载的内容需建立版本对比算法。当遇到验证码拦截时,应当立即切换采集策略或转为人工干预模式。定时任务的触发间隔设置需要权衡数据更新频率与服务器负载的平衡点,避免因高频访问导致IP封禁。

相关软件推荐

简易REST API客户端(Requests库)

发布日期: 2025-05-26 11:11:16

在数据交互需求爆炸的当下,REST API已成为开发者绕不开的日常工具。Python社区里有个...

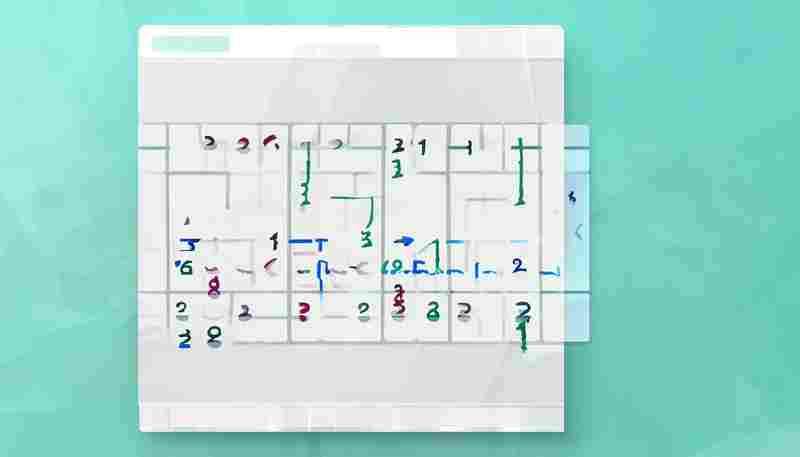

基于Tkinter的简易数独游戏(自动生成题目)

发布日期: 2025-05-08 11:57:32

在Python生态中,基于Tkinter开发的数独游戏生成器悄然走红。这款不足千行代码的工具,...

随机软件推荐

文件树内容相似度分析器

在数字信息爆炸的时代,文件管理成为许多人的痛点。尤其当用户需要处理多个项目的代码库、大量文档或历史存档...

家庭电子产品保修卡数据库

现代家庭中的电子产品数量呈现爆发式增长,仅以三口之家为例,平均持有超过20件带保修服务的电子产品。面对纸质...

圆角度与坡度百分比转换器(角度↔百分比坡度)

道路施工告示牌标注的"6%坡度"常让驾驶员困惑,施工人员却清楚这代表每100米上升6米。在土木工程、道路建设和景观...

系统托盘窗口置顶倒计时器

在电脑前处理多任务时,经常需要临时记录特定时段的情况:可能是会议前的五分钟准备期,或是专注工作的倒计时...

基于密码使用场景的智能推荐工具(如网站-数据库)

在数字身份管理日益重要的今天,密码安全已成为个人与企业无法回避的挑战。据统计,全球每年因密码泄露导致的...

文件属性批量修改工具(修改创建-修改时间)

日常办公场景中,常会遇到需要调整文件时间属性的需求。数码相机导出的照片创建时间错乱、项目文档需要统一时...

植物养护指南二维码标签工具

在园艺产业快速发展的当下,传统纸质养护说明面临信息更新滞后、查阅不便等痛点。某科技公司推出的智能植物标...

自动生成周报模板工具(自定义字段)

在职场办公场景中,周报撰写堪称效率黑洞。某互联网公司调查显示,72%的职场人每周需要耗费2-3小时制作周报,其...

多线程端口扫描检测工具(socket库实现)

2023年网络安全演练期间,我们团队基于Python的socket库开发了一款轻量级端口扫描工具。该工具在渗透测试环节成功检...

系统服务监控工具(进程状态查看)

在服务器运维工作中,运维工程师每天需要面对数十个运行中的系统进程。某次线上服务异常时,技术团队曾耗费两...

Python基于Flask的简易个人博客系统

在信息爆炸的时代,个人博客依然是思想沉淀的最佳载体。对于开发者而言,采用Flask框架搭建的轻量级博客系统,正...

密码字符发音转换器(助记词生成功能)

电脑屏幕前闪过第8个错误提示,李航烦躁地抓了抓头发。刚设置的32位密码才隔三天就完全想不起来,这种经历在数...

命令行版IP端口连通性测试工具

IP端口连通性测试是网络运维中最基础的排查手段之一。面对服务器无法访问、服务异常等问题,技术人员通常需要快...

办公文档格式标准化工具

在快节奏的办公场景中,文档格式混乱常成为团队协作的隐形障碍。同一份文件经过多人编辑后,可能因字体、段落...

开机启动项管理工具(服务禁用-启用)

1. 工具存在的必要性 现代操作系统启动时加载的隐藏服务常超出用户预期。某第三方测试数据显示,Windows 10系统默认...

多语言Markdown文档并行校对工具

在全球化的协作场景中,多语言文档的同步校对往往面临效率瓶颈。传统方式需依赖多窗口切换或人工对照,容易导...

PDF转文本工具(带格式保留)

PDF格式转换工具作为现代办公场景中的刚需产品,始终占据着数字文档处理的核心位置。市场上近期出现的多款智能...

家庭安全设备检查提醒工具

凌晨三点的厨房传来轻微异响,次日发现燃气阀门老化导致微量泄漏。这样的场景让许多家庭后怕——安全隐患往往...

网络课程二维码教学资质自动验证工具

网络课程二维码教学资质自动验证工具诞生于在线教育快速发展的背景之下。随着各大平台对课程合规性审查要求的...

定时邮件批量发送工具(支持附件)

现代职场中,邮件处理效率直接影响工作节奏。某市场部员工张敏的遭遇颇具代表性:凌晨三点蹲守跨境会议前发送...

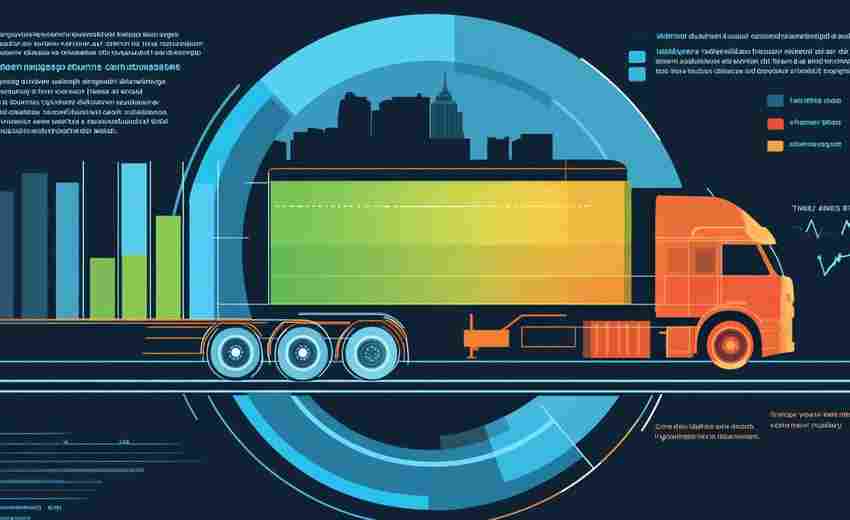

物联网设备状态日志聚合监控工具

在工业物联网、智慧城市等场景中,设备状态日志的实时采集与分析能力已成为运维效率的“生命线”。面对动辄数...

文本加密解密工具(Base64实现)

互联网时代的数据交互常面临编码格式不兼容的困扰。Base64作为通用编码方案,通过字符映射规则将二进制数据转化...

网页正文内容转语音工具

在信息爆炸的时代,人们每天需要处理大量文字信息。网页转语音工具应运而生,这类软件通过智能语音合成技术,...

密码生成器多语言界面切换工具

密码生成器多语言界面切换工具:打破语言壁垒的安全助手 在全球化趋势下,软件工具的多语言支持逐渐成为刚需。...

简易数独生成器(回溯算法生成题目)

在数字游戏的世界里,数独因其独特的逻辑魅力吸引着全球爱好者。传统手工出题效率低下且容易出错,基于回溯算...

拼音声调标注PDF导出工具

在中文教学、语言研究或国际文化交流场景中,拼音声调标注一直是基础且重要的需求。传统手动标注不仅耗时耗力...

基于pandas的CSV数据清洗转换工具

在数据分析领域,CSV文件的清洗与转换是每个从业者绕不开的基础环节。面对格式混乱、数据缺失或冗余的原始数据...

随机抽奖名单生成与结果导出工具

在活动策划、品牌营销或企业内部福利发放场景中,抽奖环节往往承担着活跃气氛、提升参与感的重要作用。传统的...

服务启动耗时性能分析工具

在分布式系统架构中,服务启动耗时直接影响业务连续性。某电商平台曾因支付服务冷启动超时导致大促期间订单流...

微博热搜话题关联舆情报告生成工具

微博热搜榜单每日更新的背后,是每分钟超过百万级的用户行为数据。当某明星绯闻以某艺人工作室声明登上榜首时...

PDF文档合并拆分批注工具

在数字化办公场景中,PDF文档的编辑与管理始终是高频需求。面对合并多份合同文件、拆分大型报告书、添加工作批...

视频拍摄日期自动整理归档工具

许多摄影从业者都经历过这样的场景:SD卡里堆叠着上百条视频文件,命名方式混杂着"IMG_001""未命名项目""微信视频...

基于SMTPLIB的邮件群发营销工具

背景与应用场景 在数字化营销领域,基于SMTP协议的邮件发送功能仍是企业与客户保持沟通的重要渠道。传统邮件客户...

系统服务依赖关系可视化工具(生成拓扑图)

现代软件架构日趋复杂,微服务、容器化技术的普及使得系统服务间的依赖关系呈现网状交叉形态。某数据中心曾发...

文本转语音文件生成器(调用TTS引擎)

在数字内容爆发式增长的时代,一款名为"VoiceForge Pro"的文本转语音工具正在音频制作领域掀起变革。这款搭载最新...

屏幕截图定时器(自动周期截图)

办公室的日光灯管发出轻微的电流声,程序员李浩的视线在三个显示器间来回切换。他正在调试一段复杂的代码,每...

天气查询与预警桌面客户端

清晨推开窗户前,习惯性点开桌面的圆形气象浮窗——这种日常操作正改变着千万用户获取天气信息的方式。天气查...

图片压缩剪贴板快速处理器

凌晨两点,设计师李明盯着电脑屏幕里那张300MB的PSD文件发愁。甲方临时要求通过邮件发送设计稿,但公司邮箱附件限...

文件操作自动化工具(录制-回放操作序列)

在数字办公场景中,文件批量重命名、格式转换、目录整理等重复性操作占据着大量工作时间。某款基于操作序列录...

学科难度系数与得分率关联分析器

在教育评估领域,学科难度与得分率的关系长期受到关注。如何精准量化两者间的关联,直接影响教学策略优化与考...