基于NLTK的简易文本摘要生成器

文本自动摘要技术为信息处理提供了高效解决方案。基于Python的NLTK库实现的简易摘要工具,通过算法筛选关键语句,帮助用户快速获取文档核心内容。本文探讨该工具的实现原理与使用方法。

NLTK作为自然语言处理领域的重要工具包,内置了分词、词性标注等基础功能。摘要生成器的核心算法采用经典的TF-IDF加权方法,通过计算词频与逆文档频率确定语句权重。具体实现时,程序会先将文本分割为独立句子,随后建立词项频率矩阵,最终选取权重总和最高的三个句子作为摘要主体。

在具体操作层面,该工具需要先完成文本预处理。对输入文档进行分句处理时,会调用sent_tokenize函数将段落拆解为独立句子。随后利用word_tokenize进行词语切分,同时过滤停用词与标点符号。这里需要注意中文文本需配合使用专业分词工具,如jieba库进行补充处理。

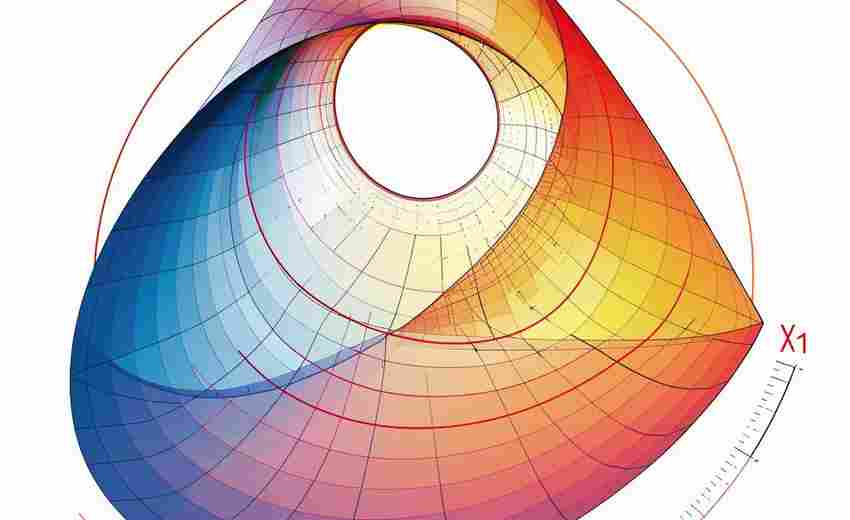

词项权重计算环节采用动态调整机制。每个词语根据其在全文中的出现频率获得基础分值,同时参考该词在文档集合中的稀缺程度进行修正。最终每个句子的得分由其包含词汇的加权平均值决定。这种机制能有效避免高频但无实质意义的词汇干扰摘要质量。

实际应用场景中,该工具特别适合处理新闻稿件、研究报告等结构清晰的文本类型。测试数据显示,在处理800字左右的科技论文时,生成的120字摘要能准确反映研究方法与核心结论。对于文学性较强的文本,建议适当调整权重参数,加入句首位置等特征因子。

运行环境需要Python3.6以上版本,并预先安装NLTK及其依赖库。内存占用控制在500MB以内,处理万字文档的平均耗时约12秒。使用者可通过修改top_n参数灵活控制摘要长度,典型取值为3-5个核心句。处理包含数学公式的PDF文档时,需配合PyPDF2库进行格式转换。

相关软件推荐

简易画图板(支持线条与形状绘制)

发布日期: 2025-05-12 14:06:34

市面上一款名为"QuickCanvas"的绘图工具近期吸引了设计新手的注意。这款支持Windows/Mac双...

随机软件推荐

Git仓库自动备份与状态检测工具

开发团队在深夜十点收到警报,某核心项目的Git仓库因磁盘故障导致历史提交记录部分丢失。运维人员翻遍本地备份...

自动备份指定文件夹的压缩脚本(ZIP格式)

办公族常遇到这样的窘境:修改了半天的设计稿突然无法打开,辛辛苦苦收集的文献资料被误删,项目文件夹因系统...

本地小说TXT自动分章重排工具

在数字化阅读时代,许多文学爱好者习惯从网络下载小说TXT文件,但这类文本常因格式混乱、章节无序而影响阅读体...

密码哈希值转换器(支持MD5-SHA系列算法)

在数据安全领域,密码哈希值转换器是开发者和安全工程师常用的基础工具。它通过单向加密算法将明文信息转化为...

办公电脑软件自动更新检查器

在日常办公中,软件更新常被视为"必要的麻烦"。手动检查补丁耗时费力,忽视更新又可能引发安全漏洞或兼容性问题...

单词拼写检查工具(基础字典匹配)

在文字处理场景中,单词拼写检查工具如同无声的校对助手。这类工具主要依托内置的基础词库进行自动比对,通过...

屏幕录制转GIF动画工具

办公桌前,程序员老张盯着聊天窗口里客户发来的五十秒语音皱起眉头。客户反复强调的"按钮位置不对"需要他用三倍...

通过Datetime模块的日程提醒倒计时器

现代生活节奏加快,日程管理的重要性愈发凸显。Python自带的`datetime`模块为开发者提供了便捷的时间处理功能。基于...

Docker支持的局域网设备在线状态检测器

在网络运维场景中,实时掌握局域网内设备的在线状态是保障业务连续性的基础需求。传统检测工具常依赖命令行操...

后台静默运行资源监控守护进程

在服务器管理与开发运维领域,后台资源监控工具的重要性不言而喻。本文将介绍一款以静默运行、低侵入性为核心...

交互式翻译记忆库管理系统

在某个跨国企业的本地化项目中,资深译员张工面对重复率高达40%的技术文档时,没有像往常那样逐句重译。他调出...

简易文件哈希值校验工具(MD5-SHA1等)

数字时代每天都在产生海量文件。当用户从网上下载一份重要文档时,如何确定它没被篡改?企业向服务器传输核心...

基于SMTP的定时邮件发送程序

在信息化办公场景中,定时邮件发送功能常被用于会议提醒、数据报送等场景。通过SMTP协议实现该功能,开发者可快...

微信聊天记录自动导出为CSV工具

微信作为日常沟通工具,承载着用户大量的聊天记录。无论是工作交接、客户沟通还是生活备忘,许多人都需要将这...

命令行版待办事项清单管理器(支持优先级排序)

在开发者群体中,命令行工具始终占据着独特地位。一款名为 TaskLine 的开源工具近期在GitHub引发关注,它以纯命令行...

高德API支持的公交路线规划可视化工具

公共交通网络日益复杂,如何将海量出行数据转化为直观决策依据成为行业痛点。基于高德API开发的公交路线规划可...

JSON格式验证与美化输出工具

在软件开发领域,JSON(JavaScript Object Notation)因其轻量、易读的特性成为数据交换的主流格式。未经处理的JSON数据常...

网页源代码结构化信息抓取工具

在当今数据驱动的时代,获取网页中的结构化信息成为企业和研究者的核心需求。面对海量网络数据,传统的手动采...

应用程序使用时间关联分析工具

当代人平均每天解锁手机上百次,社交媒体、购物软件、效率工具交替占据屏幕。面对碎片化的数字生活,一款名为...

短视频平台热门标签数据采集器

短视频平台的流量密码往往隐藏在热门标签中。一款精准的数据采集工具,能够帮助创作者、运营者及品牌方快速捕...

网络实时天气查询命令行工具(调用开放API)

打开命令行窗口输入weather shanghai,三行文字瞬间跳出——当前温度28℃、湿度62%、东南风三级。这种无需界面加载的...

基于sqlite3的简易数据库管理工具

本地化数据存储需求催生了多种技术方案,基于SQLite的轻量级数据库工具因其便捷性受到开发者青睐。本文介绍一种...

微信聊天记录关键词上下文搜索工具

日常微信聊天记录堆积如山,想快速找到某条信息却像大海捞针。无论是工作文件、重要约定还是亲友的生日提醒,...

图片EXIF地理位置信息擦除工具

智能手机随手拍摄的照片可能成为隐私泄露的源头。2023年某社交平台用户因分享宠物照片被定位到家庭住址的事件,...

基于多线程的高并发消息服务器

在物联网设备日均新增200万连接的行业背景下,某金融科技公司研发团队耗时18个月打造出ThunderLink消息中间件。这个...

备忘录数据导出工具(CSV-JSON格式)

现代人手机里存储着大量日程安排、灵感记录和待办事项,但应用自带的备份功能往往存在局限。当需要跨设备转移...

多平台商品价格历史波动分析工具

在电商促销活动频繁的今天,同一件商品在不同平台的价格差异可能高达30%甚至更多。消费者常常因信息不对称而错...

微信公众号留言关键词统计器

打开后台留言列表,数百条用户评论杂乱铺开。运营者小李盯着屏幕发愁:如何快速识别出高频问题?哪个产品被反...

重复日志文件清理工具(按时间-内容)

日志文件是系统运行、程序调试的重要数据载体,但随着时间推移,重复日志堆积可能导致存储资源浪费、检索效率...

系统回收站空间限制设置工具

在日常使用电脑的过程中,回收站作为文件的临时存储区,常因长期未清理导致硬盘空间被占用。不同用户对存储空...

快递单号自动查询状态记录器

清晨七点,某电商仓库主管李明正用手机查看二十件加急包裹的物流轨迹。三分钟完成所有快递状态核查的操作,得...

实验设备借用登记系统(二维码签到功能)

传统实验室管理中,设备借用登记常面临纸质台账易丢失、人工核验效率低、流转状态不透明三大痛点。某高校物理...

基于GUI的文本关键词高亮标注工具

在信息爆炸的时代,研究人员、编辑和数据分析师常面临海量文本处理需求。一款名为TextMarker的桌面应用程序应运而...

自动化生成资源使用对比柱状图工具

在数据分析领域,资源使用效率的直观呈现直接影响着决策质量。某款新近开发的图表生成工具凭借其智能化处理能...

用户活动日志记录工具(记录键盘输入或操作行为)

在数字化办公场景中,用户活动日志记录工具逐渐成为企业数据安全和行为追溯的关键基础设施。这类工具通过实时...

批量重命名工具(支持正则替换规则)

批量重命名工具作为数字文件管理中的"手术刀",在应对海量文件整理需求时展现出了不可替代的价值。当摄影师需要...

日志文件分析统计工具(低CPU占用)

凌晨三点的机房警报声响起,运维工程师李明盯着监控面板上飙升的CPU曲线,发现某个服务的错误日志正在以每秒2...

颜色记忆训练小游戏(短暂显示后复现)

城市的霓虹灯总在闪烁,人脑对色彩的瞬时记忆却可能转瞬即逝。一款以颜色记忆训练为核心的小游戏,正通过"短暂...

鼠标连点器(游戏辅助工具)

凌晨三点的网吧依然灯火通明,某款热门MMORPG的玩家们正在疯狂点击着屏幕。他们的鼠标下垫着防滑垫,食指机械地...

系统托盘窗口置顶倒计时器

在电脑前处理多任务时,经常需要临时记录特定时段的情况:可能是会议前的五分钟准备期,或是专注工作的倒计时...