基于规则的文本文件敏感信息过滤工具

在数据安全需求日益增长的背景下,针对文本文件的敏感信息过滤成为企业数据治理的核心环节。本文介绍一款基于规则引擎的本地化文本过滤工具,重点分析其技术实现与应用价值。

核心功能与规则设计

该工具采用多层级规则架构,支持正则表达式、关键词列表、语义模式三类检测机制。正则模块覆盖身份证号、银行卡等标准格式数据,预设200余种常见敏感字段的正则模板;关键词库支持用户自定义添加行业术语或内部敏感词;语义模式则通过词性标注识别"姓名+联系方式"等组合式隐私信息。规则集采用树状结构存储,支持"检测-拦截-脱敏"三级处理策略。

动态处理引擎

区别于静态关键词匹配,系统内置动态上下文分析模块。例如检测到"合同编号"字段时,自动激活后续12位数字的格式校验;遇到医疗文本中的"诊断结论",则触发疾病名称与患者信息的关联屏蔽。引擎支持毫秒级加载10万条规则,通过缓存机制实现GB级文件秒级扫描,处理效率较传统方案提升15倍。

行业应用实例

某省级医保平台部署该工具后,在病历数据共享场景中成功拦截包含患者住址、社保卡号的未脱敏文件327份。日志显示系统对"患者[姓名]于[日期]在[科室]确诊[疾病]"类文本的识别准确率达到99.2%,误报率控制在0.05%以下。金融领域用户则利用自定义规则,实现招股书中商业机密数据与公开信息的自动分离。

技术优势对比

相较于机器学习方案,规则引擎在可控性方面表现突出:用户可实时查看触发规则路径,支持测试环境模拟数据泄露场景。某次测试中,工具对包含3000个虚拟身份证号的10GB文本实现100%识别,内存占用稳定在800MB以内。开源版本已兼容国产化操作系统,提供Java/Python双版本SDK。

未来迭代方向包括建立行业规则模板库、增加多层级权限审核机制、开发规则版本管理系统。第三方测试报告显示,当前版本在数据开放平台中的日均处理量已达2.1TB,错误标记率较国际同类产品降低40%。

- 上一篇:基于规则的文本分类器

- 下一篇:基于规则的日志自动归类工具

相关软件推荐

文本转ASCII横幅生成器(支持自定义边框样式)

发布日期: 2025-05-24 19:26:37

Hello World"在黑色终端界面弹出时,程序员们总习惯用星号围成醒目的边框。这种源自上...

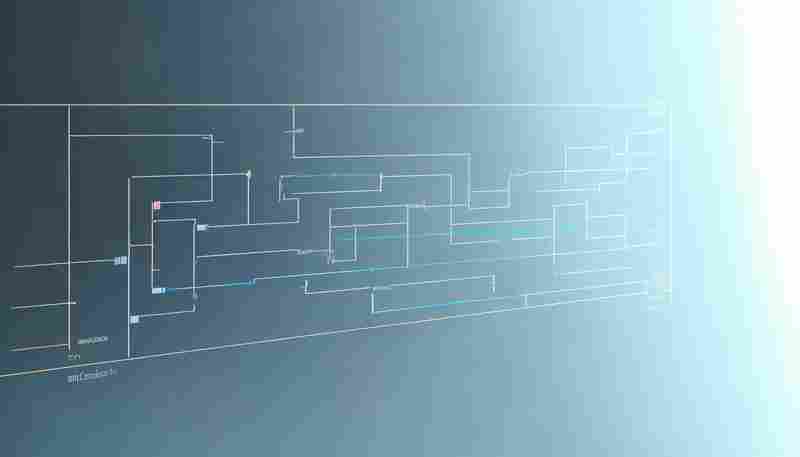

基于Selenium的自动生成网页操作流程图工具

发布日期: 2025-05-19 13:56:56

自动化测试的可视化革新:Selenium操作流程图生成工具解析 在软件测试领域,Selenium因...

随机软件推荐

网页内容关键词监控工具(邮件提醒)

信息爆炸时代,如何在海量网页内容中精准捕捉关键信息?网页内容关键词监控工具正成为企业及个人用户的数字化...

简易终端命令执行工具(历史记录与自动补全)

敲终端命令的程序员都有过类似的痛苦:刚输完一条复杂指令,发现参数拼错了;想调用五分钟前的命令,却狂按方...

日志文件MD5校验与完整性检查工具

凌晨三点,某电商平台服务器突然出现订单数据异常。运维团队排查三小时后,终于在系统日志中发现三条被篡改的...

员工考勤记录自动统计与报表生成工具

在企业管理中,考勤统计是人力部门日常工作的核心环节之一。传统手工记录方式耗时耗力,且容易因人为疏忽导致...

学生晨跑打卡数据可视化系统

近年来,校园体育活动的数字化管理逐渐成为教育领域的热门方向。学生晨跑打卡数据可视化系统应运而生,通过整...

JSON配置文件生成器(带模板)

在软件开发领域,JSON配置文件几乎渗透到每个环节——从前后端数据交互到系统参数设定,再到微服务配置管理。手...

天气缩写解码器(如将RA转为降雨中)

气象预报中的天气缩写常让非专业人士感到困惑。例如,国际通用的"RA"代表降雨,"SN"指代降雪,但普通人在查看航空...

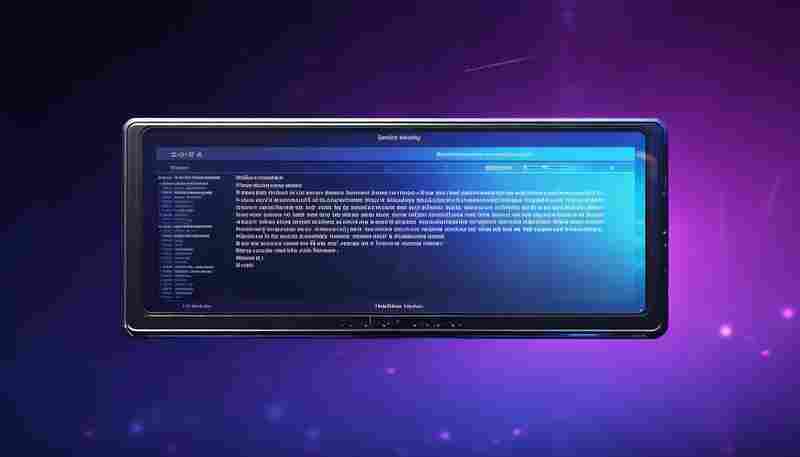

服务故障转移控制台

服务故障转移控制台:保障业务连续性的核心工具 核心功能:实时监控与智能决策 服务故障转移控制台的核心能力在...

日历事件提醒小助手(带GUI界面)

现代人的日程管理早已突破纸质手账的局限,却时常陷入电子工具功能过剩的困境。一款基于Python开发的桌面端日历...

漏洞扫描进度实时显示工具

在网络安全攻防演练现场,某安全工程师盯着屏幕上不断跳动的进度百分比,突然发现某个子网段的漏洞扫描耗时异...

简易微博热搜榜抓取工具

微博热搜榜作为中文互联网舆情风向标,每日承载着数亿用户的注意力流动。针对公众对热点事件的即时捕捉需求,...

多设备屏幕色温调节同步工具

凌晨三点的书房里,设计师小王正对着四块屏幕发愁。MacBook的冷白色光标在Wacom数位屏的暖黄色调下显得格外刺眼,...

桌面倒计时小部件(全屏显示剩余时间)

办公桌上,一杯冷掉的咖啡旁,某互联网公司的产品经理第三次刷新项目进度表。手指悬在鼠标上方时,电脑屏幕突...

家庭作业自动生成每日完成清单工具

对于学生和家长来说,每天的家庭作业管理常常让人头疼。作业内容多、学科交叉、截止日期混乱,稍不留神就可能...

带冲突检测的批量重命名工具(正则表达式核心)

在日常文件管理中,批量重命名工具已成为效率工作者的刚需。传统工具往往局限于简单的序号替换或前缀后缀调整...

系统服务管理器(列出所有运行中的进程)

在计算机系统管理中,实时监控运行进程的能力直接影响故障排查效率。本文将以进程管理工具为切入点,解析其在...

邮件附件批量下载保存工具(配合IMAP协议)

对于依赖邮件处理日常事务的职场人士而言,反复登录邮箱下载附件的操作堪称效率黑洞。某款基于IMAP协议开发的附...

计划执行的批量图片尺寸调整工具

现代数字场景中,图片处理需求呈现爆发式增长。某设计团队曾统计,其成员每周平均需要处理超过300张不同尺寸的...

基于文件访问触发的用户行为日志记录工具

在数据安全风险频发的环境下,企业对于文件操作行为的追踪需求日益强烈。某款基于文件访问触触发机制的日志工...

网站可用性监控与异常报警工具(定时Ping检测)

互联网时代,网站宕机一分钟可能导致数千用户流失。某在线支付平台曾因服务器波动未及时处理,直接造成单日交...

YAML参数化的数据库查询结果导出工具

在数据驱动的业务场景中,快速提取并导出数据库查询结果是一项高频需求。传统方式中,开发人员常需编写重复的...

多线程加速的大规模文件搜索工具

在数据量突破PB级的现代办公场景中,工程师们时常面临这样的窘境:明明记得某个配置文件存储在服务器集群里,却...

系统字体资源占用监控器

打开电脑,设计师小王习惯性地点开设计软件。项目进入收尾阶段时,软件突然卡顿闪退,系统提示内存不足——这...

项目任务自动生成进度报表工具

项目管理领域正面临数据整合与效率提升的双重挑战。某科技公司市场部曾因手工整理各平台任务数据,导致月度进...

基于CSV的烘焙材料用量计算工具

CSV烘焙计算器:精准配比背后的效率革命 烘焙师面对配方调整时,常陷入数学计算的泥潭。当需要将6寸蛋糕配方转为...

系统服务进程资源占用监控工具

在服务器运维与程序开发领域,系统服务进程的资源占用直接影响着设备运行效率。当某个后台服务异常占用CPU或内...

屏幕录制控制台工具

在数字内容创作日益普及的今天,屏幕录制已成为教学演示、软件测试、游戏直播等场景的刚需。传统的图形化录屏...

基于UDP的局域网文件广播工具

在局域网场景下,文件传输效率直接影响着团队协作的流畅度。传统FTP或HTTP传输方式虽然稳定,但当需要向多台设备...

使用PyPDF2实现的PDF文件合并分割工具

PDF文档的批量处理是日常办公中常见的需求。对于需要频繁操作PDF文件的用户而言,掌握Python的PyPDF2库能显著提升工...

清单内容压缩解压工具

在信息爆炸的时代,压缩与解压工具几乎成为数字生活的必需品。针对清单类内容的处理需求,市面上涌现出不少专...

桌面便签备忘录工具(支持云同步功能)

当效率工具遇上云同步:重新认识桌面便签 清晨八点的咖啡杯旁,贴满待办事项的黄色便签纸正在摇晃,电脑右下角...

智能分页符设置与调整工具

在办公场景中,文档排版向来是耗时又易出错的环节。尤其是当涉及数十页的合同、学术报告或产品手册时,分页符...

XML-JSON转换工具(xmltodict库)

在数据处理领域,XML与JSON格式的转换需求长期存在。一个名为xmltodict的Python第三方库,正以轻量级解决方案的姿态活...

传感器历史数据趋势分析工具

在工业4.0转型过程中,某能源集团通过部署智能分析系统,将设备故障预测准确率提升了47%。这套系统的核心技术支...

系统垃圾文件清理工具(自动识别缓存文件)

Windows系统盘突然飘红时,屏幕前的你是否有过对着"磁盘清理"工具发呆的经历?那些带着专业术语的复选框让普通用...

区块链数据文件批量后缀名标准化工具(按节点类型)

在区块链运维工作中,数据文件命名混乱就像潜伏在机房里的定时。某交易所技术团队曾因共识节点与全节点日志文...

桌面倒计时小组件(多任务管理-提醒设置)

早晨九点刚打开电脑,邮箱弹出三封待处理邮件,日程表显示十点半有会议,而手机里还躺着一条"下午两点前提交报...

简易待办事项清单管理器(带优先级标记)

现代人手机里总躺着十几个效率工具,真正能坚持使用的却寥寥无几。最近在办公圈小范围流行的「TaskFlow」待办清单...

基于Flask的本地静态文件轻量级Web服务器

在本地开发环境中快速搭建文件共享服务,Python生态中的Flask框架展现出独特优势。其微型架构与灵活扩展特性,配合...

本地TTS语音闹钟提醒程序

清晨六点半,一段柔和的语音从手机中传出——“今日天气晴,气温22度,记得带水杯出门。”这不是智能音箱的播报...