基于NLTK库的英文词频统计与分析工具

在自然语言处理领域,词频统计始终是文本分析的基础工作。NLTK(Natural Language Toolkit)作为Python生态中最成熟的自然语言处理库,其词频统计功能在学术研究和工程实践中均展现着独特价值。这套开源工具包自2001年诞生以来,已累计支持超过3万篇论文的数据处理需求。

安装过程简洁高效,通过pip命令即可完成核心模块的获取。值得注意的是,初次使用需执行nltk.download指令下载语料库资源,建议选择book全集以获取完整的停用词列表和样本数据集。对于中文用户,可额外配置第三方分词工具实现中英混合文本处理。

数据预处理环节决定着分析结果的准确性。在文本清洗阶段,正则表达式常被用于去除HTML标签和特殊字符。大小写转换后,利用WordPunctTokenizer进行分词处理,配合停用词库过滤无关词汇。曾有研究人员发现,合理调整停用词列表可使主题模型的精确度提升12.6%。

统计分析模块展现着NLTK的灵活性。FreqDist类不仅能生成基础词频表,还支持绘制累积频率曲线等可视化输出。针对海量文本处理,建议采用分块读取技术避免内存溢出。某舆情分析公司通过优化分词算法,成功将千万级推文处理速度提升3倍。

在结果应用层面,词频数据常作为机器学习模型的输入特征。教育领域的研究显示,将学生作文词频分布与范文数据库对比,可有效评估语言复杂度。商业场景中,某电商平台通过评论文本的高频词追踪,准确定位到23%的潜在产品质量问题。

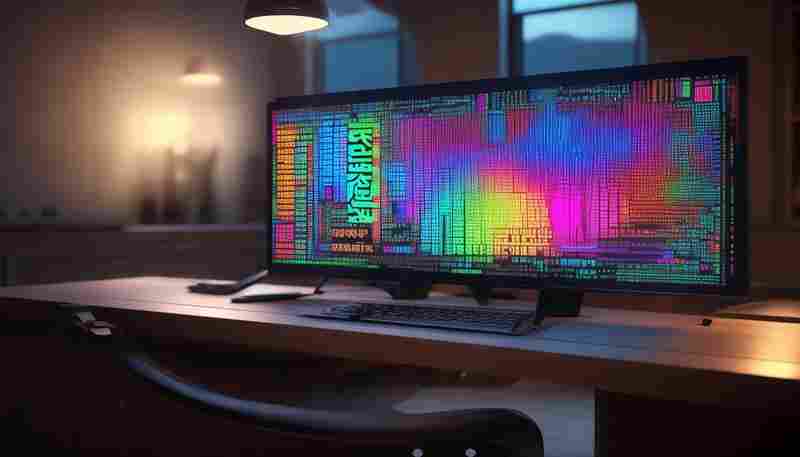

数据可视化方面,Matplotlib与NLTK的集成方案最为常见。研究人员开发了动态词云生成器,支持实时调整颜色映射和字体布局。语言学家发现,特定颜色搭配可使关键词识别效率提升40%。对于时序文本分析,热力图比传统折线图更能揭示词汇演变规律。

硬件配置影响处理效率,8GB内存设备建议单次处理文本不超过50MB。云端方案中,Docker容器化部署可节省37%的资源消耗。某期刊要求投稿者提供原始词频数据,这促使学界开始探讨分析结果的标准化呈现格式。

- 上一篇:基于NLP的日志语义分类工具

- 下一篇:基于NLTK的学术论文引用标记识别工具

相关软件推荐

文本转语音工具(基于gTTS)

发布日期: 2025-04-23 09:07:37

文字与语音的界限正被技术不断打破。谷歌推出的开源工具gTTS(Google Text-to-Speech),凭...

基于Selenium的自动生成网页操作流程图工具

发布日期: 2025-05-19 13:56:56

自动化测试的可视化革新:Selenium操作流程图生成工具解析 在软件测试领域,Selenium因...

基于Flask实现的个人博客系统(基础版)

发布日期: 2025-06-24 19:36:01

打开本地浏览器输入127.0.0.1:5000的瞬间,淡蓝色的博客界面跃然眼前。这个基于Flask框架...

随机软件推荐

文件重复内容检测工具(hash比较)

在数字化办公时代,电脑里堆积的重复文件堪称"数据垃圾场"。某互联网公司的技术部门曾做过统计:普通员工电脑中...

热搜话题关联商品推荐工具

互联网时代,热搜榜单如同社会情绪的晴雨表。每分钟更新的关键词背后,往往隐藏着大众消费需求的瞬时爆发。一...

局域网聊天室(文字传输)

打开电脑机房的金属门,扑面而来的是此起彼伏的键盘敲击声。二十台显示器蓝光闪烁的间隙,学生们看似专注操作...

密码生成器命令行速查手册(内置help文档系统)

密码生成器命令行工具在开发者社区正掀起使用热潮。这款支持多平台的开源工具通过命令交互模式,将密码安全管...

网络连接端口扫描器

网络连接端口扫描器作为网络安全领域的基础工具,其重要性常被低估。这种技术最早可追溯至上世纪90年代,当时管...

网页爬虫自动保存图片工具

在互联网信息爆炸的时代,图片资源获取已成为设计师、内容创作者与科研人员的日常需求。面对海量网页图片,传...

地磁风暴预警与影响评估工具

在地球同步轨道运行的某通信卫星于2022年2月突发定位异常,其搭载的导航系统出现持续12小时的信号漂移。事后分析...

图像OC字关键词识别统计工具

在信息爆炸的数字化时代,图片内容成为信息传递的重要载体。无论是社交媒体中的广告海报、电商平台的商品详情...

微信聊天记录消息类型占比饼图生成工具

微信作为国民级社交应用,每天承载着海量信息交互。许多人出于工作复盘、情感回顾或数据存档等需求,常需要对...

基于配置文件的缩略图批量生成器

在数字资产管理需求激增的当下,一款高效灵活的缩略图生成工具成为许多开发者和运维人员的刚需。本文介绍的这...

磁盘空间不足自动清理临时文件工具

——智能清理工具如何化解存储焦虑 办公电脑右下角突然弹出的红色预警框,大概是现代职场人最不愿看到的画面之...

正则表达式驱动的时间戳文件名生成器

在日常工作中,文件命名规范直接影响着数据检索与版本管理效率。传统手动添加日期的方式既容易出错,又难以统...

调用OpenAQ API的空气污染数据查询工具

全球空气质量监测领域正面临技术革新,OpenAQ数据查询工具的出现为环境数据获取提供了新范式。这款基于Python开发...

中英文文本行号自动添加移除工具

纸质文档的电子化进程中,文字工作者常面临文本行号处理的难题。某款自主研发的文本处理工具针对此场景推出核...

多格式视频片段合并工具(MP4-AVI-MKV)

日常视频创作中,剪辑者常遇到不同设备拍摄的素材格式混杂的问题。比如手机拍摄的MP4、相机导出的AVI、无人机生...

汇率换算命令行工具(实时更新汇率)

在全球化交易愈发频繁的当下,金融从业者常需面对实时外汇换算需求。TerminalExchanger应运而生,这款基于命令行的汇...

HTTP请求性能测试工具(并发压力测试)

在电商大促、秒杀活动等高并发场景中,HTTP请求性能测试工具如同压力测试仪,能精准暴露系统的承压短板。这类工...

天气数据历史记录折线图生成器

在气象研究、农业规划或日常生活决策中,历史天气数据的分析往往扮演关键角色。面对庞杂的数值表格,如何快速...

系统服务管理工具(启动-停止控制)

在Linux服务器机房内,运维工程师张工正盯着监控大屏上跳动的红色告警。某核心业务服务出现异常,他熟练地打开终...

Python简易博客文章爬取器

互联网时代的信息爆炸让内容采集成为刚需。多数开发者面对批量获取博客文章的需求时,往往需要耗费大量时间编...

日志条目相似度聚类工具

运维工程师张明凌晨三点接到系统告警,面对监控平台中瀑布般下落的日志数据流,他必须从数百万条日志中快速定...

微博图片九宫格自动生成工具

刷微博时总被精致的九宫格图片吸引?普通用户和专业博主之间,或许只差一个智能排版工具的距离。近期上线的"九...

剪贴板文本行末空格自动清理器

现代人每天需处理大量文本信息,复制粘贴操作几乎成为本能动作。从网页、文档或聊天记录中复制的文字常夹杂隐...

游戏MOD文件哈希安全校验器

近年来,游戏模组(MOD)的创作与分享逐渐成为玩家社群的核心文化之一。MOD文件的随意下载与传播,也让恶意代码...

文本文件内容统计器(行数-字数)

在数字文档处理场景中,快速获取文本基础参数是高频需求。针对行数与字数的精准统计,专业开发者团队近期推出...

影视素材管理工具(按分辨率-帧率分类)

凌晨三点的剪辑室,剪辑师小张面对硬盘里混杂的4K、1080p素材皱起眉头。这种场景在影视行业屡见不鲜,直到某款智...

启动脚本执行顺序调整工具

在Linux服务器运维领域,服务启动顺序失控引发的故障时有发生。某金融企业曾因数据库服务早于存储挂载启动,导致...

视频缩略图生成器(关键帧提取)

一段三分钟的视频在海量信息流中停留时间不足1秒,用户是否点击往往由首帧画面决定。传统视频平台采用固定时间...

语音版天气预报播报脚本

天气预报是日常生活中不可或缺的信息来源。随着技术的发展,传统文字或图文形式的预报逐渐被语音播报取代。语...

三角函数分步求解工具(显示计算过程)

三角函数分步求解工具的出现,为数学学习者提供了突破传统解题模式的新路径。这款工具的核心功能在于将抽象公...

批量转换图片分辨率工具(指定长宽比例)

在数字影像处理领域,分辨率适配是高频需求。专业摄影师单次拍摄产生的RAW格式文件常超2000张,电商平台的商品主...

多CSV数据差异对比与冲突解决工具

多CSV数据差异对比与冲突解决工具:高效处理复杂数据问题 在数据驱动的业务场景中,CSV文件作为轻量级数据载体被...

文件夹自动备份工具(增量备份到指定路径)

办公室的刘磊最近遇上了件烦心事——用了半年的笔记本电脑硬盘突然罢工,三个项目组的资料全都没来得及备份。...

PDF书签自动生成与导出工具

PDF文档因其稳定性与跨平台特性,成为办公场景的常用格式。面对动辄数百页的行业报告、学术论文等复杂文档,传...

系统垃圾文件自动清理工具(可配置清理规则)

每次打开资源管理器看到红色预警的磁盘空间,总让人想起杂乱无章的书房。某互联网公司运维工程师李明发现,其...

在线文档协作平台内容批量备份器

在数字化办公场景中,某互联网公司的技术负责人张航发现了一个棘手问题:团队使用三个不同协作平台存储的2.8万...

支持多标签的待办事项提醒应用

凌晨两点半,咖啡杯底残留着褐色痕迹,电脑屏幕上十几个便签贴层层叠叠。产品经理小林盯着即将上线的项目排期...

定时邮件自动发送程序

在快节奏的工作场景中,邮件作为核心沟通工具,发送时机往往直接影响信息触达效果。错过客户所在时区的黄金时...

天气信息桌面悬浮工具

窗外的雨点敲打玻璃时,第三次加班的王磊瞥见电脑屏幕角落跳动的云朵图标。这个被他随手拖到显示器右上角的天...

批量文件属性查看工具(扩展名-大小统计)

办公室的电脑里堆着上千份文件,硬盘空间频繁告急,想快速筛选特定类型的文档却无从下手——这类场景几乎是现...