基于多线程的日志文件并行处理工具

在日均TB级日志量的电商监控系统中,传统日志处理器需要8小时完成的任务,某新型工具仅用23分钟即告完成。这种效率跃升源于其核心的多线程并行架构,正在重构日志处理领域的技术实践。

动态线程池打破资源僵局

不同于固定线程数的常规方案,该工具采用三级反馈队列调度算法,根据CPU占用率和内存水位自动调节工作线程数量。实测显示,在处理混合型日志(含文本/JSON/二进制数据)时,线程数能在50-200之间智能浮动,较静态线程方案提升37%的吞吐量。当遭遇突发性日志洪峰,系统能在300ms内完成线程扩容。

智能分片机制破解文件切割难题

工具内置的流式分片引擎采用滑动窗口技术,支持按时间戳、日志等级、服务模块三种维度自动拆分文件。在处理单个体积超过50GB的日志文件时,通过SIMD指令加速的特征识别模块,可在首行解析阶段即建立分片索引。某金融机构压力测试表明,该机制使跨节点处理的网络传输量减少62%。

异常熔断保障处理连续性

当检测到单条日志解析耗时超过阈值(默认500ms),系统会触发熔断机制,将问题日志转移至隔离队列。这个设计在应对非常规日志格式时尤为关键,某云服务商部署后,因异常日志导致的整体处理中断次数归零。配套的修复工具包能自动生成正则表达式模板,帮助开发人员快速修补解析漏洞。

资源监控可视化闭环

内嵌的Prometheus+Grafana监控套件实时呈现线程状态热力图,运维人员可直观观测到I/O等待队列的堆积情况。测试数据显示,在磁盘吞吐量波动20%的环境下,工具仍能保持处理速率标准差不超过5%,这对需要精确计算日志处理时长的计费场景尤为重要。

该工具现已兼容Nginx、Kafka、K8s等12种常见日志格式,开发团队透露下个版本将集成ZSTD压缩算法,进一步降低跨数据中心传输时的带宽消耗。开源社区贡献的ElasticSearch插件正在测试阶段,预计Q3正式发布。

- 上一篇:基于声音识别的会议发言时间统计工具

- 下一篇:基于天气API的太阳能发电量预测工具

相关软件推荐

基于requests的静态网页表格数据抓取工具

发布日期: 2025-06-10 10:00:01

在数据采集领域,基于Python的requests库构建的表格抓取工具已成为企业级数据获取的基...

随机软件推荐

桌面倒计时提醒软件

现代人的电脑屏幕总是拥挤——文档、网页、聊天窗口层层叠叠。在快节奏的工作场景中,桌面倒计时提醒软件正悄...

网页截图工具(整页截图与局部截图)

在信息碎片化时代,网页截图工具已成为职场人士与互联网用户的效率利器。面对复杂的网络场景,如何快速截取完...

号码预测器(大乐透格式生成)

每逢大乐透前,总有人试图从往期数据、冷热号分布甚至玄学中寻找规律。近年来,一种名为"大乐透号码预测器"的工...

文件行数统计与对比脚本

在软件开发、数据分析或文本处理场景中,文件行数的统计与差异对比是高频需求。例如,代码合并前需要确认改动...

大文件分割与合并工具(带进度显示)

在数字信息爆炸的时代,科研人员处理3D建模的TB级数据时,程序员需要迁移数百GB的代码仓库时,普通用户传输4K视频...

按名称过滤终止进程的命令行工具

在系统维护和软件开发过程中,进程管理是高频操作场景。面对失控的进程或需要批量终止任务时,熟练掌握进程筛...

多线程IP地址地理位置查询工具

互联网环境下,IP地址定位已成为网络安全、业务分析等领域的基础需求。传统单线程查询工具在处理大批量数据时,...

文件元信息批量查看工具

在数字资产管理领域,数据量的激增使得传统单文件处理方式逐渐显露疲态。某科技团队推出的FileMetaX工具,凭借其...

天气预报定时查询与桌面弹窗工具

清晨7:30的电脑桌面准时浮现透明提示框:今日气温25-32℃,空气质量优,建议携带防晒伞。这是某互联网公司产品经...

简易五子棋AI对战小游戏

棋盘界面加载完毕的瞬间,黑白两色的圆形光标在木质纹理背景上微微闪烁。这款仅8MB的桌面程序无需复杂安装,双...

系统重复文件清理工具

办公桌抽屉积满旧发票和过期文件时,人们总会主动整理,但电脑硬盘里堆积的重复文档往往被忽视。某金融公司技...

二维码解码识别工具(与生成互补)

在移动支付普及的今天,二维码已成为连接物理世界与数字空间的桥梁。作为生成工具的互补,解码工具承担着信息...

多关键词日志文件内容匹配统计工具

日志文件作为系统运行的重要记录载体,常隐藏着服务器状态、程序异常等关键信息。面对动辄数GB的日志数据,传统...

跨平台文件编码自动检测与转换工具

在日常办公或开发场景中,文件乱码问题如同幽灵般频繁出现。不同操作系统、软件对文本编码的默认支持存在差异...

MySQL数据库表分区管理辅助工具

数据库运维工程师每天面对十亿级数据表时,常会遇到这样的困境:明明做了表分区设计,查询性能却在业务高峰期...

Tkinter版密码管理器(AES加密存储)

现代生活中密码管理已成为刚需。市面上虽有不少商业密码管理工具,但数据隐私始终是用户的核心顾虑。近期在技...

多CSV文件字段差异对比报告生成器

在数据处理领域,跨系统数据迁移或接口对接时,业务部门常遇到字段名称、格式、类型不统一的痛点。某互联网公...

命令行Git仓库管理助手

在代码开发领域,Git几乎是每位开发者绕不开的工具。但面对繁杂的`git add`、`git commit`、`git rebase`命令,许多人容易...

简易天气查询工具(调用公开API显示城市天气)

每逢出门前查看天气已成现代人习惯。一款基于公开API开发的轻量化天气查询工具,因其便捷性逐渐走进大众视野。...

简易游戏开发框架Pygame

窗外的蝉鸣声夹杂着键盘敲击声,二十年前的某个夏夜,几个大学生用Python语言敲出了会移动的方块。这个名为Pyga...

文件树状结构可视化生成器

在数据规模指数级增长的当下,开发团队常面临文件管理的混沌困境。某金融科技公司的真实案例显示,其核心系统...

剪贴板历史记录工具(支持内容分类保存)

现代办公场景中,频繁切换各类软件导致的信息碎片化已成为效率瓶颈。据统计,普通职场人日均执行复制操作超百...

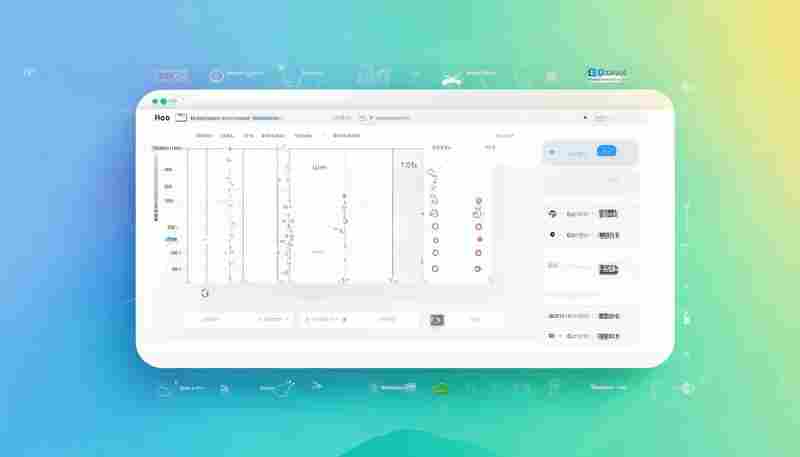

传感器时序数据切片分析工具

在智能制造与物联网技术快速发展的当下,工业设备每秒钟产生的海量传感器数据已成为企业数字化转型的关键资源...

课程考核成绩分析报告工具

教育领域长期面临成绩数据利用率低的痛点。传统人工统计方式耗时耗力,关键教学信息常湮没于数字表格中。针对...

HTTP接口自动化测试脚本工具

在持续集成开发模式下,某电商平台的技术团队曾因支付接口漏测导致线上事故。事故复盘报告显示,人工测试覆盖...

支持断线重连的可靠文件传输工具

网络波动导致的文件传输中断,始终是困扰远程协作的痛点。某跨国设计团队在传输3D建模文件时,因网络闪断导致...

股票基本面数据爬取与可视化分析工具

在信息爆炸的资本市场,专业投资者每天需要处理海量上市公司数据。某科技团队最新研发的股票基本面智能分析系...

植物养护提醒工具(生长周期记录)

朋友家阳台上的琴叶榕又秃了。她盯着手机日历叹气:"明明上周浇过水,叶子怎么又黄了?"这场景养植物的人都不陌...

书签文件夹层级管理器

打开浏览器时,总有些用户会对着收藏栏里密密麻麻的书签发怔。那些曾经随手保存的网页链接,像滚雪球般堆积成...

文本文件词频统计器(生成Top10词汇)

在信息爆炸的数字化时代,文字工作者常面临海量文本的分析需求。一款高效的词频统计工具能快速解析文本特征,...

键盘鼠标操作录制与回放器

日常工作中,重复性操作常占据大量时间。比如财务人员每月需处理相同格式的报表,设计师需反复调整参数测试效...

图片九宫格切割生成器(社交平台配图)

打开社交平台,九宫格创意图片正以每月12%的增速占领用户视线。这种源自Instagram的视觉呈现方式,在微信朋友圈、...

USB蓝牙设备配对历史记录查看器

当代电子设备普遍依赖蓝牙技术实现无线连接。手机、耳机、智能家居等设备频繁配对过程中,系统默认的日志记录...

单词本背诵工具(带发音与例句功能)

传统单词背诵常面临记忆孤立、发音模糊的痛点。一款集合真人发音、情境例句的智能单词本工具,正逐步成为语言...

网络图片批量下载与缩略图生成器

数字内容爆炸时代,网络图片处理效率成为刚需。某款新晋工具凭借批量下载与智能缩略功能,在设计师群体中悄然...

使用NumPy实现的矩阵计算教学演示软件

矩阵计算教学如何突破传统模式?一套基于NumPy开发的交互式软件正在改变课堂场景。这款工具将抽象的线性代数概念...

视频转码任务进度监控与失败通知

视频转码过程中最令人头疼的问题,莫过于任务卡在某个未知节点,或是系统突然崩溃却无人察觉。某影视工作室曾...

多标签Markdown笔记编辑器(实时预览)

信息爆炸时代的工作台总堆满待处理的文档:会议纪要半开着,项目进度表需要更新,临时闪现的灵感需要速记。传...

端口状态变化微信通知机器人

在网络运维与安全防护领域,端口状态的实时监控至关重要。传统的人工巡检或邮件告警模式存在滞后性,尤其在突...

货物重量体积转换运价工具

在物流运输领域,货物的计费方式通常基于实际重量与体积重量的对比,选择二者中较高值作为最终计费依据。这一...