基于requests的静态网页表格数据抓取工具

在数据采集领域,基于Python的requests库构建的表格抓取工具已成为企业级数据获取的基础设施。该技术方案通过HTTP请求与HTML解析的有机结合,为结构化数据抽取提供了可靠的工程实现路径。

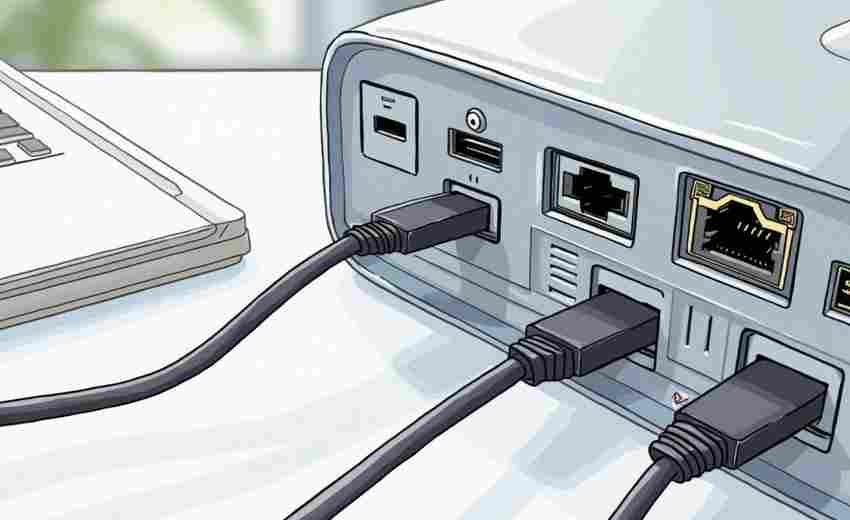

工具核心由requests网络请求模块与HTML解析库(如BeautifulSoup或lxml)构成。requests库负责目标网页的精准获取,通过自定义Headers、Cookies和超时参数,可有效应对多数反爬机制。解析组件则针对table标签进行特征识别,自动提取表头与数据行的对应关系。

某金融机构曾运用该方案实现股票交易数据的定时抓取。通过设置User-Agent伪装浏览器访问,配合XPath定位策略,成功从证券门户网站提取实时行情数据。关键代码段展示表格定位的典型实现:

```python

from bs4 import BeautifulSoup

import requests

resp = requests.get(' headers=headers)

soup = BeautifulSoup(resp.text, 'lxml')

table = soup.find('table', {'class': 'market-data'})

headers = [th.text.strip for th in table.find_all('th')]

rows = [[td.text.strip for td in tr.find_all('td')] for tr in table.find_all('tr')[1:]]

```

实际工程应用中需注意三个技术要点:网页编码自动检测机制可避免乱码问题,使用Session对象保持会话状态能应对登录型网站,设置随机延时策略可降低IP封禁风险。对于含分页的表格数据,建议通过URL参数分析实现批量抓取,而非模拟点击操作。

动态渲染网页的处理需结合Selenium等工具,但会增加系统复杂度。表格结构异常的情况,如合并单元格处理,需要开发特定的数据重组算法。数据持久化阶段推荐使用Pandas进行格式转换,可轻松导出为CSV或数据库存储。

反爬策略升级倒逼采集方案持续迭代,IP代理池和请求指纹随机化已成为标准配置。法律合规边界需要技术团队与法务部门协同把控,避免触碰数据安全红线。

相关软件推荐

基于Python的简易HTTP服务器搭建工具

发布日期: 2025-04-10 11:15:28

命令行窗口弹出黑色背景,光标闪烁的瞬间,许多开发者会本能地敲下`python -m http.se...

系统定时任务管理工具(基于schedule库)

发布日期: 2025-04-26 13:23:44

在Python应用开发中,定时任务管理是常见需求。基于schedule库的定时任务工具凭借其轻...

随机软件推荐

网页内容变更自动检测与通知工具

在信息爆炸的数字化时代,每天有超过200亿个网页发生内容更新。如何在海量网络数据中精准捕捉关键信息变化,成...

推特话题热度实时监控报警工具

在社交媒体时代,推特作为全球信息传播的核心平台之一,每天产生数亿条推文。品牌、机构甚至个人用户若想快速...

天气实时查询软件

打开手机,滑动屏幕,几秒内就能知道未来几小时会不会下雨——这种便利在十年前还是科幻场景,如今已融入日常...

多账户邮件自动发送器

在信息传递高度依赖电子邮件的时代,企业、团队甚至个人常面临多账户邮件管理的难题。手动切换账号、重复编辑...

系统资源监控小部件(CPU-内存使用率实时显示)

当视频剪辑进度条突然停滞,当游戏画面出现撕裂帧,人们才会想起那个藏在任务栏角落的透明窗口。系统资源监控...

CSV文件内容差异对比与合并工具

在数据密集型的工作场景中,CSV文件作为轻量级的数据载体被广泛使用。当多人协作或跨系统交互时,同一份数据可...

新闻关键词频率统计与分析脚本

在信息爆炸的时代,新闻数据的快速处理与深度解析成为媒体从业者、市场研究人员甚至普通用户的刚需。一款高效...

简易数独游戏(自动出题)

数独作为经典的逻辑推理游戏,长期吸引着全球玩家的兴趣。然而传统手工出题效率低、难度不可控的问题,一直困...

ASCII艺术版化学方程式配平朗读工具

实验室的白板上,用粉笔写化学方程式的场景正在被数字化工具改变。一款结合ASCII艺术与方程式配平功能的工具悄然...

文本差异比较工具(双栏对比高亮差异)

在信息迭代频繁的数字化场景中,文本差异比对工具正逐渐成为内容创作者、程序开发者和法律从业者的刚需装备。...

简易论坛爬虫与热帖分析工具

网络论坛作为信息交流的核心阵地,每天产生海量用户发言。如何快速获取有效信息并识别热点话题,成为运营者与...

自动生成简单动画效果工具

一键生成动画:让创意跃然屏幕的轻量级工具 在数字内容爆炸的时代,动画效果早已不再是专业设计师的专属。无论...

天气影响下的能源使用计划优化器

随着气候波动加剧,能源供给与需求的动态平衡面临更大挑战。极端高温、寒潮、持续降雨等天气现象直接影响电力...

Office文档转PDF水印批量添加器

在数字化办公场景中,文档格式转换与水印添加是高频需求。无论是企业合同、财务报告,还是学术论文,将Office文...

虚拟机快照自动管理维护工具

在虚拟化技术深度渗透企业IT架构的今天,某数据中心运维团队发现其虚拟机快照数量呈指数级增长。技术主管张工发...

文件夹同步工具(本地-远程对比)

现代数字生活中,数据分散存储于多个设备或云端已成常态。文件夹同步工具凭借其核心的本地与远程对比功能,成...

可自定义时间段的灵活番茄钟工具

现代人对抗拖延症时,常依赖经典的番茄工作法——25分钟专注+5分钟休息。但固定时间段的标准化设计,未必适配所...

基于FFmpeg的视频画面镜像翻转分辨率工具

FFmpeg作为开源多媒体处理领域的标杆工具,其命令行模式在视频编辑领域长期占据核心地位。针对视频画面镜像翻转...

简易邮件客户端(带定时发送功能)

又忘记给客户发周报!"深夜十一点冲完咖啡的刘主管盯着电脑屏幕叹气。这种场景在职场并不少见,人们往往高估自...

桌面天气小部件(API调用+GUI显示)

在数字化生活场景中,桌面天气小工具已成为现代人管理日程的重要辅助工具。这类工具通过实时获取天气数据并以...

批量下载网易云音乐歌单工具

对于习惯用网易云音乐整理歌单的用户来说,本地保存歌单的需求一直存在。无论是想离线收听,还是备份收藏的曲...

利用sounddevice实现的音频录制工具

许多开发者面对音频采集需求时,常被复杂的接口文档与设备兼容性问题困扰。Python生态中的sounddevice库因其简洁的...

简易屏幕颜色取色器

在数字设计、编程或日常办公场景中,色彩提取是一项高频需求。设计师需要精准匹配品牌色值,开发者可能需快速...

知乎问答数据跨平台迁移工具

在信息爆炸的时代,知识分享与内容迁移逐渐成为刚需。许多知乎用户曾面临这样的困扰:辛辛苦苦创作的优质回答...

MySQL数据库慢查询日志分析工具

凌晨三点的报警短信响起时,运维老张摸出床头柜的眼镜,盯着手机屏幕上突然飙升的数据库响应曲线,熟练地打开...

Unittest编写的测试用例管理工具

Unittest作为Python标准库中的测试框架,在软件测试领域占据重要地位。其内置的测试用例管理机制为开发者提供了系统...

批量生成测试虚拟数据工具(姓名-地址等)

在软件开发和测试环节中,真实数据的缺失常常成为效率瓶颈。无论是验证表单功能、模拟用户行为,还是测试数据...

Reddit帖子情感热度趋势分析系统

在信息爆炸的社交平台时代,如何精准捕捉用户情绪并预测话题趋势成为企业、研究机构的刚需。一款针对Reddit平台...

简易注册表清理器(安全项识别与删除)

对于长期使用Windows系统的用户而言,注册表冗余项积累导致的系统卡顿、软件冲突等问题并不陌生。传统的手动清理...

图像格式转换工具(支持JPG-PNG转换)

电脑里存着几百张照片,突然发现部分图片格式不兼容手机预览?设计好的透明Logo需要紧急提交却存成了JPG格式?这...

Excel公式批量转换为VBA代码工具

在数据处理领域,Excel公式与VBA代码的协作如同齿轮与轴承的精密咬合。当企业面临数百条复杂公式需要维护时,传统...

食谱热量计算工具

现代人对健康饮食的追求催生了众多智能工具,其中食谱热量计算器正逐渐成为厨房里的标配。这种工具通过精确的...

窗口化Base64编解码工具

在数据处理与传输的场景中,Base64编码作为一种常见的二进制转文本方案,频繁出现在开发、测试甚至日常办公中。...

命令行视频帧率单位换算工具(FPS-毫秒每帧)

在视频处理领域,帧率(FPS)与单帧时长(毫秒/帧)的换算常让从业者头疼。某个深夜,当剪辑软件突然显示"帧间隔...

计划执行的批量图片尺寸调整工具

现代数字场景中,图片处理需求呈现爆发式增长。某设计团队曾统计,其成员每周平均需要处理超过300张不同尺寸的...

基于Pandas的数据可视化快速生成工具

在数据清洗与分析的场景中,Python开发者时常面临这样的困境:耗费数小时完成数据预处理后,还需要在Matplotlib或...

文档格式转换工具(DOCX转PDF-TXT)

随着电子文档应用场景的多样化,DOCX转PDF/TXT的需求持续增长。无论是学术论文提交、企业合同归档,还是跨平台数据...

系统快捷键禁用工具(特定键屏蔽)

键盘快捷键的普及极大提升了操作效率,但误触或恶意操作也可能引发麻烦。想象一个场景:设计师正在用Photoshop赶...

批量下载网页图片资源爬虫工具

网络图片资源获取已成为设计师、自媒体从业者及普通用户的日常需求。面对海量图片素材时,手动保存不仅效率低...

跨域Cookie同步管理器

互联网应用中,跨域数据互通始终是开发者面临的棘手难题。某电商平台曾因主站与子域名购物车系统无法共享登录...