使用Scrapy框架的简易网页爬虫工具

互联网时代数据即黄金,如何快速获取目标数据成为开发者必备技能。Scrapy作为Python生态中的爬虫框架,凭借模块化架构在开发者社群积累良好口碑。这款开源工具用简洁的API设计,让数据抓取流程变得清晰可控。

架构设计暗藏玄机 Scrapy采用异步处理机制,内置的Twisted引擎让网络请求并行处理。引擎中心负责调度请求队列,下载器自动管理并发连接,数据管道支持自定义清洗逻辑。这种分层结构使得修改抓取策略时无需重构整体代码,开发者可以像搭积木一样替换各个组件。

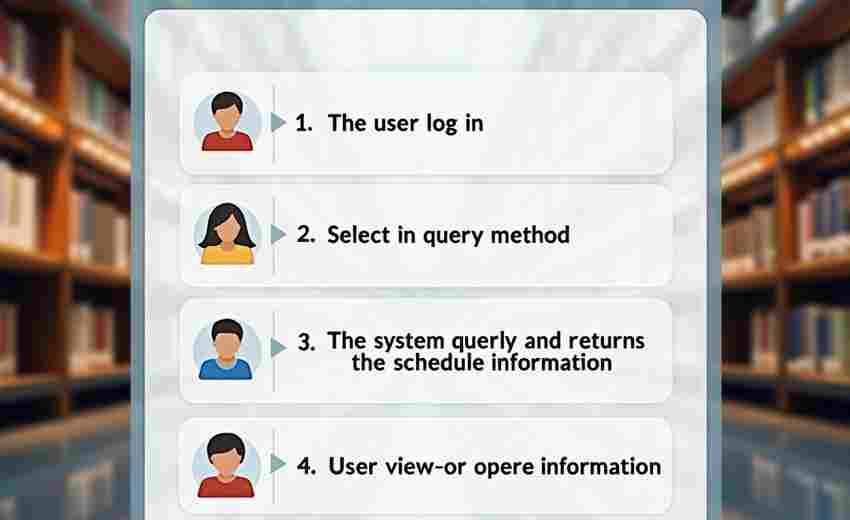

五分钟搭建原型 新建项目只需执行scrapy startproject指令,系统自动生成标准目录结构。在spiders目录创建爬虫类,定义初始URL和解析规则即可运行。例如抓取新闻标题的代码片段:

```python

class NewsSpider(scrapy.Spider):

name = 'news'

start_urls = ['

def parse(self, response):

for article in response.css('div.news-item'):

yield {'title': article.css('h2::text').get}

```

命令行执行scrapy crawl news -o result.json,数据自动存入JSON文件。

智能对抗反爬策略 面对网站验证码或IP封锁,可通过配置DOWNLOAD_DELAY参数控制访问频率。中间件模块支持自动切换User-Agent,配合代理IP池可有效规避封禁。部分动态加载内容需启用Splash渲染引擎,处理JavaScript生成的数据。

企业级扩展方案 分布式爬虫可借助Scrapy-Redis实现多机协作,消息队列保证任务不重复。云服务商提供托管方案,AWS EC2搭配S3存储实现PB级数据采集。当遇到复杂登录验证时,可集成Selenium模拟浏览器操作获取Cookies。

调试阶段建议启用FEED_EXPORT_ENCODING确保中文不乱码,部署时注意遵守robots.txt协议。官方文档提供完整的类型注解,社区维护的扩展库覆盖主流网站API对接需求。掌握XPath与CSS选择器编写技巧,能显著提升数据定位精度。

- 上一篇:使用Scrapy框架的简易爬虫实例

- 下一篇:使用Scrapy的定制化网页爬虫框架

相关软件推荐

使用Folium库生成地理位置标记地图

发布日期: 2025-06-30 10:42:02

Folium作为地理数据可视化工具在Python生态中占据独特地位。该库基于Leaflet.js开发,能够...

Python自动化测试框架unittest库

发布日期: 2025-04-17 19:24:03

在Python生态中,unittest作为标准库自带的测试框架,历经20余次版本迭代依然保持着强大...

使用APScheduler的定时桌面提醒工具

发布日期: 2025-04-24 14:07:57

在信息过载的日常工作中,很多人都有过忘记重要事项的经历。基于Python的APScheduler库...

使用pyinstaller的可执行文件打包工具

发布日期: 2025-05-01 18:00:41

PyInstaller作为Python生态中一款高效的打包工具,凭借其简洁的操作逻辑,成为开发者分...

利用pygame的简单2D游戏框架工具

发布日期: 2025-05-27 13:00:24

安装Python环境后输入pip install pygame的瞬间,一个充满可能性的2D世界就此开启。作为S...

随机软件推荐

视频字幕自动合并工具(SRT文件处理)

在数字内容爆炸的时代,字幕文件处理已成为视频工作者绕不开的日常课题。某影视工作室最近完成的项目数据显示...

多线程文件内容搜索工具(支持正则匹配)

在信息爆炸的数字化时代,硬盘中堆积的文档、日志和代码文件常常让精准检索变得如同大海捞针。传统单线程搜索...

根据学习进度生成甘特图的任务管理工具

项目管理领域经典的甘特图技术,正以全新形态渗透进个人学习管理场景。当传统纸质计划本难以应对复杂的知识体...

文件加密解密工具(对称加密保护敏感文件)

在数字化浪潮下,个人隐私泄露事件频发。某银行职员因误将存储在未加密U盘中,导致三万条个人信息在黑市流通。...

基于IP地址的设备类型识别工具

在万物互联的数字化时代,网络环境中各类设备的身份判定成为运维管理的关键环节。一款基于IP地址的设备类型识别...

多语言翻译文件自动排序工具

全球化协作中,翻译文件的混乱排序常导致效率断崖式下跌。某跨国电商团队曾因语言包版本错乱,导致西班牙语商...

Git备份文件按日期分类存储工具

场景痛点 程序员小张凌晨两点完成代码调试,随手执行`git commit -m "update"`后倒头就睡。次日发现新功能导致核心模块...

Markdown格式转换HTML网页生成器

在内容创作与技术开发交叉的领域,一种工具正在悄然改变文档处理的效率天花板——基于Markdown的HTML网页生成器。...

利用APScheduler的任务定时执行管理器

凌晨三点的服务器监控警报突然响起,开发团队发现某个核心服务的数据同步任务连续失败。运维人员排查两小时后...

健身补给品库存预警管理系统

国内健身市场规模突破5000亿元大关的背景下,健身补给品市场年均增长率达18.6%。传统库存管理方式在应对多品类、...

桌面随机密码生成器(可自定义复杂度)

互联网时代,密码如同家门钥匙。据Verizon数据泄露报告显示,80%以上的网络攻击与密码脆弱性直接相关。桌面随机密...

支持符号链接处理的增量备份工具

在日常数据管理中,符号链接(Symbolic Link)的使用场景日益普遍。无论是开发者通过软链管理多版本依赖,还是运维...

键盘输入硬件状态监测诊断器

办公室角落传来密集的敲击声,李工盯着屏幕上突然卡顿的输入光标,第八次尝试输入验证码失败。这种场景在数字...

单词本背诵与闪卡学习工具

纸质单词本在书包里泛着柔和的米黄色,电子闪卡在手机屏幕闪烁冷光,两种工具承载着不同时代学习者的记忆密码...

图像ASCII字符画转换器(灰度映射)

在数字世界的某个角落,一种特殊的艺术形式正悄然流行——用键盘上的字符重构视觉世界。某位平面设计师在深夜...

基于文件创建时间的排序备份工具

在数字时代,文件备份如同给数据买保险,但如何高效管理备份内容却让许多人头疼。传统的按文件名或修改时间排...

Turtle模块绘制的动态时钟小程序

在Python的图形绘制领域,Turtle模块始终保持着独特的魅力。它如同数字时代的画笔,让编程初学者也能直观感受图形...

局域网内群发消息通知工具

在办公会议前五分钟,行政人员需要紧急通知所有部门参会;学校机房管理员要在下课前三分钟统一关闭学生电脑;...

窗口置顶浮动控制小工具

对于需要频繁切换窗口的工作场景来说,桌面管理常常成为效率杀手。程序员调试代码时被遮挡的日志窗口、设计师...

图像分辨率单位换算工具(像素-厘米-英寸)

在这个数字化主导的时代,图像处理已成为日常工作中的高频操作。当设计师面对印刷需求时,屏幕上的像素数值突...

基于正则表达式的敏感数据扫描工具

在数据安全防护领域,敏感信息泄露如同潜伏的暗礁,稍有不慎便会导致企业声誉受损或面临法律风险。传统的关键...

外卖平台订单合并处理工具

午高峰的后厨烟雾弥漫,服务员手中的订单打印机疯狂吐纸。"美团18号单3份黄焖鸡""饿了么27号要免葱""抖音套餐备注...

基于HTTP请求的定时服务状态检查工具

在分布式架构主导的互联网环境中,服务可用性直接决定业务存亡。当人工巡检无法应对数以千计的API接口时,基于...

网页截图缩略图生成工具

在信息爆炸的数字化时代,网页内容的快速传播离不开视觉化呈现。无论是设计师、开发者,还是内容创作者,经常...

颜色拾取坐标轨迹记录回放器

在数字设计、软件开发或数据分析领域,重复性操作往往消耗大量时间。一款名为 坐标轨迹记录回放器 的工具,通过...

离线缓存汇率数据查询工具

金融交易与跨境消费场景中,汇率波动常带来不确定性。某款汇率查询工具通过离线缓存功能,解决了网络环境不稳...

用户回访行为漏斗演变追踪系统

在流量红利逐渐消失的市场环境中,用户回访行为的数据价值被提升到战略高度。某头部电商平台通过精细化运营将...

基于Pillow的图片批量添加边框工具

图片处理领域常会遇到为作品添加边框的需求,无论是提升视觉美感还是统一图片比例,批量添加边框工具都能显著...

基于PyQt的跨平台图片处理应用程序

在数字内容创作日益普及的当下,图像处理工具的选择直接影响着工作效率。一款名为PyImageToolkit的开源软件近期在开...

文本转语音朗读器(gTTS库+音频播放)

在数字化工具日益普及的今天,文本转语音技术逐渐成为刚需。Python生态中的gTTS库搭配音频播放模块,为开发者提供...

新闻头条每日推送脚本(接入新闻API)

在信息爆炸的时代,如何高效获取精准新闻成为刚需。一款基于新闻API的自动化推送脚本工具近期引发关注,其核心...

自动整理下载文件夹的脚本(按文件类型分类)

每次打开电脑的下载文件夹,各类文件混杂堆叠的场面总让人血压飙升。安装包、压缩文档、图片、视频、PDF文档毫...

招聘网站职位信息批量爬取与存储系统

近年来,企业招聘需求与人才流动频率显著增长,招聘网站每日产生海量岗位信息。传统人工检索方式存在效率瓶颈...

Excel单元格内容翻译工具

日常工作中遇到多语种Excel文件时,手动逐行翻译既耗时又容易出错。针对这个痛点,近期市场上涌现出多款单元格翻...

定时任务执行提醒程序(桌面弹窗通知)

清晨八点的会议资料还没准备?下午三点医院挂号需要准时开抢?对于健忘症人群而言,错过重要事项的焦虑感时常...

天气查询桌面小部件(API数据抓取)

窗外的天气总在无声中影响生活节奏。当传统天气软件需要频繁点击刷新时,智能化的桌面小部件正悄然改变着信息...

系统回收站文件恢复工具

日常办公中误删文件的情况时有发生。当回收站被清空或文件被永久删除时,多数人会陷入数据丢失的焦虑。本文将...

语音转文字基础工具(调用API实现)

嘈杂的会议室里,智能设备正在将七嘴八舌的讨论转化为整齐的文字记录;深夜加班的编辑戴着耳机,视频素材里的...

批量重命名工具(序号-日期前缀)

办公桌上堆叠着三百多张产品图,文件名显示"IMG_2023_副本(2)(最终版).jpg"时,多数人都会产生砸键盘的冲动。这种混乱...

目录结构可视化树状图生成器

面对复杂的项目目录或凌乱的文件夹体系,用户常陷入反复点击、逐层查找的困境。可视化树状图生成工具的出现,...