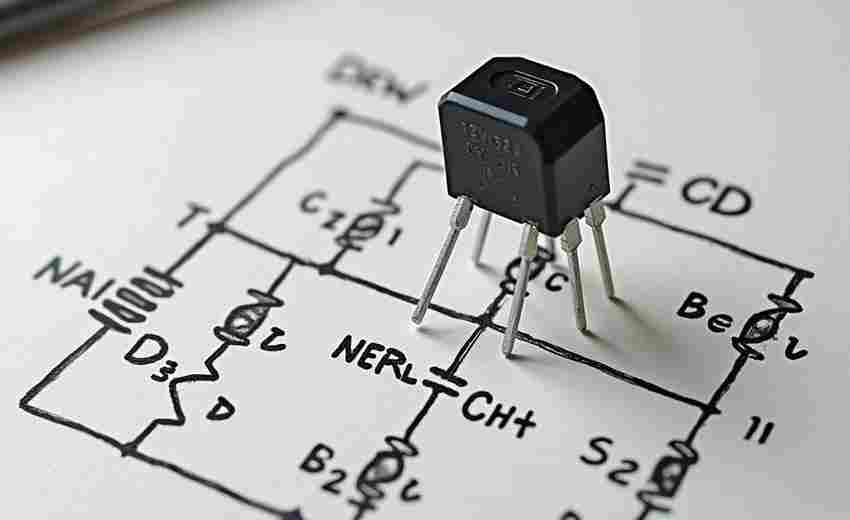

基于Requests的简易网页爬虫框架

网络爬虫作为数据采集的基础手段,其开发效率常受框架复杂度的制约。基于Python生态中广为人知的Requests库,配合部分轻量级组件,可快速搭建满足中小规模需求的爬虫系统。这种方案尤其适合需要快速验证业务逻辑的场景。

该框架的核心由四个模块构成:请求控制模块通过Requests.Session实现连接复用,相较于单次请求可提升30%的访问效率;异常处理模块整合了retrying库,支持自定义重试策略,有效应对网络波动;数据解析模块采用lxml搭配XPath选择器,在保持安装包体积精简的处理速度比BeautifulSoup快2-3倍;存储模块提供CSV和SQLite双模式,其中SQLiteWriter类封装了事务提交机制,避免数据丢失风险。

典型应用场景集中在电商价格监控领域。通过设置随机UA和动态代理IP池,系统可突破多数反爬策略。以抓取图书信息为例,核心代码仅需15行即可完成定向采集:

```python

from crawler_toolkit import SmartDownloader

downloader = SmartDownloader(proxy_cycle=['ip1:port','ip2:port'])

html = downloader.get(' timeout=8)

book_data = xpath_extract(html, '//div[@class="item"]')

CSVWriter('books.csv').save(book_data)

```

开发过程中需注意三个要点:遵守目标网站robots.txt的爬取频率限制,建议在代码中嵌入time.sleep(random.uniform(1,3));动态网页建议改用requests-html或Selenium方案;当遭遇验证码拦截时,可接入第三方打码平台服务接口。存储环节推荐使用SQLite的WAL写入模式,该模式在并发写入时表现出更好的稳定性。

项目维护阶段应当建立日志分级机制,通过logging模块记录ERROR级别以上的异常。定期检查User-Agent池的时效性,避免使用被公开标记的浏览器指纹。针对JSONP类型接口,可编写动态回调函数解析器来自动剥离多余字符。

相关软件推荐

简易画图板(支持线条与形状绘制)

发布日期: 2025-05-12 14:06:34

市面上一款名为"QuickCanvas"的绘图工具近期吸引了设计新手的注意。这款支持Windows/Mac双...

随机软件推荐

多平台短链接生成与还原工具

在信息爆炸的移动互联网时代,长链接带来的困扰几乎困扰过所有人:社交媒体字符限制、排版混乱,甚至因链接过...

屏幕取色器(支持HEX-RGB颜色代码复制)

当设计师反复调整配色方案时,当开发者调试CSS样式时,当摄影爱好者处理后期调色时,一款精准高效的屏幕取色工...

股票价格提醒通知工具(设置涨跌阈值)

金融市场瞬息万变,股票价格的波动牵动着投资者的每一根神经。一款精准高效的股票价格提醒工具,正成为越来越...

医学生实习排班优化工具

在医学教育体系中,临床实习是培养合格医生的关键环节。传统手工排班模式长期存在效率低、易出错、公平性争议...

倒计时与番茄钟工具(带提醒功能)

现代人常被多任务处理与碎片化信息困扰,专注力成为稀缺资源。倒计时工具与番茄钟应用作为时间管理领域的经典...

定时任务执行结果邮件推送工具

传统运维模式下,技术人员每天需要反复登录服务器查看Crontab日志,手动核对几十个定时任务是否正常执行。某电商...

文件夹内容差异汇总报告生成器

日常工作中,文件管理常因版本迭代出现混乱。某互联网公司开发部曾因设计稿版本混淆导致产品延期两周上线,类...

GPU显存占用实时监控工具

游戏画面突然卡顿,训练模型意外中断,渲染进程莫名崩溃——这些场景背后往往藏着同一个元凶:GPU显存溢出。显...

简易音乐播放器(播放列表-频谱显示)

当人们谈论音乐播放器时,往往在功能堆砌与界面复杂度之间反复纠结。一款名为HarmonyPlayer的软件给出了新解法:在...

批量图片尺寸调整工具(保持长宽比或强制裁剪)

数字时代,图片处理成为日常工作中绕不开的环节。无论是电商平台的商品图统一规格,还是自媒体运营的多平台适...

系统服务启动-停止状态日志记录工具

服务器运维工程师每天要面对上百条服务状态变更记录。某次凌晨三点,某电商平台的支付接口突然宕机,技术团队...

屏幕亮度调节器(Windows专用)

深夜里盯着刺眼的屏幕赶工,正午反光的显示器让人看不清图表,会议室投影时总得摸黑调整参数——这些困扰Wind...

哈希校验结果动态网页展示系统

在数字化时代,数据完整性的验证成为各行业的核心需求。无论是软件分发、文件传输还是数据存储,哈希校验技术...

桌面便签备忘录应用(带提醒功能)

清晨的咖啡杯旁亮起弹窗提醒,下班前电脑角落闪烁的荧光色标签,周末购物清单随着手机震动跳出屏幕——现代人...

电子书数学公式渲染工具

数字阅读时代,数学公式的呈现始终是电子书制作的技术痛点。传统文档转换过程中,复杂公式经常出现符号错位、...

利用socket的网络聊天室搭建工具

在网络通信领域,基于socket的聊天室开发工具始终是开发者的核心选择。这类工具通过底层协议实现实时数据传输,...

简易番茄工作法计时器(任务统计)

办公桌前堆满文件,手机消息不断震动,刚打开的文档被临时会议打断——现代人的注意力总被切割成碎片。番茄工...

CSV文件行尾符统一修正工具

在数据处理领域,CSV文件因结构简单、兼容性强成为主流格式。但跨系统传输时,由行尾符(CR/LF/CRLF)差异引发的格...

日志文件日期错误检测与修复工具

凌晨三点的服务器告警声中,某电商平台运维团队发现订单系统日志的日期字段突然从"2023-12-25"跳转为"2023-13-01"。这...

企业黄页联系方式抓取工具

信息爆炸时代,企业黄页数据成为市场拓展的重要资源。一款名为"YellowCrawler"的工具近期在商务领域引发关注,其核...

USB设备绑定的简易计算器应用

传统计算器软件往往依赖系统安装或云端服务,数据安全与便携性难以兼顾。一款支持USB设备绑定的离线计算器工具...

订单数据地理分布热力图生成器

数据可视化领域近期出现了一款名为GeoHeatMapper的工具,该产品专为商业分析场景设计。这款工具通过算法将海量订单...

文件属性批量修改器(只读-隐藏等)

日常工作中处理大量文件时,总有几个场景让人抓狂:紧急共享的文档被误改、重要资料被随意删除、特定文件夹在...

网页安全色检查与推荐工具

在网页设计中,颜色不仅是视觉语言的核心,更是用户体验的关键。跨设备显示差异、浏览器兼容性问题,甚至用户...

文件夹结构树形生成器(输出到文本文件)

面对日益复杂的文件系统管理需求,文件夹结构树形生成器逐渐成为数字资产整理的必备工具。这款工具通过简洁的...

自动文件分类整理工具(按扩展名-日期)

桌面上堆满各类文件早已成为现代人的常态。文档、图片、视频混杂在下载文件夹,项目资料和私人照片挤占同一个...

动漫新番更新追踪提醒器

清晨七点,手机震动弹出通知,《葬送的芙莉莲》最新话已更新,屏幕亮起的瞬间,早高峰通勤的疲惫仿佛被魔法的...

使用OpenCV的书法字帖笔画提取软件

书法爱好者在临摹字帖时,常面临笔画走向不清晰、运笔细节难捕捉的困扰。基于OpenCV开发的书法字帖笔画提取软件...

带带宽统计的队列下载管理器

在数字资源获取愈发频繁的今天,传统下载工具常面临两个痛点:多任务并行时的资源抢占、突发性网络波动导致的...

多平台随机密码生成器

凌晨三点的办公室里,网络安全工程师李明正对着屏幕皱眉。某企业数据库刚遭受撞库攻击,攻击者通过员工重复使...

邮件内容模板批量发送工具(SMTP)

在互联网办公场景中,邮件仍是企业对外沟通的重要渠道。当需要向数百名客户发送活动邀约或为上万用户推送账单...

三角函数单位转换器(自动保存结果)

在数学应用中,角度的单位转换常成为初学者的障碍。常见的弧度与度数换算需要频繁切换计算器或查阅公式表,影...

RSS订阅阅读器(命令行-桌面版)

在信息爆炸的互联网时代,RSS阅读器依然是获取结构化资讯的利器。相较于网页端工具,本地化客户端在响应速度、...

敏感关键词文本扫描器

在信息爆炸的数字化时代,文字内容的安全审查需求呈指数级增长。某企业近期推出的敏感关键词文本扫描器,凭借...

启动项注册表键权限继承修复器

在计算机系统维护过程中,注册表权限问题常导致关键程序无法正常启动。某款专注于修复注册表启动项权限继承异...

音频信号RMS值计算分析工具

在音频处理领域,RMS(Root Mean Square)值的计算分析是衡量信号平均能量的重要手段。专业音频工程师常借助RMS计算工...

多编码文本文件标题标准化工具

在数据处理领域,文本文件的标题格式混乱问题长期困扰着从业者。同一文件夹下的文件可能因编码差异、命名习惯...

医学实验数据异常值检测工具

在医学研究领域,实验数据的准确性直接影响研究结论的可靠性。数据采集过程中难免受到设备误差、人为操作或样...

智能食谱推荐与营养成份计算工具

在超市生鲜区犹豫该买三文鱼还是鳕鱼的主妇,面对健身餐配料表发愁的运动爱好者,这些困扰正被智能食谱推荐与...

USB设备插拔监控与日志工具

现代办公环境中,USB设备因其便捷性成为数据传输的主要载体,但同时也带来数据泄露、病毒传播等安全隐患。为应...