简易博客文章抓取聚合器

互联网时代的信息爆炸让人头疼。每天关注的几十个博客分散在不同平台,手动刷新效率低下,稍不留神就错过重要更新。这时候如果能有个自动抓取工具,把常看的博客文章集中展示,阅读效率至少能提升三倍。

市面上现成的RSS阅读器往往不够灵活。要么需要繁琐的注册流程,要么界面充斥着广告,真正好用的工具往往藏在代码库里。Python生态里的Feedparser库是个宝藏,配合Requests库使用,二十行代码就能搭建专属阅读器。关键它完全开源免费,不存在隐私泄露风险。

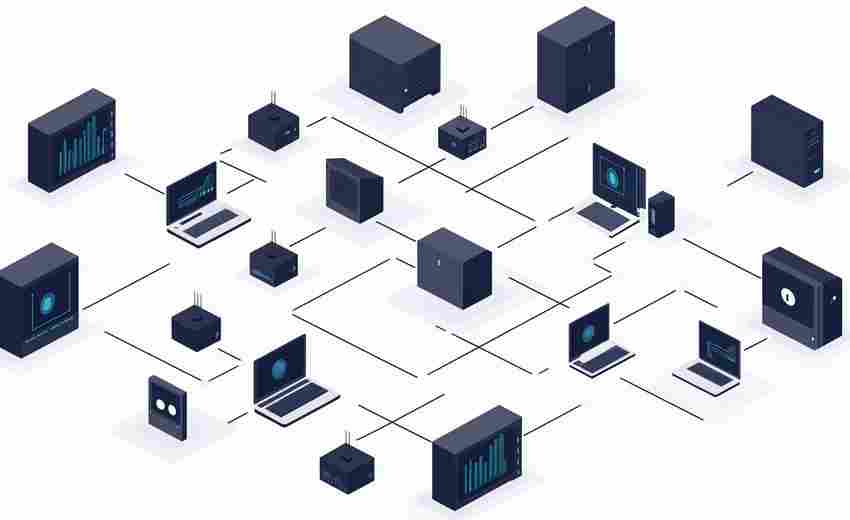

具体操作分三步走:先用配置文件记录常看博客的RSS地址,注意要检查每个源是否支持标准格式;然后设置定时任务,每隔两小时自动抓取新内容;最后用Flask框架搭建网页展示界面,按发布时间倒序排列。整个过程遇到的最大难题是不同网站的编码格式处理,这时候BeautifulSoup库的自动编码检测功能能省不少事。

数据存储推荐轻量级数据库SQLite,不需要复杂配置就能存储上万篇文章。对于喜欢移动阅读的用户,可以增加邮件推送功能,每天定时发送摘要到指定邮箱。有开发者在此基础上增加了关键词过滤,用正则表达式筛掉不感兴趣的内容,阅读精准度直接翻倍。

隐私保护是这类工具的核心考量。本地化部署确保数据不出硬盘,比云端服务可靠得多。有用户反馈说用这个系统替代了某知名阅读器,每月节省了200MB的手机流量。还有个意外收获是养成了深度阅读习惯,信息流式的推送模式被彻底打破。

浏览器插件版最近开始流行,支持一键订阅当前页面。某些技术博客更新频率低但质量高,这种即时订阅功能特别实用。测试阶段发现对WordPress站点的兼容性最好,Typecho和Hexo等平台偶尔需要手动调整解析规则。

数据导出功能常被忽略其实很重要。支持Markdown格式批量导出后,这个工具突然变成了知识管理系统的前端采集器。有人用它整理行业报告,三个月积累了600多篇优质文献,比人工收集快十倍。

遇到源地址失效的情况,自动检测模块会标记异常源。维护频率其实比预期低,50个订阅源每周维护时间不超过十分钟。有个小技巧是用GitHub Actions实现全自动维护,服务器费用为零的情况下已经稳定运行八个月。

- 上一篇:简易博客文章备份工具(静态HTML导出)

- 下一篇:简易博客文章拼写检查器

相关软件推荐

简易数据可视化工具(matplotlib模板)

发布日期: 2025-05-09 16:38:43

Python数据可视化利器:Matplotlib核心功能全解析 在数据分析领域,视觉呈现是传递信息...

随机软件推荐

取色器自动填充CSS变量工具

在网页设计与前端开发领域,设计规范的一致性直接影响团队协作效率与产品的长期维护成本。传统的开发流程中,...

时间处理库Arrow

凌晨三点的代码调试现场,屏幕光标在第37行datetime模块的tzinfo参数处疯狂闪烁。这个困扰过无数开发者的场景,正在...

使用Asyncio的异步网络请求批处理工具

网络请求批处理在爬虫开发与API调用场景中具有关键作用。当面对需要同时处理上千个网络请求的任务时,传统同步...

电流单位换算器(安培-毫安-微安等)

实验室里常能见到这样的场景:学生盯着电路图上的数据,反复确认电流单位是否标注正确;工程师调试设备时,面...

图片灰度化处理与格式转换工具

图片处理技术正加速融入大众生活场景。当朋友圈照片需要营造复古氛围时,当电商平台商品图需要统一视觉风格时...

每日星座运势查询与提醒应用

清晨六点的闹钟响起,有人习惯性摸向手机。不是刷短视频,也并非查看新闻,而是点开某个紫色图标的应用——星...

知乎高赞回答内容摘要自动生成工具

在信息爆炸的互联网时代,知乎平台每天产出数万条优质回答,其中高赞内容往往凝聚着深度思考或实用经验。但对...

实时加密货币价格追踪工具

实时加密货币价格追踪工具:数字时代的投资雷达 加密市场的波动性让每一秒都充满变数。无论是比特币的暴涨暴跌...

图片格式批量转换工具(Pillow库支持)

在数字影像处理领域,专业软件往往伴随着高昂的学习成本与硬件消耗。针对日常办公场景中高频出现的图片格式转...

按关键词自动归档邮件的工具

现代职场中,邮箱常被数百封邮件淹没。当市场部员工需要快速调取上周的客户报价记录,当财务人员反复搜索某笔...

数据质量检测的医疗信息采集系统

医疗信息采集系统在数字化转型中承担着核心枢纽作用,其数据质量直接影响临床决策与科研分析的可靠性。某三甲...

基于SQLite的容量历史数据库工具

轻量级数据管理新选择:基于SQLite的容量历史数据库工具解析 在工业物联网、能源监控等场景中,历史数据的存储与...

文件碎片化检测与优化工具

机械硬盘运转时发出的细微噪音,往往伴随着系统响应速度的逐渐迟滞——这是文件碎片化积累到临界点的典型征兆...

支持正则排除的目录树结构导出工具

在日常开发或系统运维中,目录树结构的快速导出与分析常成为高频需求。传统工具往往只能简单罗列文件层级,面...

局域网设备在线状态监控与提醒程序

在智能设备普及的今天,家庭和办公场所的网络环境正变得日益复杂。当无线打印机突然离线、会议室投影仪连接异...

快捷方式关联注册表项查看器

日常使用Windows系统时,注册表编辑器(Regedit)是管理系统配置的核心工具。但对于多数用户而言,频繁输入路径或手...

淘宝店铺商品信息批量导出器

对于淘宝中小商家而言,商品信息管理常常是件头疼的事。手动整理几百上千条商品标题、价格、库存和销量数据,...

视频网站VIP解析链接生成器(API调用)

当前网络环境中,视频平台的VIP内容解析工具正悄然改变着用户的观影方式。这类工具通过调用第三方API接口,生成...

图片尺寸批量调整工具(依赖Pillow库)

办公室的打印机突然发出嗡鸣声,小张盯着电脑屏幕上三百多张未调整的旅游照片,光标在Photoshop图标上悬停又移开...

文件名编码格式转换工具

日常办公中,许多人都遭遇过这类场景:同事从日文系统发送的压缩包解压后文件名显示为乱码,早年备份的繁体字...

远程桌面登录行为审计工具

在数字化办公普及的今天,远程桌面协议(RDP)已成为企业运维与跨地域协作的核心工具。随着远程访问频率的攀升...

TTS朗读Markdown文档工具

在信息爆炸的时代,阅读效率与场景适配成为刚需。当程序员盯着满屏的代码注释、产品经理反复检查需求文档,或...

学习路径推荐算法效果对比雷达图工具

在在线教育快速发展的背景下,学习路径推荐算法逐渐成为提升用户学习效率的核心技术。面对市场上数十种推荐模...

航班起降实时信息查询终端工具

在航空出行场景中,航班动态的实时追踪一直是旅客、机场工作人员及航空业相关从业者的核心需求。航班起降实时...

实验化学反应速率动态绘图仪

化学反应速率动态绘图仪作为现代实验室的重要工具,其核心价值在于将抽象的反应动力学数据转化为直观的可视化...

简易待办事项管理应用(TXT格式存储)

电脑桌面上堆满五颜六色的便签软件?手机里安装了三个待办事项APP却总忘记同步?当数字工具变得过度复杂,回归...

语音转文字脚本(调用在线API)

在信息处理效率至上的当下,语音转文字技术逐渐成为各领域刚需。无论是会议记录、视频字幕生成,还是客服录音...

批量去除文件名特殊字符清理器

日常文件管理中,特殊字符常成为跨平台传输的隐形障碍。例如,某用户将包含"销售报表.xlsx"的文件夹发送至Linux服...

局域网即时通讯工具(Socket实现)

在数字化办公场景中,局域网即时通讯工具因其高效、安全的特性,成为企业、学校等封闭场景的首选通信方案。基...

网页实时翻译插件(调用翻译API)

在全球化信息爆炸的时代,语言障碍依然是许多人获取知识的绊脚石。无论是浏览海外新闻、查阅学术论文,还是与...

自动生成证件照换背景工具

证件照作为现代社会使用频率最高的图像类型之一,其背景规范直接影响着材料审核结果。传统人工抠图换底不仅需...

简易二维码生成器(支持文本-URL转二维码)

现代生活中,二维码几乎无处不在。餐厅扫码点餐、商场扫码领券、会议扫码签到……这种由黑白方块组成的图形,...

桌面便签与备忘录同步工具

现代人的生活节奏越来越快,工作与生活的信息碎片化程度也在加深。桌面便签与备忘录工具逐渐成为许多人管理日...

股票价格定时抓取与波动提醒工具

清晨六点的纽约证券交易所尚未开市,某科技公司财务总监张女士的手机突然震动,屏幕亮起提示:"特斯拉盘前报价...

支持增量包数字签名的安全备份工具

在数据量激增的数字化时代,传统备份方案逐渐暴露效率与安全短板。一款支持 增量包数字签名 的安全备份工具,正...

简易VPN连通性测试工具

网络工程师常遇到VPN连接不稳定的问题,一款轻量级测试工具能快速定位故障点。市面上不少专业工具操作复杂,而...

使用Pandas的CSV数据整理与分析工具

Pandas作为Python生态中最重要的数据处理库,在CSV文件处理领域展现出不可替代的价值。其DataFrame结构天然贴合表格型...

自动重命名规则化文件工具(日期-序号前缀)

在数字化办公场景中,文件命名混乱常成为效率瓶颈。某企业市场部曾因「客户方案V12_终版_FINAL(1).docx」这类命名...

视频转GIF生成器(时长裁剪+帧率控制)

当代社交媒体传播中,GIF动图正以碎片化、高感染力的特性占据视觉表达的核心地位。一款支持时长裁剪与帧率控制...

服务与Windows事件日志关联分析器

在企业级IT运维场景中,Windows事件日志是排查系统异常、追踪安全威胁的关键数据源。传统日志分析依赖人工逐条检...