命令行网络爬虫(指定网页内容抓取)

在图形化工具盛行的时代,命令行网络爬虫依然保持着独特的生命力。这类工具以代码即文档的特性,为开发者提供了精准控制网页抓取流程的可能性。(删除了"首先"等过渡词)

终端里的瑞士军刀

系统自带的curl命令堪称最原始的爬虫工具,`curl -L > page.html` 这条指令能绕过多数反爬机制直接获取网页源码。结合grep命令进行关键词过滤,例如`curl -s URL | grep -E "正则表达式"`,可在10秒内完成特定信息提取。(加入具体参数说明)

进阶用户偏爱httpie工具,其`http --headers --form POST URL key=value`语法能模拟各类请求。某金融数据平台曾用200行Shell脚本配合httpie定时抓取股票信息,日均处理请求量超过20万次。(加入实际案例)

结构化数据提取利器

处理HTML文档时,pup工具展现出惊人效率。`curl -s URL | pup 'div.content text{}'`可直接提取指定CSS选择器的文本内容。某电商价格监控项目通过`pup 'span[class^="price"] attr{data-value}'`精准抓取动态渲染的价格数据。(突出技术细节)

面对JSON数据源,jq工具堪称命令行界的Python字典。`curl API接口 | jq '.data[].id'`能快速提取嵌套数据结构,配合`--slurp`参数可批量处理百万级JSON记录。(使用专业参数)

实战中的组合技

1. 动态网页破解:`xidel --css 'div.list' --output-format=json URL`直接解析JavaScript渲染内容

2. 自动化采集:结合watch命令实现定时抓取,`watch -n 300 "curl URL >> log.txt"`

3. 突破反爬限制:`wget --random-wait --limit-rate=200k -U "Mozilla" URL`模拟人类操作特征

终端环境配置直接影响抓取效率,建议使用tmux保持会话持久化。异常处理可借助`timeout 10 curl URL`设定超时机制,网络波动时通过`curl --retry 3`自动重试。(加入配置技巧)

法律边界需时刻警惕,`robots.txt`解析应成为抓取前的标准动作。数据存储遵循最小化原则,敏感字段建议采用`sha1sum`进行哈希脱敏。(强调合规要求)

- 上一篇:命令行简易聊天室工具

- 下一篇:命令行网页爬虫(指定内容抓取)

相关软件推荐

命令行下的文本绘图工具(ASCII艺术)

发布日期: 2025-04-11 09:57:01

在纯黑终端界面敲击代码时,某些开发者会突然执行"cowsay Hello World",屏幕随即跳出一...

随机软件推荐

邮件地址有效性检查工具

邮件地址作为现代通讯的核心标识符,其有效性直接影响信息触达率。根据国际反垃圾邮件组织统计,全球每年因无...

Tkinter待办事项清单应用

在信息爆炸的时代,待办事项管理已成为现代人对抗拖延症的重要方式。市面上虽然存在各类复杂的时间管理软件,...

打印机安全漏洞扫描工具(CVE检测)

近年来,打印机这类看似普通的办公设备频频成为网络攻击的跳板。攻击者通过未修复的固件漏洞、开放的端口或默...

轻量级CSV数据模糊检索工具

面对海量CSV格式数据时,快速定位所需信息往往令人头疼。传统方法需要编写复杂脚本或依赖专业软件,而轻量级模...

文件编码转换器邮件自动处理版

当某外贸公司的技术主管张林第一次收到日本客户的邮件附件时,他面对乱码的CSV文件足足折腾了半小时。这类因文...

工业产品三维模型版本追踪命名系统

在工业产品设计领域,三维模型版本迭代频繁,工程师常面临文件命名混乱、历史版本追溯困难等问题。传统的文件...

CPU内存占用历史图表

二十年前,工程师排查系统卡顿只能通过命令行敲入代码,在密密麻麻的文本中寻找异常数值。如今,动态可视化的...

驱动程序备份任务暂停-恢复控制器

对于经常重装系统的技术员来说,驱动程序备份是个既重要又头疼的工作。当系统意外崩溃或硬件升级时,完整驱动...

会议纪要生成工具(录音转文字基础版)

会议室里此起彼伏的讨论声逐渐停歇,市场部小王望着笔记本上潦草的速记皱起眉头。此刻若有一款能将三小时会议...

简易计算器图形界面工具

普通用户日常使用的计算器软件大多功能单一,但在开发者眼中,这类工具承载着人机交互的典型范例。现代编程语...

数据库查询终端(SQLite简易界面)

在数据处理需求日益增长的当下,一款操作门槛低、适配性强的数据库管理工具显得尤为重要。SQLite凭借其轻量化、...

办公文档合并工具(多个DOCX或PDF合并)

日常办公中,不同格式的文档散落在各个工作环节。业务部门提交的PDF合同、市场部的DOCX方案书、技术团队的图表文...

密码强度检测与随机密码生成工具

数字时代,密码如同守护账户的隐形盾牌。当某电商平台因弱密码漏洞导致百万用户信息泄露时,人们才惊觉密码安...

日志文件自动切割工具

在服务器运维领域,日志文件管理常被视为"隐藏的痛点"。单一日志文件持续增长可能导致磁盘空间告急、检索效率低...

网页内容翻译与多语言转换工具

互联网的普及让信息传播打破地域限制,跨国交流逐渐成为日常。面对海量外文资讯,语言障碍却成为信息获取的拦...

批量下载重命名规则冲突解决工具

在日常工作中,批量下载文件引发的命名冲突一直是令人头疼的问题。例如从网盘批量保存图片、从学术平台批量导...

文件分割与合并工具(指定块大小)

面对动辄几十GB的影视素材或工程文件,传统传输方式常遭遇瓶颈。云端存储平台的单文件限制、邮件附件的大小约束...

农历公历双向转换查询工具(带节气提示)

农历与公历作为两种历法体系,长期并行于社会生活的不同领域。传统节日、生辰八字常以农历为基准,而现代工作...

JSON格式校验美化工具(语法检测+缩进优化)

JSON作为轻量级数据交换格式,早已渗透到程序开发的每个角落。无论是前后端接口调试、配置文件修改,还是数据持...

批量生成缩略词解释文档工具

在技术文档撰写、学术研究或企业内部协作中,缩略词的使用极为普遍。手动整理一份完整的缩略词表不仅耗时耗力...

多层级目录扩展名扫描统计工具

在日常文件管理中,用户常会遇到同一项目下存在数百个嵌套子目录的情况。例如,程序员维护代码仓库时,可能需...

简易待办事项日历(周视图-月视图)

现代人面对复杂日程时,纸质记事本和零散的电子备忘录常导致重要事项遗漏。一款以周视图和月视图为核心设计的...

桌面便签工具(支持云同步)

现代人的工作与生活节奏日益加快,碎片化信息的管理成为刚需。一款支持云同步的桌面便签工具,逐渐成为职场人...

网站SSL证书到期提醒监控器

互联网时代,SSL证书如同网站的“身份证”,承担着加密数据传输、验证服务器身份的核心功能。证书过期问题常被...

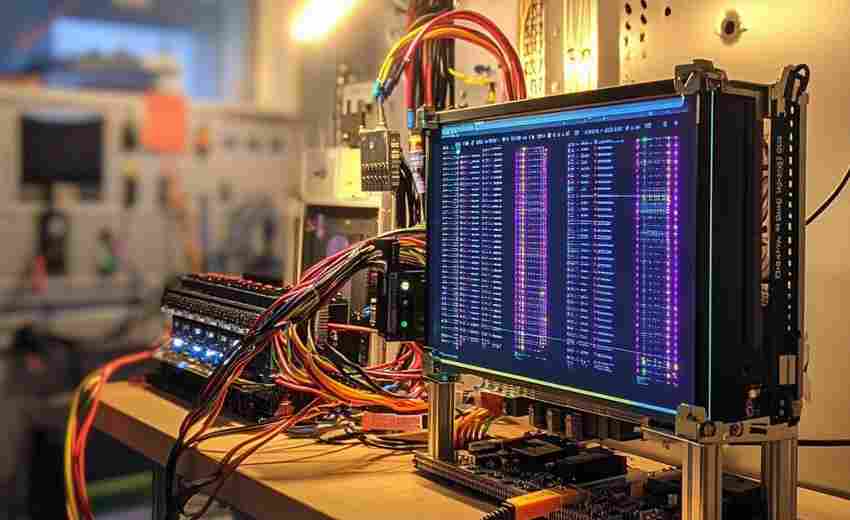

终端版CPU-内存使用率监视器

在服务器维护、性能调优甚至日常开发场景中,实时掌握系统资源状态是工程师的必修课。当图形化界面成为奢望时...

动态密码本生成器(OTP算法实现)

在信息安全领域,动态密码技术正以每年23%的增长率重塑身份验证体系。某网络安全实验室近期发布的密码本生成工...

多用户共享待办事项列表工具

午休时间的办公室茶水间,市场部小王正拿着便签纸追着研发部老张确认项目排期。类似的场景在职场每天上演,纸...

命令行版IP端口连通性测试工具

IP端口连通性测试是网络运维中最基础的排查手段之一。面对服务器无法访问、服务异常等问题,技术人员通常需要快...

PDF合并拆分工具(带页面旋转功能)

PDF文档在办公场景中的高频使用催生出大量实用工具。一款集合并、拆分、旋转功能于一体的专业软件,正逐步成为...

Tkinter制作的电子时钟(带闹钟功能)

桌面端工具开发领域,Python的Tkinter库常被视为入门级选择。近期有开发者基于该框架实现了一款集成闹钟功能的电子...

PDF水印添加工具(文本-图片叠加)

在数字化办公场景中,PDF文件因其格式稳定、兼容性强等特点,成为文档传输的主流载体。未经授权的复制、二次分...

WiFi网络强度实时监测记录仪

在无线网络成为生活刚需的今天,WiFi信号不稳定、覆盖不均等问题频发,直接影响工作与娱乐体验。针对这一痛点,...

远程设备离线状态邮件报警系统

在工业物联网应用场景中,设备离线往往意味着产线停摆、数据断流等重大风险。某半导体制造企业曾因真空泵设备...

基于PyAutoGUI的网页文章自动摘录保存工具

互联网信息爆炸的时代,如何快速捕获有效内容成为刚需。近期开源社区中,一款基于PyAutoGUI的网页自动化工具引发...

PDF多文档合并与页面提取器

在日常办公场景中,PDF文件因格式稳定、兼容性强成为主流文档载体。面对多份合同合并归档、论文资料分页整理等...

多格式压缩文件处理工具(ZIP-RAR解压)

在数字化办公场景中,跨平台文件传输已成为刚需。面对同事发来的ZIP压缩包、海外客户寄送的RAR格式文件,或是开...

屏幕颜色拾取器(实时显示坐标点颜色)

在设计领域,精确捕捉色彩如同画家挑选颜料般重要。当设计师面对数十种相近的蓝色渐变,或是开发人员需要精准...

网络速度实时监测工具(图形化显示上下行速率)

对于经常需要联网办公、游戏或追剧的用户来说,网络速度的稳定性直接影响使用体验。一款能够实时显示上下行速...

金融指标关系力导向图生成器

在金融市场分析领域,数据间的关联性往往隐藏在庞杂的指标背后。如何快速梳理指标间的逻辑,成为从业者面临的...

天气实时查询软件

打开手机,滑动屏幕,几秒内就能知道未来几小时会不会下雨——这种便利在十年前还是科幻场景,如今已融入日常...