简易网页爬虫(指定URL抓取页面内容)

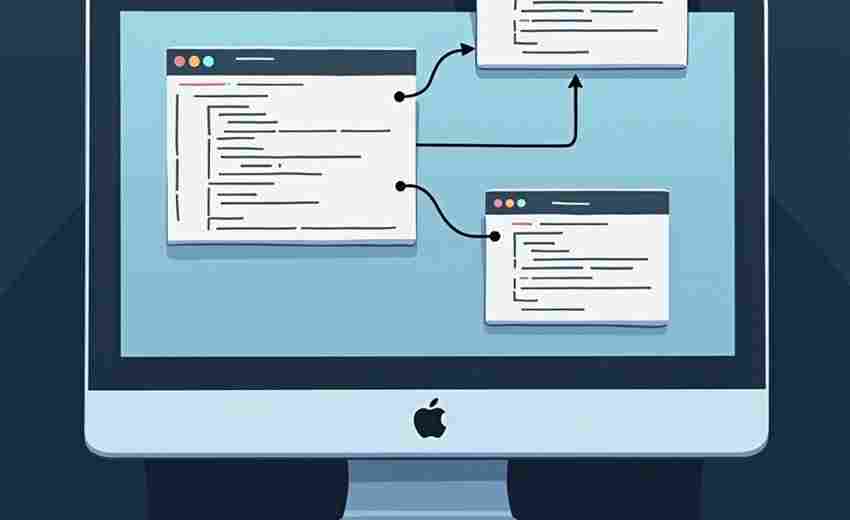

网络信息爆炸的时代,网页数据抓取成为开发者与数据分析师的刚需工具。一个基于Python的简易网页爬虫只需20行代码即可实现核心功能,其技术实现路径值得探讨。

基础原理与工具选择

基于HTTP协议的网络请求是爬虫技术的底层逻辑。Python生态中,requests库可完成90%的页面获取任务,配合BeautifulSoup或lxml解析HTML文档结构。Node.js开发者则常用axios+cheerio组合,两者在异步处理方面更具优势。

以下Python示例演示基础抓取流程:

```python

import requests

from bs4 import BeautifulSoup

response = requests.get(')

soup = BeautifulSoup(response.text, 'html.parser')

title_tag = soup.find('title')

print(title_tag.text.strip)

```

常见问题处理策略

实际开发中会遇到403禁止访问状态码,这通常需要添加User-Agent请求头伪装浏览器:

```python

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) ...'

response = requests.get(url, headers=headers)

```

对于动态加载内容,传统请求库可能失效。此时可选用Selenium或Playwright实现浏览器自动化操作,这类工具能执行JavaScript脚本并获取渲染后的DOM结构。

法律与道德边界

抓取公开数据时需遵守目标网站的robots.txt协议,商业级抓取要特别注意《反不正当竞争法》相关条款。某电商平台2021年起诉数据公司案例显示,超过300次/分钟的请求频率可能被判定为恶意爬取。

数据存储环节建议使用SQLite轻量级数据库,大规模采集可转用MongoDB文档型数据库。正则表达式在处理非结构化文本时效率极高,但XPath在DOM节点定位方面更精准可靠。

- 上一篇:简易网页爬虫(抓取指定页面图片)

- 下一篇:简易聊天室程序(Socket通信)

相关软件推荐

简易截图工具(使用pyautogui库)

发布日期: 2025-05-05 16:30:40

Windows系统自带的截图工具功能有限,第三方软件又常夹带广告。利用Python的pyautogui库,...

随机软件推荐

商品SKU编码规则校验与生成器

在电商与零售行业,商品SKU编码如同每件商品的"身份证号",承载着规格、属性、库存等多维度信息。传统人工编码模...

多车型油耗对比分组柱状图生成器

在汽车消费市场,油耗参数始终是用户关注的核心指标。针对不同品牌、车型的油耗数据对比需求,某技术团队开发...

网络端口扫描器(socket版)

互联网时代的主机安全检测离不开端口扫描技术。基于Socket编程实现的端口扫描器因其底层控制能力强、灵活度高等...

随机名言-鸡汤语录生成器(带朗读功能)

清晨六点的通勤地铁上,有人习惯性摸出手机点开红色图标刷短视频。但在某个隐秘的科技爱好者社群中,超过十万...

微信公众号文章标题采集爬虫(需登录)

在内容运营与数据分析领域,微信公众号作为中文内容生态的核心平台,其文章标题的采集需求持续增长。针对需要...

带暂停功能的目录同步工具

在数据量激增的数字化场景中,目录同步工具的可靠性与灵活性直接影响用户的工作流效率。近期市场上出现了一类...

使用Scrapy框架的定向数据采集工具

在互联网数据呈指数级增长的当下,如何精准获取特定领域的信息成为企业数字化转型的关键。Scrapy框架作为Python生...

Linux命令自动生成助手

对于许多开发者或运维人员来说,Linux命令行既是高效的工具,也是学习成本的高墙。哪怕经验丰富的用户,偶尔也会...

带地理定位功能的LBS服务注册工具

在移动互联网深度渗透的当下,地理定位技术已成为本地生活服务的核心引擎。一款集地理定位与服务注册于一体的...

Flask+SQLAlchemy的简易博客系统

当开发者需要快速构建一个可扩展的博客系统时,Flask框架与SQLAlchemy的组合堪称黄金搭档。这对技术组合既能保持代...

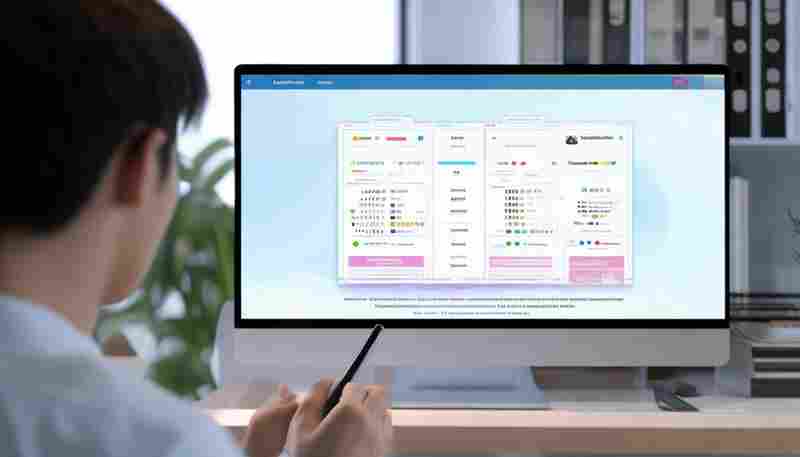

待办事项优先级工作量平衡分配程序

现代职场人常面临两大难题:任务优先级混乱与工作量分配失衡。一款名为「TaskBalancer」的智能任务管理工具近期在...

利用os模块的文件夹大小统计工具

日常开发中常会遇到需要统计文件夹体积的需求。无论是清理磁盘冗余数据,还是分析项目文件分布,快速获取目录...

简易数据库备份工具(定时压缩归档)

凌晨三点的机房监控屏突然闪烁红光,某电商平台运维人员发现数据库出现异常锁表现象。他们立即启用了最后一次...

网页内容关键词监控报警器

在信息爆炸的数字化时代,网页内容更新频率以秒计算,企业、媒体、个人用户对特定关键词的实时追踪需求日益迫...

简易2048数字合并游戏(滑动合并相同数字)

一款看似简单却极易上瘾的数字游戏,自诞生起便席卷全球。它没有复杂的剧情,没有华丽的特效,仅凭滑动合并的...

Excel数据自动填充工具(模板化内容生成)

重复性数据录入曾是财务、行政、运营等岗位的日常痛点。某互联网公司市场部员工小林回忆:"去年双十一活动,连...

网络配置合规性检查工具(预定义规则)

在数字化转型的浪潮中,网络设备数量激增,配置复杂度呈指数级上升。传统的人工巡检模式不仅效率低下,还容易...

任务优先级与天气联动提醒

窗外的暴雨拍打着玻璃,电脑屏幕上的会议提醒却在此时弹出——类似场景几乎每天都在城市中上演。当时间管理与...

简易画板绘图工具(基础绘图功能)

阳光透过百叶窗洒在桌面上,手绘板连接电脑的瞬间,光标化作一支虚拟画笔。在数字化创作日益繁复的今天,一款...

电子书EPUB-MOBI编码修复工具

纸质书的折角褶皱常被视作阅读印记,电子书的乱码错页却令人抓狂。当EPUB文档出现章节错乱,MOBI文件显示异常符号...

桌面悬浮网速监测器

现代人面对网络卡顿时的焦躁,往往来自于对网络状态的不确定。当视频缓冲图标开始旋转,游戏画面突然定格,多...

浏览器缓存智能清理扩展工具

点击网页时突然卡顿,硬盘空间悄无声息被吞噬,后台数据越积越多拖慢运行速度——这些由浏览器缓存引发的顽疾...

团建活动方案生成工具(预算分级模板)

传统团建活动策划常面临三大痛点:预算分配模糊导致执行困难,活动形式与团队需求错配,行政流程消耗过多精力...

自动生成报告工具(用Jinja2模板引擎)

在企业数据处理和业务分析场景中,生成标准化报告是高频需求。传统手动编写报告的方式不仅耗时,且容易因人为...

图片相似度比对工具(OpenCV基础)

在电商平台运营过程中,商品主图重复上传导致的资源浪费问题长期困扰着运营团队。某服饰类目运营人员发现,每...

系统剪贴板历史管理器(使用pyperclip库)

日常工作中,频繁按下的Ctrl+C/V组合键背后,隐藏着大量被覆盖的宝贵数据。传统剪贴板的单向存储机制如同沙漏,新...

简易通讯录管理系统(基于文本文件)

本地化数据管理需求在技术圈始终存在。一款基于纯文本文件的通讯录管理系统近期在开发者社区引发关注,其核心...

指定目录下文件大小统计与排序工具

办公电脑堆积了上百G的设计素材,程序员的工作站塞满代码和日志文件——存储空间告急时,如何快速揪出那些"空间...

单位换算大全工具(长度-体积-重量等转换)

厨房里盯着菜谱发愁,旅行前翻着行李箱计算行李重量,工作中对着跨国文件核对数据——这些场景总绕不开单位换...

CSV文件缺失行自动补全对比工具

数据清洗环节中,CSV文件因人为操作失误或系统传输中断导致的记录缺失,常引发后续分析结果偏差。某款针对该痛...

基于关键词的文本文件快速检索工具

办公桌上堆满电子文档时,总有人对着搜索框发愁。传统检索工具要么加载迟缓,要么漏掉关键信息。某技术团队开...

取色器操作教程演示工具

在数字设计领域,色彩的选择直接影响作品的视觉表现力。取色器作为一款高效的颜色提取工具,能够快速捕捉屏幕...

音频格式转换处理器

碎片化时代催生大量音频处理需求。面对设备兼容性难题、存储空间限制、音质优化痛点,一款高效可靠的音频格式...

自动生成会议记录模板工具(带时间戳)

在企业日常运营中,会议记录是信息传递与工作推进的关键载体。传统手工记录方式常面临效率低、易遗漏、格式混...

3D模型文件材质信息重命名工具

在3D设计领域,材质文件管理一直是困扰从业者的痛点。当项目涉及数百个材质贴图时,混乱命名导致的资源错位问题...

频道合作品牌曝光统计工具

在碎片化传播时代,品牌方与内容创作者、媒体平台的合作模式日趋复杂。如何量化跨渠道传播效果,识别高价值合...

语音转文字小工具(调用本地语音识别库)

在信息处理效率至上的时代,语音转文字工具逐渐成为职场、学术等场景的刚需。市面上多数产品依赖云端服务,数...

桌面悬浮窗CPU-RAM监测器

许多人在使用电脑时都遇到过类似困扰:剪辑视频时软件突然卡死,游戏激战时画面莫名掉帧。这类问题的根源往往...

命令行实现的简易待办事项清单管理程序

在数字工具泛滥的当下,一款没有复杂界面、不依赖网络环境的命令行待办事项工具,反而成了效率控的另类选择。...

自动生成网页爬虫日志分析报告工具

爬虫日志分析是技术团队日常运维中不可忽视的环节。面对每天数以GB计的日志文件,工程师需要快速定位异常访问、...