网络爬虫基础版(静态页面文本内容抓取)

互联网时代数据获取成为刚需,静态网页文本抓取作为基础技术支撑着大量数据应用场景。入门级开发者通常会选择Python生态中的Requests库作为起点,这款轻量级工具通过七行代码就能完成基础网页请求:import requests后调用get方法,配合status_code验证响应状态,text属性直接输出网页源码。

解析环节往往需要BeautifulSoup助力,这款HTML解析器支持多种解析方式。当遇到包含文章列表的网页结构时,开发者可用find_all方法配合CSS选择器精准定位,例如soup.select('div.article-list > h2')能快速提取所有文章标题节点。实际应用中需注意网页编码差异,部分网站需要手动指定response.encoding='utf-8'避免乱码。

Node.js用户群体更倾向使用Cheerio库,其语法与jQuery高度相似。通过load方法载入HTML文档后,使用$('selector')链式操作能快速构建数据抽取逻辑。在处理包含分页的新闻网站时,开发者可通过分析URL参数规律配合循环结构实现自动翻页,这需要配合正则表达式或字符串处理函数完成页码迭代。

抓取频率控制常被新手忽视,部分网站会在nginx配置访问频率限制。合理设置time.sleep(random.uniform(1,3))能有效降低被封禁概率。User-Agent轮换机制也值得重视,通过fake_useragent库生成多样化请求头能提升爬虫隐蔽性。

数据存储环节要根据应用场景选择方案,小规模测试可用CSV模块直接写入本地文件。涉及图片下载时需注意流式传输处理,使用iter_content方法分块写入避免内存溢出。MySQL等关系型数据库适合结构化存储,但需要预先设计字段类型和长度。

法律合规边界始终是爬虫开发的红线,robots.txt协议必须严格遵守。当遇到网站加载动态内容时,基础爬虫存在局限性,此时需考虑升级至Selenium等浏览器自动化工具。清洗数据时注意处理HTML实体编码,如将&转换为普通字符。

- 上一篇:网络爬虫基础版(静态页面内容抓取)

- 下一篇:网络爬虫天气实时查询工具

相关软件推荐

简易网络爬虫(指定站点抓取)

发布日期: 2025-04-05 13:55:36

当我们需要快速获取特定网站公开数据时,基于Python的Requests+BeautifulSoup组合已成为技术...

网络速度测试工具speedtest-cli

发布日期: 2025-05-04 17:45:49

全球有超过2.5亿人使用Speedtest测试网络性能,而speedtest-cli作为其命令行版本,在技术圈...

随机软件推荐

文件时间属性批量打标工具

在数字信息爆炸的时代,文件时间属性管理逐渐成为专业用户的刚需。某款新晋的TimeStamp Pro软件,凭借其精准的时间...

动态二维码生成解析工具(含GUI)

在数字支付与信息交互领域,二维码正悄然经历第三次进化。相较于传统黑白方块构成的静态码,支持实时更新、数...

配置文件自动回滚管理器

在分布式系统与微服务架构普及的今天,配置文件的管理逐渐成为运维工作的核心痛点。一次错误的配置推送,可能...

快递面单图片文字识别工具

随着快递业务量持续增长,人工处理面单信息的效率瓶颈日益凸显。某技术团队近期推出的智能面单识别系统,正通...

CSV转Markdown表格工具

在日常工作中,程序员、文档编辑者以及内容创作者常会遇到需要将CSV数据快速转换为Markdown表格的需求。手动处理不...

自动化测试文件集校验工具

在持续集成与敏捷开发成为主流的软件工程领域,测试文件的完整性直接决定交付质量。某互联网企业近期因配置文...

Tkinter绘图板(支持图层管理和导出PNG)

在Python生态中,Tkinter因其内置特性成为快速开发GUI应用的首选工具之一。基于Tkinter实现的绘图板工具,近年来因其支...

系统垃圾文件清理器(自定义规则)

传统系统清理软件往往停留在表层扫描阶段,例如删除浏览器缓存或回收站文件。但在实际使用中,每个用户的系统...

AMP元素点击事件跟踪脚本

在移动端网页加速技术领域,AMP(Accelerated Mobile Pages)框架因其加载速度优势被广泛应用。但开发者常面临用户行为...

分布式系统配置文件版本对比器

在微服务与容器化技术普及的背景下,某互联网公司运维团队曾因生产环境配置错误导致服务中断。事故复盘显示,...

多平台剪贴板同步中转服务

跨设备剪贴板同步工具:打破平台壁垒的效率神器 现代人的工作流往往横跨多个设备:手机收到同事发来的地址链接...

温度转换计算器(Flask网页版)

夏日的午后,厨房烤箱上的华氏度刻度让人困惑;实验室的同事指着仪器上的摄氏温度数据反复确认;旅行前翻攻略...

多平台文件属性批量修改工具(创建时间-权限)

在数字资产管理领域,文件属性的精准控制常被忽视却至关重要。某款新晋工具凭借多平台兼容性与批量处理能力,...

系统蓝屏错误日志分析器

当Windows系统遭遇致命错误时,蓝屏界面往往伴随着一串晦涩的代码与日志文件,这类问题常让普通用户手足无措,甚...

简易番茄工作法计时器(任务统计)

办公桌前堆满文件,手机消息不断震动,刚打开的文档被临时会议打断——现代人的注意力总被切割成碎片。番茄工...

桌面便签式待办事项管理程序

清晨八点的阳光斜照在显示器上,三张半透明的虚拟便签悬浮在桌面右下角,分别标记着「项目会议资料准备」「客...

多账号自动登录助手工具

现代人日常接触的互联网服务越来越多,社交平台、办公软件、电商网站等场景往往需要用户注册多个账号。频繁切...

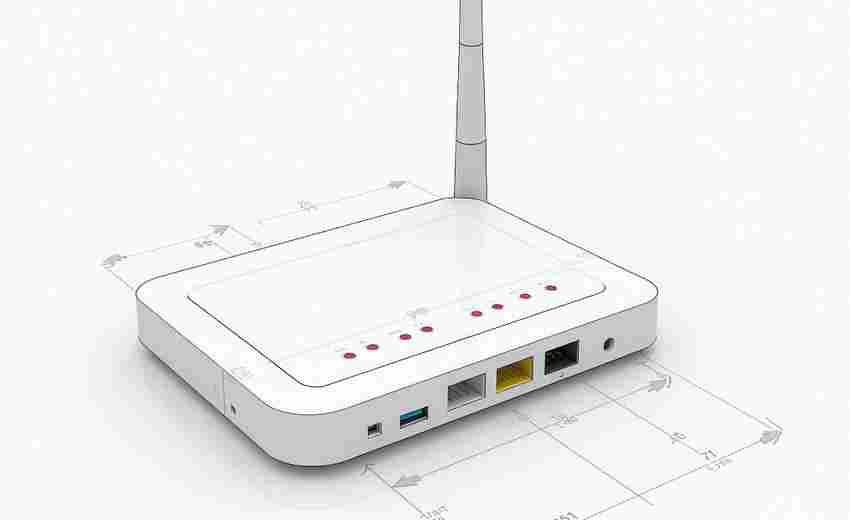

网络Ping延迟测试脚本工具

在远程办公常态化的今天,网络延迟直接影响着工作效率。当视频会议频繁卡顿、文件传输频繁中断时,快速定位网...

网络设备温度监控客户端

温度异常是引发网络设备宕机的主要诱因之一。某数据中心2022年运维报告显示,全年发生的37%硬件故障与散热系统失...

每日待办事项提醒工具

清晨的阳光洒在书桌上,一杯咖啡冒着热气,电脑屏幕前的待办清单密密麻麻——这是许多人开启一天工作的场景。...

学术期刊订阅更新跟踪器

在学术研究领域,及时获取最新期刊文献已成为科研工作者的刚性需求。据统计,全球每年新增的SCI期刊论文超过3...

日志文件实时增量关键词监控器

日志文件作为系统运行的重要记录载体,每天可能产生数万条新增数据。传统日志分析工具通常依赖全量扫描或定时...

智能文件分类按扩展名整理工具

办公桌堆满纸质文件的时代逐渐远去,电子文档的爆炸式增长却带来了新的困扰。当电脑桌面铺满未命名的PDF、PPT混...

Excel单元格内容翻译工具

日常工作中遇到多语种Excel文件时,手动逐行翻译既耗时又容易出错。针对这个痛点,近期市场上涌现出多款单元格翻...

办公文档(Word-Excel)内容批处理工具

日常办公中,重复性文档操作消耗着大量工作时间。某跨国企业市场部的统计显示,员工每周平均花费6.3小时处理文...

PDF文档批量合并拆分与加密工具

日常办公中,PDF文档的批量处理常让人头疼。某款近期备受关注的工具软件,凭借其精准的功能定位,正在改变用户...

邮件联系人自动分组标签生成器

随着电子邮件在日常沟通中承担越来越重要的角色,如何高效管理海量联系人成为痛点。传统手动分类方式耗时长、...

Python打包的翻译工具绿色版

许多人在日常工作中常遇到外文资料翻译需求。市场上主流翻译软件普遍存在体积臃肿、广告弹窗等问题,一款名为...

股票价格波动预警通知脚本(调用财经API)

金融市场的高波动性让投资者对价格变动保持高度敏感。针对这一需求,基于财经API开发的股票价格波动预警工具应...

多语言文本词频对比工具(中英文停用词自动识别)

数字时代产生的海量多语言文本数据,对研究者、企业及语言工作者提出了新的挑战。一款集成了中英文停用词自动...

键盘输入练习工具

现代职场对键盘输入效率的要求日益提升。打字速度直接影响工作效率,错误率过高则容易导致数据偏差。针对这一...

文件链接有效性批量检测器

数字资源管理领域长期存在一个痛点:随着时间推移,存储在文档、数据库中的大量文件链接会逐渐失效。某互联网...

自动文本文件内容关键词提取工具

在信息爆炸的时代,文本内容的高效处理成为刚需。面对海量文档,如何快速定位核心信息?一款基于自然语言处理...

日志文件滚动归档重命名工具(按日期小时自动轮转)

现代服务器系统每天产生海量日志数据,如何高效管理这些文件成为运维工作的关键痛点。传统人工重命名方式效率...

文件夹自动分类整理工具(按扩展名归类)

办公族和设计师常会遇到桌面堆满各类文件的窘境。某款新推出的智能分类工具通过文件扩展名识别技术,帮助用户...

容器镜像分层分析优化器

运维团队最近在排查线上环境时发现某业务镜像体积达到3.2GB,导致每次部署耗时长达15分钟。当我们尝试用传统方式...

系统快捷键管理器(全局热键注册)

Windows系统自带的快捷键体系已无法满足现代用户需求。专业开发者每天需调用十余个开发工具,设计师要在PS、Figm...

文件锁定冲突识别工具

在跨团队协作或分布式开发环境中,文件锁定冲突如同潜伏在暗处的绊脚石。某跨国游戏公司曾因美术资源文件被多...

简易文本转语音本地播放器

当代人获取信息的场景日益碎片化,文字转语音工具逐渐成为提升效率的刚需。对于注重隐私保护和技术可控性的用...

几何图形动态绘制工具

几何图形动态绘制工具正悄然改变传统设计流程,其创新功能让图形创作进入交互可视化时代。这款工具突破传统制...