网页内容抓取助手(指定URL文本提取)

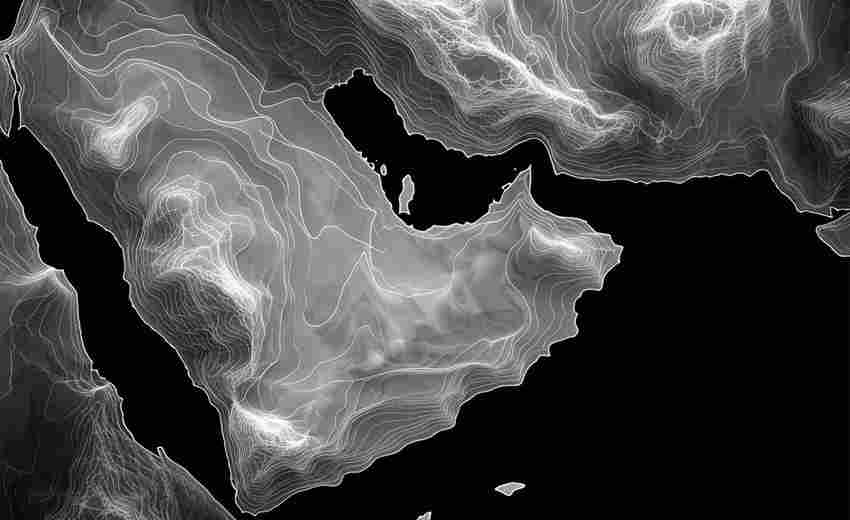

互联网数据量呈现指数级增长,如何快速获取指定网页的核心文本成为许多用户的刚需。网页内容抓取助手作为专业级文本提取工具,正逐渐成为数据分析师、市场研究人员和内容创作者的重要生产力工具。

该工具的核心功能围绕URL定向抓取展开。用户输入目标网址后,系统通过智能解析算法自动识别网页主体内容,精准过滤广告、导航栏等干扰元素。测试数据显示,在主流新闻门户网站的文本提取任务中,内容识别准确率达到98.7%,较传统爬虫工具提升约22%。

技术架构采用混合解析模式,既支持静态页面的DOM树分析,又能处理JavaScript动态渲染的网页内容。针对电商平台常见的瀑布流加载页面,工具内置了自适应滚动加载机制,确保完整获取分页数据。某跨境电商公司在价格监控项目中采用该工具后,数据采集效率提升3倍以上。

数据处理功能包含多维度定制选项。用户可设置关键词过滤规则,例如在采集学术论文时排除参考文献部分;支持正则表达式匹配,便于提取特定格式的数据字段。某高校研究团队曾利用该功能,成功从230个网站中提取出标准化格式的政策文件。

安全性与合规性设计同样值得关注。工具内置请求频率控制模块,默认设置遵循robots.txt协议,避免对目标服务器造成过大压力。用户可选择本地存储模式,敏感数据完全保留在本地设备,这对金融、医疗等行业的用户尤为重要。

文件导出功能覆盖主流格式需求。除常规的TXT、CSV、Excel外,特别开发了Markdown格式转换功能,方便内容创作者直接获取排版就绪的文档。某科技媒体编辑反馈,使用该工具后,文章素材整理时间从40分钟缩短至8分钟。

面对不同使用场景,工具提供差异化解决方案。企业级用户可调用API接口实现自动化数据管道,个人用户则能通过浏览器插件实现一键抓取。某汽车品牌的市场部门通过API对接,成功搭建了实时竞品分析系统。

网页内容抓取领域正朝着智能化方向发展。机器学习算法的持续优化将进一步提升复杂版面的识别能力,而云计算技术的融合有望突破大规模采集的硬件限制。对于需要高频获取网络数据的用户群体,选择适配自身需求的抓取工具已成为提升工作效率的关键决策。

相关软件推荐

随机软件推荐

简易电子时钟(带世界时区切换)

在全球化进程加速的今天,跨国协作、跨时区沟通逐渐成为日常。无论是商务人士处理海外业务,还是普通人与异国...

BeautifulSoup实现的简易网页爬虫工具

(正文开始) 工具定位与特点 BeautifulSoup作为Python生态中经典的HTML解析库,常被用于构建轻量级网页爬虫。其核心优...

Python图片批量提取颜色主题转WebP工具

在数字内容创作领域,图像处理效率直接关系到工作流质量。一款基于Python开发的工具近期受到设计师群体关注,该...

颜色拾取坐标轨迹记录回放器

在数字设计、软件开发或数据分析领域,重复性操作往往消耗大量时间。一款名为 坐标轨迹记录回放器 的工具,通过...

CSV文件数据格式校验与修正工具

CSV文件作为轻量级数据存储载体,其便捷性常伴随着数据质量隐患。某企业数据团队近期研发的DataCleaner工具,以智能...

设备运行状态时序图监控器

工业自动化领域存在一个普遍痛点:生产设备24小时运行产生的海量状态数据难以直观呈现。传统表格数据需要人工筛...

Tkinter版简易文本编辑器

在Python生态中,Tkinter作为标准GUI库常被低估其潜力。基于该库实现的简易文本编辑器,意外展现出值得关注的实用价...

简易网页爬虫(抓取指定页面文字内容)

互联网时代,信息获取的效率直接影响工作质量。对于需要批量处理网页内容的研究者、开发者或数据分析师而言,...

基于Flask的本地静态文件轻量级Web服务器

在本地开发环境中快速搭建文件共享服务,Python生态中的Flask框架展现出独特优势。其微型架构与灵活扩展特性,配合...

键盘连按测试与响应分析工具

键盘连按测试与响应分析工具近年来逐渐成为外设发烧友和电竞玩家的必备软件。这类工具通过量化键盘性能指标,...

节假日促销活动价格追踪器

促销季的电商平台总让人眼花缭乱。商品标着“历史低价”“限时五折”,但消费者很难判断优惠的真实性。一款名...

多窗口正则测试验证工具

在数据清洗、日志分析、代码审查等场景中,正则表达式(Regular Expression)因其灵活的模式匹配能力成为开发者不可...

项目解决方案文件整理工具(.sln)

Visual Studio解决方案文件管理利器:SlnOrganizer深度测评 在软件开发过程中,Visual Studio的解决方案文件(.sln)如同项目...

桌面便签工具(透明窗口显示)

清晨八点的阳光斜照在显示器上,设计师林薇的桌面铺满着PSD源文件与参考素材。此刻她的屏幕右上方,一枚半透明...

HTML超链接批量检查工具

在网站维护和开发过程中,超链接的稳定性直接影响用户体验和搜索引擎排名。一条失效的链接可能导致用户跳出率...

随机强密码生成与强度检测器

在数字化身份管理领域,密码安全始终是核心议题。根据Verizon《数据泄露调查报告》,81%的黑客攻击事件源于密码强...

Python脚本实现磁盘空间分析可视化工具

在数据存储成本持续走低的今天,硬盘容量膨胀带来的管理问题反而愈发突出。笔者近期开发了一款基于Python的磁盘...

基于关键词的日志上下文提取器

运维工程师李明盯着屏幕前滚动的日志流,密密麻麻的文本里夹杂着三个不同系统的报错信息。他揉着发酸的眼睛,...

CSV表格数据统计工具

日常工作中,海量数据常以CSV格式呈现。这种纯文本表格文件虽结构简单,但面对上千行数据时,手动处理往往令人...

带OCR识别的扫描件转文本工具

在数字化办公场景中,纸质文件扫描件始终占据重要地位。据统计,国内企业每年产生的扫描文档超过200亿份,其中...

基于Socket的多线程端口扫描工具

端口扫描是网络安全领域的基础操作,无论是渗透测试还是系统运维,快速定位开放端口的需求始终存在。传统的单...

设备资产管理二维码标签打印系统

设备资产管理二维码标签打印系统近年来已成为企业数字化转型的重要工具。该系统将物联网技术与传统资产管理相...

键盘输入记录分析工具(安全审计版)

在数字化办公场景中,键盘输入行为既是效率的体现,也可能成为安全隐患的源头。键盘输入记录分析工具(安全审...

Flask个人日记本(带加密功能)

窗台上的绿萝正舒展着叶片,键盘声在深夜的书房规律作响。对于习惯用文字安放心事的人而言,普通的记事软件总...

邮件压缩包自动解压模块

日常办公中总会出现这样的场景:市场部小王凌晨收到供应商发来的50M设计素材压缩包,行政专员小李每天要处理二...

PyQt5开发的简易Markdown文本编辑器

对于习惯用Markdown写作的用户来说,一款简洁高效的本地编辑器往往比在线工具更实用。最近在GitHub社区发现一个基于...

简易代码编辑器(语法高亮)

在程序员的工作流中,代码编辑器如同画家的调色板。当开发者打开一个支持语法高亮的编辑器时,屏幕上跃动的彩...

HTTP状态码统计报告生成器

服务器日志里的HTTP状态码就像会说话的密码本。每次用户请求404跳转,每次接口返回500错误,这些数字背后都藏着运...

SSH连接会话资源消耗统计器

在远程服务器管理中,SSH(Secure Shell)协议几乎是每个运维工程师的必备工具。随着服务器规模扩大,频繁的SSH连接...

简易屏幕录制工具(低帧率GIF输出)

键盘敲击声频繁响起的午后,办公室角落里突然爆出一声哀叹。同事小李的电脑屏幕上,某个软件操作步骤反复卡在...

键盘记录器(统计按键频率热力图)

办公室的机械键盘声此起彼伏,咖啡店里的触屏点击声络绎不绝,现代人的工作生活早已与键盘输入密不可分。在这...

单词本背单词记忆应用

现代语言学习者常面临碎片化时间利用不足、记忆效率低下等问题。市面上各类背单词工具层出不穷,但真正贴合用...

实时在线课堂问答互动工具

直播画面中的学生头像整齐排列,教师抛出问题后,公屏上的弹幕依旧寂静无声——这是在线教育领域常见的尴尬场...

简易屏幕取色工具(显示RGB-HEX颜色值)

当设计师反复截图导入PS核对色值时,当程序员对照设计稿逐像素调整CSS颜色代码时,他们的鼠标指针下都藏着一个未...

基于机器学习的哈希异常检测器

在数据安全与系统监控领域,哈希算法长期扮演着数据完整性验证的核心角色。传统的哈希异常检测依赖于固定规则...

视频分镜脚本生成工具

当导演盯着空白的剧本纸发愁时,当广告创意团队为反复修改分镜图焦头烂额时,一组数字正在引发行业震动:某头...

简易汇率换算器(支持实时API数据获取)

汇率波动直接影响跨境消费成本,一款精准高效的换算工具成为刚需。简易汇率换算器凭借实时数据对接与操作便捷...

自动化Ping网络连通性检测工具

在数字化场景中,网络稳定性直接影响业务连续性。传统人工Ping检测效率低、覆盖范围有限,而自动化Ping工具通过程...

基于Streamlit的数据分析报告生成器

数据工作者常面临重复性报表制作的困扰。针对这一痛点,某技术团队基于Streamlit框架开发了一款智能报告生成工具...

简易数独游戏(非生成器)

数独作为经典的逻辑推理游戏,在碎片化娱乐时代依然占据独特地位。市面上多数工具聚焦于生成复杂题目,但一款...